Python爬取前程无忧网站上python的招聘信息

前言

文的文字及图片来源于网络,仅供学习、交流使用,不具有任何商业用途,版权归原作者所有,如有问题请及时联系我们以作处理。

作者: 我姓刘却留不住你的心

PS:如有需要Python学习资料的小伙伴可以加点击下方链接自行获取

http://note.youdao.com/noteshare?id=3054cce4add8a909e784ad934f956cef

本文获取的字段有为职位名称,公司名称,公司地点,薪资,发布时间

创建爬虫项目

scrapy startproject qianchengwuyou

cd qianchengwuyou

scrapy genspider -t crawl qcwy www.xxx.com

items中定义爬取的字段

import scrapy

class QianchengwuyouItem(scrapy.Item):

# define the fields for your item here like:

job_title = scrapy.Field()

company_name = scrapy.Field()

company_address = scrapy.Field()

salary = scrapy.Field()

release_time = scrapy.Field()

qcwy.py文件内写主程序

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from qianchengwuyou.items import QianchengwuyouItem

class QcwySpider(CrawlSpider):

name = 'qcwy'

# allowed_domains = ['www.xxx.com']

start_urls = ['https://search.51job.com/list/000000,000000,0000,00,9,99,python,2,1.html?']

# https://search.51job.com/list/000000,000000,0000,00,9,99,python,2,7.html?lang=c&postchannel=0000&workyear=99&cotype=99°reefrom=99&jobterm=99&companysize=99&ord_field=0&dibiaoid=0&line=&welfare=

rules = (

Rule(LinkExtractor(allow=r'https://search.51job.com/list/000000,000000,0000,00,9,99,python,2,(\d+).html?'), callback='parse_item', follow=True),

)

def parse_item(self, response):

list_job = response.xpath('//div[@id="resultList"]/div[@class="el"][position()>1]')

for job in list_job:

item = QianchengwuyouItem()

item['job_title'] = job.xpath('./p/span/a/@title').extract_first()

item['company_name'] = job.xpath('./span[1]/a/@title').extract_first()

item['company_address'] = job.xpath('./span[2]/text()').extract_first()

item['salary'] = job.xpath('./span[3]/text()').extract_first()

item['release_time'] = job.xpath('./span[4]/text()').extract_first()

yield item

pipelines.py文件中写下载规则

import pymysql

class QianchengwuyouPipeline(object):

conn = None

mycursor = None

def open_spider(self, spider):

print('链接数据库...')

self.conn = pymysql.connect(host='172.16.25.4', user='root', password='root', db='scrapy')

self.mycursor = self.conn.cursor()

def process_item(self, item, spider):

print('正在写数据库...')

job_title = item['job_title']

company_name = item['company_name']

company_address = item['company_address']

salary = item['salary']

release_time = item['release_time']

sql = 'insert into qcwy VALUES (null,"%s","%s","%s","%s","%s")' % (

job_title, company_name, company_address, salary, release_time)

bool = self.mycursor.execute(sql)

self.conn.commit()

return item

def close_spider(self, spider):

print('写入数据库完成...')

self.mycursor.close()

self.conn.close()

settings.py文件中打开下载管道和请求头

ITEM_PIPELINES = {

'qianchengwuyou.pipelines.QianchengwuyouPipeline': 300,

}

USER_AGENT = 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/534.57.2 (KHTML, like Gecko) Version/5.1.7 Safari/534.57.2'

运行爬虫,同时写入.json文件

scrapy crawl qcwy -o qcwy.json --nolog

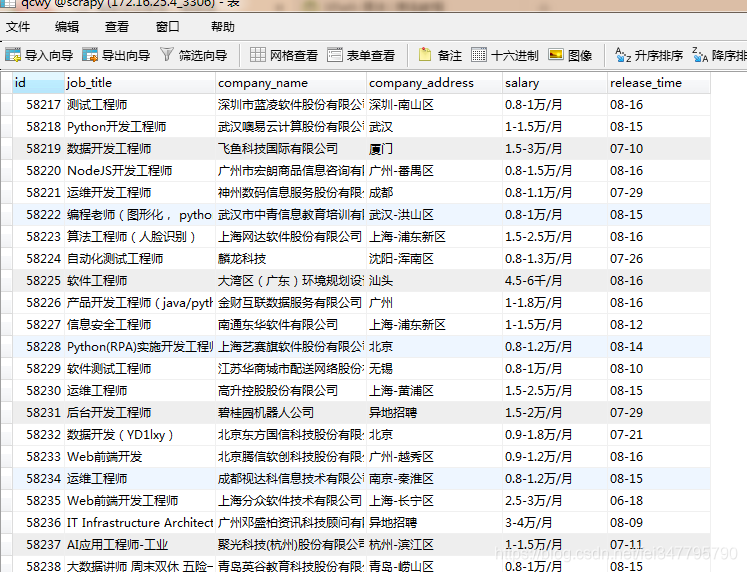

查看数据库是否写入成功,

.

Python爬取前程无忧网站上python的招聘信息的更多相关文章

- 爬取前程无忧网站上python的招聘信息。

本文获取的字段有为职位名称,公司名称,公司地点,薪资,发布时间 创建爬虫项目 scrapy startproject qianchengwuyou cd qianchengwuyou scrapy g ...

- python爬取当当网的书籍信息并保存到csv文件

python爬取当当网的书籍信息并保存到csv文件 依赖的库: requests #用来获取页面内容 BeautifulSoup #opython3不能安装BeautifulSoup,但可以安装Bea ...

- 使用python爬取东方财富网机构调研数据

最近有一个需求,需要爬取东方财富网的机构调研数据.数据所在的网页地址为: 机构调研 网页如下所示: 可见数据共有8464页,此处不能直接使用scrapy爬虫进行爬取,因为点击下一页时,浏览器只是发起了 ...

- [转]使用python爬取东方财富网机构调研数据

最近有一个需求,需要爬取东方财富网的机构调研数据.数据所在的网页地址为: 机构调研 网页如下所示: 可见数据共有8464页,此处不能直接使用scrapy爬虫进行爬取,因为点击下一页时,浏览器只是发起了 ...

- Python爬取散文网散文

配置python 2.7 bs4 requests 安装 用pip进行安装 sudo pip install bs4 sudo pip install requests 简要说明一下bs4的使用因为是 ...

- Python 爬取赶集网租房信息

代码已久,有可能需要调整 #coding:utf-8 from bs4 import BeautifulSoup #有这个bs4不用正则也可以定位要爬取的内容了 from urlparse impor ...

- 利用python爬取贝壳网租房信息

最近准备换房子,在网站上寻找各种房源信息,看得眼花缭乱,于是想着能否将基本信息汇总起来便于查找,便用python将基本信息爬下来放到excel,这样一来就容易搜索了. 1. 利用lxml中的xpath ...

- python爬取返利网中值得买中的数据

先使用以前的方法将返利网的数据爬取下来,scrapy框架还不熟练,明日再战scrapy 查找目标数据使用的是beautifulsoup模块. 1.观察网页,寻找规律 打开值得买这块内容 1>分析 ...

- Python爬取网址中多个页面的信息

通过上一篇博客了解到爬取数据的操作,但对于存在多个页面的网址来说,使用上一篇博客中的代码爬取下来的资料并不完整.接下来就是讲解该如何爬取之后的页面信息. 一.审查元素 鼠标移至页码处右键,选择检查元素 ...

随机推荐

- 关于JVM、JRE、Jdk三者的定义与联系

许多初学者对于java中的JVM.JRE.JDK三者的定义与联系有些模糊,接下来我就根据我的理解来为各位解答一下,希望能帮到正在努力的你们. JVM JVM是Java Virtual Machin ...

- CTPN网络理解

本文主要对常用的文本检测模型算法进行总结及分析,有的模型笔者切实run过,有的是通过论文及相关代码的分析,如有错误,请不吝指正. 一下进行各个模型的详细解析 CTPN 详解 代码链接:https:// ...

- Java描述设计模式(01):单例模式

本文源码:GitHub·点这里 || GitEE·点这里 一.单例模式 1.概念图解 单例设计模式定义:确保这个类只有一个实例,并且自动的实例化向系统提供这个对象. 2.样例代码 package co ...

- Unix 开发中的 Make 三连

Unix 开发过程中,经常性的操作是从源码编译安装相应库文件,所以下面三个命令便是家常便饭,俗称三连: ./configure make make install 下面来看看这三步分别做了什么. co ...

- ASP.NET MVC教程一:ASP.NET MVC简介

一.MVC模式简介 MVC模式是一种流行的Web应用架构技术,它被命名为模型-视图-控制器(Model-View-Controller).在分离应用程序内部的关注点方面,MVC是一种强大而简洁的方式, ...

- abp去掉AbpUser中的Name,Surname,去掉姓和名分离

abp是国外的框架,默认的框架中的AbpUser表中的Name和Surname是分开的,这不符合国情:可以先去掉 1. 在User类中重写Name和Surname,并设置为私有 2. 在DbConte ...

- Winform中自定义添加ZedGraph右键实现设置所有Y轴刻度的上下限

场景 Winforn中实现ZedGraph自定义添加右键菜单项(附源码下载): https://blog.csdn.net/BADAO_LIUMANG_QIZHI/article/details/10 ...

- spark SQL、RDD、Dataframe总结

- Cesium专栏-视频投影(附源码下载)

Cesium Cesium 是一款面向三维地球和地图的,世界级的JavaScript开源产品.它提供了基于JavaScript语言的开发包,方便用户快速搭建一款零插件的虚拟地球Web应用,并在性能,精 ...

- dedecmsV5.7 arclist标签同时取出主表和附表里的数据

{dede:arclist}{/dede:arclist}标签默认取出来的是主表x_archives中的数据,如果要取出附表中的数据,需要满足两个条件: 指定channelid属性(注意:channe ...