豆瓣电影top250爬取并保存在MongoDB里

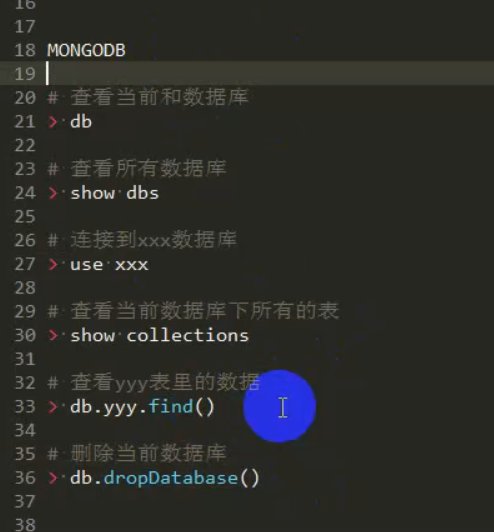

首先回顾一下MongoDB的基本操作:

数据库,集合,文档

db,show dbs,use 数据库名,drop 数据库

db.集合名.insert({})

db.集合名.update({条件},{$set:{}},{multi:true})

db.集合名.remove({条件})

db集合名.find({条件},{投影}).limit().skip().sort().count().distinct() 数据库 增加 修改 删除 查询

mysql insert update delete select

redis set set del get

mongodb insert update remove find,aggregate

string

hash

list

set

zset

增加

mysql:insert into 表名(列) values(值)

mongo:db.集合名.insert({})

修改:

mysql:update 表名 set 列=值 where 条件

mongo:db.集合名.update({条件},{值$set},{是否修改多条})

删除:

mysql:delete from 表名 where ....

mongo:db.集合名.remove({条件},{是否删除多条})

查询:

db.stu.find({},{})

比较运算符,逻辑运算符,$where

limit(),skip(),sort(),count(),distinct()

首先使用xpath提取出要爬取的信息:我们这个项目需要爬取的信息有:标题,信息,评分,简介

第一页链接:https://movie.douban.com/top250

第二页链接:https://movie.douban.com/top250?start=25&filter=

第三页链接:https://movie.douban.com/top250?start=50&filter=

规律:https://movie.douban.com/top250?start=\d+&filter=

标题://a/span[@class="title"][1]

信息://div[@class="bd"]/p[1]/text()

评分://div[@class="star"]/span[2]/text()

简介://span[@class="inq"]/text()

然后使用sscrapy startproject douban 创建项目

sscrapy genspider dopuban movie.douban.com

然后依次编写下面的文件:

items.py

doubanmovie.py

settings.py

pipelines.py

豆瓣电影top250爬取并保存在MongoDB里的更多相关文章

- 豆瓣电影信息爬取(json)

豆瓣电影信息爬取(json) # a = "hello world" # 字符串数据类型# b = {"name":"python"} # ...

- 5分钟掌握智联招聘网站爬取并保存到MongoDB数据库

前言 本次主题分两篇文章来介绍: 一.数据采集 二.数据分析 第一篇先来介绍数据采集,即用python爬取网站数据. 1 运行环境和python库 先说下运行环境: python3.5 windows ...

- Scrapy教程--豆瓣电影图片爬取

一.先上效果 二.安装Scrapy和使用 官方网址:https://scrapy.org/. 安装命令:pip install Scrapy 安装完成,使用默认模板新建一个项目,命令:scrapy s ...

- python2.7爬取豆瓣电影top250并写入到TXT,Excel,MySQL数据库

python2.7爬取豆瓣电影top250并分别写入到TXT,Excel,MySQL数据库 1.任务 爬取豆瓣电影top250 以txt文件保存 以Excel文档保存 将数据录入数据库 2.分析 电影 ...

- python2.7抓取豆瓣电影top250

利用python2.7抓取豆瓣电影top250 1.任务说明 抓取top100电影名称 依次打印输出 2.网页解析 要进行网络爬虫,利用工具(如浏览器)查看网页HTML文件的相关内容是很有必要,我使用 ...

- Python爬虫----抓取豆瓣电影Top250

有了上次利用python爬虫抓取糗事百科的经验,这次自己动手写了个爬虫抓取豆瓣电影Top250的简要信息. 1.观察url 首先观察一下网址的结构 http://movie.douban.com/to ...

- 利用python2.7正则表达式进行豆瓣电影Top250的网络数据采集及MySQL数据库操作

转载请注明出处 利用python2.7正则表达式进行豆瓣电影Top250的网络数据采集 1.任务 采集豆瓣电影名称.链接.评分.导演.演员.年份.国家.评论人数.简评等信息 将以上数据存入MySQL数 ...

- 一起学爬虫——通过爬取豆瓣电影top250学习requests库的使用

学习一门技术最快的方式是做项目,在做项目的过程中对相关的技术查漏补缺. 本文通过爬取豆瓣top250电影学习python requests的使用. 1.准备工作 在pycharm中安装request库 ...

- 【转】爬取豆瓣电影top250提取电影分类进行数据分析

一.爬取网页,获取需要内容 我们今天要爬取的是豆瓣电影top250页面如下所示: 我们需要的是里面的电影分类,通过查看源代码观察可以分析出我们需要的东西.直接进入主题吧! 知道我们需要的内容在哪里了, ...

随机推荐

- Linux学习8-Linux常用命令(4)

链接命令 命令名称:ln 命令英文原意:link 命令所在路径:/bin/ln 执行权限:所有用户 功能描述:生成链接文件 语法:ln 选项[-s][原文件] [目标文件] 选项: -s 创建 ...

- 去除底部“自豪地采用 WordPress”版权信息----最后附最新版的删除方法!!

footer.php get_template_part( 'template-parts/footer/site', 'info' );

- 一步一步实现web程序信息管理系统之一----登陆界面实现

一步一步实现web程序信息管理系统 在web程序中特别是信息管理系统,登陆功能必须有而且特别重要.每一个学习程序开发或以后工作中,都会遇到实现登陆功能的需求.而登陆功能最终提供给客户或展现给客户的最基 ...

- 教程:RSS全文输出,自己动手做。(一)

这里以PHP版为例,尽量说得通俗点吧,水平实在有限,见谅. 目前我这里所有的获取全文输出的网站大概是三种情况: 要输出的内容集中在一页上,也就是看似列表页的页面里集中了你想要的所有内容,并不需要点击“ ...

- 全功能开发团队(FSD)

- MySql 缓存查询原理与缓存监控 和 索引监控

MySql缓存查询原理与缓存监控 And 索引监控 by:授客 QQ:1033553122 查询缓存 1.查询缓存操作原理 mysql执行查询语句之前,把查询语句同查询缓存中的语句进行比较,且是按字节 ...

- Ubunt 安装mysql

apt-get install mysql-client-core-5.6apt-get install mysql-client-5.6apt-get install mysql-server-5. ...

- 切片和append操作

本文转自:http://meia.fun/article/1541470004286 学习切片时,被append这个方法困扰了半天:在main方法中把一个切片作为实参传递给另一个函数,并在这个函数内调 ...

- [翻译] CHTCollectionViewWaterfallLayout

CHTCollectionViewWaterfallLayout https://github.com/chiahsien/CHTCollectionViewWaterfallLayout CHTCo ...

- 工作总结 [all]

2. 工作总结 3. 面试经验 4. 其他