使用Spark开发应用程序,并将作业提交到服务器

1、pycharm编写spark应用程序

由于一些原因在windows上配置未成功(应该是可以配置成功的)、我是在linux上直接使用pycharm,在linux的好处是,环境可能导致的一切问题不复存在

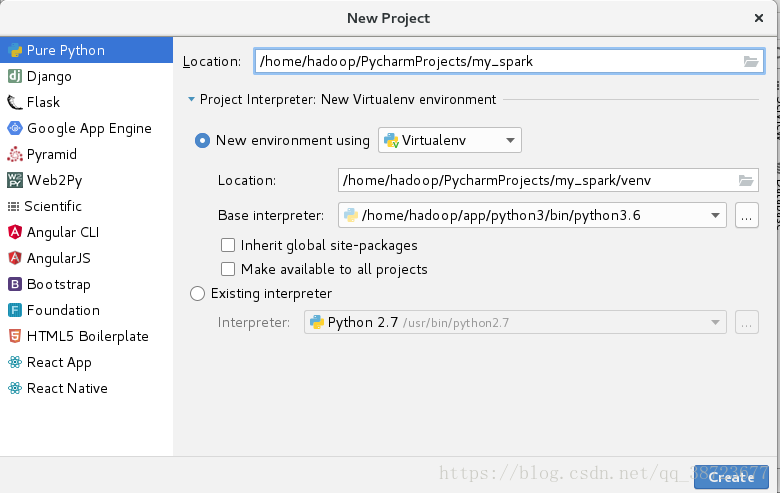

111 新建一个普通python工程

编程环境使用spark使用的python环境

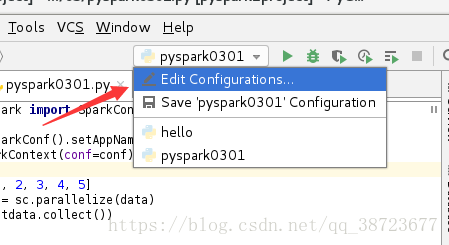

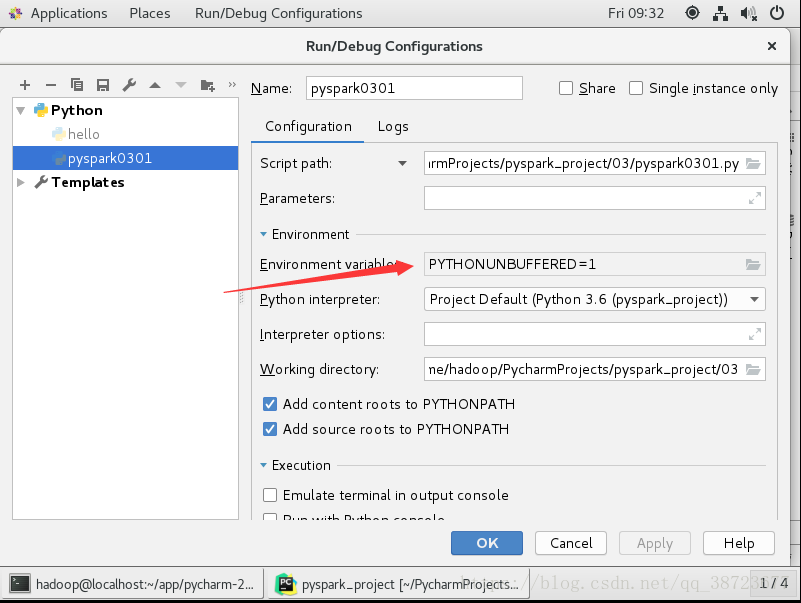

222 配置spark环境

进入下图

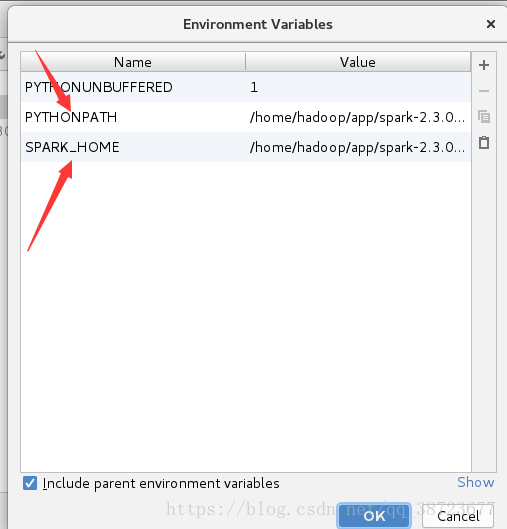

添加2个相应属性

PYTHON_PATH为spark安装目录下的python的路径

我的:/home/hadoop/app/spark-2.3.0-bin-2.6.0-cdh5.7.0/python

SPARK_HOMR为spark安装目录

我的:/home/hadoop/app/spark-2.3.0-bin-2.6.0-cdh5.7.0

完成后

导入两个包进入setting

包位置为spark安装目录下python目录下lib里

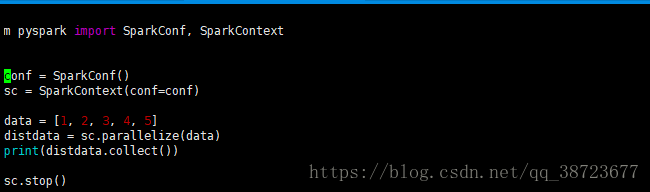

2、正式编写

创建一个python文件

from pyspark import SparkConf, SparkContext

# 创建SparkConf:设置的是spark的相关信息

conf = SparkConf().setAppName("spark0301").setMaster("local[2]")

# 创建SparkContext

sc = SparkContext(conf=conf)

# 业务逻辑

data = [1, 2, 3, 4, 5]

# 转成RDD

distdata = sc.parallelize(data)

print(distdata.collect())

# 好的习惯

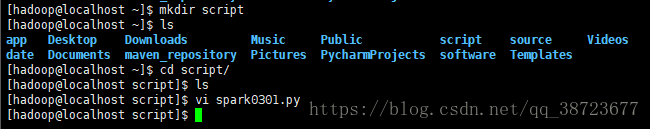

sc.stop()在linux系统用户家根目录创建一个script

将代码放入spark0301.py中

将appname和master去掉,官网说不要硬编码,会被自动赋值

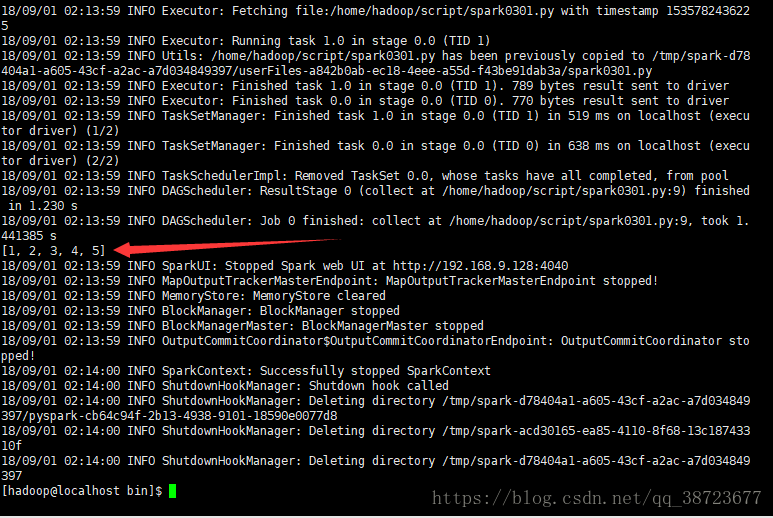

然后进入spark安装目录下bin目录运行

./spark-submit --master local[2] --name spark0301 /home/hadoop/script/spark0301.py

因为速度太快结束网站是看不到的

使用Spark开发应用程序,并将作业提交到服务器的更多相关文章

- Spark开发环境搭建和作业提交

Spark高可用集群搭建 在所有节点上下载或上传spark文件,解压缩安装,建立软连接 配置所有节点spark安装目录下的spark-evn.sh文件 配置slaves 配置spark-default ...

- Spark学习(四) -- Spark作业提交

标签(空格分隔): Spark 作业提交 先回顾一下WordCount的过程: sc.textFile("README.rd").flatMap(line => line.s ...

- Spark学习之路(五)—— Spark运行模式与作业提交

一.作业提交 1.1 spark-submit Spark所有模式均使用spark-submit命令提交作业,其格式如下: ./bin/spark-submit \ --class <main- ...

- Spark 系列(五)—— Spark 运行模式与作业提交

一.作业提交 1.1 spark-submit Spark 所有模式均使用 spark-submit 命令提交作业,其格式如下: ./bin/spark-submit \ --class <ma ...

- Spark作业提交至Yarn上执行的 一个异常

(1)控制台Yarn(Cluster模式)打印的异常日志: client token: N/A diagnostics: Application application_1584359 ...

- 入门大数据---Spark部署模式与作业提交

一.作业提交 1.1 spark-submit Spark 所有模式均使用 spark-submit 命令提交作业,其格式如下: ./bin/spark-submit \ --class <ma ...

- Spark On Yarn:提交Spark应用程序到Yarn

转载自:http://lxw1234.com/archives/2015/07/416.htm 关键字:Spark On Yarn.Spark Yarn Cluster.Spark Yarn Clie ...

- Spark应用程序运行的日志存在哪里(转)

原文链接:Spark应用程序运行的日志存在哪里 在很多情况下,我们需要查看driver和executors在运行Spark应用程序时候产生的日志,这些日志对于我们调试和查找问题是很重要的. Spark ...

- 利用Scala语言开发Spark应用程序

Spark内核是由Scala语言开发的,因此使用Scala语言开发Spark应用程序是自然而然的事情.如果你对Scala语言还不太熟悉,可 以阅读网络教程A Scala Tutorial for Ja ...

随机推荐

- Hive——基本DML语句

Hive--基本DML语句 DML:Data Manipulation Language(数据操作语言,与关系型数据库相似) 官方手册:https://cwiki.apache.org/conflue ...

- 五个 .NET 性能小贴士

原文:bit.ly/3wSpO4o 作者:Nikita Starichenko 翻译:精致码农 大家好!今天我想和大家分享几个 .NET 的性能小贴士与基准测试. 我的系统环境: BenchmarkD ...

- Geoserver通过ajax跨域访问服务数据的方法(含用户名密码认证的配置方式)

Goeserver数据有两种,一种需进行用户密码的权限认证,一种无须用户密码.对于网上跨域访问Geoserver数据的种种方法,对这2种数据并非通用. 笔者将Geoserver官方下载的Geoserv ...

- 什么是BI工具,好用的BI工具软件排名

目录 一.什么是BI工具? 二.BI工具有什么好处? 三.BI工具软件排名 由于海量数据对各种规模的企业构成挑战,因此每年确保所有业务流程都在控制之下变得越来越困难.最终,组织和公司在做出可持续和有利 ...

- 当vue 页面加载数据时显示 加载loading

参考:https://www.jianshu.com/p/104bbb01b222 Vue 页面加载数据之前增加 `loading` 动画 创建组件 1.新建 .vue 文件: src -> c ...

- iOS实现常用地图坐标系转换(swift5)

// 桥接后,OC工程也可用 // HTMCoorTransform.swift // HTMapKit // // Created by LongMa on 2021/8/3. // import ...

- 点云上的深度学习及其在三维场景理解中的应用(PPT内容整理PointNet)

这篇博客主要是整理了PointNet提出者祁芮中台介绍PointNet.PointNet++.Frustum PointNets的PPT内容,内容包括如何将点云进行深度学习,如何设计新型的网络架构 ...

- .Net Core+分布式配置中心(AgileConfig)

GitHub上AgileConfig非常详细,以下只是本人学习过程的整理 一.介绍 1.参考地址 https://github.com/dotnetcore/AgileConfig https://w ...

- Notepad++的NppFTP插件连接linux操作系统

Notepad++的NppFTP插件连接linux操作系统 下载地址:https://notepad-plus-plus.org/downloads/v8.1.2/ 1.安装Npp_FTP插件 两种方 ...

- 常见的嵌入式linux学习和如何选择ARM芯片问答

常见的ARM嵌入式学习问答,设计者和学习者最关心的11个问题: 1. ARM嵌入式是学习硬件好还是学习软件好? 2. 嵌入式软件和硬件,哪一种职位待遇更高?或者说, ...