Python爬取mn52网站美女图片以及图片防盗链的解决方法

防盗链原理

其实解决办法很简单,加入header,然后把Referer写入即可!

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36',

'Referer': url

}

本文爬取https://www.mn52.com/网站上面的清纯美女图片,代码如下;

# 需要的库

import requests

import re

import os

from multiprocessing import Pool

# 主函数

def get_img(url):

# 设置图片存储路径

path = './mn52/'

if not os.path.exists(path):

os.mkdir(path)

# 请求头,因为图片路由有防盗链设置所以在headers中添加'Referer': url

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3325.181 Safari/537.36',

'Referer': url

}

try:

# 请求主页面路由

response = requests.get(url=url,headers=headers)

# print(response.text)

# 正则提取并遍历获取分页面

res_paging = re.findall('<div class="picbox">.*?<a href="(.*?)"',response.text,re.S)

for i in res_paging:

# 拼接分页面路由

url_infos = 'https://www.mn52.com' + i

# 请求分页面路由

res_details = requests.get(url=url_infos,headers=headers)

# 遍历获取图片路由

res_detail = re.findall('<div class="img-wrap">.*?<img .*?rel="(.*?)"/>',res_details.text,re.S)

for i in res_detail:

# 拼接图片路由

img_urls = 'https:'+i

# 给图片命名

filename = i.split('/')[-1]

# 判断图片是否已下载

if os.path.exists(path+str(filename)):

print('图片已存在')

else:

# 请求图片连接

res = requests.get(url=img_urls,headers=headers)

# 保存图片

with open(path+str(filename),'wb') as f:

f.write(res.content)

# 打印下载信息

print('正在下载:'+img_urls)

except Exception as e:

print(e)

# 程序入口

if __name__ == '__main__':

# 构造完整路由

urls = ['https://www.mn52.com/meihuoxiezhen/list_2_{}.html'.format(i) for i in range(1,94)]

# 开启多进程

pool = Pool()

# 启动程序

pool.map(get_img,urls)

print('抓取完成')

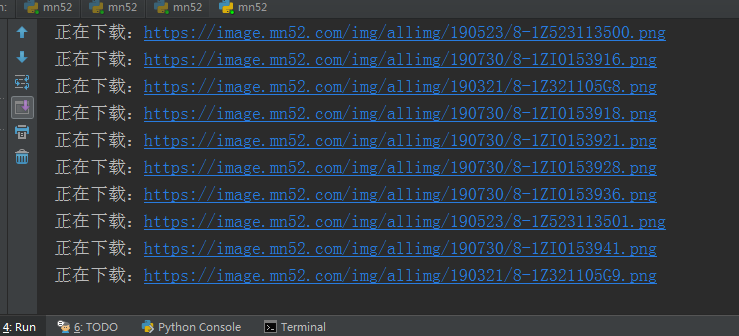

图片比较多,需要一些时间下载,控制台显示的下载过程

打开文件查看图片是否下载成功

done

Python爬取mn52网站美女图片以及图片防盗链的解决方法的更多相关文章

- python爬取某个网站的图片并保存到本地

python爬取某个网站的图片并保存到本地 #coding:utf- import urllib import re import sys reload(sys) sys.setdefaultenco ...

- 用Python爬取斗鱼网站的一个小案例

思路解析: 1.我们需要明确爬取数据的目的:为了按热度查看主播的在线观看人数 2.浏览网页源代码,查看我们需要的数据的定位标签 3.在代码中发送一个http请求,获取到网页返回的html(需要注意的是 ...

- Python爬取某网站文档数据完整教程(附源码)

基本开发环境 (https://jq.qq.com/?_wv=1027&k=NofUEYzs) Python 3.6 Pycharm 相关模块的使用 (https://jq.qq.com/?_ ...

- 使用python爬取百度贴吧内的图片

1. 首先通过urllib获取网页的源码 # 定义一个getHtml()函数 def getHtml(url): try: page = urllib.urlopen(url) # urllib.ur ...

- 利用Python爬取电影网站

#!/usr/bin/env python #coding = utf-8 ''' 本爬虫是用来爬取6V电影网站上的电影资源的一个小脚本程序,爬取到的电影链接会通过网页的形式显示出来 ''' impo ...

- python爬取电影网站信息

一.爬取前提1)本地安装了mysql数据库 5.6版本2)安装了Python 2.7 二.爬取内容 电影名称.电影简介.电影图片.电影下载链接 三.爬取逻辑1)进入电影网列表页, 针对列表的html内 ...

- python爬取招聘网站数据

# -*- coding: utf-8 -*- # 爬虫分析 from bs4 import BeautifulSoup from lxml import etree from selenium im ...

- Python爬取招聘网站数据,给学习、求职一点参考

1.项目背景 随着科技的飞速发展,数据呈现爆发式的增长,任何人都摆脱不了与数据打交道,社会对于“数据”方面的人才需求也在不断增大.因此了解当下企业究竟需要招聘什么样的人才?需要什么样的技能?不管是对于 ...

- 使用Python爬取微信公众号文章并保存为PDF文件(解决图片不显示的问题)

前言 第一次写博客,主要内容是爬取微信公众号的文章,将文章以PDF格式保存在本地. 爬取微信公众号文章(使用wechatsogou) 1.安装 pip install wechatsogou --up ...

随机推荐

- element ui表格常用功能如:导出 新增 删除 多选 跨页多选 固定表头 多级表头 合并行列 等常见需求

<template> <div class="table-cooperte"> <el-table :data="tableData&quo ...

- c#.net EF DB FIRST 添加新的模型

双击.edmx ,右键-从数据库更新模型,在“添加”里选择新表.

- [QT] - MjpegStreamer客户端(简易版)#工程源码

简介: 大学时期学习弄的一个小软件,可以起到示例的作用,软件的几个功能截图如正文所示,文末提供工程源码文件,感谢支持! 功能截图: [ 开发板启动 mjpg_streamer 服务器 ] [ 启动软件 ...

- SQL Server 数据库启动过程(用户数据库加载过程的疑难杂症)

前言 本篇主要是上一篇文章的补充篇,上一篇我们介绍了SQL Server服务启动过程所遇到的一些问题和解决方法,可点击查看,我们此篇主要介绍的是SQL Server启动过程中关于用户数据库加载的流程, ...

- Python 入门(3):运算符

Python语言支持以下类型的运算符: 算术运算符 比较(关系)运算符 赋值运算符 逻辑运算符 位运算符 成员运算符 身份运算符 运算符优先级 Python算术运算符: + 加 两个对象相加 a + ...

- Docker之Alpine制作镜像且上传至阿里云

目的: Alpine制作jdk镜像 Alpine制作jre镜像(瘦身) Docker镜像上传至阿里云 Alpine制作jdk镜像 alpine Linux简介 Alpine Linux是一个轻型Lin ...

- Shell编程学习(七)

if 条件语句的知识与实践 if 条件语句 if条件语句的语法 单分支结构 第一种 if <条件测试表达式> then 指令 fi 第二种 if <条件测试表达式>; then ...

- python罗列oss文件

# 列举文件 import oss2 from itertools import islice AccessKeyId = "your accesskeyid" AccessKey ...

- Oracle各种连接函数总结

1.前言 Oracle可用连接函数会介绍以下几个 Oracle列转行函数 Listagg() strcat() wmsys.wm_concat() 2.Oracle列转行函数 Listagg() 2. ...

- spring中AspectJ的使用

目录 AspectJ: AOP术语 通知的类型 切入点表达式 基于xml的AspectJ编程 导入jar包 定义切面类 引入约束 AOP配置 基于注解的AspectJ编程 AspectJ: 什么是AO ...