Python爬虫爬取豆瓣电影之数据提取值xpath和lxml模块

工具:Python 3.6.5、PyCharm开发工具、Windows 10 操作系统、谷歌浏览器

目的:爬取豆瓣电影排行榜中电影的title、链接地址、图片、评价人数、评分等

网址:https://movie.douban.com/chart

语法要点:

xpath语法:

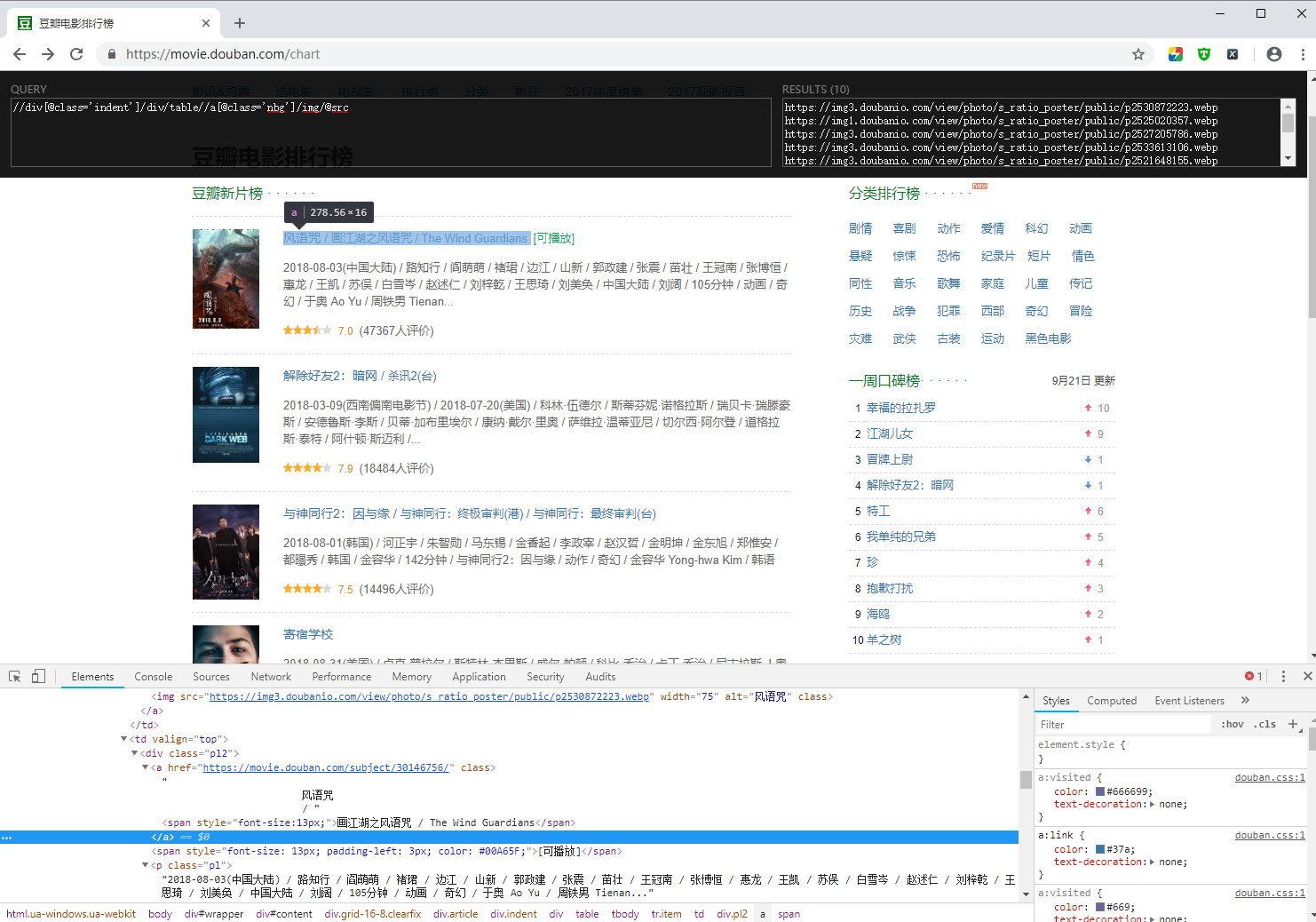

谷歌浏览器安装 xpath helper插件:帮助我们从elements中定位数据

1、选择节点(标签)

(1)、/html/head/meta:能够选中html下的所有的meta标签

(2)、//li:当前页面上的所有的li标签

(3)、/html/head//link:head下的所有link标签

2、//:能够从任意节点开始选择

(1)、//li:当前页面上的所有的li标签

(2)、/html/head//link:head下的所有的link标签

3、@符号的用途

(1)、选择具体某个元素://div[@class='feed']/ul/li,选择class='feed'的div下的ul下的li

(2)、a/@href:选择a的href的值

4、获取文本

(1)、/a/text():获取a下的文本

(2)、/a//text():获取a下的所有文本

示例:

lxml语法:

1、安装:pip install lxml

2、使用

from lxml import etree

element = etree.HTML("html字符串")

element.xpath("")

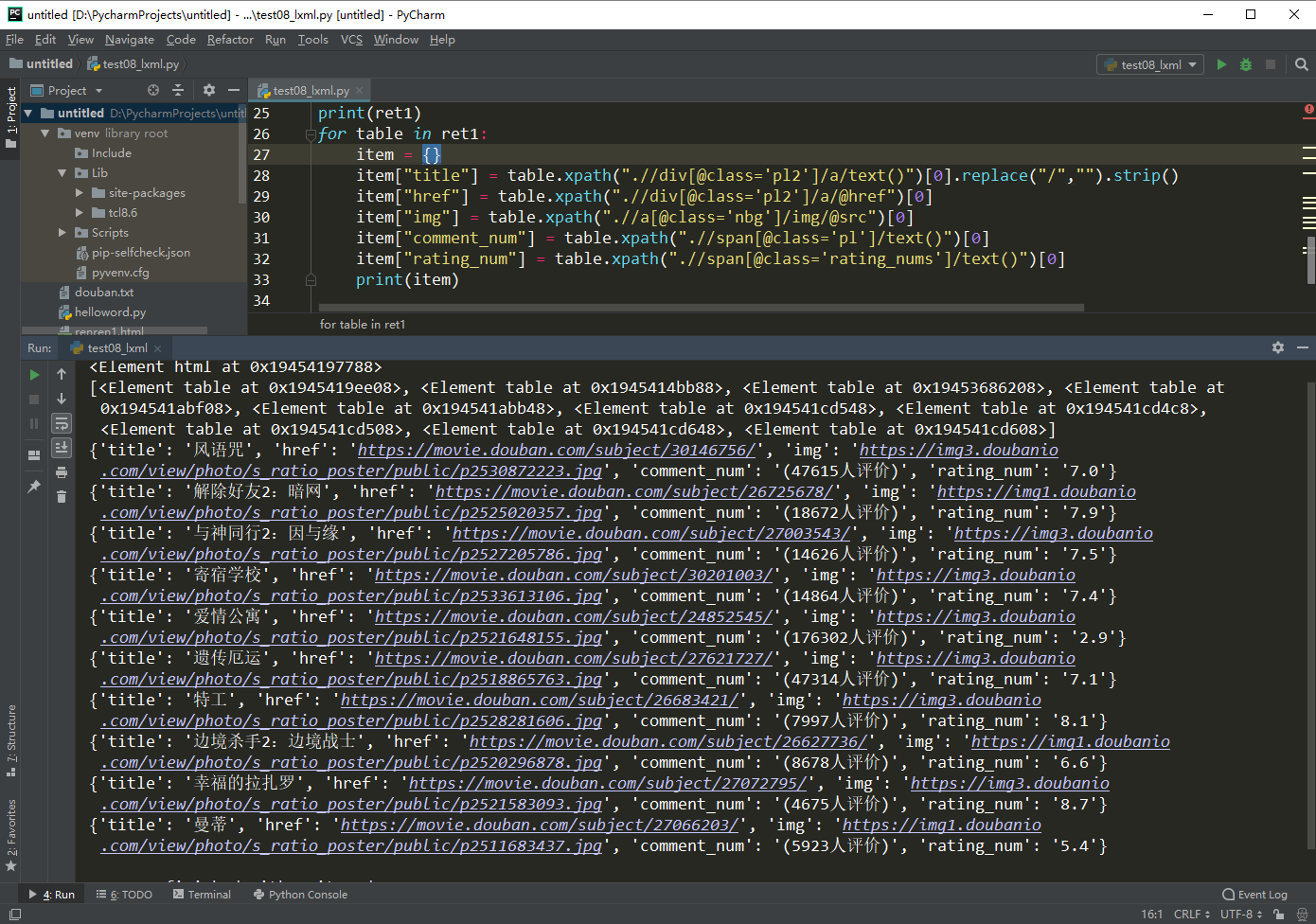

代码:

from lxml import etree

import requests url = "https://movie.douban.com/chart" headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/69.0.3497.81 Safari/537.36"

}

response = requests.get(url,headers=headers)

html_str = response.content.decode() #print(html_str) html = etree.HTML(html_str)

print(html) #1.获取所有的电影的URL地址

#url_list = html.xpath("//div[@class='indent']/div/table//div[@class='pl2']/a/@href")

#print(url_list) #2.所有图片的地址

#img_list = html.xpath("//div[@class='indent']/div/table//a[@class='nbg']/img/@src")

#print(img_list)

ret1 = html.xpath("//div[@class='indent']/div/table")

print(ret1)

for table in ret1:

item = {}

item["title"] = table.xpath(".//div[@class='pl2']/a/text()")[0].replace("/","").strip()

item["href"] = table.xpath(".//div[@class='pl2']/a/@href")[0]

item["img"] = table.xpath(".//a[@class='nbg']/img/@src")[0]

item["comment_num"] = table.xpath(".//span[@class='pl']/text()")[0]

item["rating_num"] = table.xpath(".//span[@class='rating_nums']/text()")[0]

print(item)

运行效果:

Python爬虫爬取豆瓣电影之数据提取值xpath和lxml模块的更多相关文章

- python 爬虫&爬取豆瓣电影top250

爬取豆瓣电影top250from urllib.request import * #导入所有的request,urllib相当于一个文件夹,用到它里面的方法requestfrom lxml impor ...

- python爬虫-爬取豆瓣电影数据

#!/usr/bin/python# coding=utf-8# 作者 :Y0010026# 创建时间 :2018/12/16 16:27# 文件 :spider_05.py# IDE :PyChar ...

- Python爬虫爬取豆瓣电影名称和链接,分别存入txt,excel和数据库

前提条件是python操作excel和数据库的环境配置是完整的,这个需要在python中安装导入相关依赖包: 实现的具体代码如下: #!/usr/bin/python# -*- coding: utf ...

- Python爬虫-爬取豆瓣电影Top250

#!usr/bin/env python3 # -*- coding:utf-8-*- import requests from bs4 import BeautifulSoup import re ...

- python爬取豆瓣电影信息数据

题外话+ 大家好啊,最近自己在做一个属于自己的博客网站(准备辞职回家养老了,明年再战)在家里 琐事也很多, 加上自己 一回到家就懒了(主要是家里冷啊! 广东十几度,老家几度,躲在被窝瑟瑟发抖,) 由于 ...

- Python小爬虫——抓取豆瓣电影Top250数据

python抓取豆瓣电影Top250数据 1.豆瓣地址:https://movie.douban.com/top250?start=25&filter= 2.主要流程是抓取该网址下的Top25 ...

- 写一个python 爬虫爬取百度电影并存入mysql中

目标是利用python爬取百度搜索的电影 在类型 地区 年代各个标签下 电影的名字 评分 和图片连接 以及 电影连接 首先我们先在mysql中建表 create table liubo4( id in ...

- python爬虫 Scrapy2-- 爬取豆瓣电影TOP250

sklearn实战-乳腺癌细胞数据挖掘(博主亲自录制视频) https://study.163.com/course/introduction.htm?courseId=1005269003& ...

- Python爬虫----抓取豆瓣电影Top250

有了上次利用python爬虫抓取糗事百科的经验,这次自己动手写了个爬虫抓取豆瓣电影Top250的简要信息. 1.观察url 首先观察一下网址的结构 http://movie.douban.com/to ...

随机推荐

- 【Leetcode】【Easy】Valid Parentheses

Given a string containing just the characters '(', ')', '{', '}', '[' and ']', determine if the inpu ...

- A full JDK must be specified

当你开发就了,你就发现,你遇到了各种奇葩的问题,结果,自己奇葩了. 背景:由于项目需要做安全恢复测试,然后,就搭一个新的库环境去测试: 配置jboss的运行jdk时,结果,蹦出个:A full JDK ...

- C4C Cloud Application Studio做ABSL开发的一些性能方面的最佳实践

Stefan Hagen在博文SAP Cloud Application Studio Performance Best Practices里介绍了在C4C里使用Cloud Application S ...

- 转 tcp协议里rst字段讲解

TCP协议的原理来谈谈rst复位攻击 http://russelltao.iteye.com/blog/1405349 几种TCP连接中出现RST的情况 https://blog.csdn.net/c ...

- 【Unity3D】【NGUI】UIRect的Anchor的使用

NGUI版本号:3.6.5 以以下的图,解释下主要的Anchors的使用(能够通过官方的Anchor和Chat样例进行深入学习) Target不是一定要是Sprite.能够是随意的UIRect(UIS ...

- BZOJ4066:简单题(K-D Tree)

Description 你有一个N*N的棋盘,每个格子内有一个整数,初始时的时候全部为0,现在需要维护两种操作: 命令 参数限制 内容 1 x y A 1<=x,y<=N,A是正整数 ...

- 使用Sleep方法延迟时间

实现效果: 关键知识:(线程的定义) 实现代码: private void Form1_Load(object sender, EventArgs e) { Thread show = new Thr ...

- 2018.11.1 Hibernate中的Mapper关系映射文件

Customer.hbm.xml 基本的参数都在里面了 <?xml version="1.0" encoding="UTF-8"?> <!DO ...

- dijkstra 最小费用最大流

前言:众所周知:spfa他死了 滑稽 dijkstra同样为最短路算法,为什么不能跑费用流qwq 好像是因为有负权边的缘故 但是如果我们如果使用某种玄学的将边权都拉回到正数的话 就可以跑了dijkst ...

- java基础知识一览

一.关键字:JDK1.5的新特性.Eclipse.MyEclipse.IDE.Workspace.Perspective.view.设置javac和java的版本.模块代码.快捷键.导入工程.静态导入 ...