利用docker搭建spark hadoop workbench

目的

- 用docker实现所有服务

- 在spark-notebook中编写Scala代码,实时提交到spark集群中运行

- 在HDFS中存储数据文件,spark-notebook中直接读取

组件

- Spark (Standalone模式, 1个master节点 + 可扩展的worker节点)

- Spark-notebook

- Hadoop name node

- Hadoop data node

- HDFS FileBrowser

实现

最初用了Big Data Europe的docker-spark-hadoop-workbench,但是docker 服务运行后在spark-notebook中运行代码会出现经典异常:

java.lang.ClassCastException: cannot assign instance of scala.collection.immutable.List$SerializationProxy to field org.apache.spark.rdd.RDD.org$apache$spark$rdd$RDD$$dependencies_ of type scala.collection.Seq in instance of org.apache.spark.rdd.MapPartitionsRDD

发现是因为spark-notebook和spark集群使用的spark版本不一致. 于是fork了Big Data Europe的repo,在此基础上做了一些修改,基于spark2.11-hadoop2.7实现了一个可用的workbench.

运行docker服务

docker-compose up -d

扩展spark worker节点

docker-compose scale spark-worker=

测试服务

各个服务的URL如下:

Namenode: http://localhost:50070

Datanode: http://localhost:50075

Spark-master: http://localhost:8080

Spark-notebook: http://localhost:9001

Hue (HDFS Filebrowser): http://localhost:8088/home

以下是各个服务的运行截图

HDFS Filebrower

Spark集群

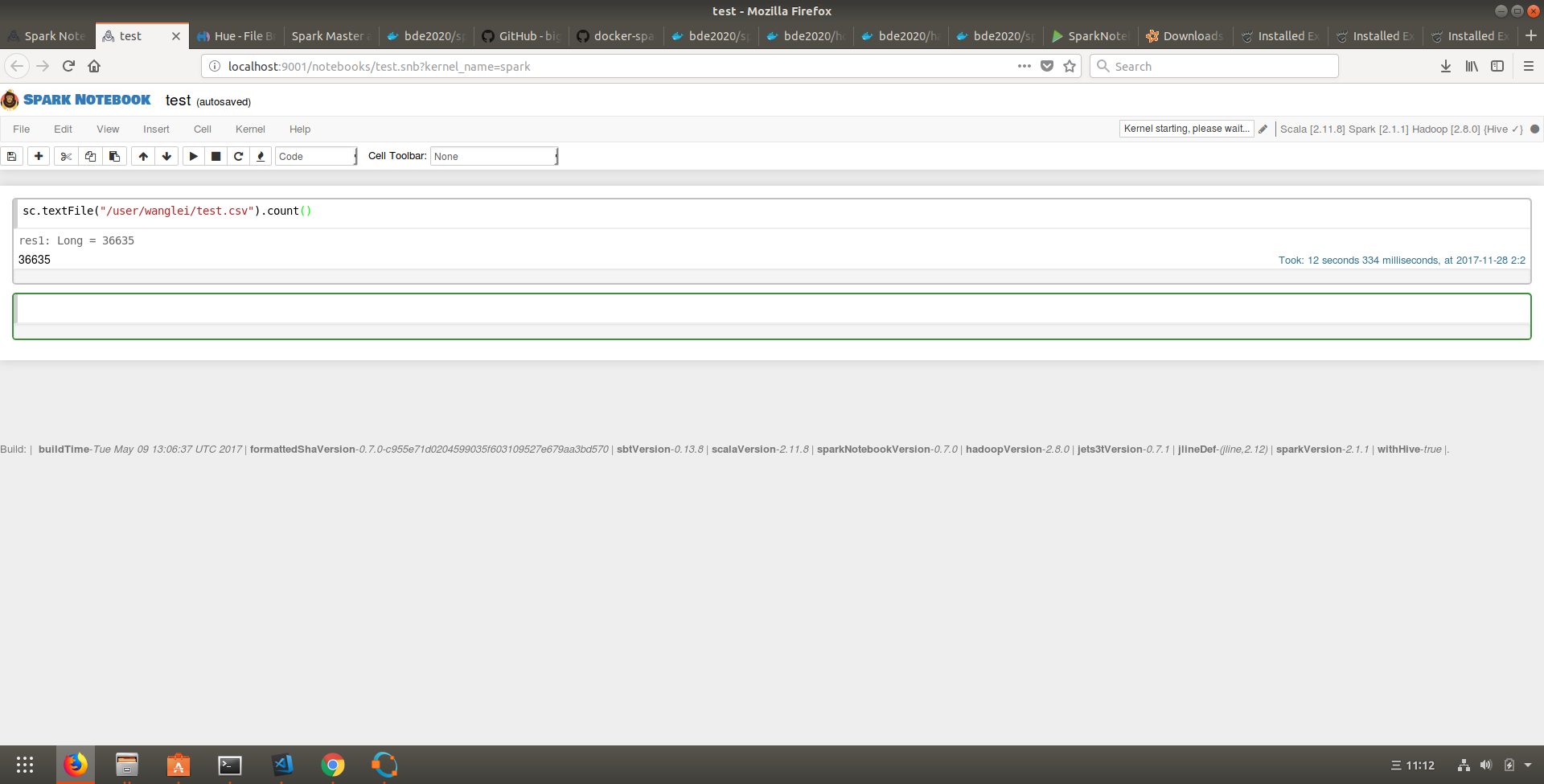

Spark-notebook

运行例子

1. 上传csv文件到HDFS FileBrowser,

2. Spark notebook新建一个notebook

3. 在新建的notebook里操作HDFS的csv文件

具体的步骤参考这里

以下是spark-notebook运行的截图:

代码链接

利用docker搭建spark hadoop workbench的更多相关文章

- 使用Docker搭建Spark集群(用于实现网站流量实时分析模块)

上一篇使用Docker搭建了Hadoop的完全分布式:使用Docker搭建Hadoop集群(伪分布式与完全分布式),本次记录搭建spark集群,使用两者同时来实现之前一直未完成的项目:网站日志流量分析 ...

- Windows下搭建Spark+Hadoop开发环境

Windows下搭建Spark+Hadoop开发环境需要一些工具支持. 只需要确保您的电脑已装好Java环境,那么就可以开始了. 一. 准备工作 1. 下载Hadoop2.7.1版本(写Spark和H ...

- 利用Docker搭建本地https环境的完整步骤

利用Docker搭建本地https环境的完整步骤 这篇文章主要给大家介绍了关于如何利用Docker搭建本地https环境的完整步骤,文中通过示例代码将实现的步骤介绍的非常详细,对大家的学习或者工作具有 ...

- 利用 Docker 搭建 IPFS 私有网络

利用 Docker 搭建 IPFS 私有网络 本文原始地址:https://sitoi.cn/posts/40630.html 下载项目 项目地址:https://github.com/Sitoi/p ...

- 利用 Docker 搭建单机的 Cloudera CDH 以及使用实践

想用 CDH 大礼包,于是先在 Mac 上和 Centos7.4 上分别搞个了单机的测试用.其实操作的流和使用到的命令差不多就一并说了: 首先前往官方下载包: https://www.cloudera ...

- 利用Docker搭建开发环境

一. 前言 随着平台的不断壮大,项目的研发对于开发人员而言,对于外部各类环境的依赖逐渐增加,特别是针对基础服务的依赖.这些现象导致开 发人员常常是为了简单从而直接使用公有的基础组件进行协同开发,在出现 ...

- ubuntu14.04环境下利用docker搭建solrCloud集群

在Ubuntu14.04操作系统的宿主机中,安装docker17.06.3,将宿主机的操作系统制作成docker基础镜像,之后使用自制的基础镜像在docker中启动3个容器,分配固定IP,再在3个容器 ...

- Docker入门详解——安装docker并利用docker搭建lnmp

首先我们需先安装docker环境,这个比较简单,以centos7为例 docker在centos7上安装需要系统内核版本3.10+,可以通过uname -r查看内核版本号,如果版本不符请自行查阅资料更 ...

- Docker 搭建Spark 依赖singularities/spark:2.2镜像

singularities/spark:2.2版本中 Hadoop版本:2.8.2 Spark版本: 2.2.1 Scala版本:2.11.8 Java版本:1.8.0_151 拉取镜像: [root ...

随机推荐

- c++中vector的pair与make_pair的使用,双关键字排序

#include <vector> #include <iostream> #include <algorithm> using namespace std; bo ...

- Fiddler使用总结(一)

与后端数据通信是前端日常开发的重要一环,在与后端接口联调的时候往往需要通过查看后端返回的数据进行调试.如果在PC端,Chrome自带的DevTools就已经足够用了,Network面板可以记录所有网络 ...

- Spring 为Bean对象执行初始化和销毁方法

1)初始化: ①可以利用<bean>元素的init-method="方法名"属性指定初始化方法. ②指定的初始化方法是在构造方法调用后自动执行.若非单例模式,则每创建一 ...

- Android+ESP8266+路由器实现远程控制(基于花生壳域名方式访问)

x先说一下实现的功能,其实就是远程控制 和这篇文章的控制 http://www.cnblogs.com/yangfengwu/p/5295632.html 应该说是这篇文章的升级,解决这篇文章由 ...

- jstl 处理字符串

1.引入 <%@ taglib uri="http://java.sun.com/jsp/jstl/functions" prefix="fn"%> ...

- Vue源码后记-vFor列表渲染(1)

钩子函数比较简单,没有什么意思,这一节搞点大事情 => 源码中v-for的渲染过程. vue的内置指令包含了v-html.v-if.v-once.v-bind.v-on.v-show等,先从一个 ...

- Abp异常-找不到方法:“System.String Abp.Runtime.Security.SimpleStringCipher.Decrypt(System.String, System.String, Byte[])”

解决方法:升级Abp.Zero版本到2.0.2

- 利用JavaScript实现动态显示表格且对应改变按键的value值

插入的代码并没有符合HTML5样式,只是为了实现利用JS动态显示表格,并且按键的value值会同时发生变化的功能. <!DOCTYPE > <html > <head&g ...

- SSH框架的多表查询和增删查改 (方法一)中

原创作品,允许转载,转载时请务必标明作者信息和声明本文章==>http://www.cnblogs.com/zhu520/p/7774144.html 这边文章是接的刚刚前一遍的基础上敲的 ...

- HTML5 input事件检测输入框变化[转载]

原文:http://www.linuxidc.com/Linux/2015-07/119984.htm 之前一直用change事件来监听输入框内容是否发生变化,只有当输入框失去焦点时才会触发,没想到h ...