002.Ceph安装部署

一 前期准备

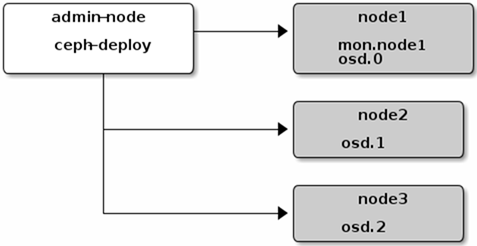

1.1 配置规格

|

节点

|

类型

|

IP

|

CPU

|

内存

|

|

ceph-deploy

|

部署管理平台

|

172.24.8.71

|

2 C

|

4 G

|

|

node1

|

Monitor OSD

|

172.24.8.72

|

2 C

|

8 G

|

|

node2

|

OSD

|

172.24.8.73

|

2 C

|

8 G

|

|

node3

|

OSD

|

172.24.8.74

|

2 C

|

8 G

|

1.2 前置准备

- 所有节点NTP安装及配置,具体操作略;

- 所有节点更新环境:

yum -y update

- deploy节点安装pip环境:

[root@deploy ~]# curl https://bootstrap.pypa.io/get-pip.py -o get-pip.py

[root@deploy ~]# python get-pip.py

- 配置国内yum源:

[root@node1 ~]# rm /etc/yum.repos.d/* -rf

[root@node1 ~]# wget -O /etc/yum.repos.d/CentOS-Base.repo http://mirrors.aliyun.com/repo/Centos-7.repo

[root@node1 ~]# yum -y install epel-release

[root@node1 ~]# mv /etc/yum.repos.d/epel.repo /etc/yum.repos.d/epel.repo.backup

[root@node1 ~]# mv /etc/yum.repos.d/epel-testing.repo /etc/yum.repos.d/epel-testing.repo.backup

[root@node1 ~]# wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo

- 部署节点配置主机名:

[root@deploy ~]# vi /etc/hosts

172.24.8.71 deploy

172.24.8.72 node1

172.24.8.73 node2

172.24.8.74 node3

- 配置deploy节点到所有OSD node节点的免秘钥登录:

[root@deploy ~]# useradd manager

[root@deploy ~]# echo manager | passwd --stdin manager #创建非root的管理用户

[root@deploy ~]# for i in {1..3}; do echo "====node${i}====";ssh root@node${i} 'useradd -d /home/cephuser -m cephuser; echo "cephuser" | passwd --stdin cephuser'; done #所有OSD node节点创建cephuser用户

[root@deploy ~]# for i in {1..3}; do echo "====node${i}====";ssh root@node${i} 'echo "cephuser ALL = (root) NOPASSWD:ALL" > /etc/sudoers.d/cephuser'; done

[root@deploy ~]# for i in {1..3}; do echo "====node${i}====";ssh root@node${i} 'chmod 0440 /etc/sudoers.d/cephuser'; done

[root@deploy ~]# su - manager

[manager@deploy ~]$ ssh-keygen -f ~/.ssh/id_rsa -N ''

[manager@deploy ~]$ ssh-copy-id -i ~/.ssh/id_rsa.pub cephuser@172.24.8.72

[manager@deploy ~]$ ssh-copy-id -i ~/.ssh/id_rsa.pub cephuser@172.24.8.73

[manager@deploy ~]$ ssh-copy-id -i ~/.ssh/id_rsa.pub cephuser@172.24.8.74

[manager@deploy ~]$ vi ~/.ssh/config #修改ceph-deploy管理节点上~/.ssh/config文件

Host node1

Hostname node1

User cephuser

Host node2

Hostname node2

User cephuser

Host node3

Hostname node3

User cephuser

[manager@deploy ~]$ chmod 600 .ssh/config

[manager@deploy ~]$ ssh node1 #测试

[cephuser@node1 ~]$ exit

1.3 部署需求

二 正式部署

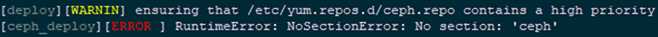

2.1 部署deploy节点

[root@deploy ~]# cat << EOM > /etc/yum.repos.d/ceph.repo

[ceph-noarch]

name=Ceph noarch packages

baseurl=https://download.ceph.com/rpm-mimic/el7/noarch

enabled=1

gpgcheck=1

type=rpm-md

gpgkey=https://download.ceph.com/keys/release.asc

EOM

[root@deploy ~]# vi /etc/yum.repos.d/ceph.repo

[ceph-noarch]

name=Ceph noarch packages

baseurl=https://mirrors.aliyun.com/ceph/rpm-mimic/el7/noarch

enabled=1

gpgcheck=1

type=rpm-md

gpgkey=https://mirrors.aliyun.com/ceph/keys/release.asc

[root@deploy ~]# yum install -y ceph-deploy

2.2 创建集群

[root@deploy ~]# su - manager

[manager@deploy ~]$ mkdir my-cluster

[manager@deploy ~]$ cd my-cluster/

[manager@deploy my-cluster]$ ceph-deploy new node1

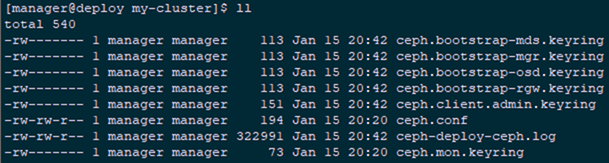

[manager@deploy my-cluster]$ ll

2.3 安装Ceph

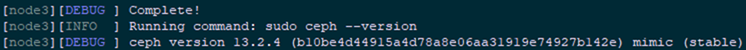

[manager@deploy my-cluster]$ ceph-deploy install node1 node2 node3

ceph-deploy install node1 node2 node3 --repo-url=https://mirrors.aliyun.com/ceph/rpm-mimic/el7/ --gpg-url=https://mirrors.aliyun.com/ceph/keys/release.asc

2.4 初始化monitor

[manager@deploy my-cluster]$ ceph-deploy mon create-initial #初始monitor、并收集所有密钥

[manager@deploy my-cluster]$ ll

2.5 部署MGR

[manager@deploy my-cluster]$ ceph-deploy mgr create node1 node2 node3

2.6 复制key

[manager@deploy my-cluster]$ ceph-deploy admin node1 node2 node3

2.7 添加OSD

[manager@deploy my-cluster]$ ceph-deploy disk list node1 node2 node3 #列出磁盘

[manager@deploy my-cluster]$ ceph-deploy osd create --data /dev/sdb node1

[manager@deploy my-cluster]$ ceph-deploy osd create --data /dev/sdb node2

[manager@deploy my-cluster]$ ceph-deploy osd create --data /dev/sdb node3

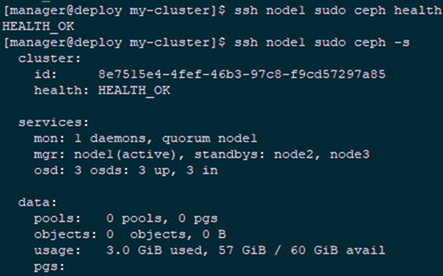

2.8 检测健康状态

[manager@deploy my-cluster]$ ssh node1 sudo ceph health

[manager@deploy my-cluster]$ ssh node1 sudo ceph -s

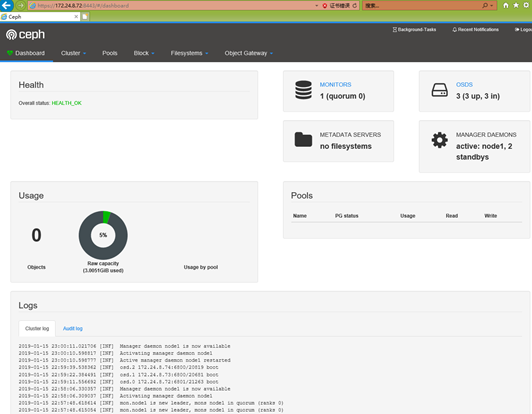

2.9 开启dashboard

[root@node1 ~]# ceph mgr module enable dashboard #开启dashboard模块

[root@node1 ~]# ceph dashboard create-self-signed-cert

[root@node1 ~]# ceph dashboard set-login-credentials admin admin #创建管理员

[root@node1 ~]# ceph mgr services #确认验证

002.Ceph安装部署的更多相关文章

- ceph安装部署

环境准备 测试环境是4台虚拟机,所有机器都是刚刚安装好系统(minimal),只配置完网卡和主机名的centos7.7,每个osd增加一块磁盘,/dev/sdb ceph-admin ---- adm ...

- centos6.4 ceph安装部署之ceph object storage

preface: ceph-deploy does not provide a rapid installation for Ceph Object Storage install Configura ...

- centos6.4 ceph安装部署之cephFS

1,ceph fileSystem

- centos6.4 ceph安装部署之ceph block device

1,prelight/preface ceph storage clusterceph block deviceceph filesystemceph object storage 此篇记录ceph ...

- 002.Oracle安装部署-ASM

一 环境准备 图形界面:略 安装包: linux.x64_11gR2_database_1of2.zip linux.x64_11gR2_database_2of2.zip 二 安装ASM-Oracl ...

- 002.Docker安装部署

一 docker安装-CentOS系统 1.1 docker自动安装脚本 root@docker:~# wget -qO- https://get.docker.com/ | sh 或—— root@ ...

- 安装部署Ceph Calamari

根据http://ovirt-china.org/mediawiki/index.php/%E5%AE%89%E8%A3%85%E9%83%A8%E7%BD%B2Ceph_Calamari 原文如下: ...

- ceph学习笔记之十二 Ubuntu安装部署Ceph J版本

https://cloud.tencent.com/info/2b70340c72d893c30f5e124e89c346cd.html 安装Ubuntu系统安装步骤略过 拓扑连接: 一.安装前准备工 ...

- ceph 存储安装部署

环境准备 1.三台服务器 cephnode01 192.168.254.83 cephnode02 192.168.254.84 cephnode03 192.168.254.85 2.基本环境配置 ...

随机推荐

- FTP服务器配置和管理

一:ftp 简介 1:ftp服务: internet 是一个非常复杂额计算机环境,其中有pc/mac/小型机/大型机等.而在这些计算机上运行的操作系统也是五花八门,有 unix.Linux.微软的wi ...

- 扇形多级菜单可配置Demo

预览效果 领导是想把这个做成复选框,所以做成了可以多选的... Demo下载:https://github.com/zhangzn3/arc-menu

- 《剑指offer》 大数递增

本题来自<剑指offer> 大数的存储 题目: 针对以下问题:大数的存储.大数的相加.大数的运算. 思路: 当数据较大时候,long long数据已经存储不了,借助数组的方式进行存储. 假 ...

- java----重载

重载: //同一个类中,方法名相同,参数列表不同[java就是靠不同的参数列表来寻找方法的],返回值可以任意,注意和函数的返回值类型相同.public class Demo { public stat ...

- sass方式实现颜色平铺(红色--->紫色)

<!DOCTYPE html><html lang="en"><head> <link rel="stylesheet" ...

- FCN 项目部分代码学习

下面代码由搭档注释,保存下来用作参考. github项目地址:https://github.com/shekkizh/FCN.tensorflowfrom __future__ import prin ...

- OpenCV-Python入门教程4-颜色空间转换

一.颜色空间转换 import cv2 import numpy as np img = cv2.imread('lena.jpg') # 转换成灰度图 img_gray = cv2.cvtColor ...

- python no module named builtins

使用python2时出现此错误. 解决办法: pip install future

- pycaffe简明文档

pycaffe简明文档 by ChrisZZ, imzhuo@foxmail.com 2018年01月18日19:00:56 说明 caffe的python接口没有官方说明文档,例如查看一个函数的用法 ...

- rabbitmq的安装与使用

1.RabbitMQ的安装,rabbitmq为erlang语言开发,所以先安装erlang语言开发包,现在电脑一般都是64位的,所以下载64位的都行了.红色框可以选择版本,箭头选择64位的进行下载.下 ...