CentOS下Hadoop运行环境搭建

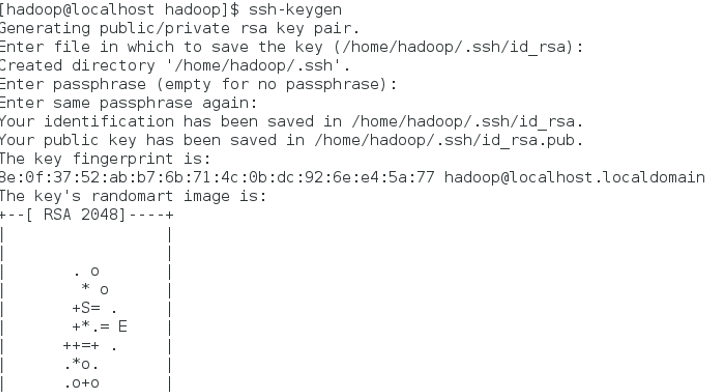

1.安装ssh免密登录

命令:ssh-keygen

overwrite(覆盖写入)输入y

一路回车

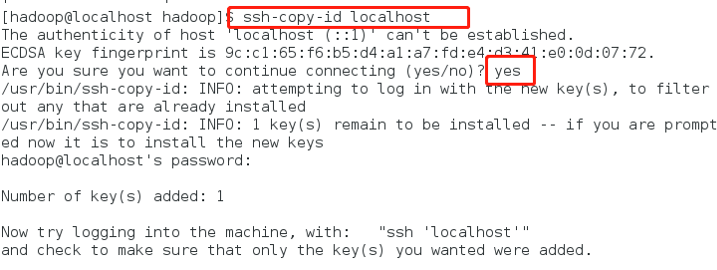

将生成的密钥发送到本机地址

ssh-copy-id localhost

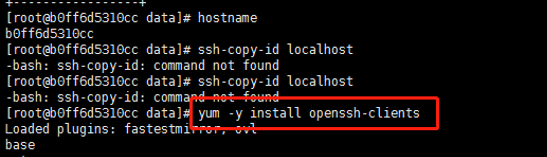

(若报错命令无法找到则需要安装openssh-clients)

命令:yum –y install openssh-clients

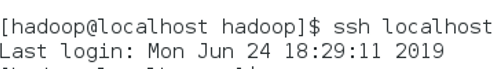

测试免密设置是否成功

ssh localhost

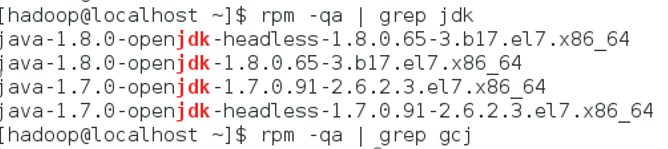

2. 卸载已有版本java

确定JDK版本

rpm –qa | grep jdk

rpm –qa | grep gcj

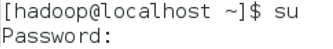

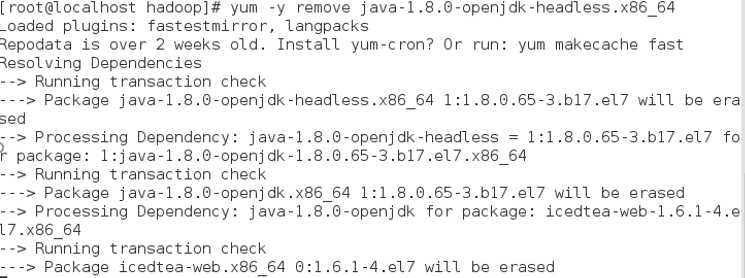

切换到root用户,根据结果卸载java

yum -y remove java-1.8.0-openjdk-headless.x86_64

yum -y remove java-1.7.0-openjdk-headless.x86_64

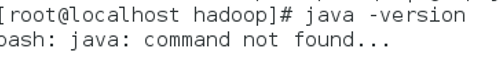

卸载后输入java –version查看

3. 安装java

换回hadoop用户,命令:su hadoop

查看下当前目标文件,命令:ls

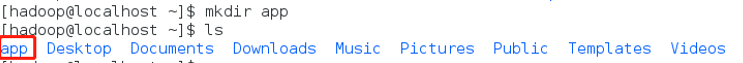

新建一个app文件夹,命令:mkdir app

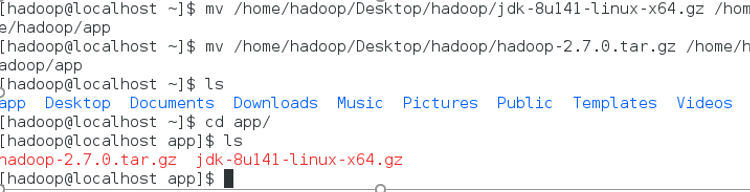

将桌面的hadoop文件夹中的java及hadoop安装包移动到app文件夹中

命令:

mv /home/hadoop/Desktop/hadoop/jdk-8u141-linux-x64.gz /home/hadoop/app

mv /home/hadoop/Desktop/hadoop/hadoop-2.7.0.tar.gz /home/hadoop/app

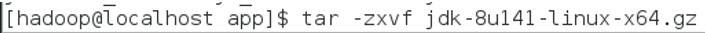

解压java程序包,命令:tar –zxvf jdk-7u79-linux-x64.tar.gz

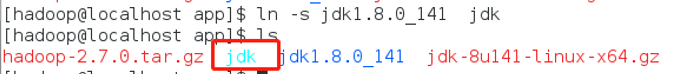

创建软连接

ln –s jdk1.8.0_141 jdk

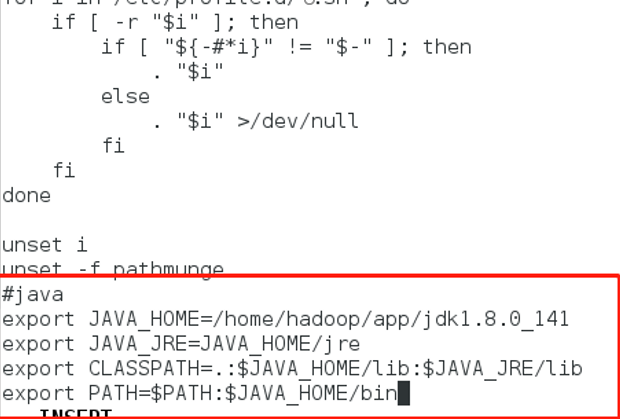

配置jdk环境变量

切换到root用户

再输入vi /etc/profile

输入

export JAVA_HOME=/home/hadoop/app/jdk1..0_141 export JAVA_JRE=JAVA_HOME/jre export CLASSPATH=.:$JAVA_HOME/lib:$JAVA_JRE/lib export PATH=$PATH:$JAVA_HOME/bin

保存退出,并使/etc/profile文件生效

source /etc/profile

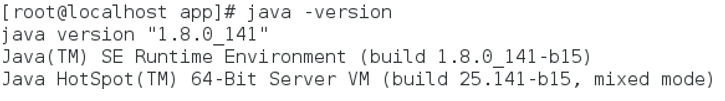

能查询jdk版本号,说明jdk安装成功

java -version

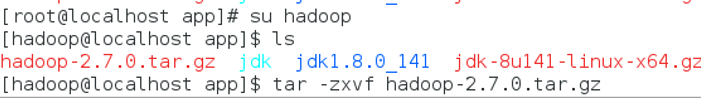

4. 安装Hadoop

切换回hadoop用户,解压缩hadoop-2.6.0.tar.gz安装包

tar -zxvf hadoop-2.7.0.tar.gz

创建软连接,命令:ln -s hadoop-2.7.0 hadoop

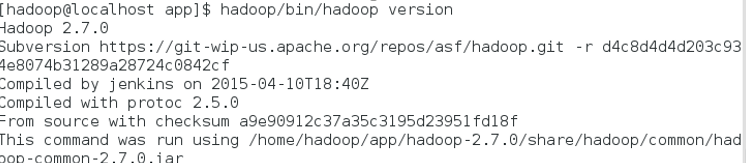

验证单机模式的Hadoop是否安装成功,命令:

hadoop/bin/hadoop version

此时可以查看到Hadoop安装版本为Hadoop2.7.0,说明单机版安装成功。

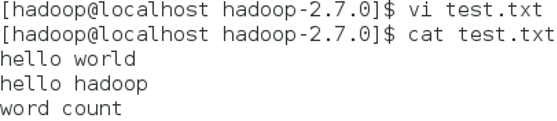

在Hadoop2.6.0安装目录下新建一个源数据文件test.txt,输入以下随机内容

测试运行Hadoop

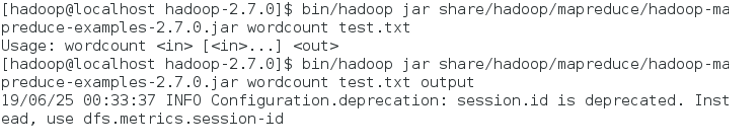

单机环境,输入命令运行Hadoop自带的WordCount程序,统计单词个数: bin/hadoop jar

share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.0. jar wordcount test.txt output

此时MapReduce程序读取的本地文件test.txt,输出目录output也在本地

查看wordcount运行结果

查看Hadoop目录结构

[hadoop@hadoop101 hadoop-2.7.]$ ll

总用量

drwxr-xr-x. hadoop hadoop 5月 bin

drwxr-xr-x. hadoop hadoop 5月 etc

drwxr-xr-x. hadoop hadoop 5月 include

drwxr-xr-x. hadoop hadoop 5月 lib

drwxr-xr-x. hadoop hadoop 5月 libexec

-rw-r--r--. hadoop hadoop 5月 LICENSE.txt

-rw-r--r--. hadoop hadoop 5月 NOTICE.txt

-rw-r--r--. hadoop hadoop 5月 README.txt

drwxr-xr-x. hadoop hadoop 5月 sbin

drwxr-xr-x. hadoop hadoop 5月 share

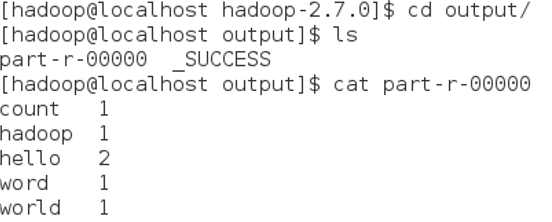

配置伪分布式登录

进入hadoop/etc/hadoop目录,修改相关配置文件

cd etc/

cd hadoop/

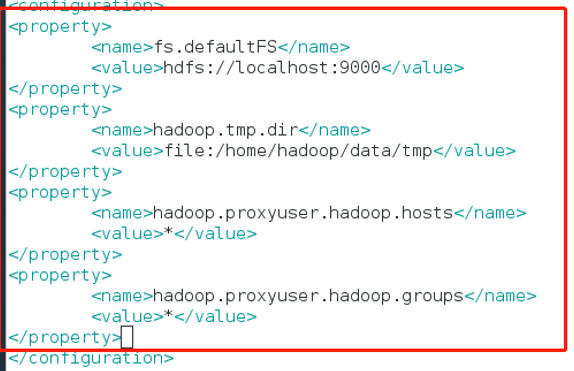

修改core-site.xml配置文件

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value> <!--hdfs 的主机名和端口号 -->

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/data/tmp</value> <!-- namenode datanode 的默认路径-->

</property>

<property>

<name>hadoop.proxyuser.hadoop.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.hadoop.groups</name>

<value>*</value>

</property>

</configuration>

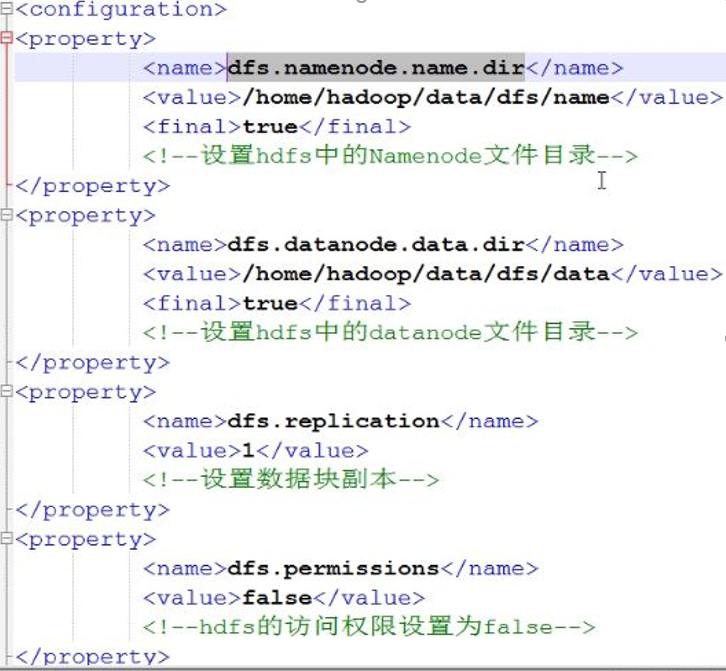

修改hdfs-site.xml配置文件

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>/data/dfs/name</value>

<final>true</final>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/dfs/data</value>

<final>true</final>

</property>

<property>

<name>dfs.replication</name>

<value></value>

</property>

<property>

<name>dfs.permissions</name>

<value>false</value>

</property>

</configuration>

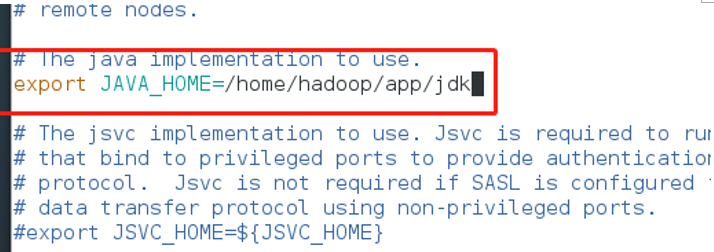

修改hadoop-env.sh配置文件

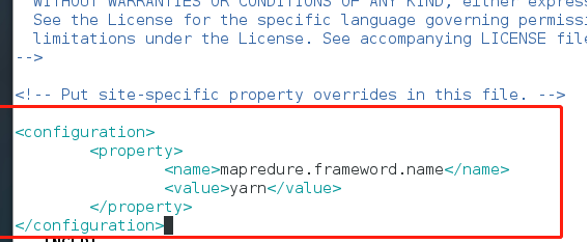

修改mapred-site.xml.template配置文件

<configuration>

<property>

<name>mapreduce.frameword.name</name>

<value>yarn</value>

</property>

</configuration>

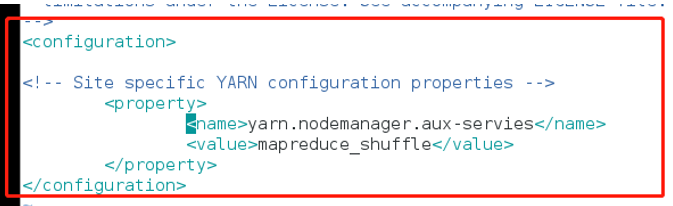

修改yarn-site.xml配置文件

<configuration>

<property>

<name>yarn.nodemanager.aux-servies</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

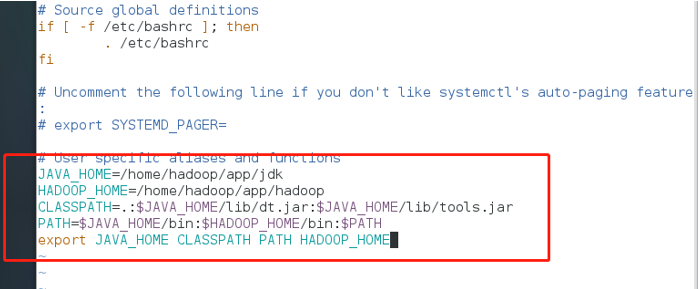

配置hadoop环境变量

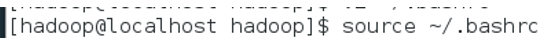

使修改生效,命令:sourec ~/.bashrc

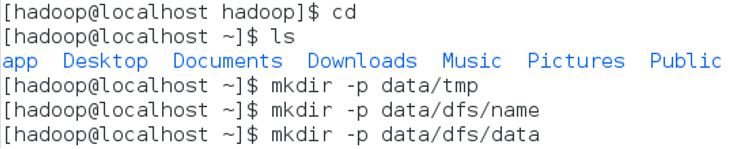

创建hadoop相关数据目录

在hadoop相关配置文件中配置了多个数据目录,提前建立这些文件夹

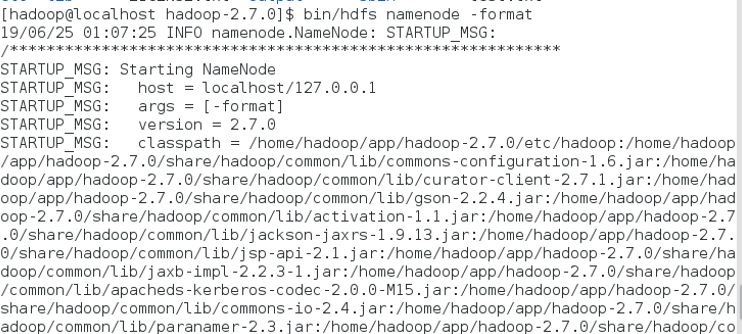

格式化namenode

在启动hadoop集群前需要格式化namenode。需要注意的是,第一次安装Hadoop集群的时候需要格式化Namenode,以后直接启动Hadoop集群即可,不需要重复格式化Namenode。

切回到hadoop目录,输入如下命令:

bin/hdfs namenode -format

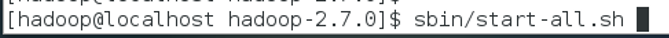

启动hadoop伪分布式集群

sbin/start-all.sh

启动完毕输入jps查看

出现上面所有进程表示启动成功

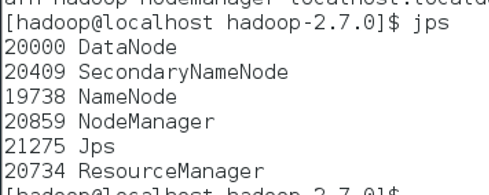

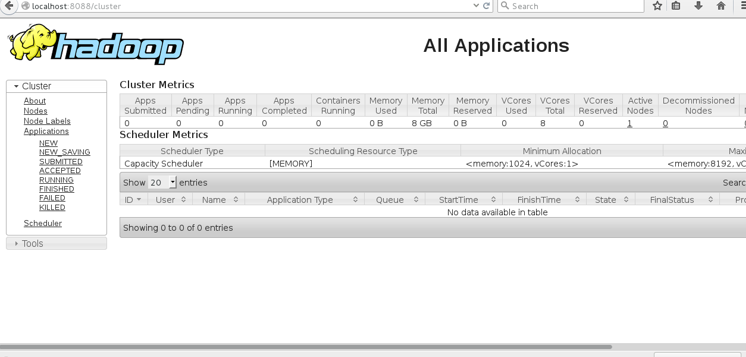

通过网页访问

localhost:50070

localhost:8088

测试运行hadoop伪分布式集群

hadoop伪分布式集群搭建完成,通过命令查看hdfs根目录下没有任何文件

bin/hdfs dfs –ls /

将之前本地新建的test.txt文件上传至hdfs

bin/hdfs dfs –mkdir /data (在集群上新建一个数据文件夹)

bin/hdfs dfs –put test.txt /data(将本地的test文件上传到集群中的data文件夹)

运行wordcount程序计数

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.0.jar wordcount /data/test.txt /data/output

查看运行结果

bin/hdfs dfs –cat /data/output/*

CentOS下Hadoop运行环境搭建的更多相关文章

- PHP - CentOS下开发运行环境搭建(Apache+PHP+MySQL+FTP)

本文介绍如何在 Linux下搭建一个 PHP 环境.其中 Linux 系统使用是 CentOS 7.3,部署在阿里云服务器上. 1,连接登录服务器 拿到服务器的 ip.初始密码以后.我们先通过远程 ...

- Hadoop运行环境搭建

Hadoop运行环境搭建 更改为阿里的Centos7的yum源 #下载wget yum -y install wget #echo 下载阿里云的yum源配置 Centos-7.repo wget - ...

- CentOS下Web服务器环境搭建LNMP一键安装包

CentOS下Web服务器环境搭建LNMP一键安装包 时间:2014-09-04 00:50来源:osyunwei.com 作者:osyunwei.com 举报 点击:3797次 最新版本:lnmp- ...

- CentOS下JAVA WEB 环境搭建

首先介绍下我的软件环境.虚拟机Vmware9.0(已经汉化),CentOS6.4(选择安装语言为简体中文),xshell4.0(强大的安全终端模拟软件),xftp4.0(FTP工具). 方便大家环境搭 ...

- centos下的lnmp环境搭建

1.配置centos的第三方yum源,因为原始的yum是无法安装nginx的 wget http://www.atomicorp.com/installers/atomic 下载atomic yum ...

- CentOS下 pycharm开发环境搭建之无穷无尽的问题

在上一篇的环境搭建中,表面上以为已经升级好python,安装好pycharm,并且可以用上了django框架,谁知道,谁知道,又是一断被虐的经历,我都要快恼羞成怒了. 在些记录一下我的经历. 1.首先 ...

- WMware 中CentOS系统Hadoop 分布式环境搭建(一)——Hadoop安装环境准备

1.创建3台虚拟机并装好系统,这里使用64位CentOS. 2.Ping测试[确保两两能ping通]: [ping xxx.xxx.xxx.xxx] 3.安装SSH:[yum install ssh ...

- CentOS下 pycharm开发环境搭建

经过一系统列的折腾之后,我终于有高版本的python和我熟悉的输入法用了,下面来搭建pycharm下的python开发环境. 1.首先安装java jdk注意是JAVA 的JDK,不是JAVA VM什 ...

- 啃掉Hadoop系列笔记(02)-Hadoop运行环境搭建

一.新增一个普通用户bigdata

随机推荐

- Redis 是怎么实现 “附近的人” 的?

针对"附近的人"这一位置服务领域的应用场景,常见的可使用PG.MySQL和MongoDB等多种DB的空间索引进行实现. 而Redis另辟蹊径,结合其有序队列zset以及geohas ...

- ByteArrayInputStream类

一.说明 哈哈,这是学习Java之路的第一篇博文.虽然说接触学习Java有一段时间了,但是对流的概念一直并不是很清楚.也看了很多资料,但是感觉还是非常的抽象很难去理解.但是流又是Java中很重要的一部 ...

- Linux系列(4):入门之文件权限与目录配置

众所周知,Linux是多用户多任务的操作系统.那么如何解决自己文件不被其他用户访问呢?这就需要引入权限管理了. Linux根据文件的所属者分为3个类别:owner.group.others,且每个类别 ...

- 拨开Python迷雾

Python方向及能力要求 web就业方向:Python基础.Python高级.前端开发. web开发爬虫方向:Python基础.Python高级.前端开发.web开发. 爬虫开发数据挖掘/分析方 ...

- X86逆向2:提取按钮通杀特征码

本章我们将学习特征码的提取与定位,特征码是软件中一段固定的具有标志性的代码片段,特征码的用途非常广泛,最常见的就是杀毒软件的查杀了,查杀就是根据特征码定位技术实现的,再比如木马的免杀也是修改了特征码的 ...

- Scala学习十——特质

一.本章要点 类可以实现任意数量的特质 特质可以要求实现它们的类具备特定的字段,方法或超类 和Java接口不同,Scala特质可以提供方法和字段实现 当你将多个特质叠加在一起时,顺序很重要——其方法先 ...

- workerman stop失败

1.官网说明:https://www.bookstack.cn/read/workerman-manual/faq-stop-fail.md 2.workerman.pid 中的有一个pid号,置为空 ...

- sql server 多条数据字段合并及创建临时表 FOR XML PATH

SELECT 字段=(SELECT b.合并字段+',' FROM 表一 AS b WHERE b.相同条件=a.相同条件 FOR XML PATH('')) FROM 表一 AS a DECLARE ...

- O031、Start Instance 操作详解

参考https://www.cnblogs.com/CloudMan6/p/5470723.html 本节将通过日志文件分析 instance start 的操作过程,下面是 start inst ...

- 原生JS-实现轮播图

用原生JS实现一个轮播图(效果) HTML <div id="outer"> <ul id="imgList"> <!-- 图片列 ...