CNN之池化层tf.nn.max_pool | tf.nn.avg_pool | tf.reduce_mean | padding的规则解释

摘要:池化层的主要目的是降维,通过滤波器映射区域内取最大值、平均值等操作。

均值池化:tf.nn.avg_pool(input,ksize,strides,padding)

最大池化:tf.nn.max_pool(input,ksize,strides,padding)

input:通常情况下是卷积层输出的featuremap,shape=[batch,height,width,channels]

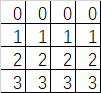

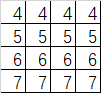

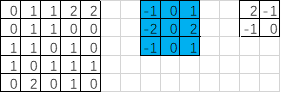

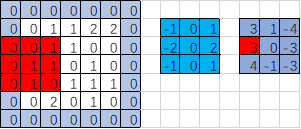

假定这个矩阵就是卷积层输出的featuremap(2通道输出) 他的shape=[1,4,4,2]

ksize:池化窗口大小 shape=[batch,height,width,channels] 比如[1,2,2,1]

strides: 窗口在每一个维度上的移动步长 shape=[batch,stride,stride,channel] 比如[1,2,2,1]

padding:“VALID”不填充 “SAME”填充0

返回:tensor shape=[batch,height,width,channels]

上图是采用的最大池化,取红色框内最大的一个数。

import tensorflow as tf

feature_map = tf.constant([

[[0.0,4.0],[0.0,4.0],[0.0,4.0],[0.0,4.0]],

[[1.0,5.0],[1.0,5.0],[1.0,5.0],[1.0,5.0]],

[[2.0,6.0],[2.0,6.0],[2.0,6.0],[2.0,6.0]] ,

[[3.0,7.0],[3.0,7.0],[3.0,7.0],[3.0,7.0]]

])

feature_map = tf.reshape(feature_map,[1,4,4,2])##两通道featuremap输入 ##定义池化层

pooling = tf.nn.max_pool(feature_map,[1,2,2,1],[1,2,2,1],padding='VALID')##池化窗口2*2,高宽方向步长都为2,不填充

pooling1 = tf.nn.max_pool(feature_map,[1,2,2,1],[1,1,1,1],padding='VALID')##池化窗口2*2,高宽方向步长都为1,不填充

pooling2 = tf.nn.avg_pool(feature_map,[1,4,4,1],[1,1,1,1],padding='SAME')##池化窗口4*4,高宽方向步长都为1,填充

pooling3 = tf.nn.avg_pool(feature_map,[1,4,4,1],[1,4,4,1],padding='SAME')##池化窗口4*4,高宽方向步长都为4,填充

##转置变形(详细解释参考另一篇博文)

tran_reshape = tf.reshape(tf.transpose(feature_map),[-1,16])

pooling4 = tf.reduce_mean(tran_reshape,1) ###对行值求平均

with tf.Session() as sess:

print('featuremap:\n',sess.run(feature_map))

print('*'*30)

print('pooling:\n',sess.run(pooling))

print('*'*30)

print('pooling1:\n',sess.run(pooling1))

print('*'*30)

print('pooling2:\n',sess.run(pooling2))

print('*'*30)

print('pooling3:\n',sess.run(pooling3))

print('*'*30)

print('pooling4:\n',sess.run(pooling4))

'''

输出结果:

featuremap:

[[[[ 0. 4.]

[ 0. 4.]

[ 0. 4.]

[ 0. 4.]] [[ 1. 5.]

[ 1. 5.]

[ 1. 5.]

[ 1. 5.]] [[ 2. 6.]

[ 2. 6.]

[ 2. 6.]

[ 2. 6.]] [[ 3. 7.]

[ 3. 7.]

[ 3. 7.]

[ 3. 7.]]]]

******************************

pooling:

[[[[ 1. 5.]

[ 1. 5.]] [[ 3. 7.]

[ 3. 7.]]]]

******************************

pooling1:

[[[[ 1. 5.]

[ 1. 5.]

[ 1. 5.]] [[ 2. 6.]

[ 2. 6.]

[ 2. 6.]] [[ 3. 7.]

[ 3. 7.]

[ 3. 7.]]]]

******************************

pooling2:

[[[[ 1. 5. ]

[ 1. 5. ]

[ 1. 5. ]

[ 1. 5. ]] [[ 1.5 5.5]

[ 1.5 5.5]

[ 1.5 5.5]

[ 1.5 5.5]] [[ 2. 6. ]

[ 2. 6. ]

[ 2. 6. ]

[ 2. 6. ]] [[ 2.5 6.5]

[ 2.5 6.5]

[ 2.5 6.5]

[ 2.5 6.5]]]]

******************************

pooling3:

[[[[ 1.5 5.5]]]]

******************************

pooling4:

[ 1.5 5.5] '''

池化层常用函数及参数

现在我们对代码中的内容加以解释:

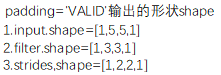

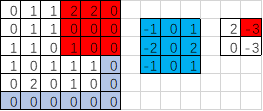

padding的规则

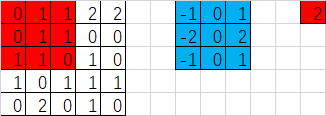

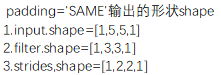

- padding=‘VALID’时,输出的宽度和高度的计算公式(下图gif为例)

输出宽度:output_width = (in_width-filter_width+1)/strides_width =(5-3+1)/2=1.5【向上取整=2】

输出高度:output_height = (in_height-filter_height+1)/strides_height =(5-3+1)/2=1.5【向上取整=2】

输出的形状[1,2,2,1]

import tensorflow as tf

image = [0,1.0,1,2,2,0,1,1,0,0,1,1,0,1,0,1,0,1,1,1,0,2,0,1,0]

input = tf.Variable(tf.constant(image,shape=[1,5,5,1])) ##1通道输入

fil1 = [-1.0,0,1,-2,0,2,-1,0,1]

filter = tf.Variable(tf.constant(fil1,shape=[3,3,1,1])) ##1个卷积核对应1个featuremap输出 op = tf.nn.conv2d(input,filter,strides=[1,2,2,1],padding='VALID') ##步长2,VALID不补0操作 init = tf.global_variables_initializer() with tf.Session() as sess:

sess.run(init)

# print('input:\n', sess.run(input))

# print('filter:\n', sess.run(filter))

print('op:\n',sess.run(op)) ##输出结果

'''

[[[[ 2.]

[-1.]] [[-1.]

[ 0.]]]]

'''

tensorflow中实现(步长2)

如果strides=[1,3,3,1]的情况又是如何呢?

输出宽度:output_width = (in_width-filter_width+1)/strides_width =(5-3+1)/3=1

输出高度:output_height = (in_height-filter_height+1)/strides_height =(5-3+1)/3=1

输出的形状[1,1,1,1],因此输出的结果只有一个

import tensorflow as tf

image = [0,1.0,1,2,2,0,1,1,0,0,1,1,0,1,0,1,0,1,1,1,0,2,0,1,0]

input = tf.Variable(tf.constant(image,shape=[1,5,5,1])) ##1通道输入

fil1 = [-1.0,0,1,-2,0,2,-1,0,1]

filter = tf.Variable(tf.constant(fil1,shape=[3,3,1,1])) ##1个卷积核对应1个featuremap输出 op = tf.nn.conv2d(input,filter,strides=[1,3,3,1],padding='VALID') ##步长2,VALID不补0操作 init = tf.global_variables_initializer() with tf.Session() as sess:

sess.run(init)

# print('input:\n', sess.run(input))

# print('filter:\n', sess.run(filter))

print('op:\n',sess.run(op)) ##输出结果

'''

op:

[[[[ 2.]]]]

'''

tensorflow中实现(步长3)

padding=‘SAME’时,输出的宽度和高度的计算公式(下图gif为例)

输出宽度:output_width = in_width/strides_width=5/2=2.5【向上取整3】

输出高度:output_height = in_height/strides_height=5/2=2.5【向上取整3】

则输出的形状:[1,3,3,1]

那么padding补0的规则又是如何的呢?【先确定输出形状,再计算补多少0】

pad_width = max((out_width-1)*strides_width+filter_width-in_width,0)=max((3-1)*2+3-5,0)=2

pad_height = max((out_height-1)*strides_height+filter_height-in_height,0)=max((3-1)*2+3-5,0)=2

pad_top = pad_height/2=1

pad_bottom = pad_height-pad_top=1

pad_left = pad_width/2=1

pad_right = pad_width-pad_left=1

import tensorflow as tf

image = [0,1.0,1,2,2,0,1,1,0,0,1,1,0,1,0,1,0,1,1,1,0,2,0,1,0]

input = tf.Variable(tf.constant(image,shape=[1,5,5,1])) ##1通道输入

fil1 = [-1.0,0,1,-2,0,2,-1,0,1]

filter = tf.Variable(tf.constant(fil1,shape=[3,3,1,1])) ##1个卷积核对应1个featuremap输出 op = tf.nn.conv2d(input,filter,strides=[1,2,2,1],padding='SAME') ##步长2,VALID不补0操作 init = tf.global_variables_initializer() with tf.Session() as sess:

sess.run(init)

# print('input:\n', sess.run(input))

# print('filter:\n', sess.run(filter))

print('op:\n',sess.run(op)) ##输出结果

'''

op:

[[[[ 3.]

[ 1.]

[-4.]] [[ 3.]

[ 0.]

[-3.]] [[ 4.]

[-1.]

[-3.]]]]

'''

SAME步长2

如果步长为3呢?补0的规则又如何?

输出宽度:output_width = in_width/strides_width=5/3=2

输出高度:output_height = in_height/strides_height=5/3=2

则输出的形状:[1,2,2,1]

那么padding补0的规则又是如何的呢?【先确定输出形状,再计算补多少0】

pad_width = max((out_width-1)*strides_width+filter_width-in_width,0)=max((2-1)*3+3-5,0)=1

pad_height = max((out_height-1)*strides_height+filter_height-in_height,0)=max((2-1)*3+3-5,0)=1

pad_top = pad_height/2=0【向下取整】

pad_bottom = pad_height-pad_top=1

pad_left = pad_width/2=0【向下取整】

pad_right = pad_width-pad_left=1

import tensorflow as tf

print(3/2)

image = [0,1.0,1,2,2,0,1,1,0,0,1,1,0,1,0,1,0,1,1,1,0,2,0,1,0]

input = tf.Variable(tf.constant(image,shape=[1,5,5,1])) ##1通道输入

fil1 = [-1.0,0,1,-2,0,2,-1,0,1]

filter = tf.Variable(tf.constant(fil1,shape=[3,3,1,1])) ##1个卷积核对应1个featuremap输出 op = tf.nn.conv2d(input,filter,strides=[1,3,3,1],padding='SAME') ##步长2,VALID不补0操作 init = tf.global_variables_initializer() with tf.Session() as sess:

sess.run(init)

# print('input:\n', sess.run(input))

# print('filter:\n', sess.run(filter))

print('op:\n',sess.run(op)) ##输出结果

'''

op:

[[[[ 2.]

[-3.]] [[ 0.]

[-3.]]]]

'''

SAME步长3

这里借用的卷积中的padding规则,在池化层中的padding规则与卷积中的padding规则一致

CNN之池化层tf.nn.max_pool | tf.nn.avg_pool | tf.reduce_mean | padding的规则解释的更多相关文章

- 深入解析CNN pooling 池化层原理及其作用

原文地址:https://blog.csdn.net/CVSvsvsvsvs/article/details/90477062 池化层作用机理我们以最简单的最常用的max pooling最大池化层为例 ...

- tensorflow的卷积和池化层(二):记实践之cifar10

在tensorflow中的卷积和池化层(一)和各种卷积类型Convolution这两篇博客中,主要讲解了卷积神经网络的核心层,同时也结合当下流行的Caffe和tf框架做了介绍,本篇博客将接着tenso ...

- TensorFlow 池化层

在 TensorFlow 中使用池化层 在下面的练习中,你需要设定池化层的大小,strides,以及相应的 padding.你可以参考 tf.nn.max_pool().Padding 与卷积 pad ...

- 【深度学习篇】--神经网络中的池化层和CNN架构模型

一.前述 本文讲述池化层和经典神经网络中的架构模型. 二.池化Pooling 1.目标 降采样subsample,shrink(浓缩),减少计算负荷,减少内存使用,参数数量减少(也可防止过拟合)减少输 ...

- tensorflow CNN 卷积神经网络中的卷积层和池化层的代码和效果图

tensorflow CNN 卷积神经网络中的卷积层和池化层的代码和效果图 因为很多 demo 都比较复杂,专门抽出这两个函数,写的 demo. 更多教程:http://www.tensorflown ...

- 第十三节,使用带有全局平均池化层的CNN对CIFAR10数据集分类

这里使用的数据集仍然是CIFAR-10,由于之前写过一篇使用AlexNet对CIFAR数据集进行分类的文章,已经详细介绍了这个数据集,当时我们是直接把这些图片的数据文件下载下来,然后使用pickle进 ...

- CNN学习笔记:池化层

CNN学习笔记:池化层 池化 池化(Pooling)是卷积神经网络中另一个重要的概念,它实际上是一种形式的降采样.有多种不同形式的非线性池化函数,而其中“最大池化(Max pooling)”是最为常见 ...

- ubuntu之路——day17.3 简单的CNN和CNN的常用结构池化层

来看上图的简单CNN: 从39x39x3的原始图像 不填充且步长为1的情况下经过3x3的10个filter卷积后 得到了 37x37x10的数据 不填充且步长为2的情况下经过5x5的20个filter ...

- CNN中卷积层 池化层反向传播

参考:https://blog.csdn.net/kyang624823/article/details/78633897 卷积层 池化层反向传播: 1,CNN的前向传播 a)对于卷积层,卷积核与输入 ...

随机推荐

- 回溯---Permutations II

47.Permutations II (Medium)](https://leetcode.com/problems/permutations-ii/description/) [1,1,2] hav ...

- IIS是怎么处理多个请求的?

一,假设有一台服务器,它的IIS上部署有一个Web应用程序-S,可以通过浏览器或其他方式进行访问. 假设有A.B.C三台电脑同时访问网站S,IIS接收到3个HTTP请求,然后分别为三个请求 ...

- 系统盘(c盘)空间清理方法总结(转)

我们一般会把系统安装在C盘,但是使用一段时间后会发现C盘的空间越来越少.尤其我们做开发的,会在电脑中装上很多软件的.比如我的机器上C盘空间15G,平时安装软件时只要可以选择我都会把它装到其他盘的, ...

- sparkStreaming复习笔记(1)

一.SparkStreaming 1.sparkcore模块的扩展,具有可扩展,高吞吐量,容错机制,针对实时数据流处理,数据可以来自于kafka,flume以及tcp套接字,可以使用更加复杂的函数来进 ...

- 【转】C/C++产生随机数

转自:https://www.cnblogs.com/vectors07/p/8185215.html C/C++怎样产生随机数:这里要用到的是rand()函数, srand()函数,C语言/C++里 ...

- less:注释

less有两种注释方法,一种是// 一种是/**/ 这两者的区别是/**/是会被编译成css里面,而//则不会 举个例子(使用的less在线编译器) 我们看到//注释并没有编译到css里面

- Ubuntu NFS搭建过程

先简单介绍一下NFS服务器是什么? NFS server可以看作是一个FILE SERVER,它可以让你的PC通过网络将远端的NFS SERVER共享出来的档案MOUNT到自己的系统中,在CLIENT ...

- idea中ehcahe配置中 Cannot find the declaration of element 'ehcache'.

ehcahe.xml 中报错: Cannot find the declaration of element 'ehcache'. 打开settings->languages&frame ...

- Thinkphp 请求和响应

一. Request对象获取方法 1. request() 助手函数获取 2. think\Request 类获取 3.利用框架注入Request对象 Request方法时单利方法 在think框架 ...

- windows 10 删除资源管理器导航栏 Creative Cloud Files

安装完Adobe的Photoshop.After Effects等软件后,资源管理器导航栏会出现让人讨厌的Creative Cloud Files目录,稍微修改注册表即可删除. 快捷键Windows ...