flink⼿手动维护kafka偏移量量

flink对接kafka,官方模式方式是自动维护偏移量

2:数据可能重复处理理

flink从kafka拉去数据过程中,如果此时flink进程挂掉,那么重启flink之后,会从当前Topic的 起始偏移量量开始消费

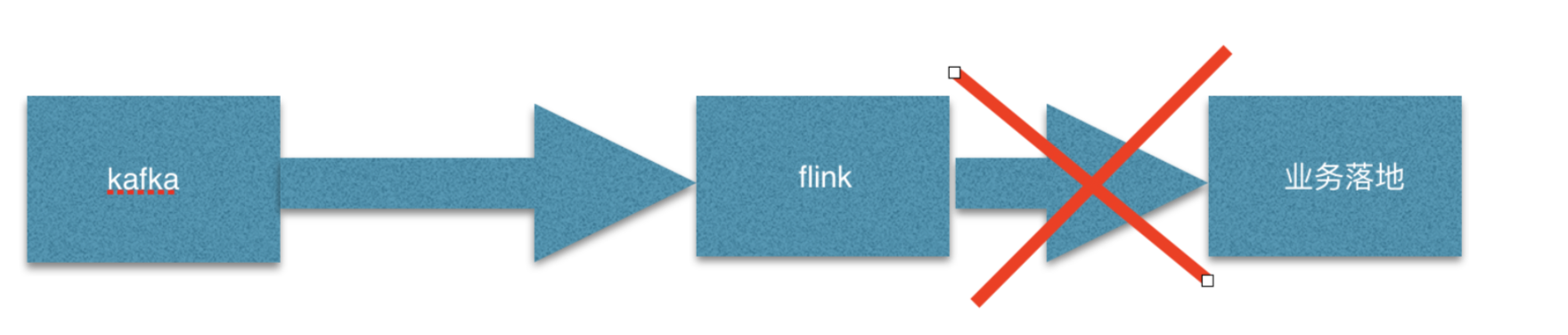

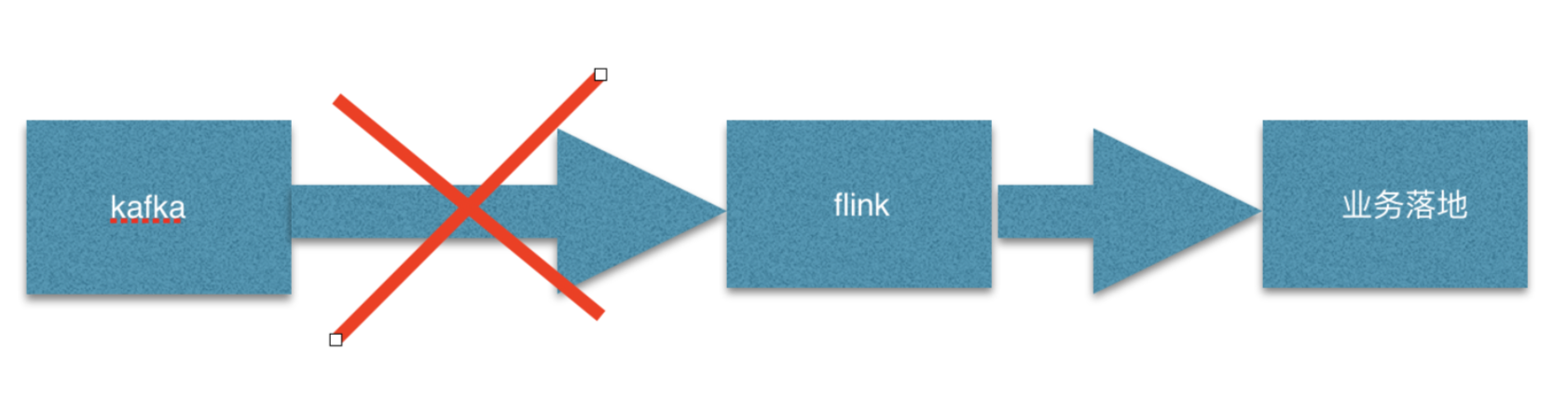

解决flink消费kafka的弊端

上述问题,在任何公司的实际⽣生产中,都会遇到,并且⽐比较头痛的事情,主要原因是因为上述的代码 是使⽤用flink⾃自动维护kafka的偏移量量,导致⼀一些实际⽣生产问题出现。~那么为了了解决这些问题,我们就 需要⼿手动维护kafka的偏移量量,并且保证kafka的偏移量量和flink的checkpoint的数据状态保持⼀一致 (最好是⼿手动维护偏移量量的同时,和现有业务做成事务放在⼀一起)~

1):offset和checkpoint绑定

//创建kafka数据流

val properties = new Properties() properties.setProperty("bootstrap.servers", GlobalConfigUtils.getBootstrap) properties.setProperty("zookeeper.connect", GlobalConfigUtils.getZk) properties.setProperty("group.id", GlobalConfigUtils.getConsumerGroup) properties.setProperty("enable.auto.commit" , "true")//TODO properties.setProperty("auto.commit.interval.ms" , "5000") properties.setProperty("auto.offset.reset" , "latest") properties.put("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer"); properties.put("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

val kafka09 = new FlinkKafkaConsumer09[String](

GlobalConfigUtils.getIntputTopic,

new SimpleStringSchema(),

properties

)

/** *

如果checkpoint启⽤用,当checkpoint完成之后,Flink Kafka Consumer将会提交offset保存 到checkpoint State中,

这就保证了了kafka broker中的committed offset与 checkpoint stata中的offset相⼀一致。 ⽤用户可以在Consumer中调⽤用setCommitOffsetsOnCheckpoints(boolean) ⽅方法来选择启⽤用 或者禁⽤用offset committing(默认情况下是启⽤用的)

* */

kafka09.setCommitOffsetsOnCheckpoints(true)

kafka09.setStartFromLatest()//start from the latest record

kafka09.setStartFromGroupOffsets()

//添加数据源addSource(kafka09)

val data: DataStream[String] = env.addSource(kafka09)

2):编写flink⼿手动维护kafka偏移量量

/**

* ⼿手动维护kafka的偏移量量 */

object KafkaTools {

var offsetClient: KafkaConsumer[Array[Byte], Array[Byte]] = null

var standardProps:Properties = null

def init():Properties = {

standardProps = new Properties

standardProps.setProperty("bootstrap.servers",

GlobalConfigUtils.getBootstrap)

standardProps.setProperty("zookeeper.connect", GlobalConfigUtils.getZk)

standardProps.setProperty("group.id",

GlobalConfigUtils.getConsumerGroup)

standardProps.setProperty("enable.auto.commit" , "true")//TODO

standardProps.setProperty("auto.commit.interval.ms" , "")

standardProps.setProperty("auto.offset.reset" , "latest")

standardProps.put("key.deserializer",

"org.apache.kafka.common.serialization.StringDeserializer");

standardProps.put("value.deserializer",

"org.apache.kafka.common.serialization.StringDeserializer");

standardProps

}

def getZkUtils():ZkUtils = {

val zkClient = new ZkClient("hadoop01:2181")

ZkUtils.apply(zkClient, false)

}

def createTestTopic(topic: String, numberOfPartitions: Int,

replicationFactor: Int, topicConfig: Properties) = {

val zkUtils = getZkUtils()

try{

AdminUtils.createTopic(zkUtils, topic, numberOfPartitions,

replicationFactor, topicConfig)

}finally {

zkUtils.close()

} }

def offsetHandler() = {

val props = new Properties

props.putAll(standardProps)

props.setProperty("key.deserializer",

"org.apache.kafka.common.serialization.ByteArrayDeserializer") props.setProperty("value.deserializer",

"org.apache.kafka.common.serialization.ByteArrayDeserializer")

offsetClient = new KafkaConsumer[Array[Byte], Array[Byte]](props)

}

def getCommittedOffset(topicName: String, partition: Int): Long = {

init()

offsetHandler()

val committed = offsetClient.committed(new TopicPartition(topicName,

partition))

println(topicName , partition , committed.offset())

if (committed != null){

committed.offset

} else{

0L

} }

def setCommittedOffset(topicName: String, partition: Int, offset: Long) {

init()

offsetHandler()

var partitionAndOffset:util.Map[TopicPartition , OffsetAndMetadata] =

new util.HashMap[TopicPartition , OffsetAndMetadata]()

partitionAndOffset.put(new TopicPartition(topicName, partition), new

OffsetAndMetadata(offset))

offsetClient.commitSync(partitionAndOffset)

}

def close() {

offsetClient.close()

}

}

flink⼿手动维护kafka偏移量量的更多相关文章

- spark streaming中维护kafka偏移量到外部介质

spark streaming中维护kafka偏移量到外部介质 以kafka偏移量维护到redis为例. redis存储格式 使用的数据结构为string,其中key为topic:partition, ...

- SparkStreaming消费Kafka,手动维护Offset到Mysql

目录 说明 整体逻辑 offset建表语句 代码实现 说明 当前处理只实现手动维护offset到mysql,只能保证数据不丢失,可能会重复 要想实现精准一次性,还需要将数据提交和offset提交维护在 ...

- spark streaming读取kakfka数据手动维护offset

在spark streaming读取kafka的数据中,spark streaming提供了两个接口读取kafka中的数据,分别是KafkaUtils.createDstream,KafkaUtils ...

- Flink SQL结合Kafka、Elasticsearch、Kibana实时分析电商用户行为

body { margin: 0 auto; font: 13px / 1 Helvetica, Arial, sans-serif; color: rgba(68, 68, 68, 1); padd ...

- flink引出的kafka不同版本的兼容性

参考: 官网协议介绍:http://kafka.apache.org/protocol.html#The_Messages_Fetch kafka协议兼容性 http://www.cnblogs.c ...

- 构建一个flink程序,从kafka读取然后写入MYSQL

最近flink已经变得比较流行了,所以大家要了解flink并且使用flink.现在最流行的实时计算应该就是flink了,它具有了流计算和批处理功能.它可以处理有界数据和无界数据,也就是可以处理永远生产 ...

- kafka之五:如何手动更新Kafka中某个Topic的偏移量

本文介绍如何手动跟新zookeeper中的偏移量.我们在使用kafka的过程中,有时候需要通过修改偏移量来进行重新消费.我们都知道offsets是记录在zookeeper中的,所以我们想修改offse ...

- 使用Flink时从Kafka中读取Array[Byte]类型的Schema

使用Flink时,如果从Kafka中读取输入流,默认提供的是String类型的Schema: val myConsumer = new FlinkKafkaConsumer08[String](&qu ...

- An Overview of End-to-End Exactly-Once Processing in Apache Flink (with Apache Kafka, too!)

01 Mar 2018 Piotr Nowojski (@PiotrNowojski) & Mike Winters (@wints) This post is an adaptation o ...

随机推荐

- stm32F429启动时钟配置

STM32f429在启动时会在startup_stm32f429_439xx.s中调用static void SetSysClock(void)函数.默认使用的是25M晶振,把系统时钟设置为180M. ...

- Docker 添加容器SSH服务

很多时候我们需要登陆到容器内部操作,此时我们就需要开启容器的SSH支持了,下面的小例子将具体介绍三种分配IP地址的方法,分别是pipworl分配,commit分配,Docker分配等. 基于commi ...

- 使用iview 的表单组件验证 Upload 组件

使用iview 的表单组件验证 Upload 组件 结果: 点击提交按钮, 没有填的form 项, 提示错误, 当填入数据后提示验证成功 代码: <template> <div id ...

- MySQL中导出用户权限设置的脚本

在对MySQL数据库进行迁移的时候,有时候也需要迁移源数据库内的用户与权限.对于这个迁移我们可以从mysql.user表来获取用户的相关权限来生成相应的SQL语句,然后在目标服务器上来执行生成的SQL ...

- 标准C语言(1)

C语言程序的绝大部分内容应该记录在以.c作为扩展名的文件里,这种文件叫源文件,C语言里还包含以.h作为扩展名的文件,这种文件叫做头文件 C语言程序里可以直接使用数字和加减乘除四则运算符号(*代表乘法, ...

- FushionCharts

FushionCharts官网:http://www.fusioncharts.com/ 在线Demo:http://www.fusioncharts.com/free/demos/Blueprint ...

- CUDA升级后

打开工程文件.vcxproj,找到 <Import Project="$(VCTargetsPath)\BuildCustomizations\CUDA 10.0.props" ...

- 认识配置文件schema.xml(managed-schema)

1.schema文件是在SolrConfig中的架构工厂定义,有两种定义模式: 1.1.默认的托管模式: solr默认使用的就是托管模式.也就是当在solrconfig.xml文件中没有显式声明< ...

- Tableau 分群

对数据的特征进行分析,分群. 数据选用的是Iris data 下载地址:http://archive.ics.uci.edu/ml/machine-learning-databases/iris/ 1 ...

- solr 基础

solr高亮设置以及摘要 https://www.cnblogs.com/rainbowzc/p/3680343.html java操作solr基本方法 https://blog.csdn.net/z ...