论文解读(DWL)《Dynamic Weighted Learning for Unsupervised Domain Adaptation》

[ Wechat:Y466551 | 付费咨询,非诚勿扰 ]

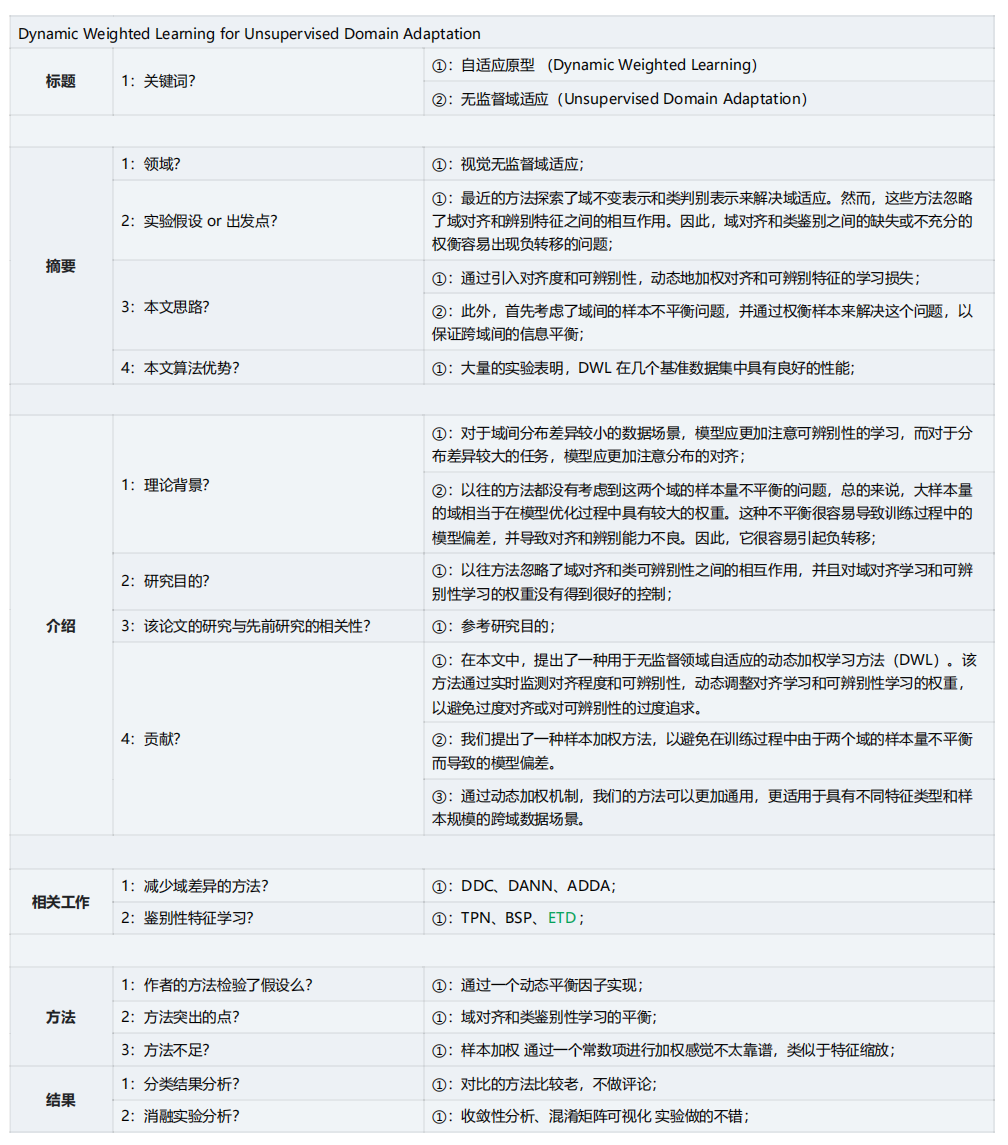

论文信息

论文标题:Dynamic Weighted Learning for Unsupervised Domain Adaptation

论文作者:Jihong Ouyang、Zhengjie Zhang、Qingyi Meng

论文来源:2023 aRxiv

论文地址:download

论文代码:download

视屏讲解:click

1 介绍

2 方法

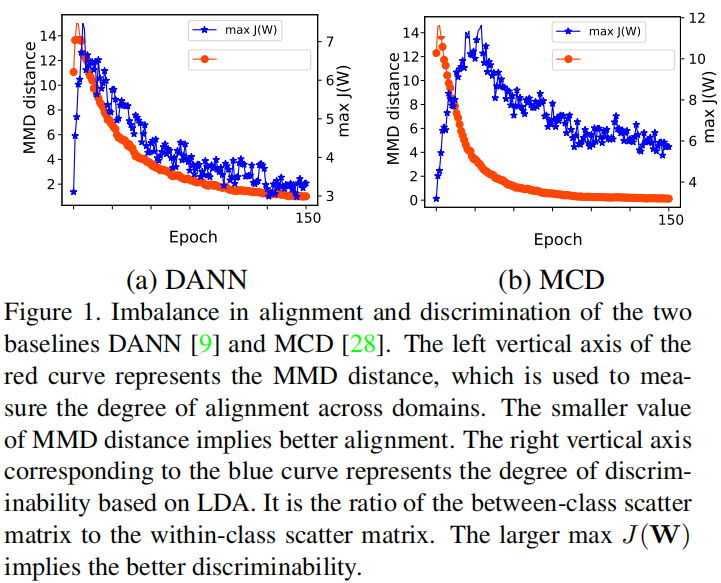

2.1 出发点

反应的问题:随着域对齐的实现,判别性在下降;

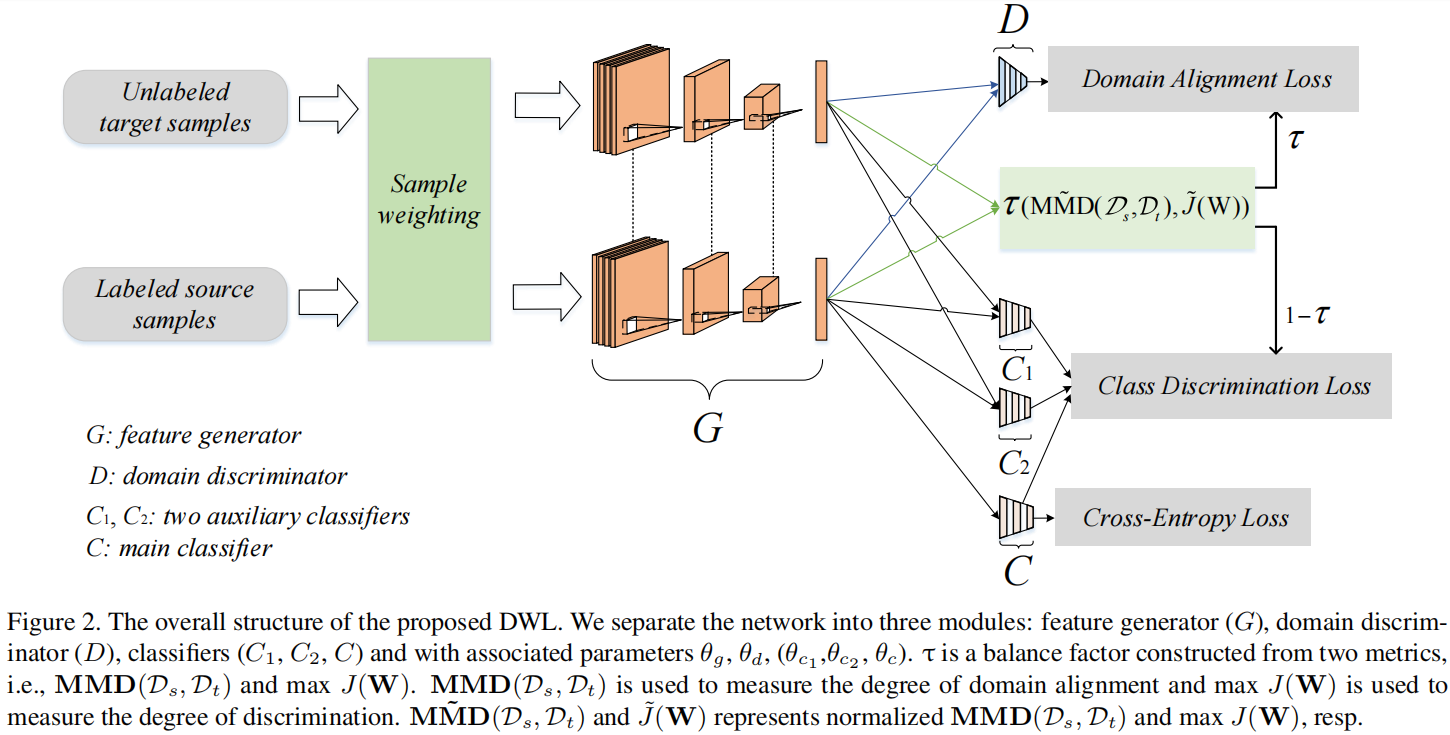

2.2 模型框架

2.3 Sample Weighting

$\begin{array}{l}\hat{x}_{i}^{s}=a\left(1+\frac{n_{t}}{n_{s}}\right) x_{i}^{s} \quad, \quad i=1,2, \ldots, n_{s} \\\hat{x}_{j}^{t}=a\left(1+\frac{n_{s}}{n_{t}}\right) x_{j}^{t} \quad, \quad j=1,2, \ldots, n_{t}\end{array} $

其中,$a \in(0,1]$ 是一个控制样本加权程度的超参数。

2.4 Domain Alignment Learning and Class Discrimination Learning

域对齐(对抗性学习):

$\begin{array}{r} \underset{\theta_{g}}{\text{min}} \; \underset{\theta_{d}}{\text{max}} \; \mathcal{L}_{d a}\left(\theta_{g}, \theta_{d}\right)=\mathbb{E}_{x_{i}^{s} \sim \mathcal{D}_{s}} \log \left[D\left(G\left(\hat{x}_{i}^{s}\right)\right)\right] +\mathbb{E}_{x_{j}^{t} \sim \mathcal{D}_{t}} \log \left[1-D\left(G\left(\hat{x}_{j}^{t}\right)\right)\right]\end{array}$

鉴别性特征学习:

$\begin{aligned} \underset{\theta_{g}, \theta_{c}}{\text{min}} \; \underset{\theta_{c_{1}}, \theta_{c_{2}}}{\text{max}} \; \mathcal{L}_{c d} & \left(\theta_{g}, \theta_{c}, \theta_{c_{1}}, \theta_{c_{1}}\right) \\= & \mathbb{E}_{x_{j}^{t} \sim \mathcal{D}_{t}}\left\|C_{1}\left(G\left(\hat{x}_{j}^{t}\right)\right)-C_{2}\left(G\left(\hat{x}_{j}^{t}\right)\right)\right\|_{1} \\& +\left\|C\left(G\left(\hat{x}_{j}^{t}\right)\right)-C_{1}\left(G\left(\hat{x}_{j}^{t}\right)\right)\right\|_{1} \\& +\left\|C\left(G\left(\hat{x}_{j}^{t}\right)\right)-C_{2}\left(G\left(\hat{x}_{j}^{t}\right)\right)\right\|_{1}\end{aligned}$

Note:$C$、$C_{1}$、$C_{2}$ 是使用源域数据预训练得到的分类器。首先,固定 $G$ 和 $C$ 最大化 $C_1$ 和 $C_2$ 的差异。然后,固定 $C_{1}$ 和 $C_{2}$ 训练 $G$ 和 $C$。

2.5 Dynamic Weighted Learning

域对齐度量 [ MMD ]:

$\operatorname{MMD}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)=\left\|\mathbb{E}_{x_{i}^{s} \sim \mathcal{D}_{s}} G\left(\hat{x}_{i}^{s}\right)-\mathbb{E}_{x_{j}^{t} \sim \mathcal{D}_{t}} G\left(\hat{x}_{j}^{t}\right)\right\|^{2}$

鉴别性度量 [ LDA ]:

$\underset{\mathbf{W}}{\text{max}} \; J(\mathbf{W})=\frac{\operatorname{tr}\left(\mathbf{W}^{\top} \mathbf{S}_{\mathbf{b}} \mathbf{W}\right)}{\operatorname{tr}\left(\mathbf{W}^{\top} \mathbf{S}_{\mathbf{w}} \mathbf{W}\right)}$

其中,$\mathbf{S}_{\mathrm{b}}$ 为类间散射矩阵,$\mathbf{S}_{\mathbf{w}}$ 为类内散射矩阵。

注意:$J(\mathbf{W})$ 越大,具有更好的辨别性。

由于上述两个评价标准不在一个数量级上,本文对其进行了归一化处理:

$\begin{array}{l}\operatorname{\text{M}} \tilde{\text{M}} \text{D}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)=\frac{\operatorname{MMD}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)-\operatorname{MMD}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)_{\min }}{\operatorname{MMD}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)_{\max }-\operatorname{MMD}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)_{\min }} \end{array}$

$\tilde{J}(\mathbf{W})=\frac{J(\mathbf{W})-J(\mathbf{W})_{\min }}{J(\mathbf{W})_{\max }-J(\mathbf{W})_{\min }}$

构造一个动态平衡因子:

$\tau=\frac{\operatorname{M} \tilde{\mathbf{M}}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)}{\operatorname{M} \tilde{\mathbf{M}}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)+(1-\tilde{J}(\mathbf{W}))}$

注意:$\text{M} \tilde{\text{M}} \text{D}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)$ 越小代表这域对齐效果越好,$1-\tilde{J}(\mathbf{W})$ 越小代表这鉴别性特征越好。

- 当域对齐的程度远优于类的可辨别性时,$\text{M} \tilde{\text{M}} \text{D}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)$ 接近 $0$,$1-\tilde{J}(\mathbf{W}) $ 接近 $1$ ,$\tau$ 接近 $0$ ;

- 当域对齐程度远低于类别识别程度时,$\text{M} \tilde{\text{M}} \text{D}\left(\mathcal{D}_{s}, \mathcal{D}_{t}\right)$ 接近 $1$,$1-\tilde{J}(\mathbf{W}) $ 接近 $0$ ,$\tau$ 接近 $1$ ;

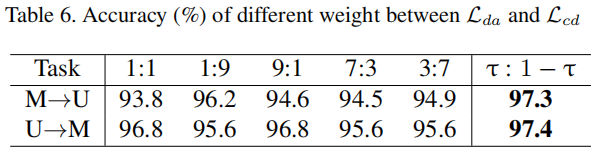

基于 $\tau$ 的良好特性,采用 $\tau$ 作为域对齐损失的权重,$1−\tau $ 作为类鉴别损失的权重。因此,得到的域对齐和类鉴别的动态加权模型如下:

$\begin{array}{l} \underset{\theta_{g}, \theta_{c}}{\text{min}} \;\; \underset{\theta_{\theta_{d}, \theta_{c_{1}}, \theta_{c_{2}}}}{\text{max}} \tau \cdot \mathcal{L}_{d a}\left(\theta_{g}, \theta_{d}\right)+ (1-\tau) \cdot \mathcal{L}_{c d}\left(\theta_{g}, \theta_{c}, \theta_{c_{1}}, \theta_{c_{2}}\right)\end{array}$

- 当领域对齐学习的有效性远远低于类辨别学习时,模型增加了域对齐学习的权重;

- 当鉴别学习的学习效果远低于域对齐学习时,模型增加鉴别学习的权重;

在这种动态加权学习机制下,可以保持域对齐学习与类辨别学习之间的一致性,从而避免过度的域对齐或类可辨别性。

2.6 Overall Training Objective

总体训练目标整合了样本加权、领域对齐学习、类判别学习和动态加权学习。此外,还需要最小化标记源样本的期望源误差。最终的极大极小目标:

$\begin{array}{l}\underset{\theta_{g}, \theta_{c}}{\text{min}} \;\;\underset{\theta_{d}, \theta_{c_{1}}, \theta_{c_{2}}}{\text{max}}\sum_{i=1}^{t_{s}} \mathcal{L}_{c e}\left(C\left(G\left(x_{i}^{s} ; \theta_{g}\right) ; \theta_{c}\right), y_{i}^{s}\right) +\tau \cdot \mathcal{L}_{d a}\left(\theta_{g}, \theta_{d}\right)+(1-\tau) \cdot \mathcal{L}_{c d}\left(\theta_{g}, \theta_{c}, \theta_{c_{1}}, \theta_{c_{2}}\right)\end{array}$

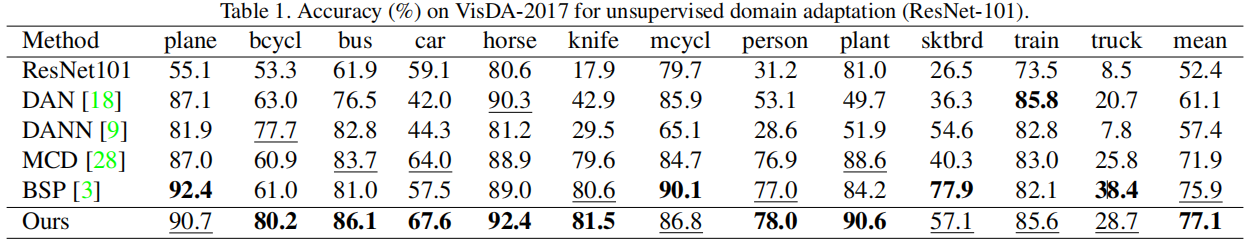

3 实验

分类结果

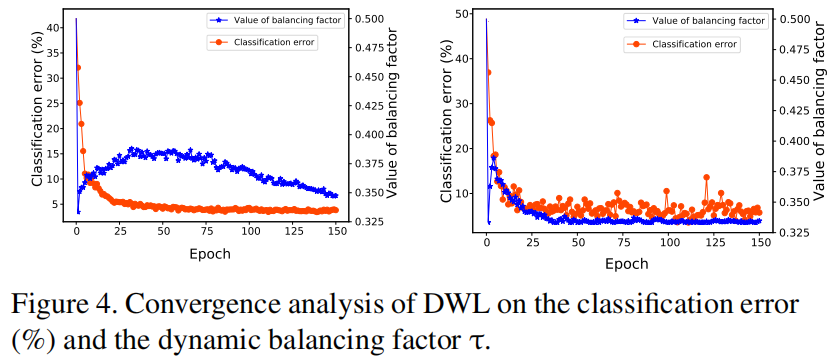

收敛性分析

对于每个子图,红色曲线的左轴表示分类误差,蓝色曲线的右轴表示平衡因子 $\tau$ 的值。可以发现,随着迭代,它们两者都逐渐收敛到一个平坦的值。这意味着随着 $\tau$ 的减少,使得类的可鉴别性被强调,使得分类误差也减小。

在迭代过程中,当 $\tau$ 的变化相对明显时,识别精度的提高也相对明显。我们将 $\tau$ 的初始值设为 $0.5$,可以发现 $\tau$ 在第一个时期急剧下降到 $0.5$ 以下,说明该模型的对齐性相对较好,但可辨别性相对较差。

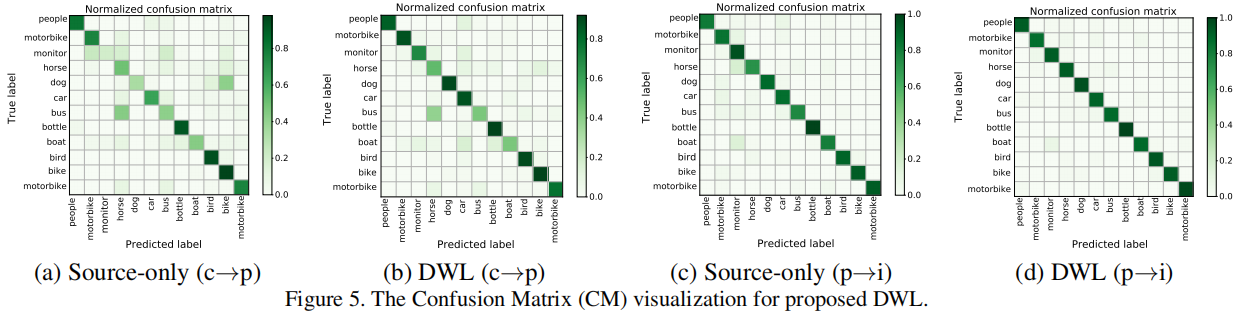

混淆矩阵可视化

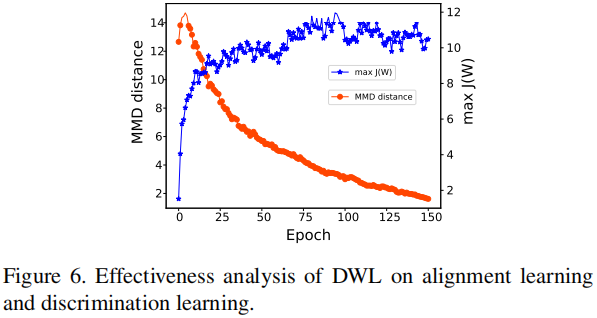

对齐度和可鉴别性度的分析

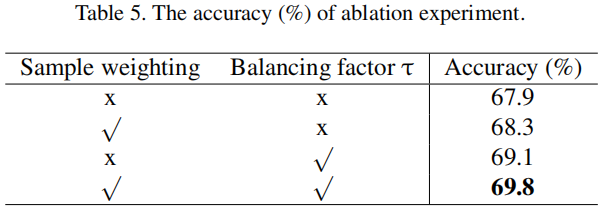

消融实验

论文解读(DWL)《Dynamic Weighted Learning for Unsupervised Domain Adaptation》的更多相关文章

- 论文解读(CDCL)《Cross-domain Contrastive Learning for Unsupervised Domain Adaptation》

论文信息 论文标题:Cross-domain Contrastive Learning for Unsupervised Domain Adaptation论文作者:Rui Wang, Zuxuan ...

- 迁移学习(DCCL)《Domain Confused Contrastive Learning for Unsupervised Domain Adaptation》

论文信息 论文标题:Domain Confused Contrastive Learning for Unsupervised Domain Adaptation论文作者:Quanyu Long, T ...

- 论文解读(CDTrans)《CDTrans: Cross-domain Transformer for Unsupervised Domain Adaptation》

论文信息 论文标题:CDTrans: Cross-domain Transformer for Unsupervised Domain Adaptation论文作者:Tongkun Xu, Weihu ...

- 论文解读(ToAlign)《ToAlign: Task-oriented Alignment for Unsupervised Domain Adaptation》

论文信息 论文标题:ToAlign: Task-oriented Alignment for Unsupervised Domain Adaptation论文作者:Guoqiang Wei, Cuil ...

- 迁移学习(CLDA)《CLDA: Contrastive Learning for Semi-Supervised Domain Adaptation》

论文信息 论文标题:CLDA: Contrastive Learning for Semi-Supervised Domain Adaptation论文作者:Ankit Singh论文来源:NeurI ...

- 论文解读(CAN)《Contrastive Adaptation Network for Unsupervised Domain Adaptation》

论文信息 论文标题:Contrastive Adaptation Network for Unsupervised Domain Adaptation论文作者:Guoliang Kang, Lu Ji ...

- 迁移学习《Asymmetric Tri-training for Unsupervised Domain Adaptation》

论文信息 论文标题:Asymmetric Tri-training for Unsupervised Domain Adaptation论文作者:Kuniaki Saito, Y. Ushiku, T ...

- 虚假新闻检测(CADM)《Unsupervised Domain Adaptation for COVID-19 Information Service with Contrastive Adversarial Domain Mixup》

论文信息 论文标题:Unsupervised Domain Adaptation for COVID-19 Information Service with Contrastive Adversari ...

- 迁移学习(IIMT)——《Improve Unsupervised Domain Adaptation with Mixup Training》

论文信息 论文标题:Improve Unsupervised Domain Adaptation with Mixup Training论文作者:Shen Yan, Huan Song, Nanxia ...

- 迁移学习(TSRP)《Improving Pseudo Labels With Intra-Class Similarity for Unsupervised Domain Adaptation》

论文信息 论文标题:Improving Pseudo Labels With Intra-Class Similarity for Unsupervised Domain Adaptation论文作者 ...

随机推荐

- 聚合短信PHP代码示例短信接口调用CURL方法

聚合的短信相信大家已经做多了吧,网上的代码看了下就是感觉太繁琐了,不过网上的也是比较好的,用的是post方法,更安全,因我们的项目是在服务器上请求,又绑定了白名单 ,所以弄了个简单点的自己用,参考如下 ...

- 2020-08-31:描述HTTP的版本之间的区别,主要是1.0/1.1/2.0三个版本的区别。

福哥答案2020-08-31: HTTP1.0与HTTP1.1的主要区别 1.长连接HTTP1.0:需要使用keep-alive参数来告知服务器端要建立一个长连接.HTTP1.1:默认支持长连接.2. ...

- 2021-12-24:划分字母区间。 字符串 S 由小写字母组成。我们要把这个字符串划分为尽可能多的片段,同一字母最多出现在一个片段中。返回一个表示每个字符串片段的长度的列表。 力扣763。某大厂面试

2021-12-24:划分字母区间. 字符串 S 由小写字母组成.我们要把这个字符串划分为尽可能多的片段,同一字母最多出现在一个片段中.返回一个表示每个字符串片段的长度的列表. 力扣763.某大厂面试 ...

- Django4全栈进阶之路2 创建虚拟环境、项目、app应用、启动运行项目

一.安装虚拟环境: 命令:pip3 install virtualenv 二.安装管理工具: 命令:pip3 install virtualenvwrapper 三.新建: 命令:python -m ...

- python学习之一 OS 文件夹的操作和文件操作

# OS模块 :查看一个文件夹下所有文件,这个文件夹有文件夹,不能用walk# -- coding: UTF-8 --import osimport sys#C:\Users\Administrato ...

- 如何开启Apache SkyWalking的自监控?

1. 开启Prometheus遥测数据 默认情况下, 遥测功能(telemetry)是关闭的(selector 为 none),像这样: telemetry: selector: ${SW_TELEM ...

- 驱动开发:内核PE结构VA与FOA转换

本章将继续探索内核中解析PE文件的相关内容,PE文件中FOA与VA,RVA之间的转换也是很重要的,所谓的FOA是文件中的地址,VA则是内存装入后的虚拟地址,RVA是内存基址与当前地址的相对偏移,本章还 ...

- 【技术积累】Python中的Pandas库【二】

如何在 Pandas 中进行文本的匹配和替换操作? 在 Pandas 中,使用 str 属性与正则表达式可以进行文本的匹配和替换操作.下面是一些常用的方法: str.contains():判断字符串中 ...

- 曲线艺术编程 coding curves 第十一章 玫瑰花形( ROSES)

第十一章 玫瑰花形 ROSES 原作:Keith Peters https://www.bit-101.com/blog/2022/11/coding-curves/ 译者:池中物王二狗(sheldo ...

- gitlab docker升级报错

背景 使用docker部署gitlab(9.5.4)后,发现合并代码有问题 日志: 看gitlab官网此问题已修复,由于上传了一批代码,又懒得重建,决定对gitlab升级 docker启动命令: do ...