李宏毅2022机器学习HW4 Speaker Identification上(Dataset &Self-Attention)

Homework4

Dataset介绍及处理

Dataset introduction

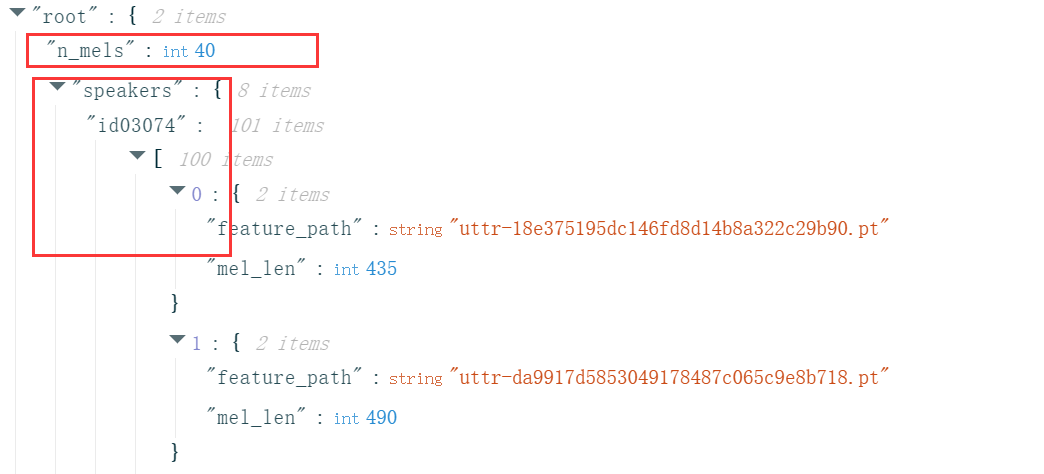

训练数据集metadata.json包括speakers和n_mels,前者表示每个speaker所包含的多条语音信息(每条信息有一个路径feature_path和改条信息的长度mel_len或理解为frame数即可),后者表示滤波器数量,简单理解为特征数即可,由此可知每个.pt语言文件可以表示为大小为mel_len \(\times\) n_mels的矩阵,其中所有文件已规定n_mels为40,不同的是语言信息的长度即mel_len。

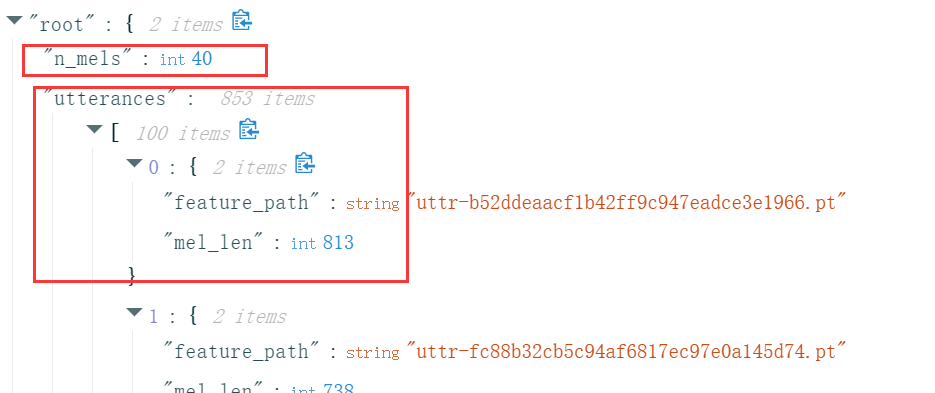

测试数据集testdata.json包括n_mels和utterances,其中n_mels和意义前面一样且固定为40,utterance表示一条语音信息,不同的是这里我们不知道这则信息是谁说出来的,任务就是检测这些信息分别是谁说的。

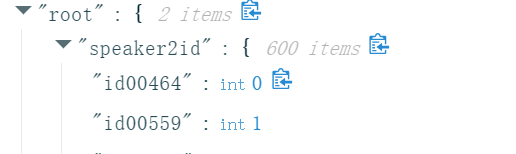

映射文件mapping.json包括两项speaker2id和id2speaker,前者将600个speaker的编号隐射为0-599,后者则是相反的操作。

Dataset procession

正如上面说,尽管“古圣先贤”已经帮我们做好了绝大多数的数据处理操作,但是如果想要批量训练数据那么就需要对每个语音序列的mel_len进行固定,比如在sample code里面固定为128个frame

class myDataset(Dataset):

def __init__(self, data_dir, segment_len=128):

它的具体实现方式如下

def __getitem__(self, index):

feat_path, speaker = self.data[index]

# Load preprocessed mel-spectrogram.

mel = torch.load(os.path.join(self.data_dir, feat_path))

# Segmemt mel-spectrogram into "segment_len" frames.

if len(mel) > self.segment_len:

# Randomly get the starting point of the segment.

start = random.randint(0, len(mel) - self.segment_len)

# Get a segment with "segment_len" frames.

mel = torch.FloatTensor(mel[start:start+self.segment_len])

else:

mel = torch.FloatTensor(mel)

# Turn the speaker id into long for computing loss later.

speaker = torch.FloatTensor([speaker]).long()

return mel, speaker

即从每个语音序列总的frame中抽取连续的128个frame,但是这并不能够保证所有的语音需要都为128个frame,可能某语音序列的frame数原本就小于128,因此还需要另外一道保险即padding。

def collate_batch(batch):

# Process features within a batch.

"""Collate a batch of data."""

mel, speaker = zip(*batch)

# Because we train the model batch by batch, we need to pad the features in the same batch to make their lengths the same.

mel = pad_sequence(mel, batch_first=True, padding_value=-20) # pad log 10^(-20) which is very small value.

# mel: (batch size, length, 40)

return mel, torch.FloatTensor(speaker).long()

def get_dataloader(data_dir, batch_size, n_workers):

"""Generate dataloader"""

dataset = myDataset(data_dir)

speaker_num = dataset.get_speaker_number()

# Split dataset into training dataset and validation dataset

trainlen = int(0.9 * len(dataset))

lengths = [trainlen, len(dataset) - trainlen]

trainset, validset = random_split(dataset, lengths)

train_loader = DataLoader(

trainset,

batch_size=batch_size,

shuffle=True,

drop_last=True,

num_workers=n_workers,

pin_memory=True,

collate_fn=collate_batch,

)

valid_loader = DataLoader(

validset,

batch_size=batch_size,

num_workers=n_workers,

drop_last=True,

pin_memory=True,

collate_fn=collate_batch,

)

return train_loader, valid_loader, speaker_num

在data_loader读取一个batch时,如果仍旧有不同大小的frame,那么就可以通过指定collate_fn=collate_batch对数据进行填充,确保每个batch的frame相同进而进行批量(并行?)计算。

当然你也可以不预先设置frame数为128,仅使用collate_batch,那么就会使这个batch内所有语音序列的frame数自动对齐到最长的frame,但往往会爆显存。

Self-Attention简单介绍

在不考虑Multi-Head Attention以及add &norm的情况下

\(X'=\)Self-Attention\((X, W^q, W^k, W^v, W^l)\) = \(\frac{XW^q(XW^k)^T}{\sqrt{d_k}}XW^vW^l\)

其中\(X, W^q, W^k, W^v, W^l\)维度分别为\(n\times d_{model}, d_{model}\times d_k, d_{model}\times d_k, d_{model}\times d_v, d_v\times d_{model}\),并称\(Q=X\times W^q, K = X\times W^k, V = X\times W^v\)

可知,变化后的\(X'\)与原来\(X\)的维度相同,这一变化过程简称为编码,那么问题来了\(X'\)与\(X\)究竟有何不同?

在变化过程中,我们对\(Q\)和\(K\)做了内积运算,这表示一个查询匹配过程,内积越大则相似度越高,那么匹配所得的权重也就越大(表明越关注这个讯息),之后再和\(V\)运算相当于通过前面的权重及原始\(V\)对新\(X\)的\(V\)做预测,视频给出了很生动的表述。

但是这里我有一疑问,为什么点积运算可以表示关注度?点积可以在一定程度表示两向量的关联性,这一点毫无疑问,但是凭什么关联性越高也意味着关注度(得分)越高呢?

李宏毅2022机器学习HW4 Speaker Identification上(Dataset &Self-Attention)的更多相关文章

- 李宏毅老师机器学习课程笔记_ML Lecture 3-1: Gradient Descent

引言: 这个系列的笔记是台大李宏毅老师机器学习的课程笔记 视频链接(bilibili):李宏毅机器学习(2017) 另外已经有有心的同学做了速记并更新在github上:李宏毅机器学习笔记(LeeML- ...

- 机器学习-Tensorflow之Tensor和Dataset学习

好了,咱们今天终于进入了现阶段机器学习领域内最流行的一个框架啦——TensorFlow.对的,这款由谷歌开发的机器学习框架非常的简单易用并且得到了几乎所有主流的认可,谷歌为了推广它的这个框架甚至单独开 ...

- 李宏毅老师机器学习课程笔记_ML Lecture 2: Where does the error come from?

引言: 最近开始学习"机器学习",早就听说祖国宝岛的李宏毅老师的大名,一直没有时间看他的系列课程.今天听了一课,感觉非常棒,通俗易懂,而又能够抓住重点,中间还能加上一些很有趣的例子 ...

- 李宏毅老师机器学习课程笔记_ML Lecture 1: ML Lecture 1: Regression - Demo

引言: 最近开始学习"机器学习",早就听说祖国宝岛的李宏毅老师的大名,一直没有时间看他的系列课程.今天听了一课,感觉非常棒,通俗易懂,而又能够抓住重点,中间还能加上一些很有趣的例子 ...

- 李宏毅老师机器学习课程笔记_ML Lecture 1: 回归案例研究

引言: 最近开始学习"机器学习",早就听说祖国宝岛的李宏毅老师的大名,一直没有时间看他的系列课程.今天听了一课,感觉非常棒,通俗易懂,而又能够抓住重点,中间还能加上一些很有趣的例子 ...

- 李宏毅老师机器学习课程笔记_ML Lecture 0-2: Why we need to learn machine learning?

引言: 最近开始学习"机器学习",早就听说祖国宝岛的李宏毅老师的大名,一直没有时间看他的系列课程.今天听了一课,感觉非常棒,通俗易懂,而又能够抓住重点,中间还能加上一些很有趣的例子 ...

- 李宏毅老师机器学习课程笔记_ML Lecture 0-1: Introduction of Machine Learning

引言: 最近开始学习"机器学习",早就听说祖国宝岛的李宏毅老师的大名,一直没有时间看他的系列课程.今天听了一课,感觉非常棒,通俗易懂,而又能够抓住重点,中间还能加上一些很有趣的例子 ...

- Python 机器学习实战 —— 监督学习(上)

前言 近年来AI人工智能成为社会发展趋势,在IT行业引起一波热潮,有关机器学习.深度学习.神经网络等文章多不胜数.从智能家居.自动驾驶.无人机.智能机器人到人造卫星.安防军备,无论是国家级军事设备还是 ...

- z/OS上Dataset 的移动

最近的一个需求,需要把大批量的Dataset移到新的Storage Class,新的Volume中去,刚开始感觉非常头疼.仔细研究后发现这个事情其实很简单.确实符合别人所说,事情的在你真正开始努力之后 ...

- 机器学习之神经网络模型-上(Neural Networks: Representation)

在这篇文章中,我们一起来讨论一种叫作"神经网络"(Neural Network)的机器学习算法,这也是我硕士阶段的研究方向.我们将首先讨论神经网络的表层结构,在之后再具体讨论神经网 ...

随机推荐

- 2024年最新的Python操控微信教程

自从微信禁止网页版登陆之后,itchat 库实现的功能也就都不能用了,那现在 Python 还能操作微信吗?答案是:可以! 在Github上有一个项目叫<WeChatPYAPI>可以使用 ...

- ts函数讲解与不确定参数是否使用以及限制返回类型

1.声明式函数 函数有两个参数 参数的数据类型是 string number 返回值值 number 哈 function person(name: string, age: number): num ...

- 【K哥爬虫普法】大数据风控第一案:从魔蝎科技案件判决,看爬虫技术刑事边界

我国目前并未出台专门针对网络爬虫技术的法律规范,但在司法实践中,相关判决已屡见不鲜,K 哥特设了"K哥爬虫普法"专栏,本栏目通过对真实案例的分析,旨在提高广大爬虫工程师的法律意识, ...

- jenkins 安装与构建过程中的系列问题

一.插件安装遇到的依赖问题 插件安装分为在线安装和离线安装 1.在线安装 搜索要安装的插件,然后进行安装即可 2.离线安装hpi文件 使用该方法安装插件每次只能安装一个插件,且如果插件之间存在依赖性则 ...

- Go 泛型之明确使用时机与泛型实现原理

目录 一.引入 二.何时适合使用泛型? 场景一:编写通用数据结构时 场景二:函数操作的是 Go 原生的容器类型时 场景三:不同类型实现一些方法的逻辑相同时 三.Go 泛型实现原理 Stenciling ...

- ansible使用,搭建mongo的replica-set小结

ansible 前言 常用到的指令 查看ip是否可用 执行 执行,查看日志输出 查看这个 playbook 的执行会影响到哪些 hosts 设置服务器免密登录 ansible了解 变量名的使用 pla ...

- 人工智能大语言模型微调技术:SFT 监督微调、LoRA 微调方法、P-tuning v2 微调方法、Freeze 监督微调方法

人工智能大语言模型微调技术:SFT 监督微调.LoRA 微调方法.P-tuning v2 微调方法.Freeze 监督微调方法 1.SFT 监督微调 1.1 SFT 监督微调基本概念 SFT(Supe ...

- 神经网络优化篇:将 Batch Norm 拟合进神经网络(Fitting Batch Norm into a neural network)

将 Batch Norm 拟合进神经网络 假设有一个这样的神经网络,之前说过,可以认为每个单元负责计算两件事.第一,它先计算z,然后应用其到激活函数中再计算a,所以可以认为,每个圆圈代表着两步的计算过 ...

- Git企业开发控制理论和实操-从入门到深入(四)|Git的远程操作|Gitee

前言 那么这里博主先安利一些干货满满的专栏了! 首先是博主的高质量博客的汇总,这个专栏里面的博客,都是博主最最用心写的一部分,干货满满,希望对大家有帮助. 高质量博客汇总 然后就是博主最近最花时间的一 ...

- .NET 云原生架构师训练营(模块二 基础巩固 引入)--学习笔记

2.1 引入 http协议 web server && web application framework .net 与 .net core asp .net core web api ...