爬虫技术(四)-- 简单爬虫抓取示例(附c#代码)

这是我的第一个爬虫代码。。。算是一份测试版的代码。大牛大神别喷。。。

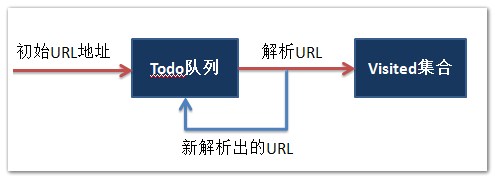

通过给定一个初始的地址startPiont然后对网页进行捕捉,然后通过正则表达式对网址进行匹配。

List<string> todo :进行抓取的网址的集合

List<string> visited :已经访问过的网址的集合

下面实现的是,给定一个初始地址,然后进行爬虫,输出正在访问的网址和已经访问的网页的个数。

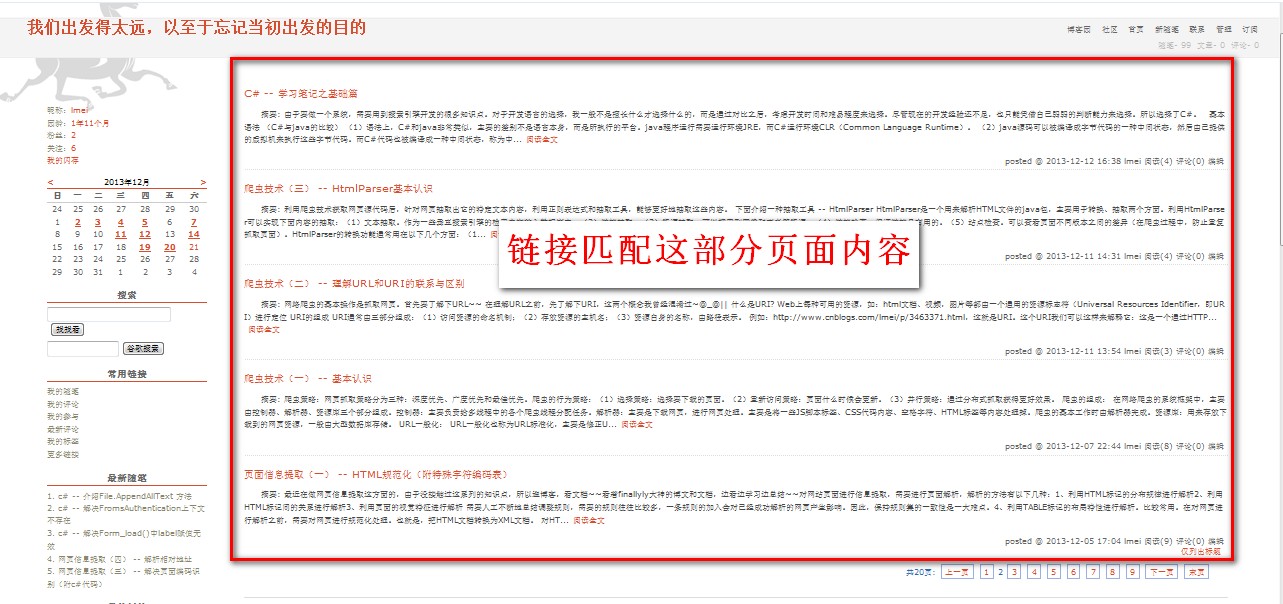

需要注意的是,下面代码实现的链接匹配页面的内容如图一、图二所示:

- 图一:

- 图二:

简单代码示范如下:(测试版)

using System;

using System.Collections.Generic;

using System.ComponentModel;

using System.Data;

using System.Drawing;

using System.Linq;

using System.Text;

using System.Windows.Forms;

using System.Web.Security;

using System.IO;

using System.Net;

using System.Text.RegularExpressions;

using System.Web; namespace Demo1

{ public partial class Form1 : Form

{

public Form1()

{

InitializeComponent();

} private void button1_Click(object sender, EventArgs e)

{

Test1 a = new Test1();

a.getCurrentURL();

} public class Test1

{

List<string> todo = new List<string>();

List<string> visited = new List<string>();

string startPoint = "http://www.cnblogs.com/lmei/";

public void getCurrentURL()

{

RequestSite(startPoint); while (todo.Count > 0)

{

string currentURL = todo[0]; RequestSite(currentURL); if (visited.Contains(currentURL)) //注释1

{

Console.WriteLine("已经访问过了" + currentURL);

todo.Remove((currentURL));

}

else

{

Console.WriteLine("现在正在访问:===> " + currentURL);

visited.Add(currentURL); Console.WriteLine("目前已经访问了:===> " + visited.Count + "个网页" );

todo.Remove((currentURL));

}

}

} public void RequestSite(string url)

{

WebRequest req = WebRequest.Create(url);

HttpWebResponse res;

try{

res = (HttpWebResponse)(req.GetResponse());

}

catch (WebException ex) { res = (HttpWebResponse)ex.Response; } Stream st = res.GetResponseStream();

StreamReader rdr = new StreamReader(st);

string s = rdr.ReadToEnd();

todo.AddRange(GetLink(s));

} List<string> GetLink(string htmlPage)

{ Regex regx =

new Regex("http://www\\.cnblogs\\.com\\/lmei\\/p\\/[0-9a-zA-Z]+\\.html*" ,RegexOptions.IgnoreCase);

MatchCollection matches = regx.Matches(htmlPage); List<string> results = new List<string>();

foreach (Match match in matches)

{

if (!visited.Contains(match.Value)) //注释2

{

results.Add(match.Value);

}

}

return results;

}

} }

}

注释1 :是将已经访问过的网址排除。

注释2 :是将已经访问过的网址排除,但是可能由于同个网页中包含的两个(或两个以上)相同的链接,而且都没被访问过的,这样使得todo队列中会有相同的网址,所以需要注释1那部分进行再次过滤排除。其实也可以将注释2那部分删去,直接让注释1过滤就行。

接下来会进一步补充爬虫抓取的内容。。。

爬虫技术(四)-- 简单爬虫抓取示例(附c#代码)的更多相关文章

- 【Python3 爬虫】01_简单页面抓取

运行平台:Winodows 10 Python版本:Python 3.4.2 IDE:Sublime text3 网络爬虫 网络爬虫,也叫网络蜘蛛(Web Spider),如果把互联网比喻成一个蜘蛛网 ...

- python爬虫构建代理ip池抓取数据库的示例代码

爬虫的小伙伴,肯定经常遇到ip被封的情况,而现在网络上的代理ip免费的已经很难找了,那么现在就用python的requests库从爬取代理ip,创建一个ip代理池,以备使用. 本代码包括ip的爬取,检 ...

- iOS—网络实用技术OC篇&网络爬虫-使用java语言抓取网络数据

网络爬虫-使用java语言抓取网络数据 前提:熟悉java语法(能看懂就行) 准备阶段:从网页中获取html代码 实战阶段:将对应的html代码使用java语言解析出来,最后保存到plist文件 上一 ...

- iOS开发——网络实用技术OC篇&网络爬虫-使用java语言抓取网络数据

网络爬虫-使用java语言抓取网络数据 前提:熟悉java语法(能看懂就行) 准备阶段:从网页中获取html代码 实战阶段:将对应的html代码使用java语言解析出来,最后保存到plist文件 上一 ...

- 爬虫学习一系列:urllib2抓取网页内容

爬虫学习一系列:urllib2抓取网页内容 所谓网页抓取,就是把URL地址中指定的网络资源从网络中读取出来,保存到本地.我们平时在浏览器中通过网址浏览网页,只不过我们看到的是解析过的页面效果,而通过程 ...

- python爬虫之分析Ajax请求抓取抓取今日头条街拍美图(七)

python爬虫之分析Ajax请求抓取抓取今日头条街拍美图 一.分析网站 1.进入浏览器,搜索今日头条,在搜索栏搜索街拍,然后选择图集这一栏. 2.按F12打开开发者工具,刷新网页,这时网页回弹到综合 ...

- Python网络爬虫(Get、Post抓取方式)

简单的抓取网页 import urllib.request url="http://google.cn/" response=urllib.request.urlopen(url) ...

- arpspoof+driftnet+ ARP欺骗简单图片抓取

arpspoof+driftnet+ ARP欺骗简单图片抓取 driftnet是一款简单而使用的图片捕获工具,可以很方便的在网络数据包中抓取图片.该工具可以实时和离线捕获指定数据包中是图片 环境 受害 ...

- [python应用]python简单图片抓取

前言 emmmm python简单图片抓取 1 import requests 2 import threading 3 import queue 4 from subprocess import P ...

- 抓取oschina上面的代码分享python块区下的 标题和对应URL

# -*- coding=utf-8 -*- import requests,re from lxml import etree import sys reload(sys) sys.setdefau ...

随机推荐

- .NET设计模式(11):组合模式(Composite Pattern)(转)

概述 组合模式有时候又叫做部分-整体模式,它使我们树型结构的问题中,模糊了简单元素和复杂元素的概念,客户程序可以向处理简单元素一样来处理复杂元素,从而使得客户程序与复杂元素的内部结构解耦. 意图 将对 ...

- 微信电脑版也能用公众号自定义菜单 微信1.2 for Windows发布

昨日,微信电脑版发布更新,版本为微信1.2 for Windows,最大的特色就是加入了保存聊天记录功能,可以使用公账号菜单,手机上收藏的表情也能在电脑版上发送,可以接收转账消息. 本次微信pc版更新 ...

- 使用Assetbundle时可能遇到的坑

原地址:http://www.cnblogs.com/realtimepixels/p/3652128.html 一 24 十一郎未分类 No Comments 转自 http://www.unity ...

- XHProf的安装和使用(PHP性能测试神器)

XHProf是Facebook开发的性能调试工具,帮助我们的PHP程序性能调优,更加健壮.XHProf安装和使用方法将在本章讲解.XHProf是PHP的PECL扩展.没有XDeBug那些耗费资源,更加 ...

- Javascript学习笔记1 数论

1.Javascript不用担心内存的回收与对象的销毁! 2.Javascript有:±infinity.NaN全局变量表示 被0整除的±无穷 和 非数字.undefined和null表示 未定义 和 ...

- Heroku 与 ASP.NET 5

一. Heroku 简单来讲,Heroku是一个支持多种语言.极易部署.多价位可免费的 Pass 平台,通过 Buildpack 搭建语言运行环境, 默认内建的大部分是 Web 开发中较为常见的语言, ...

- js正则表达式用法大全

匹配中文字符的正则表达式: [u4e00-u9fa5] 评注:匹配中文还真是个头疼的事,有了这个表达式就好办了 匹配双字节字符(包括汉字在内):[^x00-xff] 评注:可以用来计算字符串的长度(一 ...

- 使用var声明的变量 和 直接赋值并未声明的变量的区别

在看JS高级程序设计时忽然想到这个问题,众所周知,直接赋值一个变量而为声明,会产生一个全局变量(或者说是全局对象的属性),但用var声明的变量 和 直接赋值而并未声明的变量 都有哪些区别呢,这是我在百 ...

- python unittest基本介绍

python内部自带了一个单元测试的模块,pyUnit也就是我们说的:unittest 1.介绍下unittest的基本使用方法: 1)import unittest 2)定义一个继承自unittes ...

- 连接池和 "Timeout expired"异常【转】

异常信息: MySql.Data.MySqlClient.MySqlException (0x80004005): error connecting: Timeout expired. The tim ...