spider 爬虫文件基本参数(3)

一 代码

# -*- coding: utf-8 -*-

import scrapy class ZhihuSpider(scrapy.Spider):

# 爬虫名字,名字唯一,允许自定义

name = 'zhihu'

# 允许爬取的域名,scrapy每次发起的url爬取数据,先回进行域名检测,检测通过就爬取

allowed_domains = ['zhihu.com']

#发起的起始url地址,scrapy项目启动自动调用start_request()方法,把start_urls

# url的作为请求url发起请求,把获取到的response交给回调函数,回调函数传递给parse

# 解析数据

start_urls = ['http://zhihu.com/'] custom_settings = {

# 请求头

'user-agent': None,

# 请求来源

# 'referer': 'https://www.zhihu.com/',

} def start_requests(self):

'重写start_requests方法'

for url in self.start_urls:

#自定义解析方法

yield scrapy.Request(url=url,method='Get',callback=self.define_parse) def parse(self, response):

pass def define_parse(self,response):

print(response)

#输出状态码

self.logger.info(response.status)

二 参数详解

custom_settings

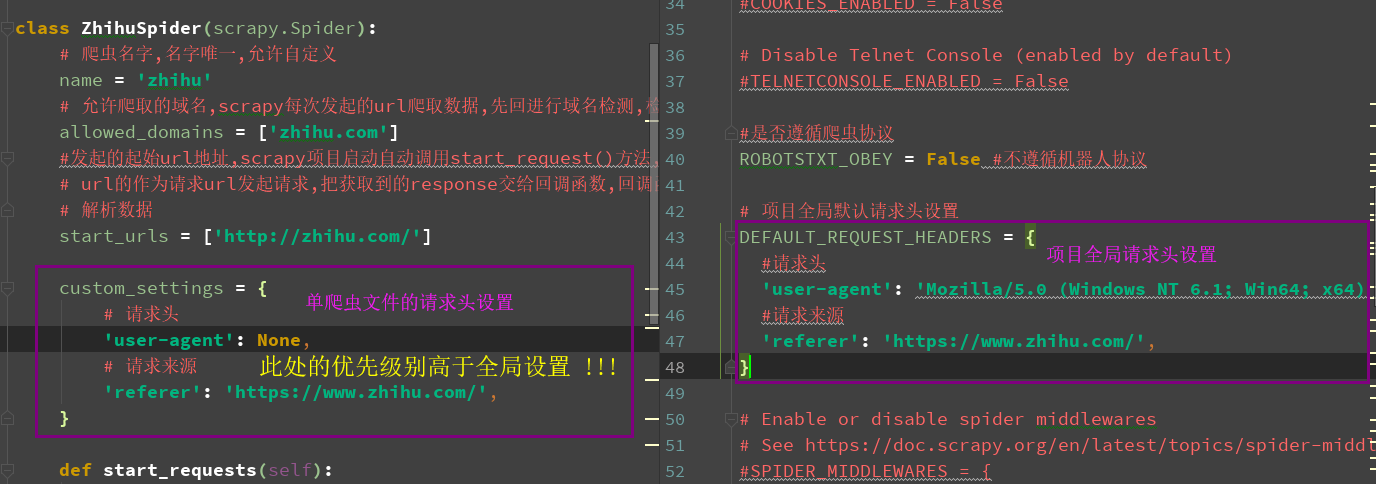

- 1 settings 文件中默认请求头 DEFAULT_REQUEST_HEADERS

- 2 spider文件中请求头参数 custom_settings

- 必须以类变量形式存在

- 优先级别高与全局

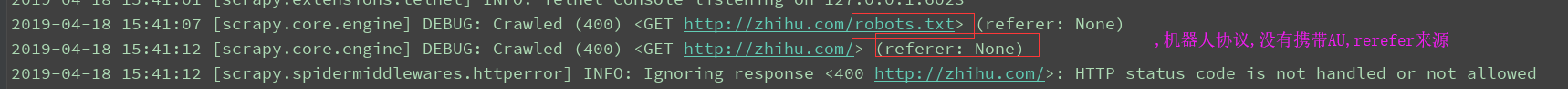

访问知乎不携带请求参数,返回400

两种请求头的书写方式如下(左:spisder, 右:settings.py)

allowed_domains

允许爬取的域名,scrapy每次发起的url爬取数据,先回进行域名检测,检测通过就爬取

start_urls

发起的起始url地址,scrapy项目启动自动调用start_request()方法,把start_urlsurl的作为请求url发起请求,把获取到的response交给回调函数,回调函数传递给parse解析数据

settings

全局的配置文件

logger

日志信息,使用=python自带的log模块

start_requests()

class MySpider(scrapy.Spider):

name = 'myspider' def start_requests(self):

#使用FormRequest提交数据

return [scrapy.FormRequest("http://www.example.com/login",

formdata={'user': 'john', 'pass': 'secret'},

callback=self.logged_in)] def logged_in(self, response):

pass

post 请求

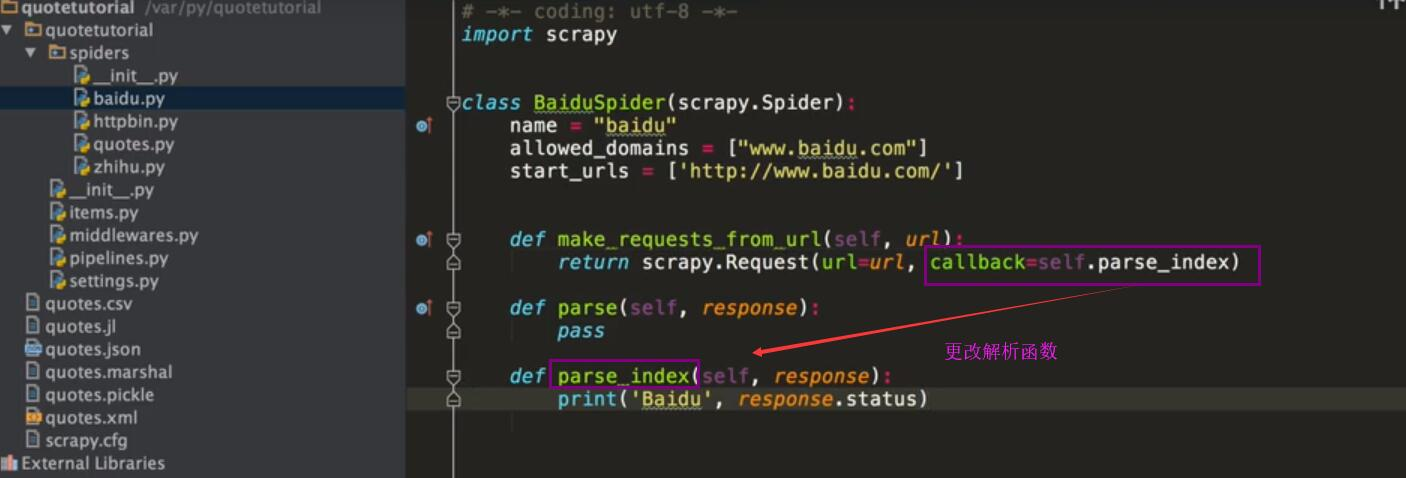

parse(response)

参数:response(Response) - 对解析的响应

指定解析函数,可以扩展多个函数,多层次的解析方法.

spider 启动参数配置

import scrapy class MySpider(scrapy.Spider):

name = 'myspider' def __init__(self, category=None, *args, **kwargs):

super(MySpider, self).__init__(*args, **kwargs)

self.start_urls = ['http://www.example.com/categories/%s' % category]

命令行中调用

scrapy crawl myspider -a category=electronics

spider 爬虫文件基本参数(3)的更多相关文章

- Scrapy 框架,爬虫文件相关

Spiders 介绍 由一系列定义了一个网址或一组网址类如何被爬取的类组成 具体包括如何执行爬取任务并且如何从页面中提取结构化的数据. 简单来说就是帮助你爬取数据的地方 内部行为 #1.生成初始的Re ...

- 第三百四十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器

第三百四十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器 编写spiders爬虫文件循环 ...

- 二十 Python分布式爬虫打造搜索引擎Scrapy精讲—编写spiders爬虫文件循环抓取内容—meta属性返回指定值给回调函数—Scrapy内置图片下载器

编写spiders爬虫文件循环抓取内容 Request()方法,将指定的url地址添加到下载器下载页面,两个必须参数, 参数: url='url' callback=页面处理函数 使用时需要yield ...

- 第三百四十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—craw母版l创建自动爬虫文件—以及 scrapy item loader机制

第三百四十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—craw母版l创建自动爬虫文件—以及 scrapy item loader机制 用命令创建自动爬虫文件 创建爬虫文件是根据scrap ...

- 二十三 Python分布式爬虫打造搜索引擎Scrapy精讲—craw母版l创建自动爬虫文件—以及 scrapy item loader机制

用命令创建自动爬虫文件 创建爬虫文件是根据scrapy的母版来创建爬虫文件的 scrapy genspider -l 查看scrapy创建爬虫文件可用的母版 Available templates: ...

- SWFUpload多图上传、C#后端跨域传文件带参数

前几天工作中用到了SWFUpload上传图片,涉及到跨域,因为前端无法实现跨域,所以只能把文件传到后端进行跨域请求,整理分享下. 效果图 前端 html部分 <!DOCTYPE html> ...

- C# 如何执行bat文件 传参数

C# 如何执行bat文件 传参数 分类: C# basic 2011-04-25 18:55 3972人阅读 评论(0) 收藏 举报 c#stringpathoutput Process p = ne ...

- Django之用户上传文件的参数配置

Django之用户上传文件的参数配置 models.py文件 class Xxoo(models.Model): title = models.CharField(max_length=128) # ...

- 由于想要实现下载的文件可以进行选择,而不是通过<a>标签写死下载文件的参数,所以一直想要使用JFinal结合ajax实现文件下载,但是ajax实现的文件下载并不能触发浏览器的下载文件弹出框,这里通过模拟表单提交实现同样的效果。

由于想要实现下载的文件可以进行选择,而不是通过<a>标签写死下载文件的参数,所以一直想要使用JFinal结合ajax实现文件下载(这样的话ajax可以传递不同的参数),但是ajax实现的文 ...

随机推荐

- js术语扫盲贴:XHR、RegExp、call-apply、prototype

(1) XHR:xml httprequestXHR注入:XHR 注入技术是通过XMLHttpRest来获取javascript的.但与eval不同的是,该机制是通过创建一个script的DOM元素, ...

- 关于ArrayList的5道面试题

我以面试官的身份参加过很多Java的面试,以下是五个比较有技巧的问题,我发现有些初级到中级的Java研发人员在这些问题上没有完全弄明白,似懂非懂.所以我写了一篇相关的文章,帮助初级Java研发人员弄清 ...

- Sublime 3基于python环境的使用

.Ctrl+Shift+R 自动调整格式 打开Sublime Text 新建一个Python的编译系统 { "cmd": ["C:\\python\\python.exe ...

- nginx配置SSL实现服务器/客户端双向认证

http://blog.csdn.net/kunoy/article/details/8239653 本人不才,配置了两天,终于搞出来了,结合网上诸多博文,特此总结一下! 配置环境: Ubuntu 1 ...

- JavaScript Array+String对象的常用方法

Array 对象 Array 对象用于在单个的变量中存储多个值. 创建 Array 对象的语法: new Array(); new Array(size); new Array(element0, e ...

- C/C++中结构体struct 的使用

结构(struct) 结构是由基本数据类型构成的.并用一个标识符来命名的各种变量的组合. 结构中可以使用不同的数据类型. 1. 结构说明和结构变量定义 在Turbo C ...

- HTML5 CSS3专题 纯CSS打造相册效果

转载请标明出处:http://blog.csdn.net/lmj623565791/article/details/30993277 今天偶然发现电脑里面还有这样的一个例子,感觉效果还不错,不记得啥时 ...

- Python定时任务

在项目中,我们可能遇到有定时任务的需求.其一:定时执行任务.例如每天早上 8 点定时推送早报.其二:每隔一个时间段就执行任务.比如:每隔一个小时提醒自己起来走动走动,避免长时间坐着.今天,我跟大家分享 ...

- Python 字典(Dictionary) has_key()方法

描述 Python 字典(Dictionary) has_key() 函数用于判断键是否存在于字典中,如果键在字典dict里返回true,否则返回false. 语法 has_key()方法语法:dic ...

- Oracle的nvl

在Oracle中nvl(字段名,value)函数用于对没有值的字段做处理在MySql中ifnull(字段名,value)是一样的功能