saltstack实现自动化扩容

[root@node1 src]# tar xf etcd-v3.2.9-linux-amd64.tar.gz

cd etcd-v3.2.9-linux-amd64

cp etcd etcdctl /usr/local/bin/

然后开启etcd集群:

1、首先创建数据目录:mkdir /data/etcd -p

2、开启服务:

nohup etcd --name auto_scale --data-dir /data/etcd/ --listen-peer-urls http://192.168.44.134:2380,http://192.168.44.134:7001 --listen-client-urls http://192.168.44.134:2379,http://192.168.44.134:4001 --advertise-client-urls http://192.168.44.134:2379,http://192.168.44.134:4001 &

[root@node1 ~]# netstat -tunlp|grep etcd

tcp 0 0 192.168.44.134:2379 0.0.0.0:* LISTEN 52094/etcd

tcp 0 0 192.168.44.134:2380 0.0.0.0:* LISTEN 52094/etcd

tcp 0 0 192.168.44.134:7001 0.0.0.0:* LISTEN 52094/etcd

tcp 0 0 192.168.44.134:4001 0.0.0.0:* LISTEN 52094/etcd

1、创建一个key/value

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/key1 -XPUT -d value="Hello world"

2、获取创建的key/value

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www1

3、删除创建的key/value

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/key1 -XDELETE

或者将上面的输出结果以json格式输出:

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www1|python -m json.tool

{

"action": "get",

"node": {

"createdIndex": 9,

"key": "/salt/haproxy/backend_www/www1",

"modifiedIndex": 9,

"value": "192.168.44.134:8080"

}

}

将etcd配置在saltstack中,结合使用:

1、首先需要安装依赖包:

####config etcd

my_etcd_config:

etcd.host: 192.168.44.134

etcd.port: 4001 ext_pillar:

- etcd: my_etcd_config root=/salt/haproxy

3、重启master

[root@node1 ~]# /etc/init.d/salt-master restart

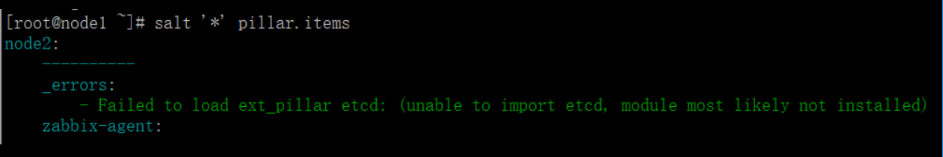

结尾一直报错:

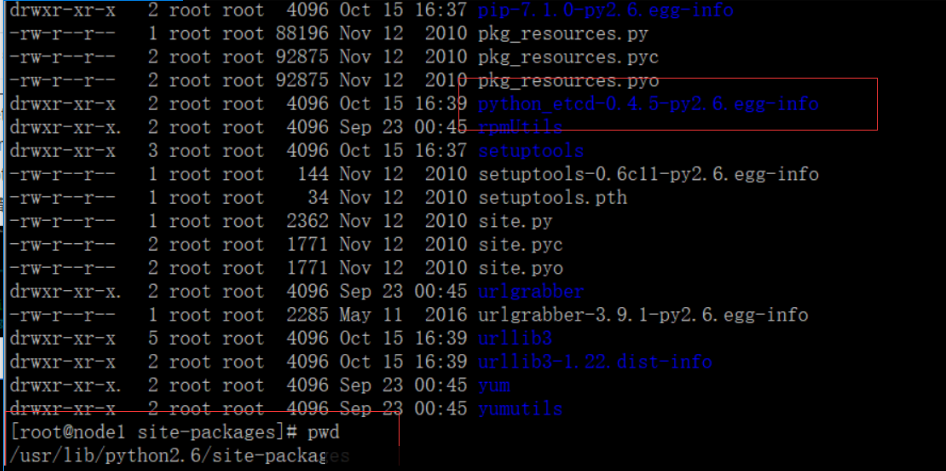

查找原因发现salt是python2.7安装的,而etcd是python2.6安装的,所以一直调用出错:

于是使用python2.7安装一遍etcd服务:

1、mv /usr/bin/python /usr/bin/python.bak

2、ln -s /usr/bin/python2.7 /usr/bin/python

3、修改/usr/bin/yum第一行为:#!/usr/bin/python2.6

4、wget https://pypi.python.org/packages/2.7/s/setuptools/setuptools-0.6c11-py2.7.egg --no-check-certificate

5、chmod +x setuptools-0.6c11-py2.7.egg

6、sh setuptools-0.6c11-py2.7.egg

7、wget https://pypi.python.org/packages/source/p/pip/pip-1.3.1.tar.gz --no-check-certificate

8、tar xf pip-1.3.1.tar.gz

9、cd pip-1.3.1

10、python setup.py install

11、/usr/bin/pip-2.7 install python-etcd

试着使用python2.7导入模块etcd,报错如下:

解决办法:

https://pypi.python.org/pypi/backports.ssl_match_hostname

tar xf backports.ssl_match_hostname-3.5.0.1.tar.gz

cd backports.ssl_match_hostname-3.5.0.1

python setup.py build

python setup.py install

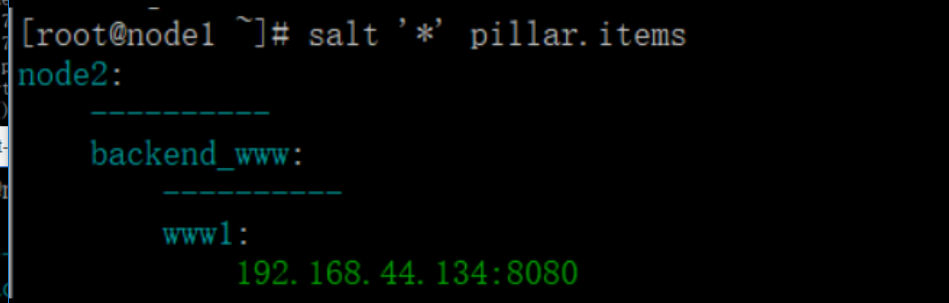

然后重启salt-master服务,查看设置的pillar:

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www1 -XDELETE

{"action":"delete","node":{"key":"/salt/haproxy/backend_www/www1","modifiedIndex":12,"createdIndex":11},"prevNode":{"key":"/salt/haproxy/backend_www/www1","value":"192.168.44.134:8080","modifiedIndex":11,"createdIndex":11}}

[root@node1 ~]# salt '*' pillar.items

node2:

----------

backend_www:

----------

zabbix-agent:

----------

Zabbix_Server:

192.168.44.134

zabbix-agent-host:

----------

zabbix_host:

node2

现在通过添加etcd的key来增加haproxy后端的节点服务器:

curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www1 -XPUT -d value="192.168.44.134:8081"|python -m json.tool

2、查看pillar

[root@node1 ~]# salt '*' pillar.items

node1:

----------

backend_www:

----------

www1:

192.168.44.134:8081

3、修改haproxy配置文件:vim /srv/salt/prod/cluster/files/haproxy-outside.cfg

{% for www,www_ip in pillar.backend_www.iteritems() %}

server {{ www }} {{ www_ip }} check inter 1000

{% endfor %}

4、修改haproxy状态配置文件:vim /srv/salt/prod/cluster/haproxy-outside.sls

haproxy-service:

file.managed:

- name: /etc/haproxy/haproxy.cfg

- source: salt://cluster/files/haproxy-outside.cfg

- user: root

- group: root

- mode: 644

- template: jinja 新增一行,使用jinja模板,使用变量

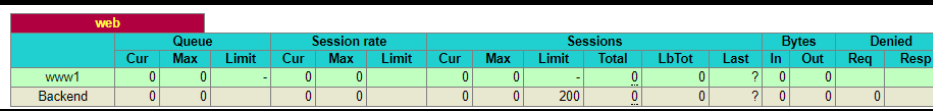

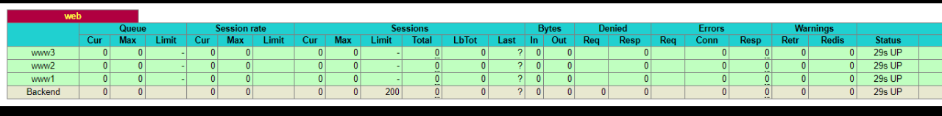

测试并验证:

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www2 -XPUT -d value="192.168.44.134:8080"|python -m json.tool

{

"action": "set",

"node": {

"createdIndex": 14,

"key": "/salt/haproxy/backend_www/www2",

"modifiedIndex": 14,

"value": "192.168.44.134:8080"

}

}

[root@node1 ~]# curl -s http://192.168.44.134:2379/v2/keys/salt/haproxy/backend_www/www3 -XPUT -d value="192.168.44.135:8080"|python -m json.tool

{

"action": "set",

"node": {

"createdIndex": 15,

"key": "/salt/haproxy/backend_www/www3",

"modifiedIndex": 15,

"value": "192.168.44.135:8080"

}

}

查看设置的pillar:

[root@node1 ~]# salt '*' pillar.items

node2:

----------

backend_www:

----------

www1:

192.168.44.134:8081

www2:

192.168.44.134:8080

www3:

192.168.44.135:8080

执行salt状态配置文件:

saltstack实现自动化扩容的更多相关文章

- saltstack自动化运维系列11基于etcd的saltstack的自动化扩容

saltstack自动化运维系列11基于etcd的saltstack的自动化扩容 自动化运维-基于etcd加saltstack的自动化扩容# tar -xf etcd-v2.2.1-linux-amd ...

- Saltstack自动化扩容

一. etcd服务的安装和使用 1.安装etcd应用: wget https://github.com/coreos/etcd/releases/download/v2.2.5/etcd-v2.2.5 ...

- saltstack之自动化运维

引入 简介 saltstack是由thomas Hatch于2011年创建的一个开源项目,设计初衷是为了实现一个快速的远程执行系统. 早期运维人员会根据自己的生产环境来写特定脚本完成大量重复性工作,这 ...

- 学习saltstack (五)

Saltstack介绍 Salt三种运行方式 1.local本地运行2.Master/Minion3.Salt ssh Salt的三大功能 a.远程执行b.配置管理(状态管理)c.云管理:阿里云,aw ...

- Redis Cluster 自动化安装,扩容和缩容

Redis Cluster 自动化安装,扩容和缩容 之前写过一篇基于python的redis集群自动化安装的实现,基于纯命令的集群实现还是相当繁琐的,因此官方提供了redis-trib.rb这个工具虽 ...

- k8s Pod 扩容和缩容

在生产环境下,在面临服务需要扩容的场景时,可以使用Deployment/RC的Scale机制来实现.Kubernetes支持对Pod的手动扩容和自动扩容. 手动扩容缩容 通过执行扩容命令,对某个dep ...

- 基于Saltstack、Artifactory打造传统模式下持续部署平台

一.持续部署 1. 现状 由于没有建立标准的持续部署流程,导致了版本管理混乱,制品管理混乱,上线持续时间长,上线测试覆盖不全面,业务流量上升后故障较多,排查复杂.运维.测试.开发人员每次版本迭代的时候 ...

- 运维知识体系v0.5

http://www.90qj.com/?post=318http://ixdba.blog.51cto.com/2895551/1751377 运维知识体系v0.5-(运维社区-赵班长出品,欢迎 ...

- Docker系列一之基础快速入门企业实战

1.1什么是LXC LXC为Linux Container的简写.Linux Container容器是一种内核虚拟化技术,可以提供轻量级的虚拟化,以便隔离进程和资源,而且不需要提供指令解释机制以及全虚 ...

随机推荐

- 【BZOJ4275】[ONTAK2015]Badania naukowe DP

[BZOJ4275][ONTAK2015]Badania naukowe Description 给定三个数字串A,B,C,请找到一个A,B的最长公共子序列,满足C是该子序列的子串. Input 第一 ...

- 【BZOJ4883】[Lydsy2017年5月月赛]棋盘上的守卫 KM算法

[BZOJ4883][Lydsy2017年5月月赛]棋盘上的守卫 Description 在一个n*m的棋盘上要放置若干个守卫.对于n行来说,每行必须恰好放置一个横向守卫:同理对于m列来说,每列 必须 ...

- 类似hibernate实现sql增删改错

Util package utils; import java.lang.reflect.Method; import java.util.ArrayList; import java.util.Ha ...

- 160526、高并发之LVS搭建负载均衡

LVS介绍: LVS的英文全称是Linux Virtual Server,即Linux虚拟服务器.它是我们国家的章文嵩博士的一个开源项目.在linux内核2.6中,它已经成为内核的一部分,在此之前的内 ...

- protobuf在java应用中通过反射动态创建对象(DynamicMessage)

---恢复内容开始--- 最近编写一个游戏用到protobuf数据格式进行前后台传输,苦于protobuf接受客户端的数据时是需要数据类型的如xxx.parseForm(...),这样就要求服务器在接 ...

- 20165330 2017-2018-2《Java程序设计》课程总结

20165330 2017-2018-2<Java程序设计>课程总结 每周作业链接汇总 预备作业1:我期望的师生关系 预备作业2:做中学learning by doing个人感想及学习基础 ...

- Spring Data 之 Repository 接口

1. 介绍 Repository是一个空接口,即是一个标记性接口; 若我们定义的接口继承了Repository,则该接口会被IOC容器识别为一个 Repository Bean; 也可以通过@Repo ...

- OVN实战---《OVN and Containers》翻译

Overview 在本篇文章中,我们要讨论的是OVN和容器的集成.到本次实验中,我们将会创建一个包含有一对容器的“虚拟机”,这些容器会直接和OVN logical switch相连,并且可以供逻辑网络 ...

- 解决MySQL数据库同步1236错误

1.报错如下: Got fatal error from master when reading data from binary log: 'The slave is connecting usin ...

- SVM支持向量机总结

一.拉格朗日乘子法 一般,在有等式约束时使用拉格朗日乘子法,在有不等约束时使用KKT条件.这里我们先介绍拉格朗日乘子法,后面再介绍KKT条件. 比如考虑下面的组合优化的问题, 这是一个带等式约束的优化 ...