Azure Data Factory(四)集成 Logic App 的邮件通知提醒

一,引言

上一篇有介绍到使用Azure Data Factory 复制数据,然后有集成 Azure DevOps 实现CI/CD,但是对于真正的项目来说,这些肯定是不够的,比如说在执行 Azure Pipeline 的过程中的监视,监视 Pipeline 的状态,想通过邮件的方式接受监视信息。

--------------------我是分割线--------------------

1,Azure Data Factory(一)入门简介

2,Azure Data Factory(二)复制数据

3,Azure Data Factory(三)集成 Azure Devops 实现CI/CD

4,Azure Data Factory(四)集成 Logic App 的邮件通知提醒

二,正文

1,创建Logic App作为邮件通知

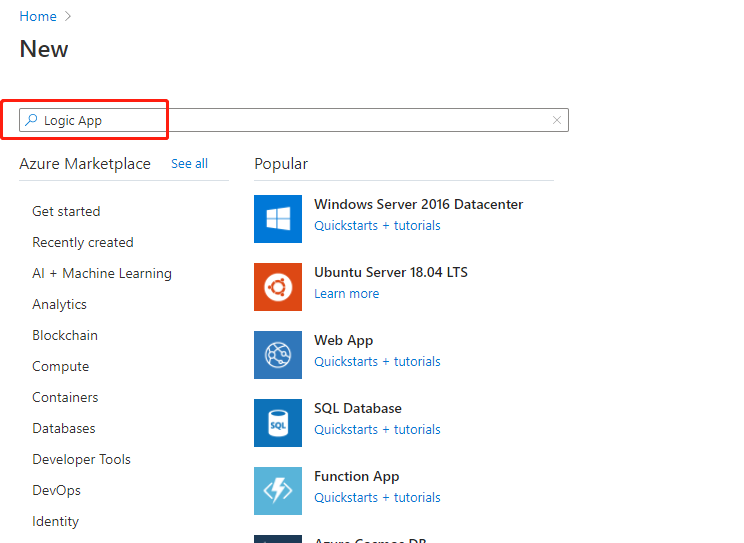

azure portal 中点击“create a resource”,输入框中输入“Logic App” 进行搜索。

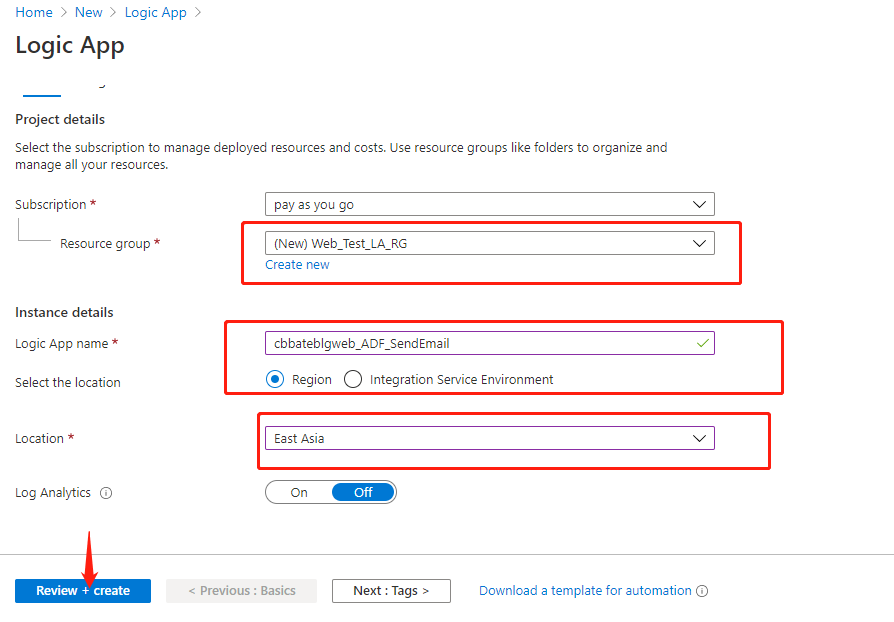

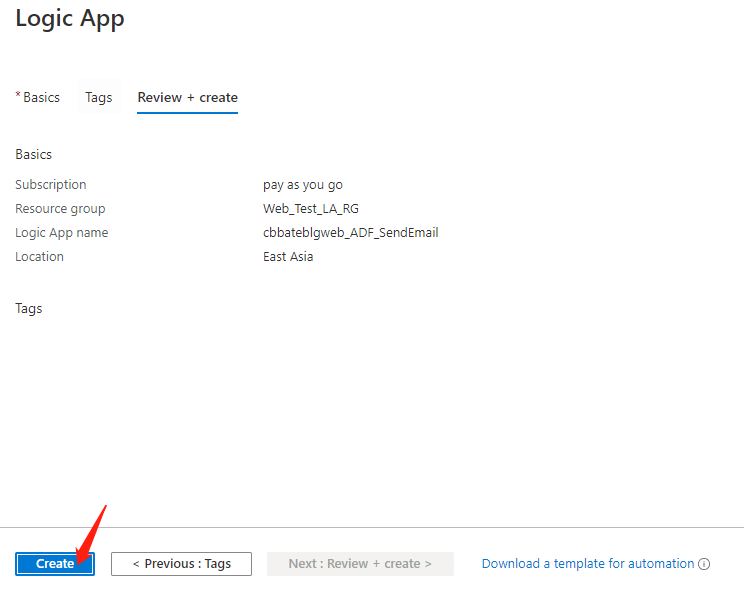

Resource group 选择创建一个新的:“Web_Test_LA_RG”

Logic App Name:“cbbateblgweb_ADF_SendEmail”

Location 选择:“East Asia”

点击 “Review + create”

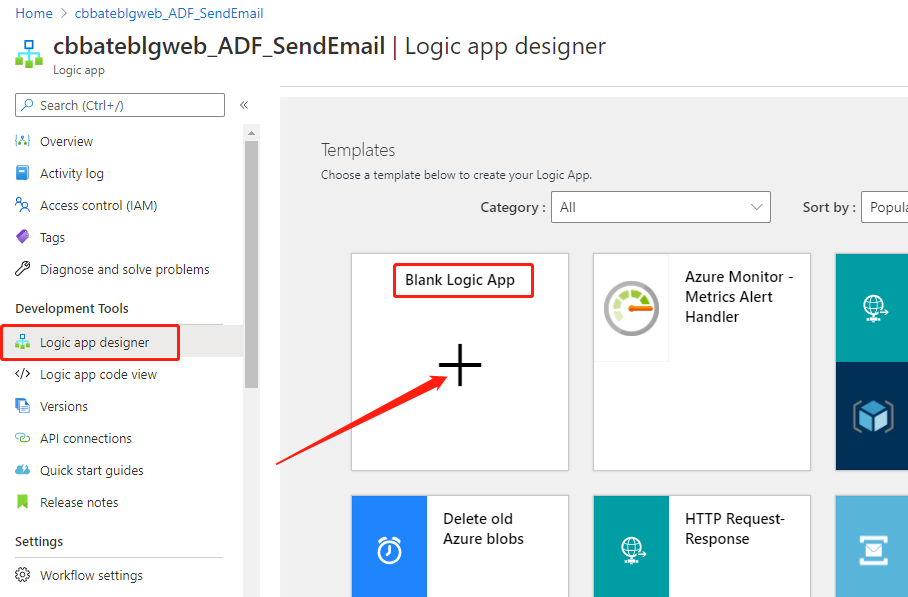

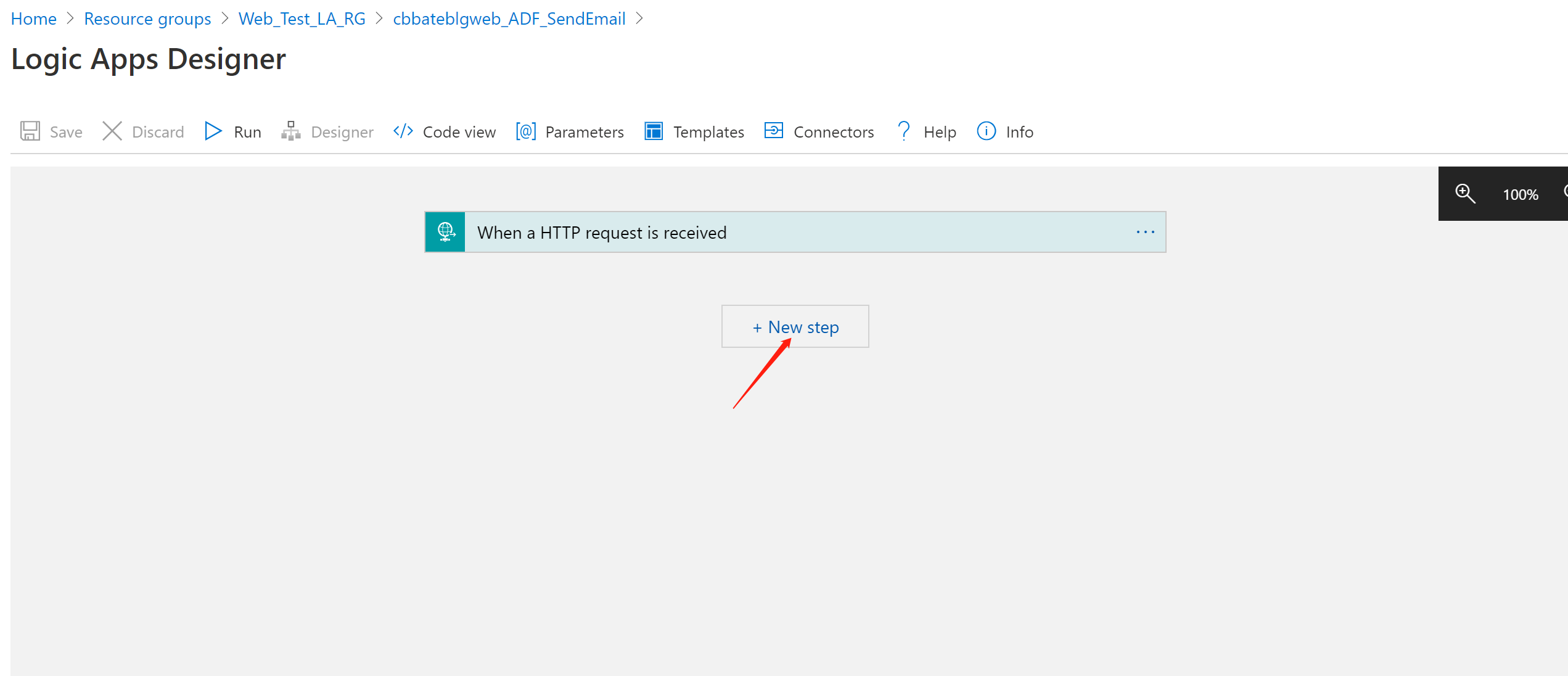

等待完成后,我们点击进入创建好的Logic App。选择 “Development Tools=》Logic”,点击 “Blank Logic App” 创建空白的Logic App

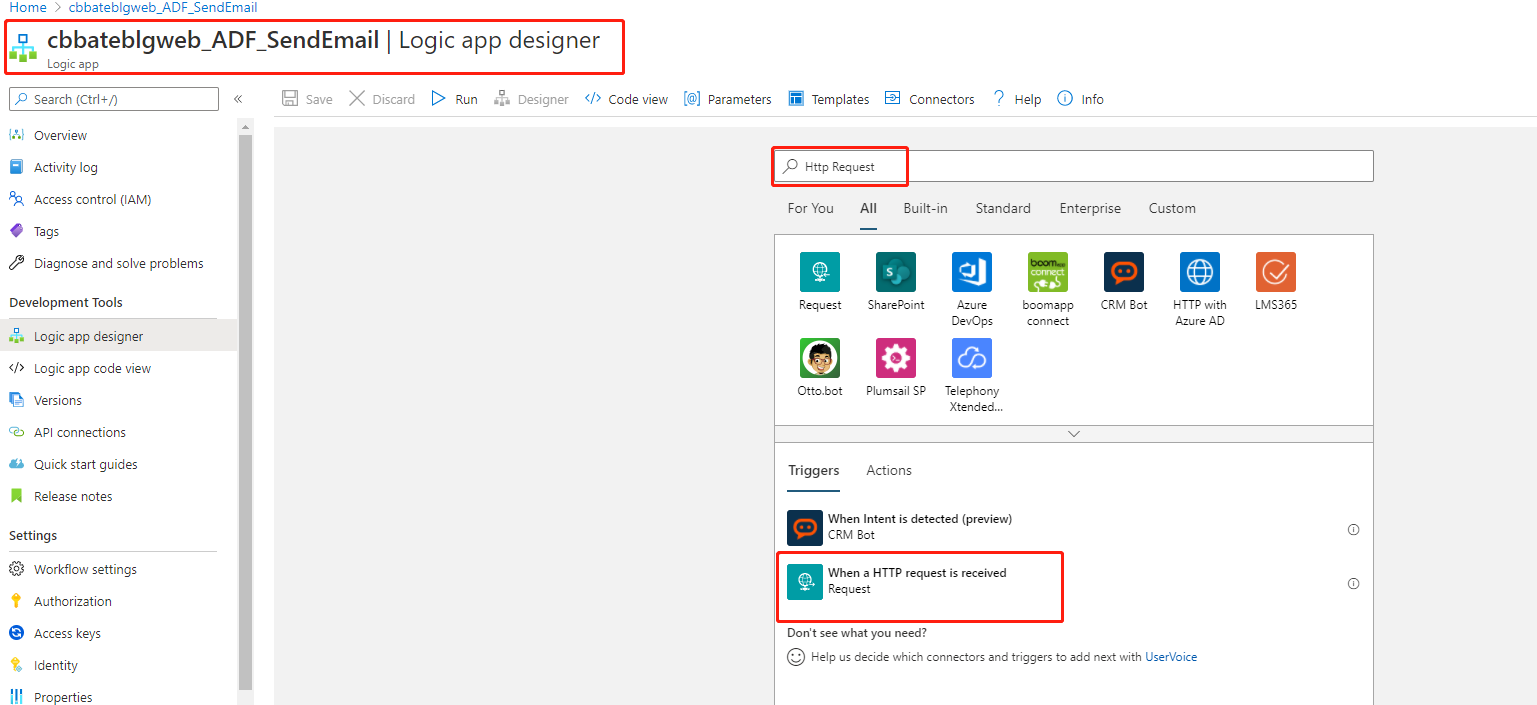

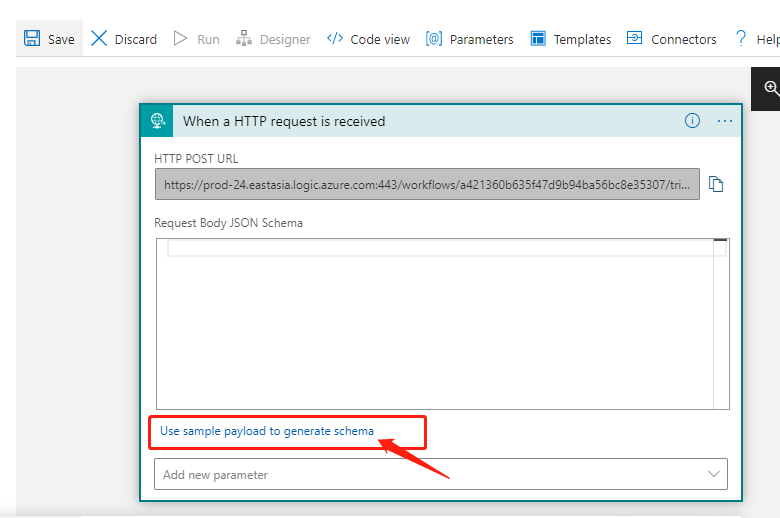

在输入框中输入 “Http Request”,选择搜索结果中 “Trigger” 下的 “When a Http request is received”(当接受一个Http 请求时)

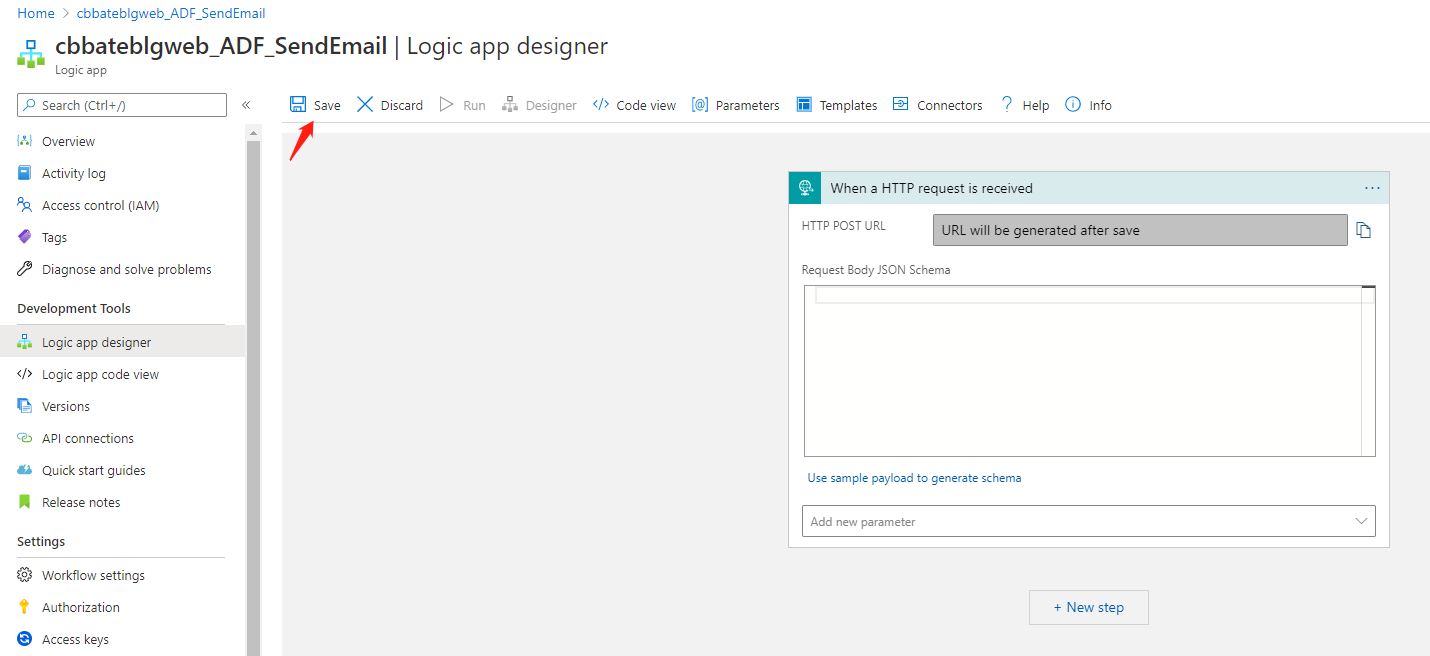

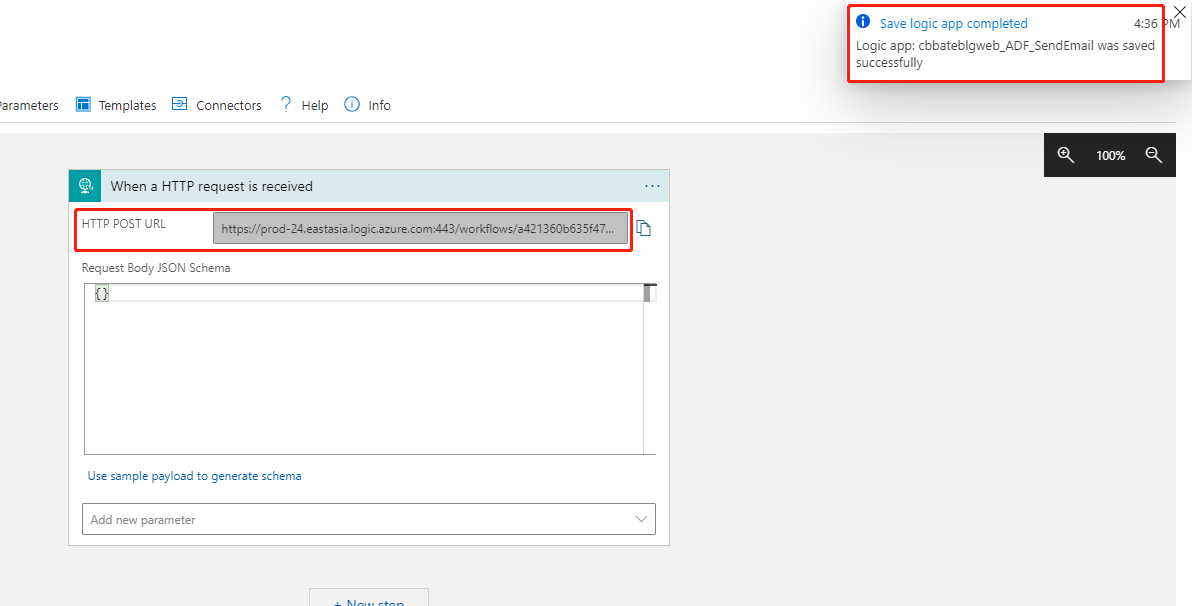

点击 “Save”,等待生成 “HTTP POST URL”

稍等片刻后,就可以看到生成出来的URL,我们先复制保存,等下可以用到。

接下来我们需要配置实例payload,点击图中圈中的部分

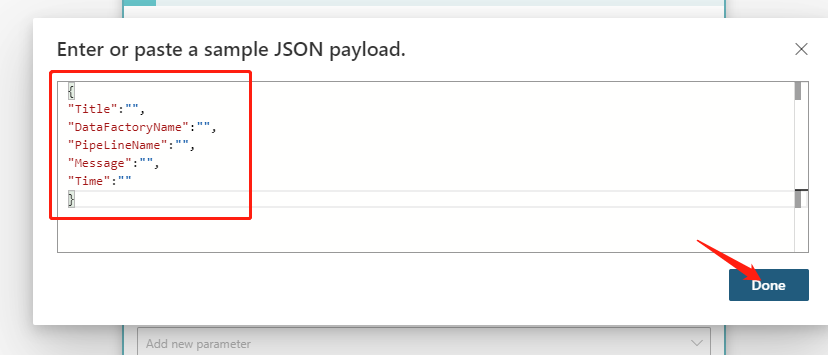

输入以下内容:

{

"Title":"",

"DataFactoryName":"",

"PipeLineName":"",

"Message":"",

"Time":""

}

点击 “Done”

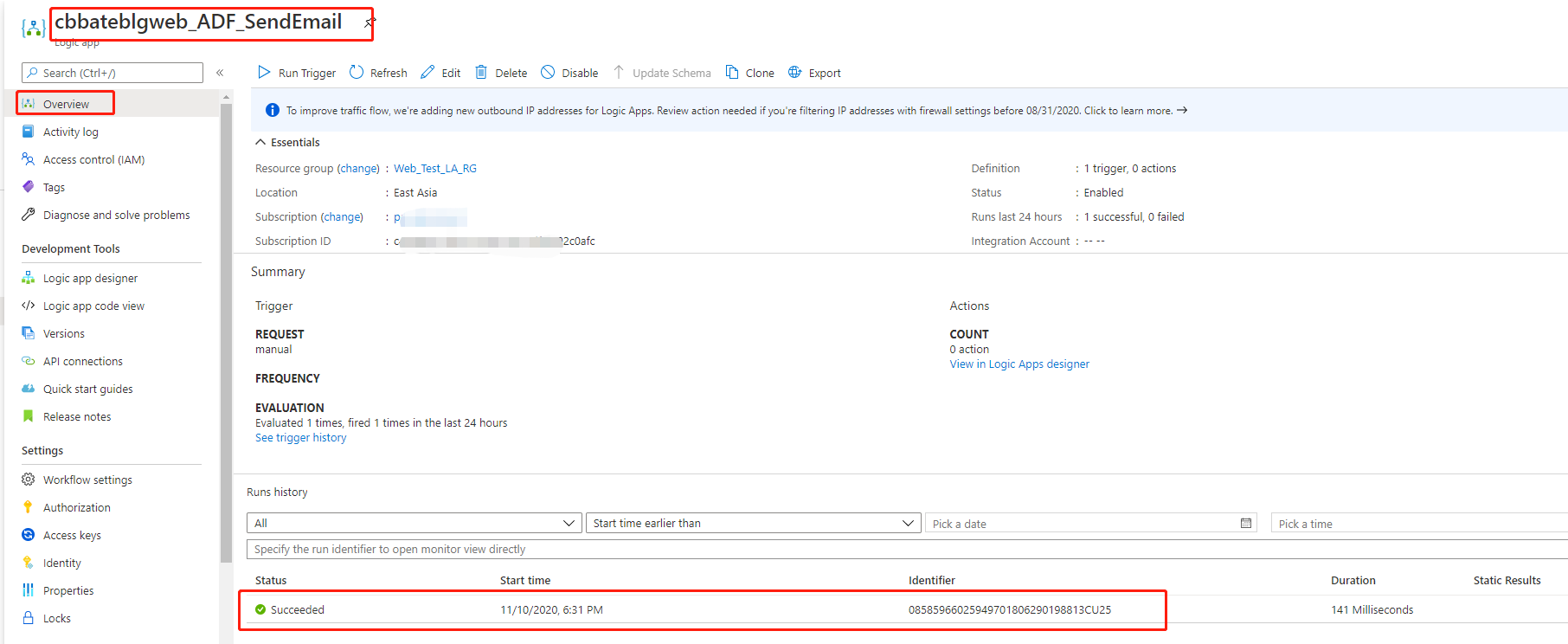

完成上述操作后,点击 “Save” 进行保存操作。并且刷新测试当前创建的Logic App的状态

2,配置Azure Factory

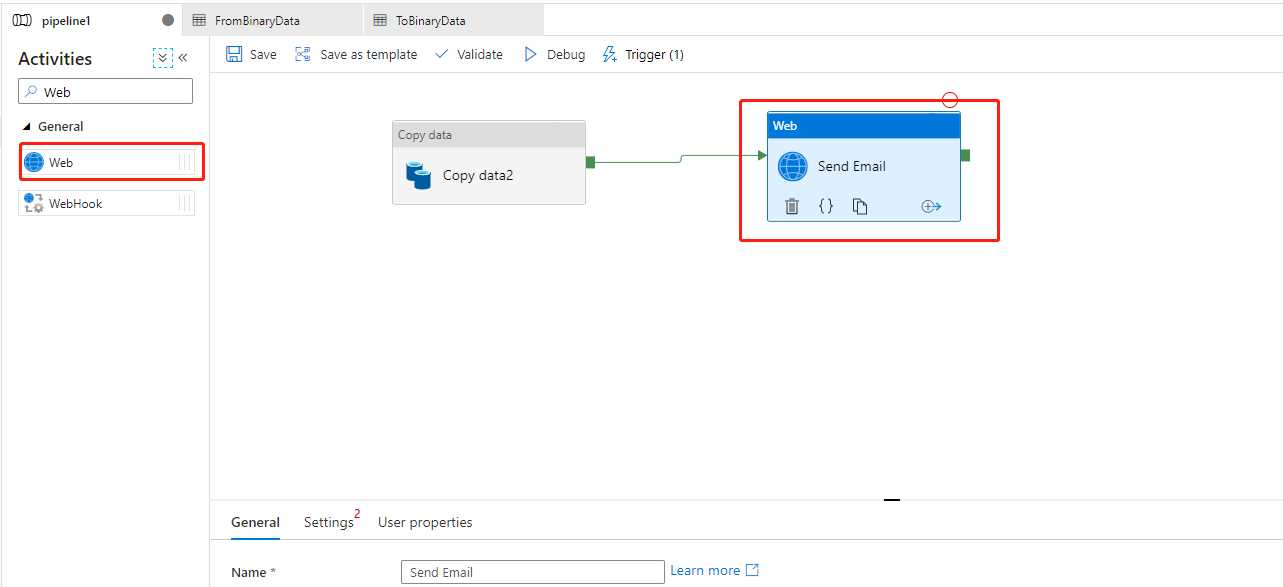

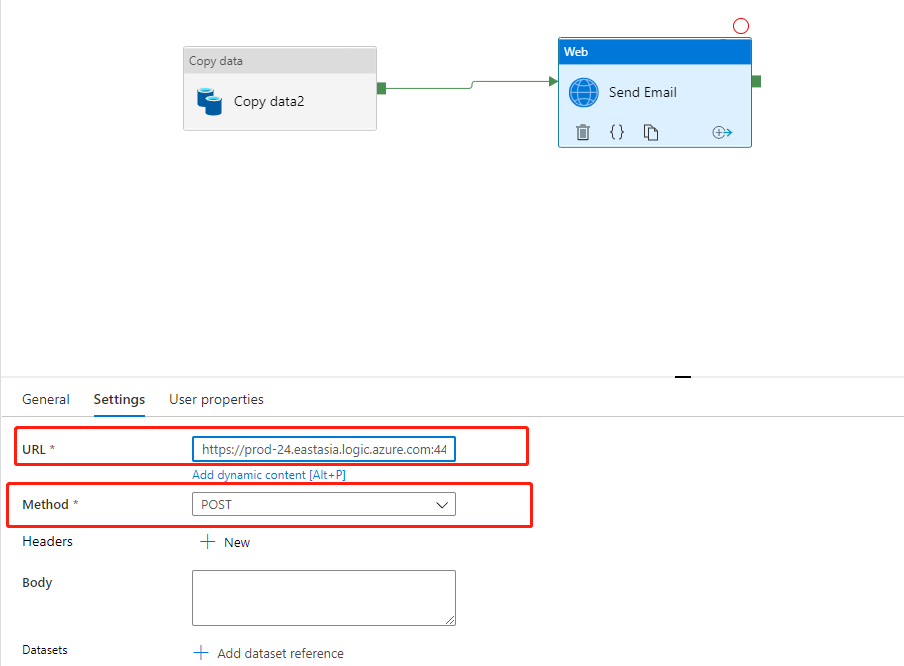

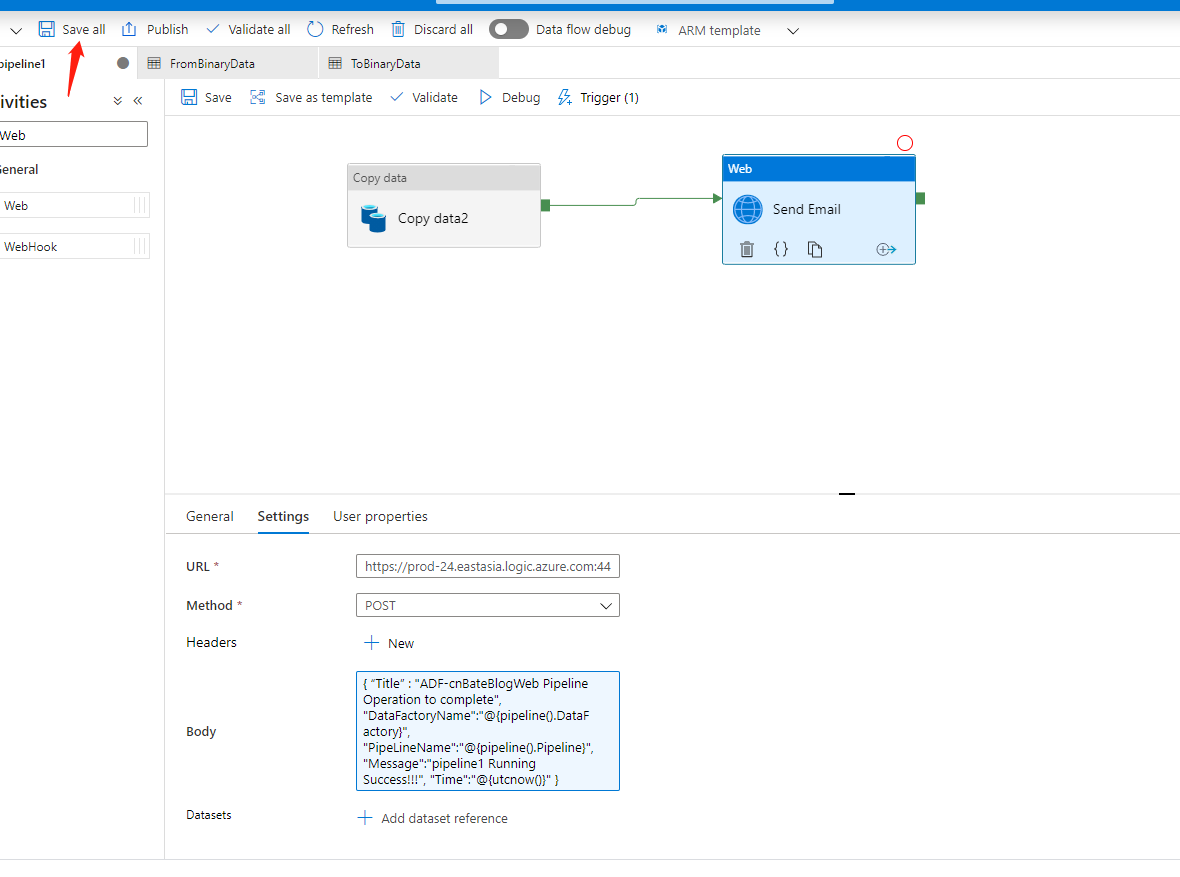

回到之前创建好的 Dev 环境的 Azure Factory-----"ADF-CnBateBlogWeb-Dev",我们需要在Pipeline 中再添加一个叫 “Web” 的 Activities,并且修改当前活动的名称 “Send Emial”。

接下来需要配置URL Method等信息

URL 链接:就是刚刚创建Logic App 保存后生成的链接。

Method 选择:“POST”

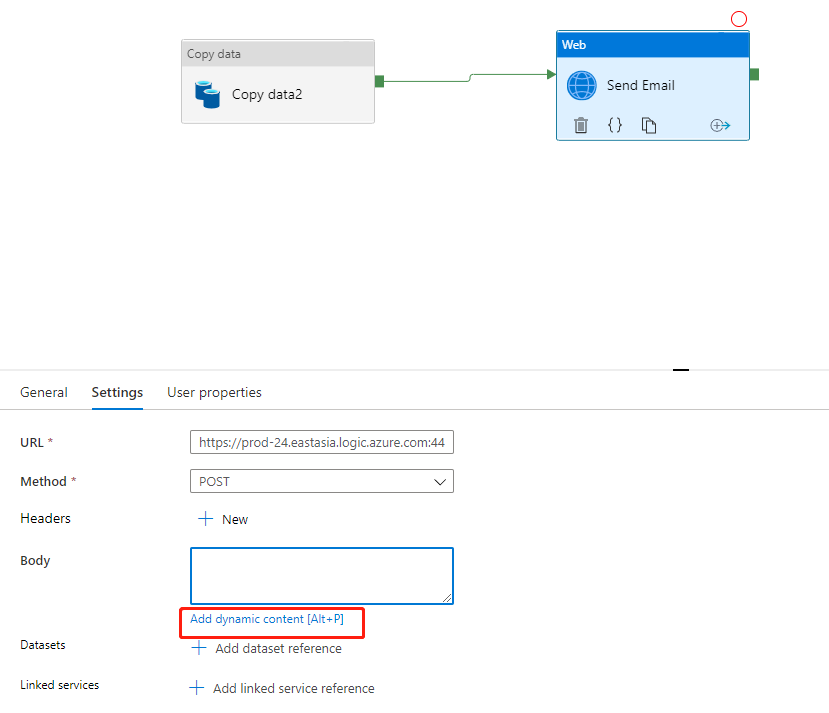

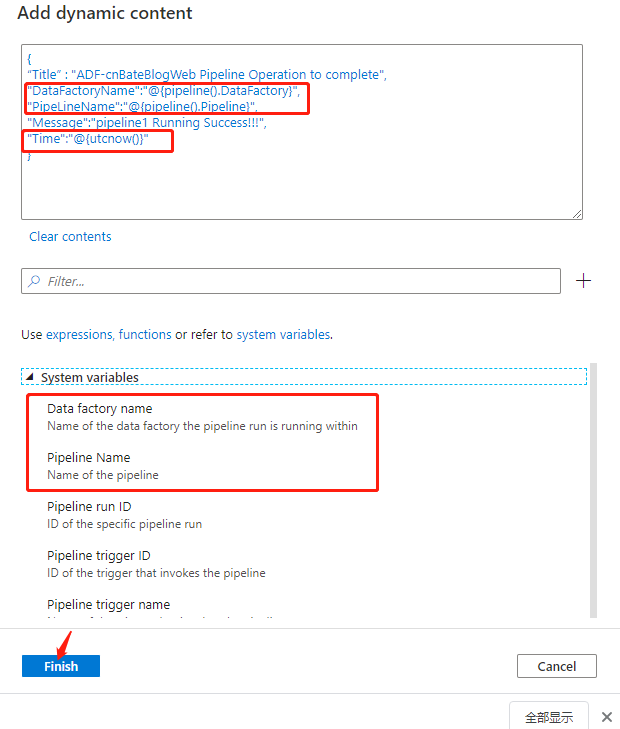

接下来就是需要我们自定义Emial通知的内容,也就是Email的正文数据,这个我们需要添加配置成动态数据,点击红色圈中的内容

当前动态数据需要的是Json格式的数据,我们输入以下Json 模板信息

{

"Title":"",

"DataFactoryName":"",

"PipeLineName":"",

"Message":"",

"Time":""

}

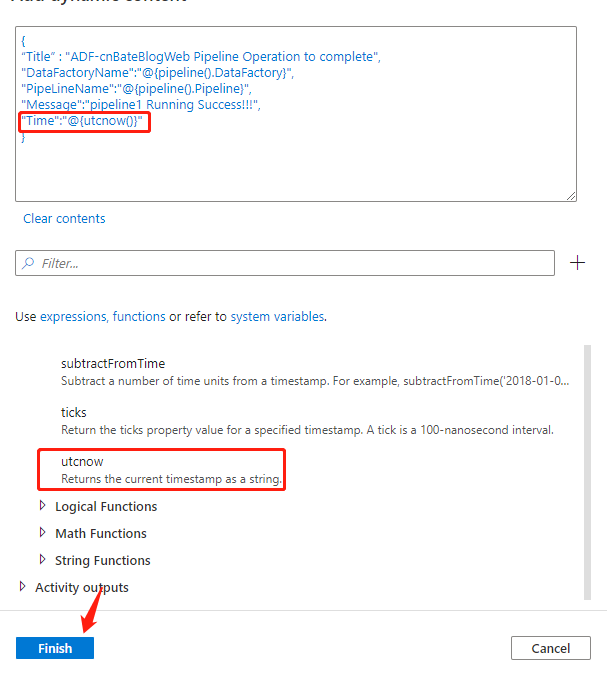

然后就是对当前各个key 的 Value 值进行赋值,我这里演示的是,将 “DataFactoryName”,“PipeLineName”,“Time” 三个Key 进行参数化动态数据。

选择对应的系统变量,以及时间函数,点击 “Finish”

配置完这些信息后,点击 “Save All”,全部进行保存操作

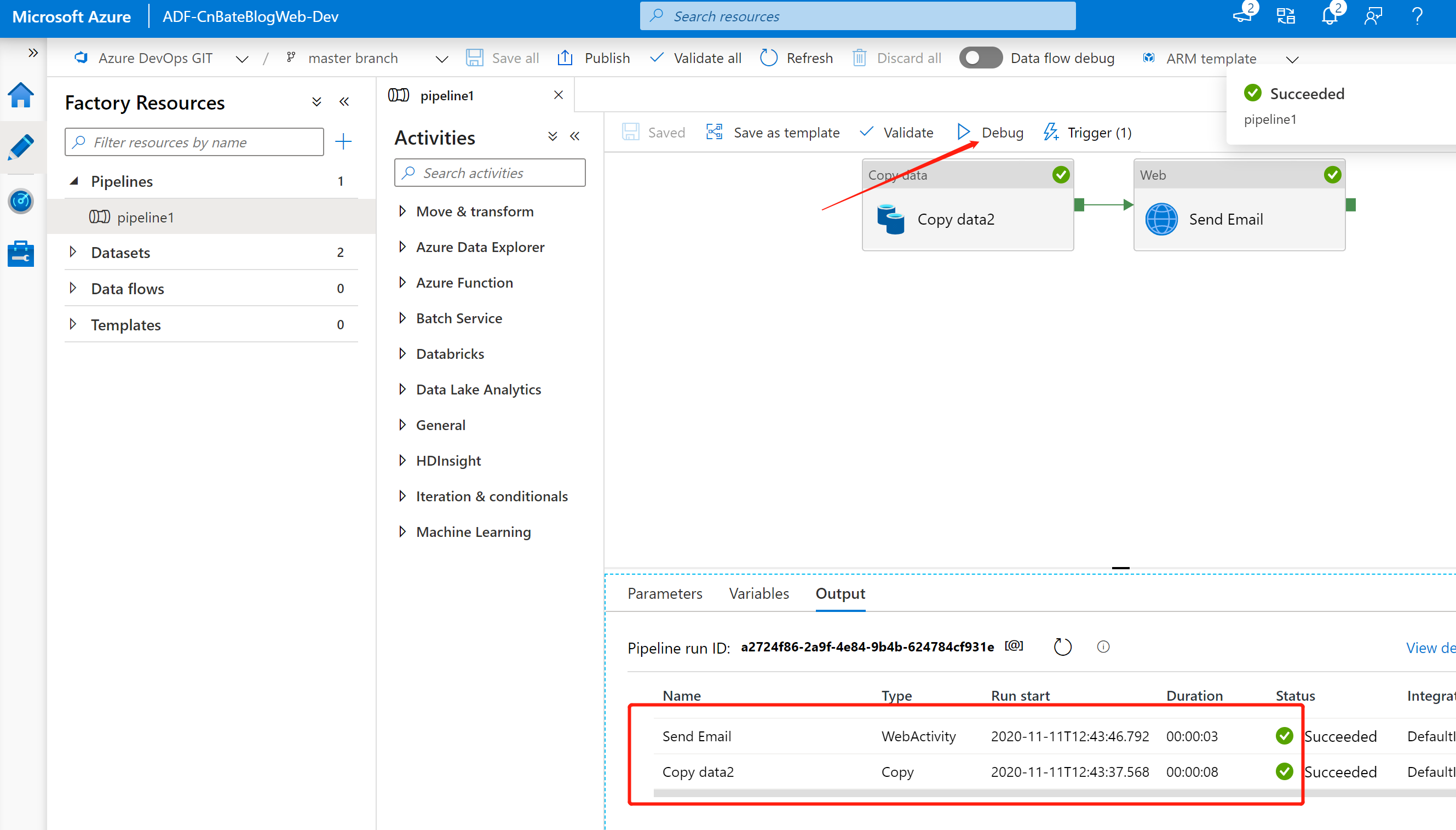

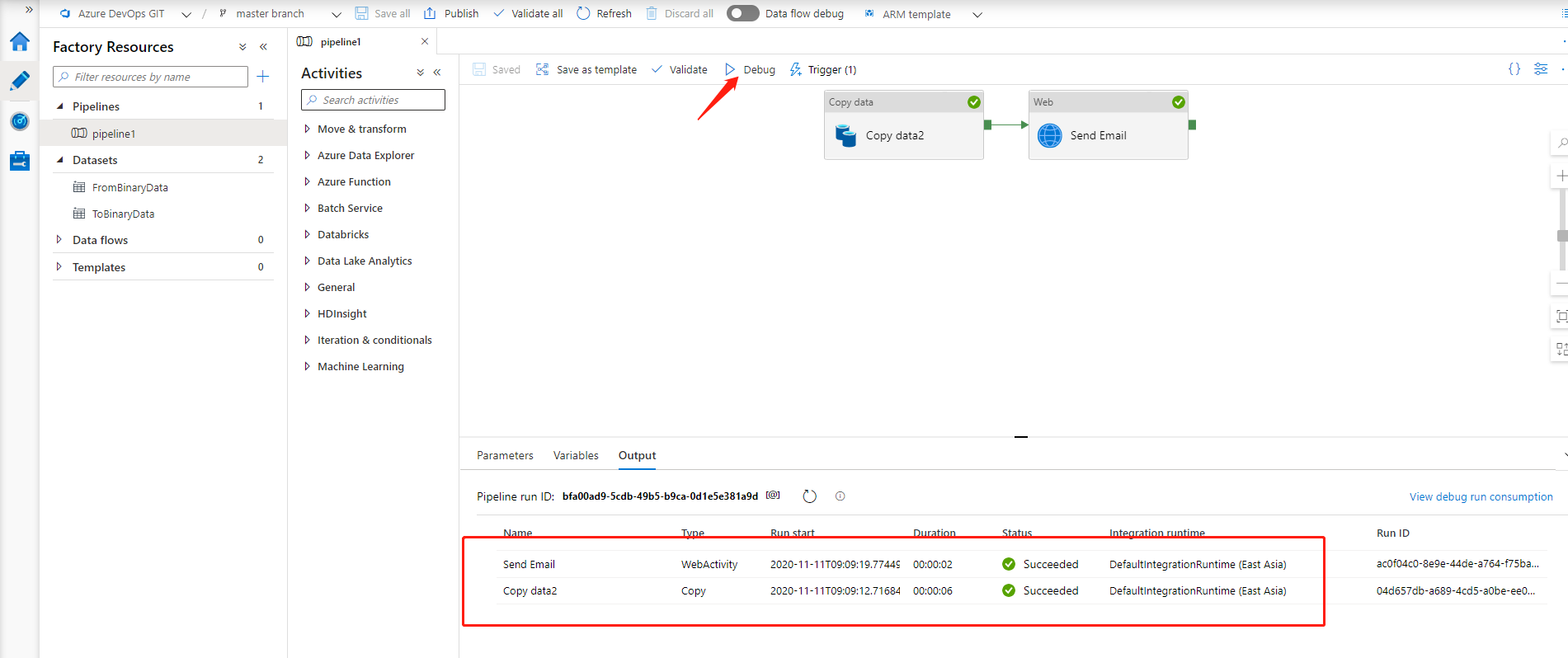

最后,我们可以点击 “Debug” 测试一下 pipeline 的运行状态

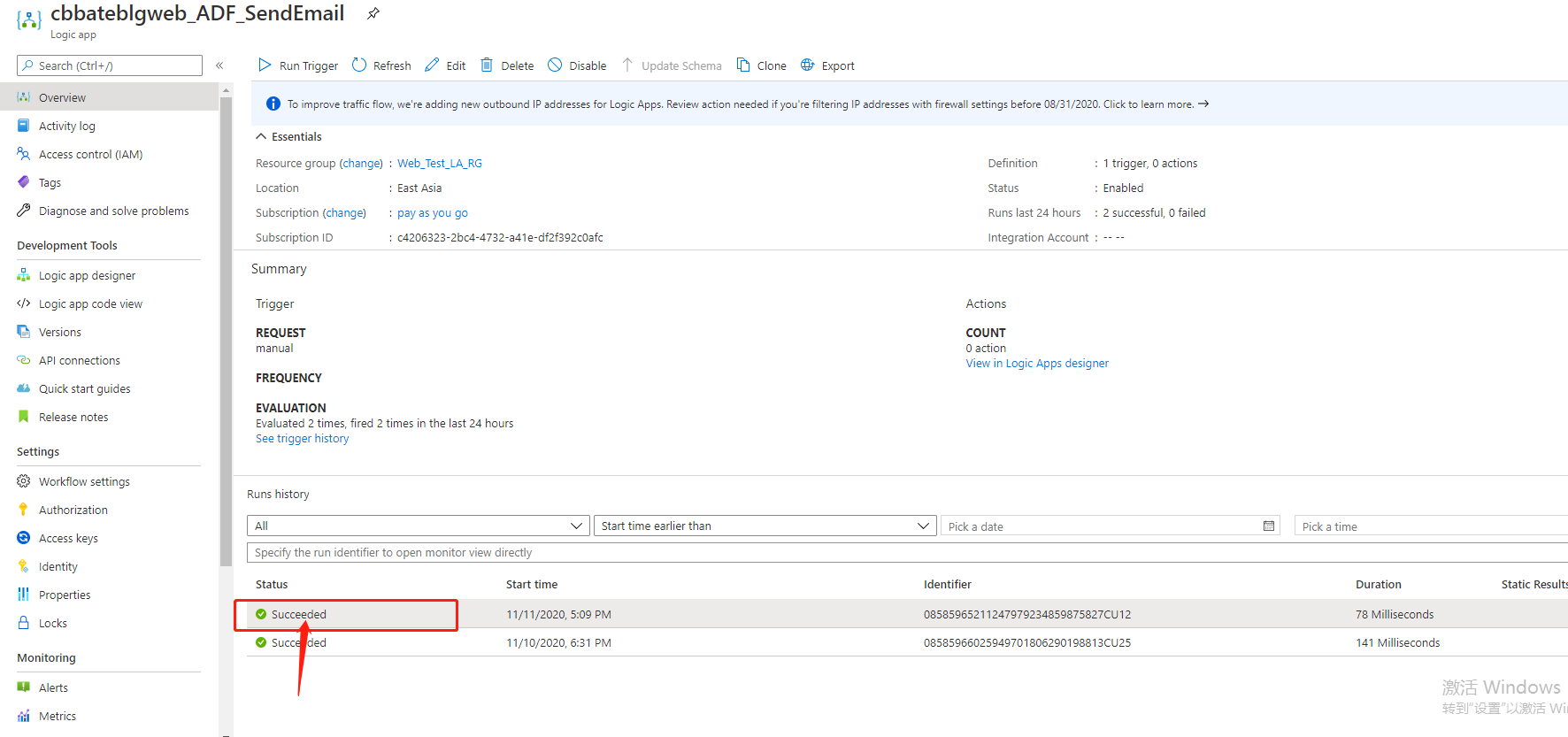

也可以回到 Logic App 中点击查看其运行历史状态

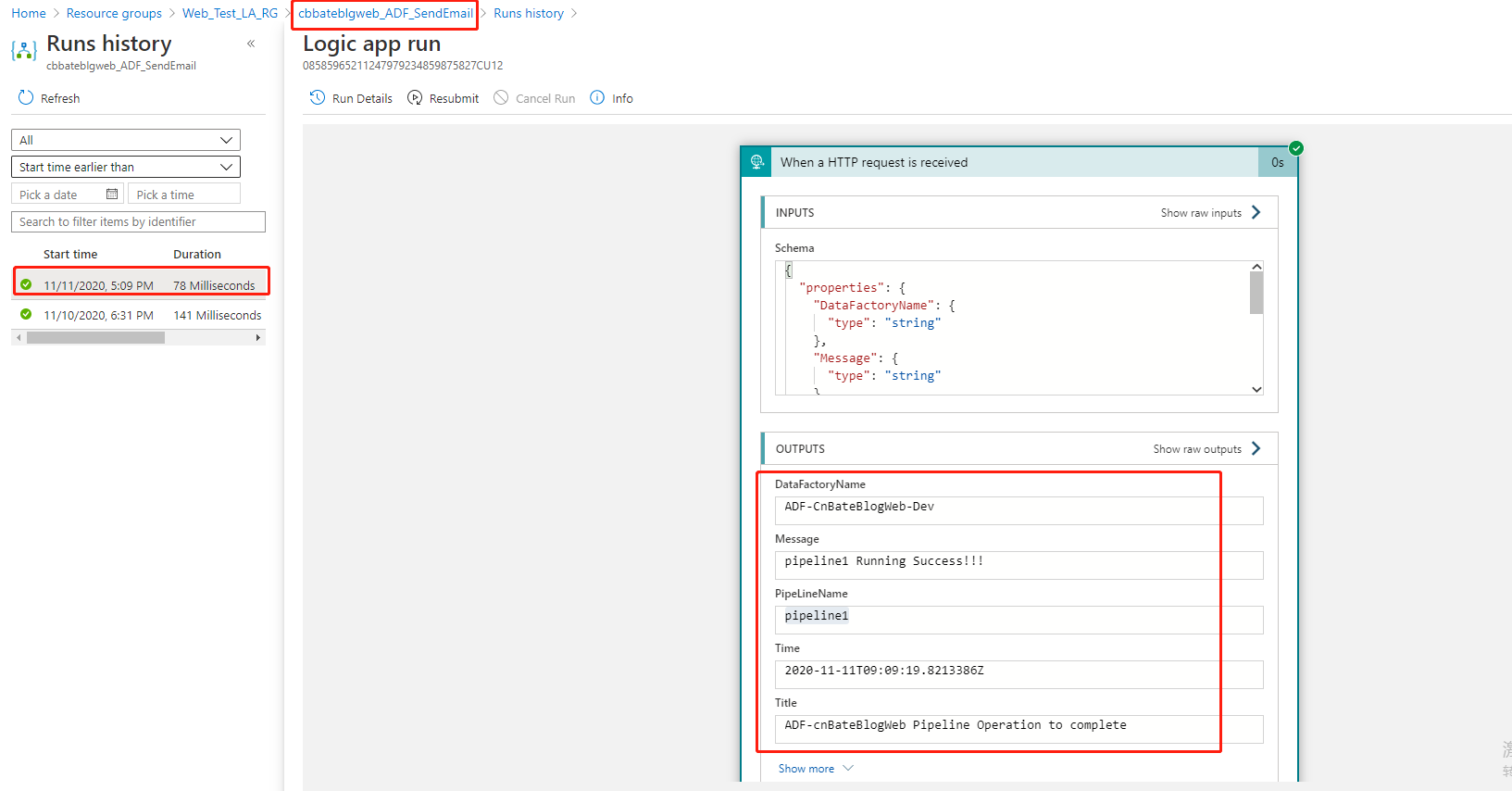

可以看到 output 输出的内容,如 ADF Name,PipeLine Name 等信息

3,配置 Logic App 添加邮件发送

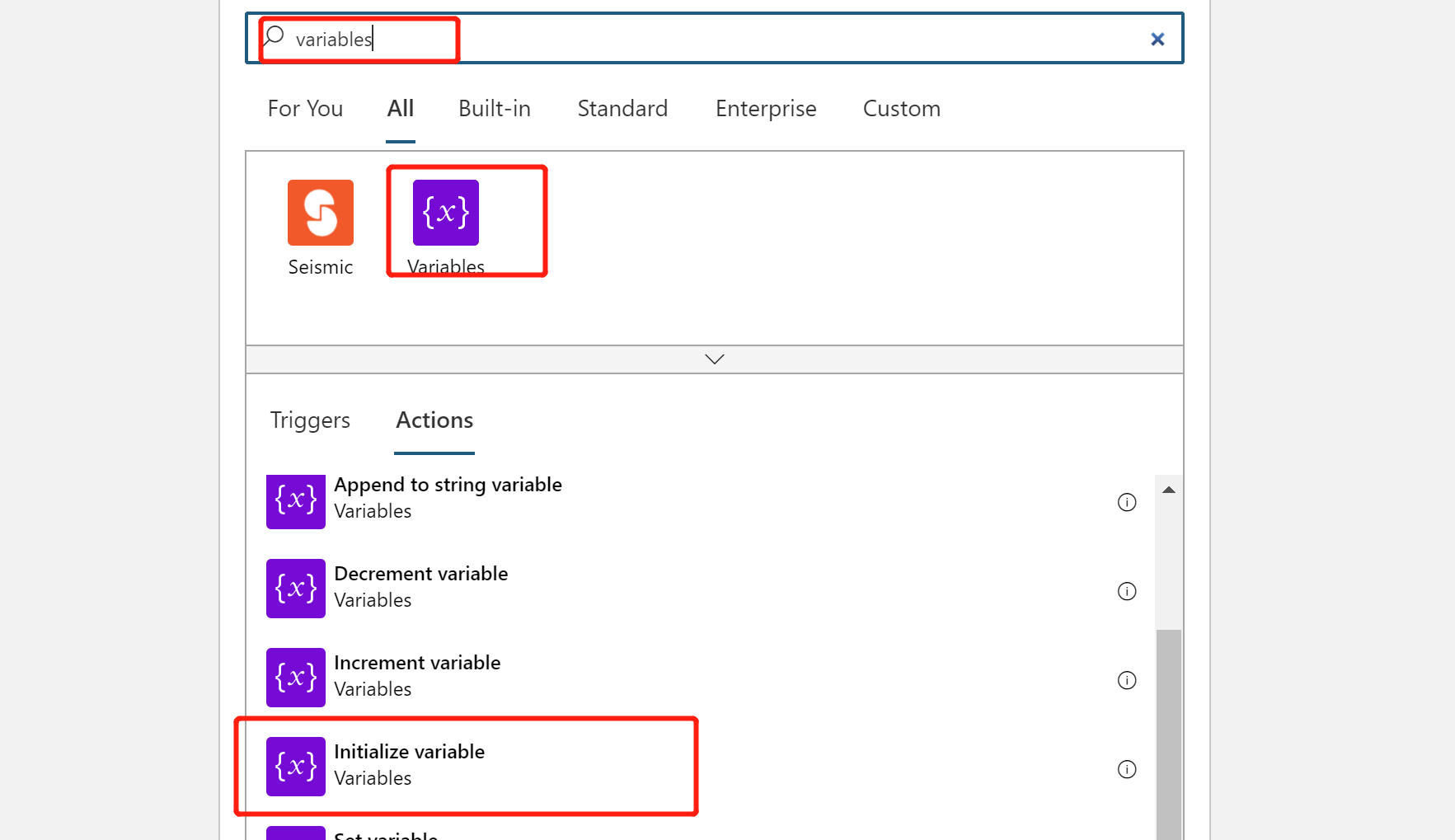

点击添加新的步骤,首先我们需要将接收到的Logic App 中的数据进行模板化,为什么呢?如果我们直接在添加 emial stage 的邮件内容中加的化,肯定不是不太友好的,我们如果前期提供一个很好的,很漂亮的邮件模板的话,那么我们只需要将这个格式化好的邮件模板直接输出就好了。

搜索 “varibales”,选择 “Initialize variables”(初始化参数)

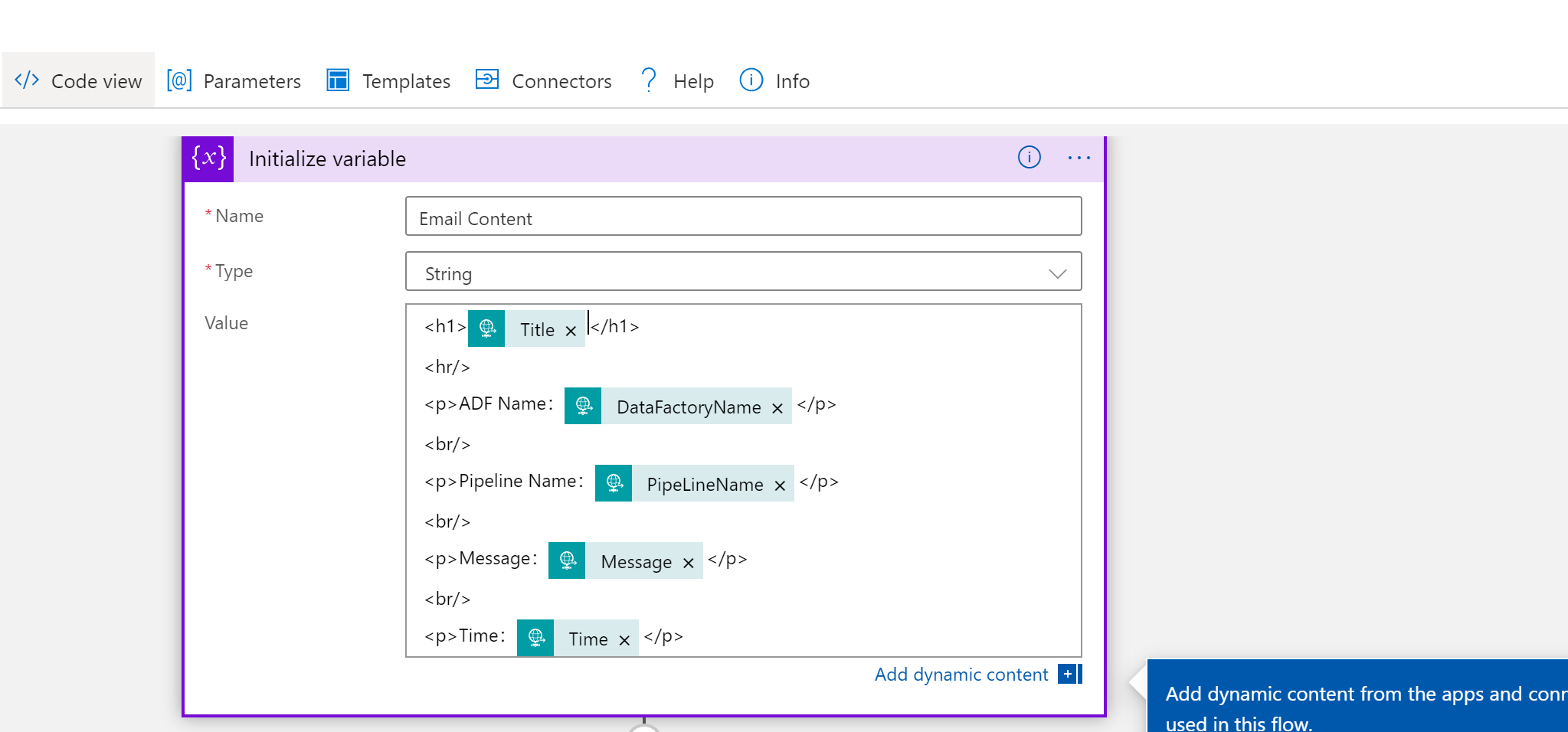

Name 输入 :“Email Content”

Type 选择:“String”

Value 填充我准备好的模板,以下时模板信息,大家在复制粘贴的时候,将对应的参数填充到对应的位置(我这里用@param 进行标记了)

<h1>@title</h1>

<hr/>

<p>ADF Name:@DataFactoryName</p>

<br/>

<p>Pipeline Name:@PipeLineName</p>

<br/>

<p>Message:@Message</p>

<br/>

<p>Time:@Time</p>

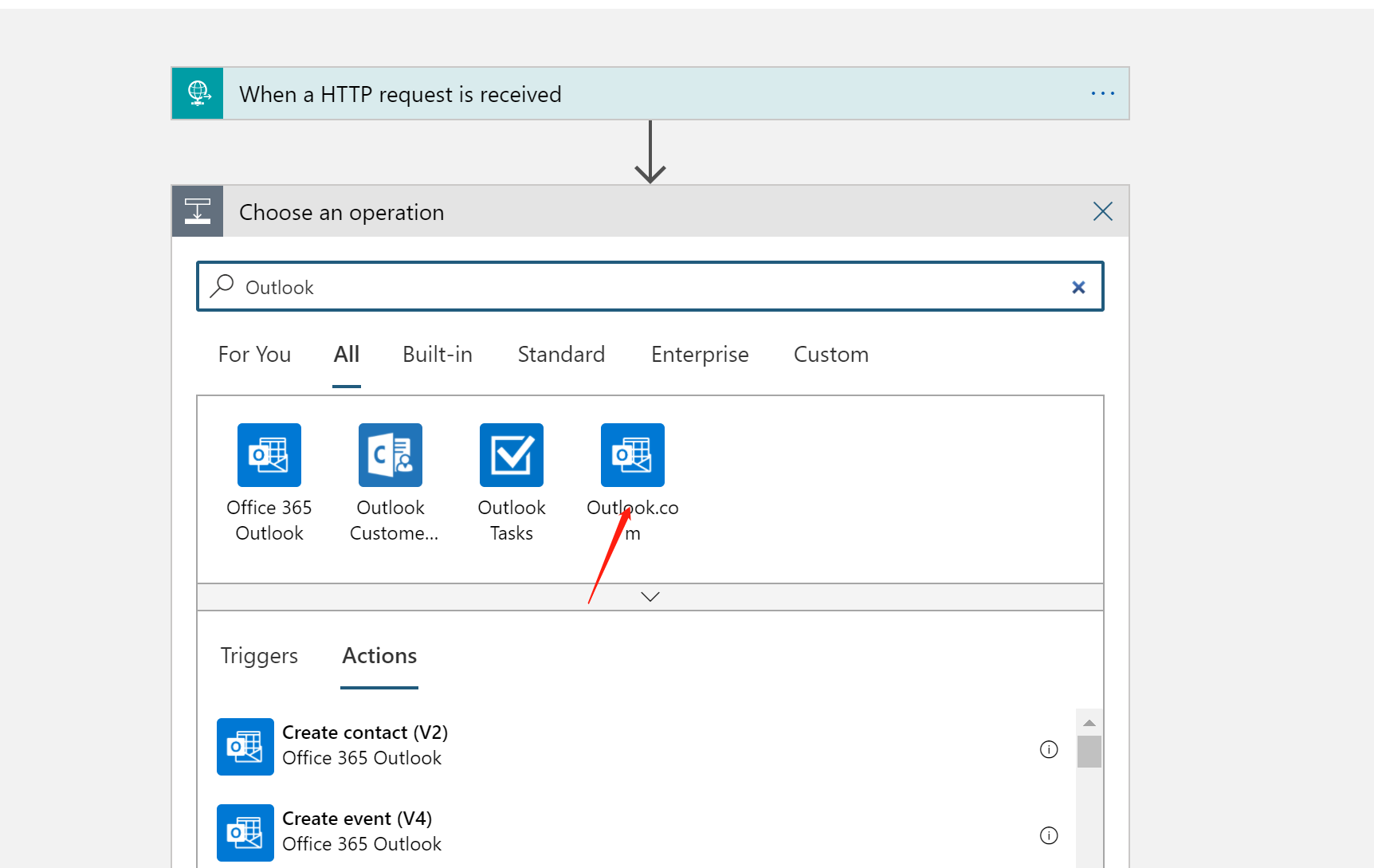

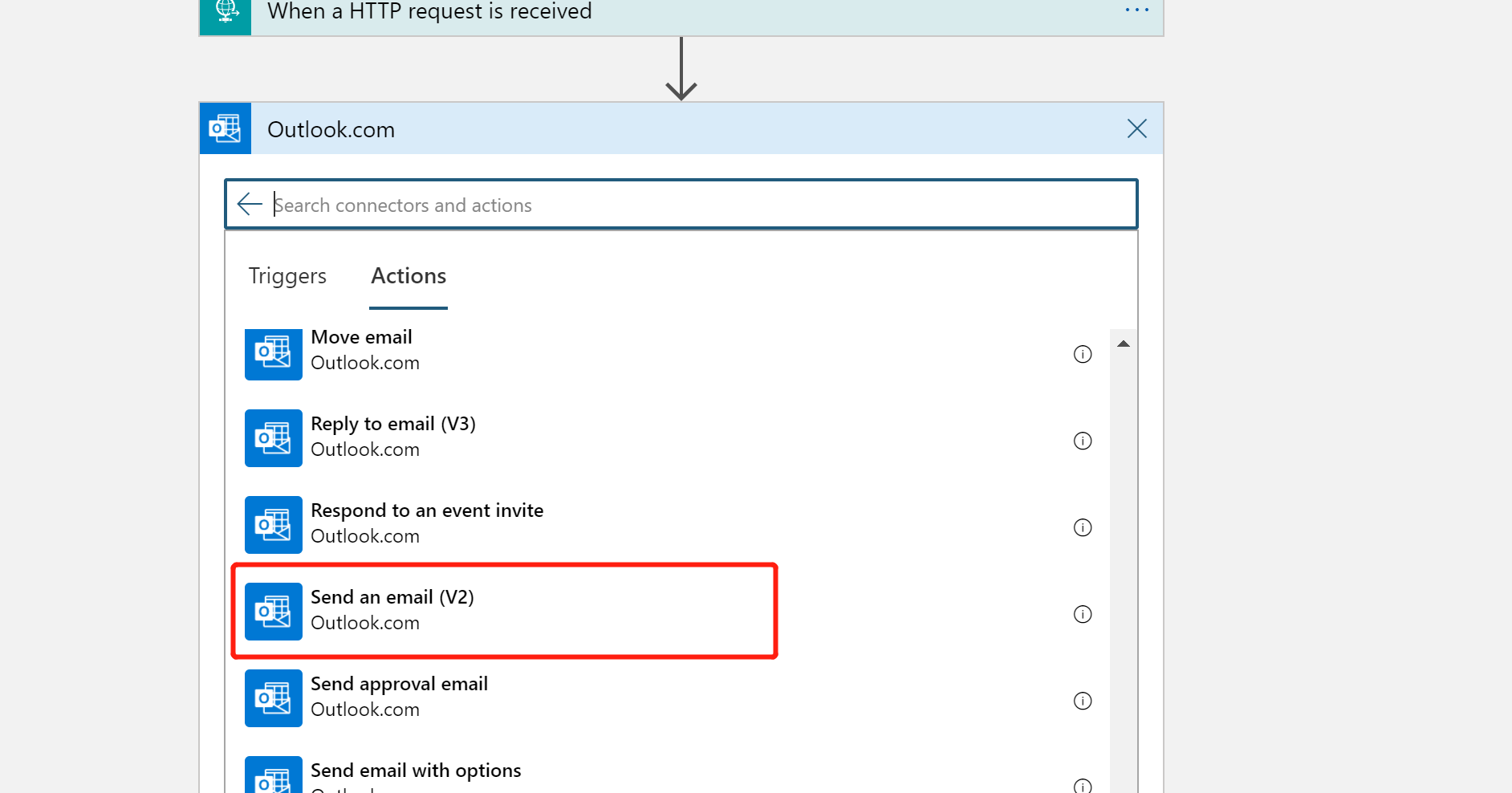

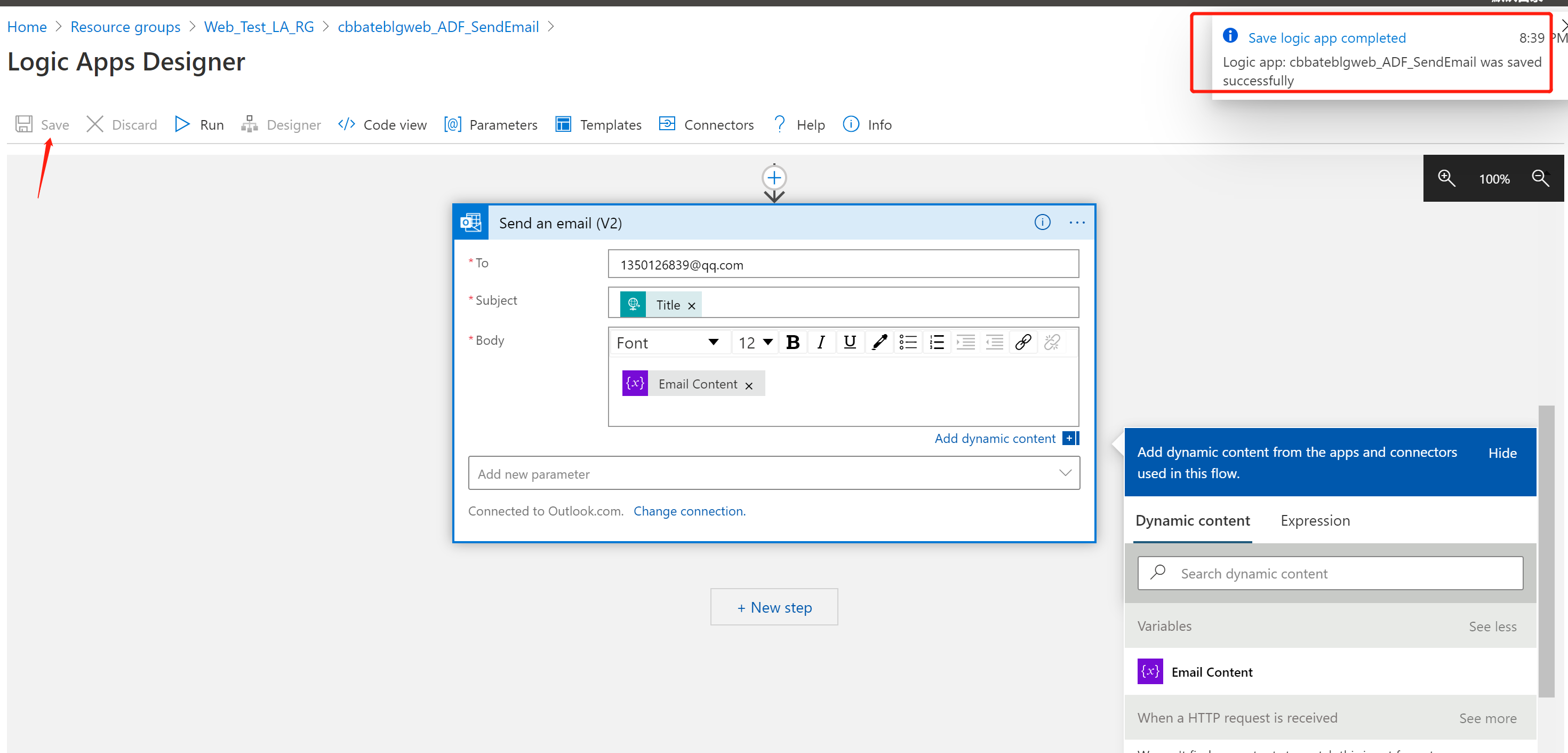

接下来就是再添加新的步骤来配置选择 outlook 邮箱

选择 “Send Emial V2”

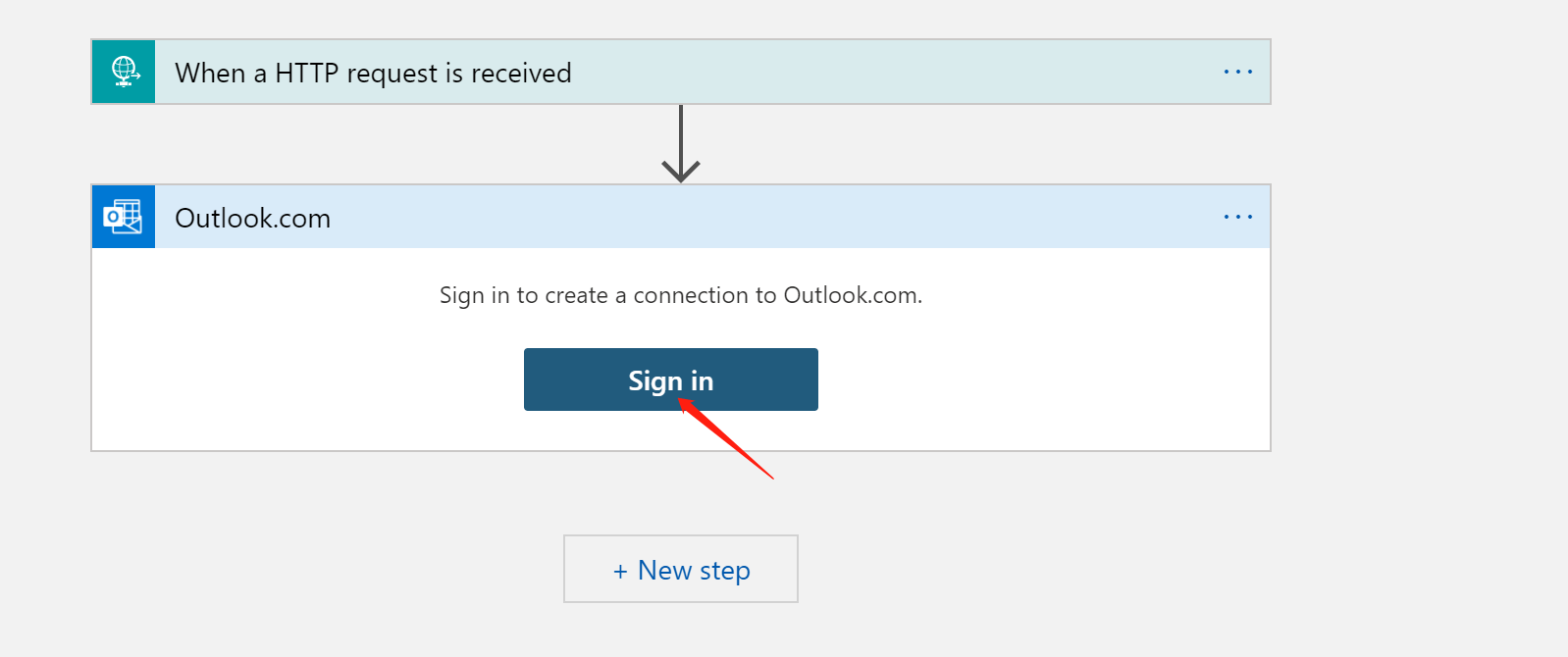

接下来就得登录连接到OutLook 邮箱。大家自行选择自己的需要登录的 outlook 邮箱

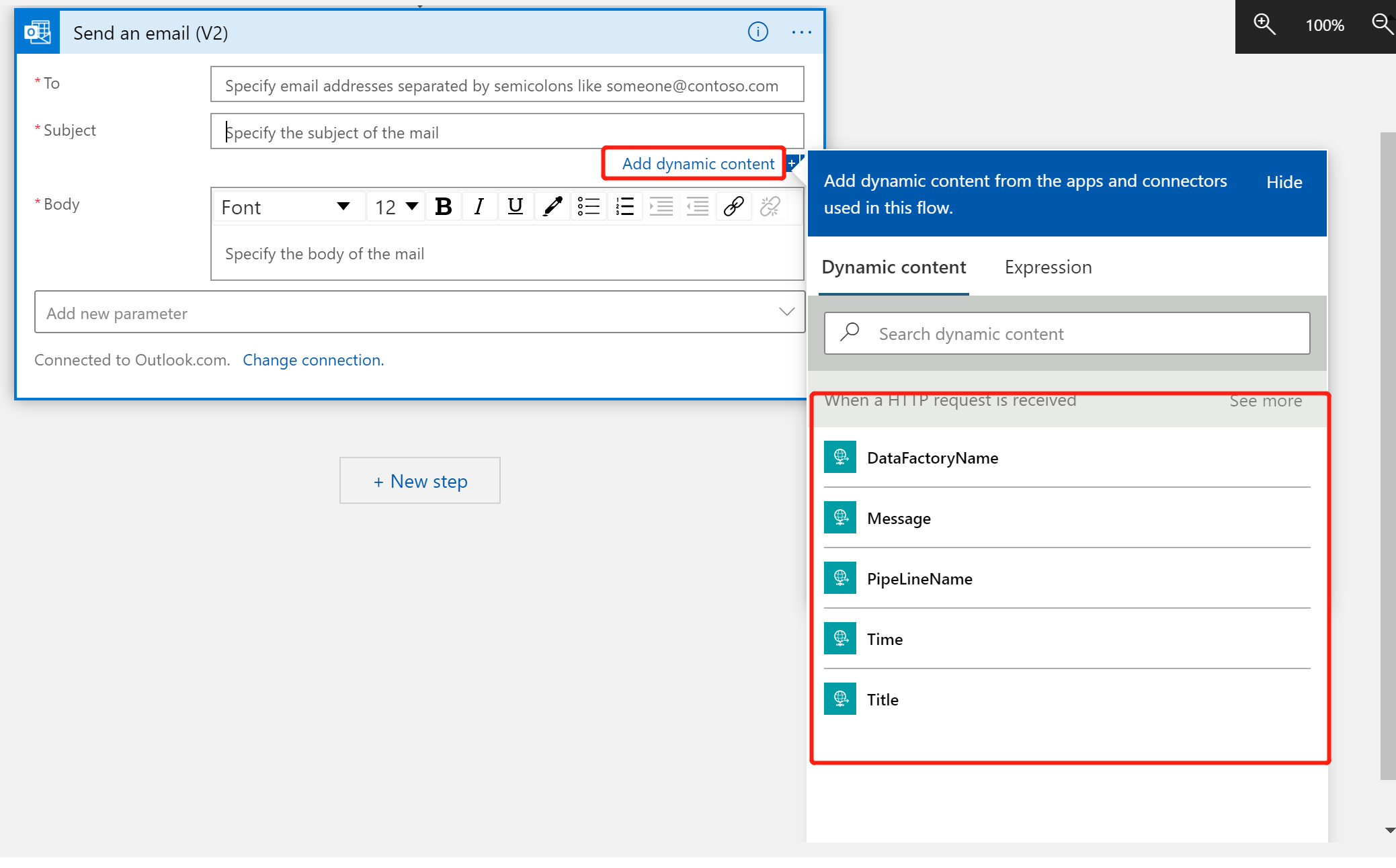

接下来就是发送邮件的一些邮件参数,大家可以参考之前我写的一篇 Logic App 入门

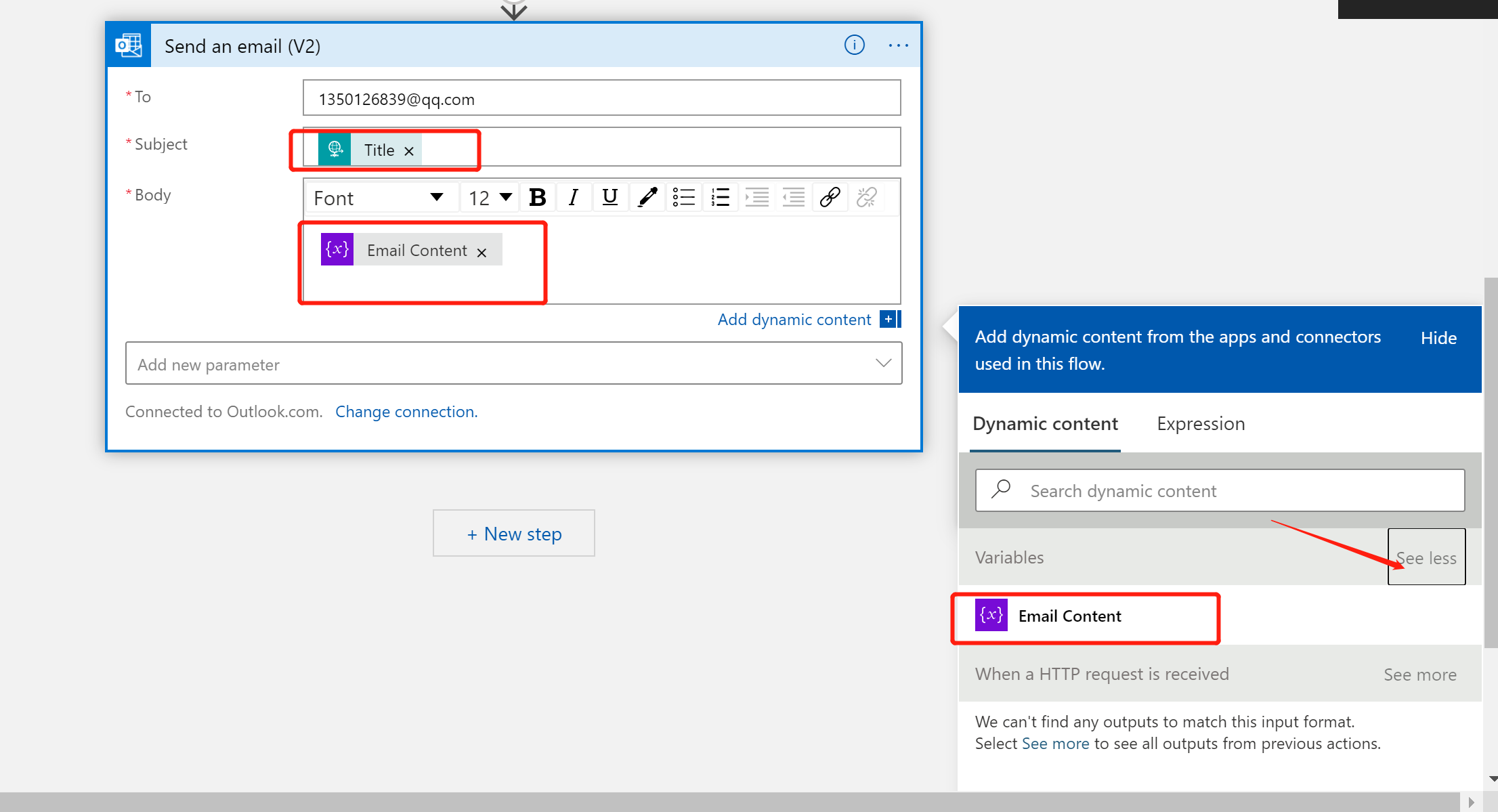

这里我将邮件发送到自己的QQ邮箱,Subject(主题)、Body(内容体)作为ADF参数化的一部分和刚刚初始化的参数的一部分,

主题 选择 动态参数 “title”

Body 选择刚刚初始化的参数 “Email Content”

配置完这些信息后,我们进行保存。

4,发送Pipeline 状态信息

我们回到ADF,点击 “Debug” 进行测试

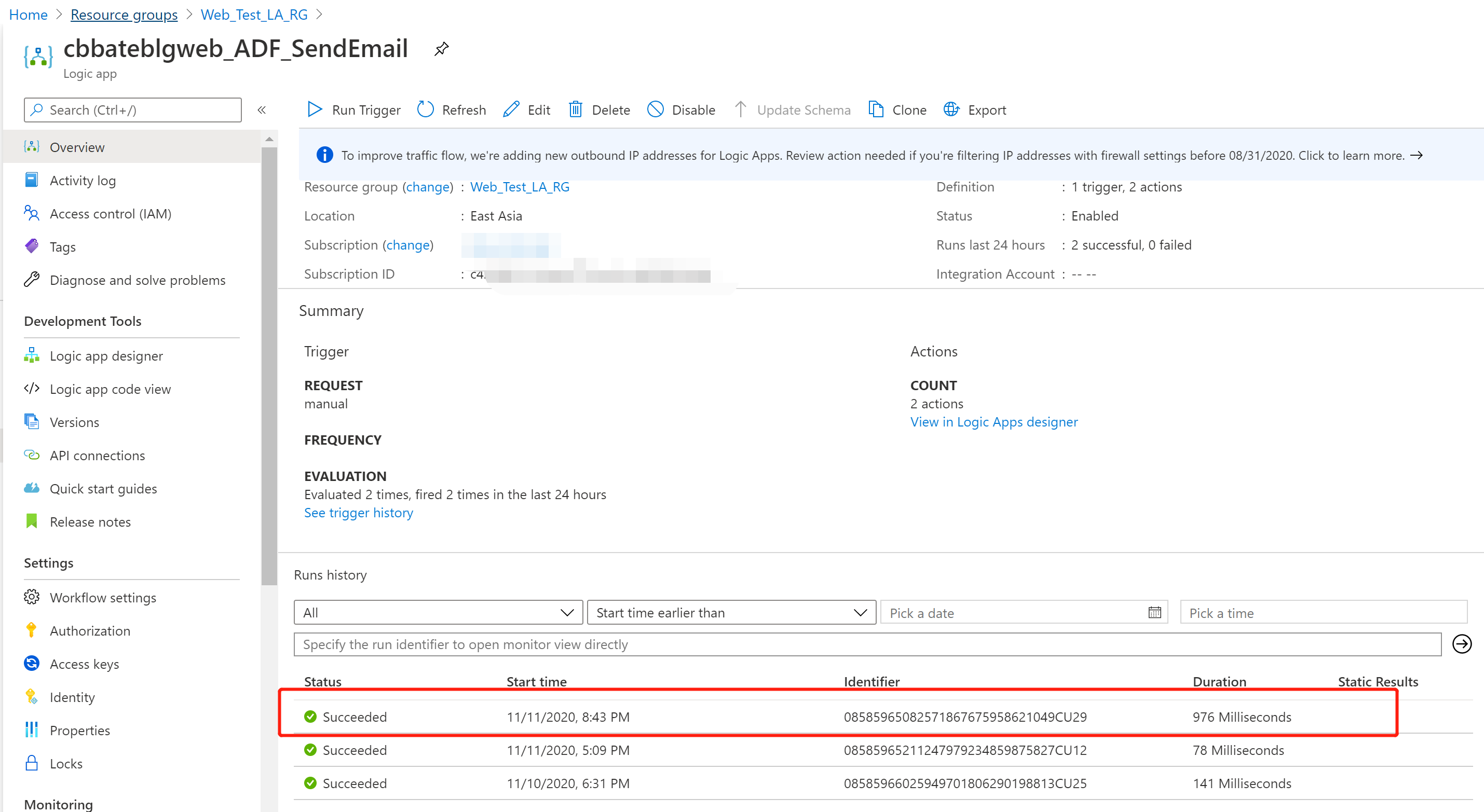

同时,我们也看看Logic App的运行状态

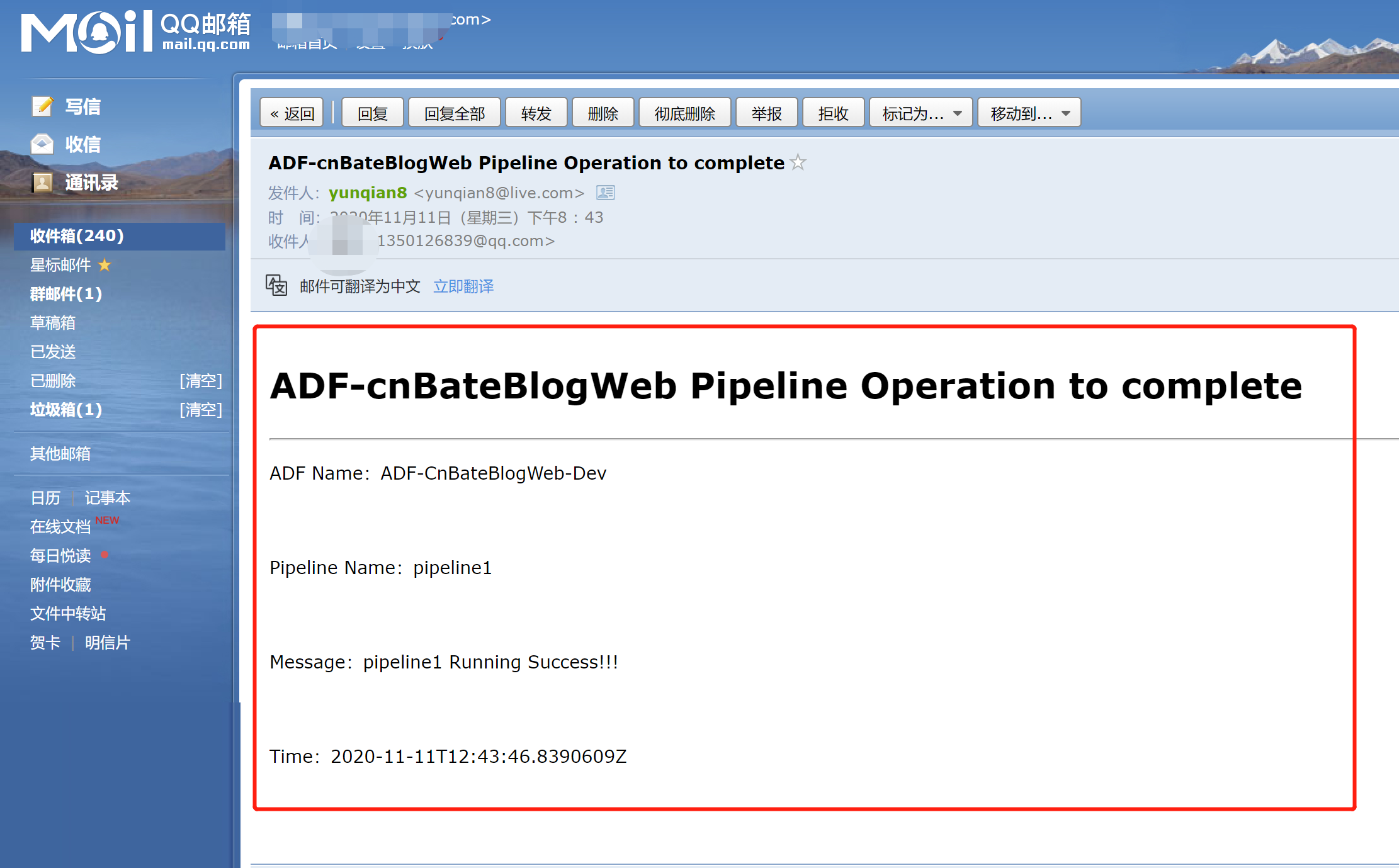

最关键的就是看看是否收到ADF pipelin 运行状态的监视邮件

BINGO!!!

Azure Data Factory(四)集成 Logic App 的邮件通知提醒的更多相关文章

- Azure Data Factory(五)Blob Storage 密钥管理问题

一,引言 之前讲解的ADF 集成Azure DevOps 实现CI/CD,在 Releases Pipeline 阶段,我们是将两个 Blob Storage 的链接字符串复制.粘贴到 "O ...

- Azure Data Factory(三)集成 Azure Devops 实现CI/CD

一,引言 由于上一节文章内容过长,无法分享Azure Data Factory 的持续集成,持续发布.今天将着重介绍一下在使用 Azure DevOps Pipeline 发布,自动进行持续集成,并且 ...

- Azure Data Factory(一)入门简介

一,引言 今天分享一个新的Azure 服务-----Azure Data Factory(Azure 数据工厂),怎么理解,参考根据官方解释-----数据工厂解释:大数据需要可以启用协调和操作过程以将 ...

- Azure Data Factory(二)复制数据

一,引言 上一篇主要只讲了Azure Data Factory的一些主要概念,今天开始新的内容,我们开始通过Azure DevOps 或者 git 管理 Azure Data Factory 中的源代 ...

- ADF 第一篇:Azure Data Factory介绍

Azure Data Factory(简写 ADF)是Azure的云ETL服务,简单的说,就是云上的SSIS.ADF是基于云的ETL,用于数据集成和数据转换,不需要代码,直接通过UI(code-fre ...

- Jenkins+PowerShell持续集成环境搭建(八)邮件通知

1. 默认邮件功能: Jenkins自带的邮件功能比较简单,配置如下: 设置默认发件人地址: 2. Email Extension Plugin 为了能够更加灵活地使用邮件功能,需要安装Email E ...

- Azure Logic App 入门(一)

一,引言 前两天看一个azure相关的题,接触到一个叫 “Azure Logic App” 的服务,刚好,今天抽空学习以下,顺便结合它做一篇入门的分析文章. 首先,我们得对它有个大概的认识,了解以下A ...

- 徒手打造基于Spark的数据工厂(Data Factory):从设计到实现

在大数据处理和人工智能时代,数据工厂(Data Factory)无疑是一个非常重要的大数据处理平台.市面上也有成熟的相关产品,比如Azure Data Factory,不仅功能强大,而且依托微软的云计 ...

- Dynamics 365 Online-使用Azure Logic App 与 Dynamics 365 集成

什么是Logic App? Azure Logic App 是微软发布的集成平台的产品,有助于生成,计划和自动完成工作流形式的流程,适合跨企业或组织集成,数据,系统和服务.与此同时,Logic App ...

随机推荐

- JVM 常见线上问题 → CPU 100%、内存泄露 问题排查

开心一刻 明明是个小 bug,但就是死活修不好,我特么心态崩了...... 前言 后文会从 Windows.Linux 两个系统来做示例展示,有人会有疑问了:为什么要说 Windows 版的 ? 目前 ...

- Hello World背后的事情

Hello World是不少人学习C++的第一项内容,代码看似简单,很多东西却涉及根本 #include <iostream> using namespace std; int main( ...

- install Wine + WeChat in Fedora 31

install Wine + WeChat in Fedora 31 dnf -y install dnf-plugins-core dnf config-manager --add-repo htt ...

- python简单实现论文查重(软工第一次项目作业)

前言 软件工程 https://edu.cnblogs.com/campus/gdgy/informationsecurity1812 作业要求 https://edu.cnblogs.com/cam ...

- java性能分析之火焰图

原由 最近因为kafka.zookeeper.ES和相关的Java应用的内存问题搞的头大,做运维将近4年,对Java调优.性能方面的知识了解的少之又少,是时候下定决心来对他多一个学习了.不能一口吃成一 ...

- python 使用pyinstaller打包程序

使用pyinstaller 打包.py脚本,在其他计算机可以直接运行,不需要python环境 安装pyinstaller库 pip install pystaller 打包程序 pyinstaller ...

- 【暑假集训】HZOI2019 Luogu P1006 传纸条 二三四维解法

写三次丢失两次,我谔谔,以后再不在博客园先保存我就去死 题目内容 洛谷链接 小渊和小轩是好朋友也是同班同学,他们在一起总有谈不完的话题.一次素质拓展活动中,班上同学被安排坐成一个\(m\)行.\(n\ ...

- 单调队列+线性dp题Watching Fireworks is Fun (CF372C)

一.Watching Fireworks is Fun(紫题) 题目:一个城镇有n个区域,从左到右1编号为n,每个区域之间距离1个单位距离节日中有m个烟火要放,给定放的地点ai,时间ti当时你在x,那 ...

- jdk、eclipse和idea安装

一.jdk下载与环境配置与IDEA 下载地址:http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-213315 ...

- Vue3 来了,Vue3 开源商城项目重构计划正式启动!

我打算用 Vue3 写一个商城项目,目前已经开始着手开发,测试完成后正式开源到 GitHub,让大家也可以用现成的 Vue3 大型商城项目源码来练练手. Vue 3.0 来了,我们该做些什么? Vue ...