Python爬虫_百度贴吧(title、url、image_url)

本爬虫以百度贴吧为例,爬取某个贴吧的【所有发言】以及对应发言详情中的【图片链接】

涉及:

- request 发送请求获取响应

- html 取消注释

- 通过xpath提取数据

- 数据保存

思路:

- 由于各贴吧发言的数量不一,因此通过观察url规律统一构造url列表进行遍历爬取,不具有可推广性,因此通过先找到【下一页】url,看某一页是否存在下一页url决定爬虫的停止与否

- 对初始url 进行while True,直到没有下一页url为止

- 发送请求获取响应

- 提取数据(标题列表、url列表、下一页url)

- 遍历url列表

- 对初始url 进行while True,直到没有下一页url为止

- 发送请求获取响应

- 提取数据(image_url_list、下一页url

- 保存数据

- 对初始url 进行while True,直到没有下一页url为止

- 遍历url列表

代码:

1 import requests

2 from lxml import etree

3 import json

4

5

6 class TieBaSpider:

7 def __init__(self):

8 self.proxies = {"http": "http://122.243.12.135:9000"} # 免费ip代理

9 self.start_url = "https://tieba.baidu.com/f?kw={}&ie=utf-8&pn=0"

10 self.headers = {

11 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.k36 (KHTML, like Gecko) "

12 "Chrome/86.0.4240.11"}

13

14 # 发送请求获取响应

15 def parse_url(self, url):

16 res = requests.get(url, headers=self.headers, proxies=self.proxies)

17 html_str = res.content.decode().replace(r"<!--", "''").replace(r"-->", "''") # 去除网页注释

18

19 return html_str

20

21 # 提取外层url内容列表

22 @staticmethod

23 def get_outer_content(html_str):

24 html = etree.HTML(html_str)

25 title_list = html.xpath("//a[@class='j_th_tit ']/text()")

26 url_list = html.xpath("//a[@class='j_th_tit ']/@href")

27 if len(html.xpath("//a[text()='下一页']/@href")) > 0:

28 next_url_outer = html.xpath("//a[text()='下一页'/@href")[0]

29 else:

30 next_url_outer = None

31

32 return title_list, url_list, next_url_outer

33

34 # 提取内层url内容列表

35 @staticmethod

36 def get_inner_content(html_str):

37 html = etree.HTML(html_str)

38 image_list = html.xpath("//img[@class='BDE_Image']/@src")

39

40 if len(html.xpath("//a[text()='下一页']/@href")) > 0:

41 next_url_inner = 'https://tieba.baidu.com' + html.xpath("//a[text()='下一页']/@href")[0]

42 else:

43 next_url_inner = None

44

45 return image_list, next_url_inner

46

47 # 保存数据

48 @staticmethod

49 def save(comment):

50 with open("tb.txt", "a", encoding="utf8") as f:

51 f.write(json.dumps(comment, ensure_ascii=False, indent=2)+"\n")

52

53 # 主函数

54 def run(self):

55 # 初始化保存数据的字典

56 comment = {}

57 # 构造 url

58 url = self.start_url.format("费德勒")

59 # 初始化外层循环条件

60 next_url_outer = url

61 while next_url_outer is not None: # 循环外层的每一页

62 html_str = self.parse_url(next_url_outer) # 发送请求,获取响应

63 title_list, url_list, next_url_outer = self.get_outer_content(html_str) # 提取数据(标题,下一页url)

64 i = 0

65 for url_inner in url_list: # 循环外层的某一页

66 image_list_all = [] # 初始化存放img_url的列表

67 url_inner = 'https://tieba.baidu.com' + url_inner # 构建url

68 image_list, next_url_inner = self.get_inner_content(self.parse_url(url_inner)) # 获取数据

69 image_list_all.extend(image_list)

70

71 while next_url_inner is not None: # 循环某一页上的某一个url

72 html_str = self.parse_url(next_url_inner)

73 image_list, next_url_inner = self.get_inner_content(html_str)

74 image_list_all.extend(image_list)

75

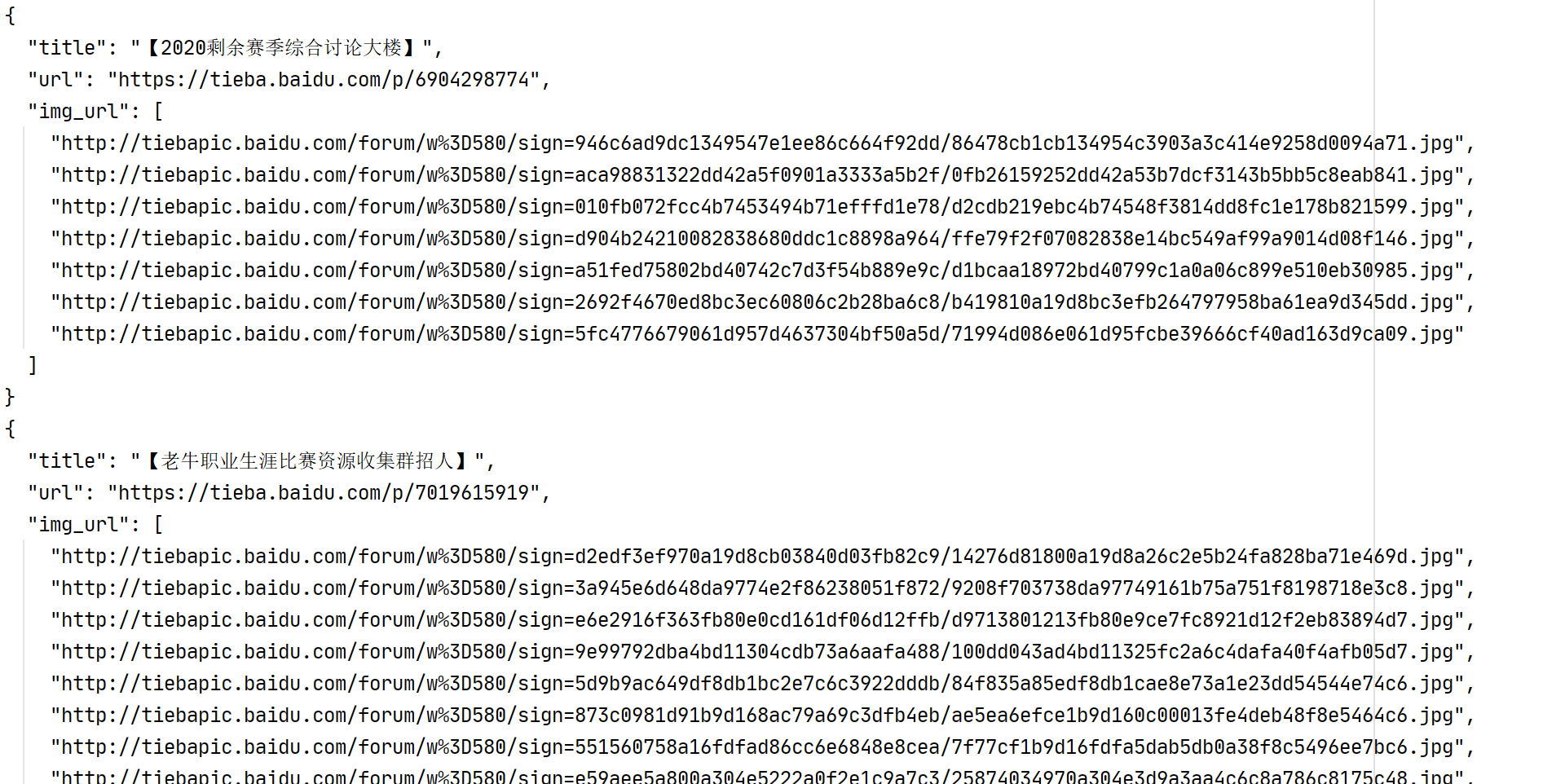

76 comment["title"] = title_list[i]

77 comment["url"] = url_inner

78 comment["img_url"] = image_list_all

79

80 self.save(comment)

81 i += 1

82 print("ok")

83

84

85 if __name__ == "__main__":

86 tb = TieBaSpider()

87 tb.run()

Python爬虫_百度贴吧(title、url、image_url)的更多相关文章

- Python爬虫_百度贴吧

# 本爬虫为爬取百度贴吧并存储HTMLimport requests class TiebaSpider: def __init__(self, tieba_name): self.tieba_nam ...

- 如何用Python爬虫实现百度图片自动下载?

Github:https://github.com/nnngu/LearningNotes 制作爬虫的步骤 制作一个爬虫一般分以下几个步骤: 分析需求 分析网页源代码,配合开发者工具 编写正则表达式或 ...

- python爬虫获取百度图片(没有精华,只为娱乐)

python3.7,爬虫技术,获取百度图片资源,msg为查询内容,cnt为查询的页数,大家快点来爬起来.注:现在只能爬取到百度的小图片,以后有大图片的方法,我会陆续发贴. #!/usr/bin/env ...

- 【转】Python爬虫_示例2

爬虫项目:爬取并筛选拉钩网职位信息自动提交简历 一 目标站点分析 #一:实验前准备: 浏览器用Chrome 用Ctrl+Shift+Delete清除浏览器缓存的Cookie 打开network准备 ...

- python爬虫_简单使用百度OCR解析验证码

百度技术文档 首先要注册百度云账号: 在首页,找到图像识别,创建应用,选择相应的功能,创建 安装接口模块: pip install baidu-aip 简单识别一: 简单图形验证码: 图片: from ...

- 利用Python爬虫实现百度网盘自动化添加资源

事情的起因是这样的,由于我想找几部经典电影欣赏欣赏,于是便向某老司机寻求资源(我备注了需要正规视频,绝对不是他想的那种资源),然后他丢给了我一个视频资源网站,说是比较有名的视频资源网站.我信以为真,便 ...

- 零基础Python爬虫实现(百度贴吧)

提示:本学习来自Ehco前辈的文章, 经过实现得出的笔记. 目标 http://tieba.baidu.com/f?kw=linux&ie=utf-8 网站结构 学习目标 由于是第一个实验性质 ...

- python爬虫_入门_翻页

写出来的爬虫,肯定不能只在一个页面爬,只要要爬几个页面,甚至一个网站,这时候就需要用到翻页了 其实翻页很简单,还是这个页面http://bbs.fengniao.com/forum/10384633. ...

- python爬虫_入门

本来觉得没什么可写的,因为网上这玩意一搜一大把,不过爬虫毕竟是python的一个大亮点,不说说感觉对不起这玩意基础点来说,python2写爬虫重点需要两个模块,urllib和urllib2,其实还有r ...

随机推荐

- Java 操作 HBase 教程

Java 操作 HBase 教程 一.简介 二.hbase-client 引入 三.连接操作 四.表操作 五.运行测试 相关博文原文地址: 博客园:美码师:HBase(2) Java 操作 HBase ...

- XSS、CSRF、SSRF联系&区别,防御

目录 区别和联系 防御 联系和区别 相同点: XSS,CSRF,SSRF三种常见的Web服务端漏洞均是由于,服务器端对用户提供的可控数据过于信任或者过滤不严导致的. 相同点: XSS,CSRF,SSR ...

- RIDE对应驱动下载

https://blog.csdn.net/apollolkj/article/details/75408237

- python格式转换的记录

Python的格式转换太难了. 与其说是难,具体来说应该是"每次都会忘记该怎么处理".所以于此记录,总的来说是编码+格式转换的记录. 本文记录环境:python3.6 经常见到的格 ...

- Java ArrayList源码分析(含扩容机制等重点问题分析)

写在最前面 这个项目是从20年末就立好的 flag,经过几年的学习,回过头再去看很多知识点又有新的理解.所以趁着找实习的准备,结合以前的学习储备,创建一个主要针对应届生和初学者的 Java 开源知识项 ...

- Web开发模型

1.服务器 web服务器:pc机器安装一个具有web服务的软件,称之位web服务器 数据库服务器:pc机器安装一个具有数据管理件服务的软件,称之为web服务器 邮件服务器:pc机器安装一个具有发送邮件 ...

- 通过SignalR技术整合即时通讯(IM)在.NET中应用落地

1.引言 即时通讯(IM)是RDIFramework.NET敏捷开发框架全新提供的一个基于Web的即时通讯.内部聊天沟通的工具.界面美观大方对于框架内部进行消息的沟通非常方便.基于RDIFramewo ...

- AtCoder Beginner Contest 171

比赛链接:https://atcoder.jp/contests/abc171/tasks A - αlphabet 题意 给出一个字母,如果为大写输出 'A',如果为小写输出 'a' . 代码 #i ...

- POJ 1743 Musical Theme【SAM】

POJ1743 Musical Theme 要找长度\(\ge 5\)且出现次数\(\ge 2\)并且第一次出现和最后一次出现不重叠的最长子串. 题目条件中,如果对于两个串,在一个串的每个数上都加上相 ...

- CodeForces 1119D(差分+前缀和+二分)

题意:给你一个数组,数组每次每个数都+1,有q次查询每一查询+L到+R中出现的所有不重复的数字个数. +L到+R其实就相当于是0到+(R-L+1) 感觉自己写的好啰嗦,直接上代码加注释: 1 #inc ...