MapReduce之自定义OutputFormat

@

OutputFormat接口实现类

OutputFormat是MapReduce输出的基类,所有实现MapReduce输出都实现了OutputFormat接口。下面介绍几种常见的OutputFormat实现类。

文本输出

TextoutputFormat

默认的输出格式是TextOutputFormat,它把每条记录写为文本行。它的键和值可以是任意类型,因为TextOutputFormat调用toString()方法把它们转换为字符串。SequenceFileOutputFormat

将SecquenceFileOutputFormat输出作为后续MapReduce任务的输入,这便是一种好的输出格式,因为它的格式紧凑,很容易被压缩。自定义OutputFormat

根据用户需求,自定义实现输出。

自定义OutputFormat使用场景及步骤

使用场景

- 为了实现控制最终文件的输出路径和输出格式,可以自定义OutputFormat。

例如:要在一个MapReduce程序中根据数据的不同输出两类结果到不同目录,这类灵活的输出需求可以通过自定义OutputFormat来实现。 - 自定义OutputFormat步骤

(1)自定义一个类继承FileOutputFormat。

(2)改写RecordWriter,具体改写输出数据的方法write()。

自定义OutputFormat 案例实操

需求

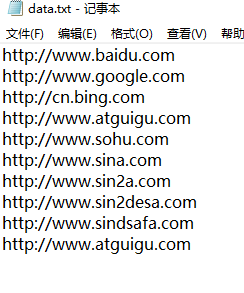

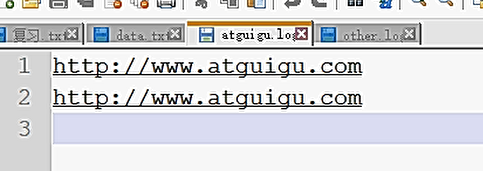

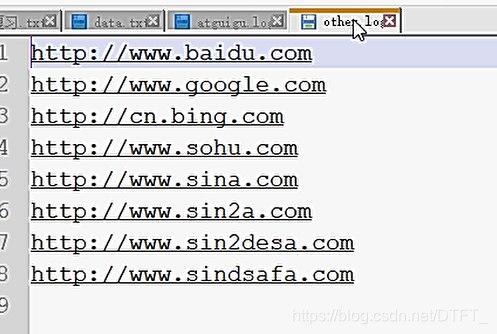

过滤输入的log日志,包含atguigu的网站输出到e:/atguigu.log,不包含atguigu的网站输出到e:/other.log。

输入数据

什么时候需要Reduce

①合并

②需要对数据排序

所以本案例不需要Reduce阶段,key-value不需要实现序列化

CustomOFMapper.java

public class CustomOFMapper extends Mapper<LongWritable, Text, String, NullWritable>{

@Override

protected void map(LongWritable key, Text value, Mapper<LongWritable, Text, String, NullWritable>.Context context) throws IOException, InterruptedException {

String content = value.toString();

//value不需要,但是不能用Null这个关键字,要使用NullWritable对象

context.write(content+"\r\n", NullWritable.get());

}

}

MyOutPutFormat.java

public class MyOutPutFormat extends FileOutputFormat<String, NullWritable>{

@Override

public RecordWriter<String, NullWritable> getRecordWriter(TaskAttemptContext job)

throws IOException, InterruptedException {

return new MyRecordWriter(job);//传递job对象,才能在RecordWriter中获取配置

}

}

MyRecordWriter.java

public class MyRecordWriter extends RecordWriter<String, NullWritable> {

private Path atguiguPath=new Path("e:/atguigu.log");

private Path otherPath=new Path("e:/other.log");

private FSDataOutputStream atguguOS ;

private FSDataOutputStream otherOS ;

private FileSystem fs;

private TaskAttemptContext context;

public MyRecordWriter(TaskAttemptContext job) throws IOException {

context=job;

Configuration conf = job.getConfiguration();

fs=FileSystem.get(conf);

atguiguOS = fs.create(atguiguPath);

otherOS = fs.create(otherPath);

}

// 将key-value写出到文件

@Override

public void write(String key, NullWritable value) throws IOException, InterruptedException {

if (key.contains("atguigu")) {

atguguOS.write(key.getBytes());//写到atguigu.log

//统计输出的含有atguigu字符串的key-value个数

context.getCounter("MyCounter", "atguiguCounter").increment(1);

}else {

otherOS.write(key.getBytes());//写到other.log

context.getCounter("MyCounter", "otherCounter").increment(1);

}

}

// 关闭流

@Override

public void close(TaskAttemptContext context) throws IOException, InterruptedException {

if (atguguOS != null) {

IOUtils.closeStream(atguguOS);

}

if (otherOS != null) {

IOUtils.closeStream(otherOS);

}

if (fs != null) {

fs.close();

}

}

}

CustomOFDriver.java

public class CustomOFDriver {

public static void main(String[] args) throws Exception {

Path inputPath=new Path("e:/mrinput/outputformat");

Path outputPath=new Path("e:/mroutput/outputformat");

//作为整个Job的配置

Configuration conf = new Configuration();

//保证输出目录不存在

FileSystem fs=FileSystem.get(conf);

if (fs.exists(outputPath)) {

fs.delete(outputPath, true);

}

// ①创建Job

Job job = Job.getInstance(conf);

//重点,设置为自定义的输出格式

job.setJarByClass(CustomOFDriver.class);

// ②设置Job

// 设置Job运行的Mapper,Reducer类型,Mapper,Reducer输出的key-value类型

job.setMapperClass(CustomOFMapper.class);

// 设置输入目录和输出目录

FileInputFormat.setInputPaths(job, inputPath);

FileOutputFormat.setOutputPath(job, outputPath);

// 设置输入和输出格式

job.setOutputFormatClass(MyOutPutFormat.class);

// 取消reduce阶段。设置为0,默认为1

job.setNumReduceTasks(0);

// ③运行Job

job.waitForCompletion(true);

}

}

输出文件:

MapReduce之自定义OutputFormat的更多相关文章

- 第3节 mapreduce高级:7、自定义outputformat实现输出到不同的文件夹下面

2.1 需求 现在有一些订单的评论数据,需求,将订单的好评与差评进行区分开来,将最终的数据分开到不同的文件夹下面去,数据内容参见资料文件夹,其中数据第九个字段表示好评,中评,差评.0:好评,1:中评, ...

- Hadoop案例(五)过滤日志及自定义日志输出路径(自定义OutputFormat)

过滤日志及自定义日志输出路径(自定义OutputFormat) 1.需求分析 过滤输入的log日志中是否包含xyg (1)包含xyg的网站输出到e:/xyg.log (2)不包含xyg的网站输出到e: ...

- Hadoop_27_MapReduce_运营商原始日志增强(自定义OutputFormat)

1.需求: 现有一些原始日志需要做增强解析处理,流程: 1. 从原始日志文件中读取数据(日志文件:https://pan.baidu.com/s/12hbDvP7jMu9yE-oLZXvM_g) 2. ...

- hadoop 自定义OutputFormat

1.继承FileOutputFormat,复写getRecordWriter方法 /** * @Description:自定义outputFormat,输出数据到不同的文件 */ public cla ...

- 关于spark写入文件至文件系统并制定文件名之自定义outputFormat

引言: spark项目中通常我们需要将我们处理之后数据保存到文件中,比如将处理之后的RDD保存到hdfs上指定的目录中,亦或是保存在本地 spark保存文件: 1.rdd.saveAsTextFile ...

- 关于MapReduce中自定义分区类(四)

MapTask类 在MapTask类中找到run函数 if(useNewApi){ runNewMapper(job, splitMetaInfo, umbilical, reporter ...

- 关于MapReduce中自定义分组类(三)

Job类 /** * Define the comparator that controls which keys are grouped together * for a single ...

- 关于MapReduce中自定义带比较key类、比较器类(二)——初学者从源码查看其原理

Job类 /** * Define the comparator that controls * how the keys are sorted before they * are pa ...

- 关于MapReduce中自定义Combine类(一)

MRJobConfig public static fina COMBINE_CLASS_ATTR 属性COMBINE_CLASS_ATTR = "mapreduce.j ...

随机推荐

- JavaScript学习 Ⅱ

五. JavaScript 数据类型 JavaScript 变量能够保存多种数据类型:数值.字符串值.数组.对象等等: var length = 7; // 数字 var lastName = &qu ...

- Producter and Consumer

package pinx.thread; import java.util.LinkedList; import java.util.Queue; public class ProducerConsu ...

- HotSpot的对象模型(5)

Java对象通过Oop来表示.Oop指的是 Ordinary Object Pointer(普通对象指针).在 Java 创建对象实例的时候创建,用于表示对象的实例信息.也就是说,在 Java 应用程 ...

- vue 仿掘金评论列表

先来个最终效果 代码: template代码: <template> <div class="main"> <div class="titl ...

- 3dTiles 数据规范详解[4.2] i3dm瓦片二进制数据文件结构

i3dm,即 Instanced 3D Model,实例三维模型的意思. 诸如树木.路灯.路边的垃圾桶.长椅等具有明显 重复 特征的数据.这类数据用得较少(笑,现在都喜欢搞BIM.倾斜摄影.精模.白模 ...

- Go的100天之旅-01初识Go

初识Go Go简介 Go的历史 上个世纪70年代Ken Thompson和Dennis M. Ritchie合作发明了UNIX操作系统同时Dennis M. Ritchie发明了C语言. 2007年的 ...

- 太实用了!自己动手写软件——SSH、FTP和SQL server的密码破解

我们的密码破解工具一共分为如下六个部分,前面四个部分我们都有在之前的文章中介绍过了 用户图形界面——GUI编程 密码字典获取——Excel文件读取 数据库类——MySQL.Oracle和SQL ser ...

- java面试题NIO与OIO的区别

面向流与面向缓冲 Java NIO和IO之间第一个最大的区别是,IO是面向流的,NIO是面向缓冲区的. Java IO面向流意味着每次从流中读一个或多个字节,直至读取所有字节,它们没有被缓存在任何地方 ...

- springmvc 重定向到外网地址

return new ModelAndView(new RedirectView("http://www.baidu.com"));

- tensorflow对鸢尾花进行分类——人工智能入门篇

tensorflow之对鸢尾花进行分类 任务目标 对鸢尾花数据集分析 建立鸢尾花的模型 利用模型预测鸢尾花的类别 环境搭建 pycharm编辑器搭建python3.* 第三方库 tensorflow1 ...