强化学习分布式经验回放框架(experience replay)reverb的安装

框架reverb的相关介绍:

https://www.cnblogs.com/devilmaycry812839668/p/16260799.html

==================================================

reverb框架为python语言环境下的,由于该框架需要和python和TensorFlow进行混合编译,因此需要用到python的libpython.so共享库,因此使用conda创建python环境就不是很好用了,这里的python环境采用从源码编译,具体参看:

https://www.cnblogs.com/devilmaycry812839668/p/16281134.html

这里采用python3.9的环境,并在 .bashrc 文件下配置python环境的变量:

export PATH=/home/devil/python3.9/bin:$PATH

export LD_LIBRARY_PATH=/home/devil/python3.9/lib:$LD_LIBRARY_PATH

安装TensorFlow,经过测试reverb暂时不支持TensorFlow=2.9.0版本,因此这里使用TensorFlow-2.8.0版本:

pip install tensorflow==2.8.0

安装reverb:

pip install dm-reverb

测试代码:

import reverb server = reverb.Server(tables=[

reverb.Table(

name='my_table',

sampler=reverb.selectors.Uniform(),

remover=reverb.selectors.Fifo(),

max_size=100,

rate_limiter=reverb.rate_limiters.MinSize(1)),

],

) client = reverb.Client(f'localhost:{server.port}')

print(client.server_info())

# Creates a single item and data element [0, 1].

client.insert([0, 1], priorities={'my_table': 1.0}) # Appends three data elements and inserts a single item which references all

# of them as {'a': [2, 3, 4], 'b': [12, 13, 14]}.

with client.trajectory_writer(num_keep_alive_refs=3) as writer:

writer.append({'a': 2, 'b': 12})

writer.append({'a': 3, 'b': 13})

writer.append({'a': 4, 'b': 14}) # Create an item referencing all the data.

writer.create_item(

table='my_table',

priority=1.0,

trajectory={

'a': writer.history['a'][:],

'b': writer.history['b'][:],

}) # Block until the item has been inserted and confirmed by the server.

writer.flush() print('...........')

# client.sample() returns a generator.

print(list(client.sample('my_table', num_samples=2)))

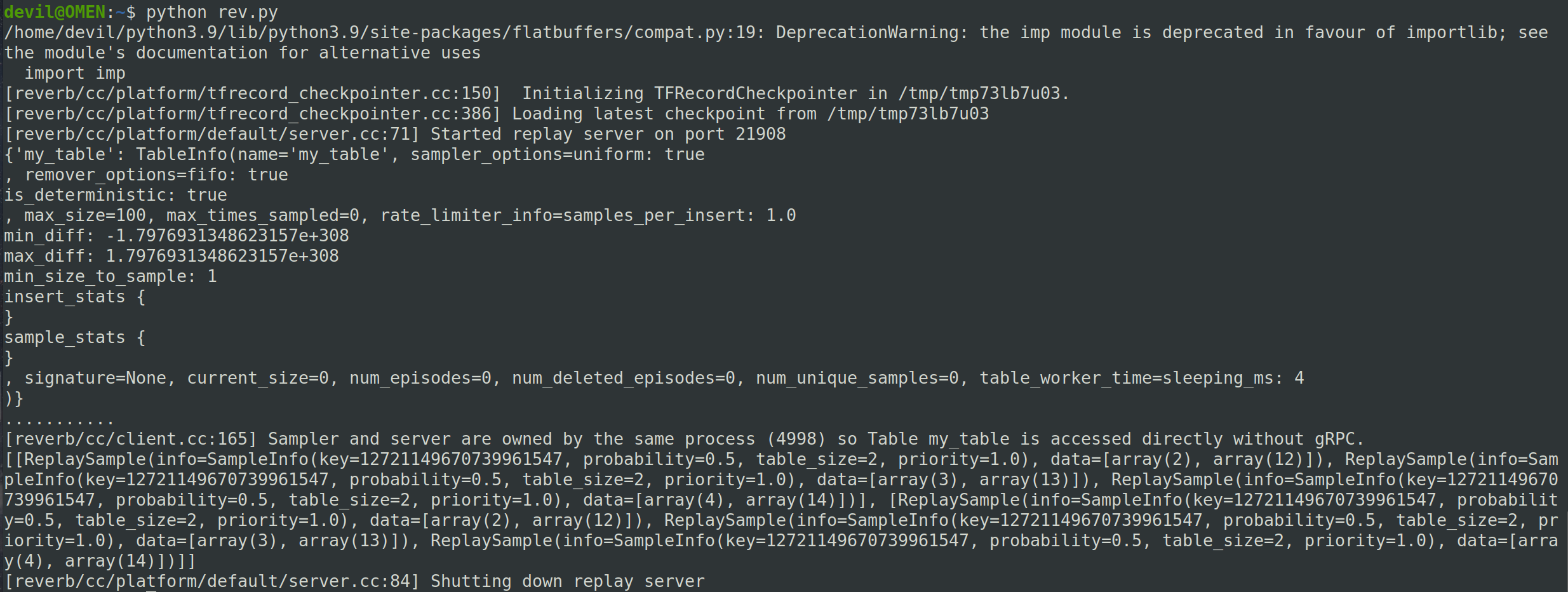

成功运行:

安装诀窍:

安装reverb第一点就是要注意python环境一定要有动态链接库.so文件并且路径中可以搜索到,使用conda的python环境一般都是静态库.a文件,因此这里我们使用的是源码编译python环境;

第二点就是TensorFlow的版本,因为我们pip方式安装的reverb都是编译好的而不是像其他库如numpy那种会下载后重新编译的,因此就需要安装与之对应的TensorFlow版本(官方编译reverb时候的TensorFlow版本),而这个信息我们往往是获得不到的,一个好的解决方法就是安装最新版的reverb然后从最新版的TensorFlow开始试,这里我们最新的TensorFlow版本是2.9.0,发现版本不匹配后直接换为2.8.0版本的TensorFlow就成功匹配最新版的reverb了。

============================================

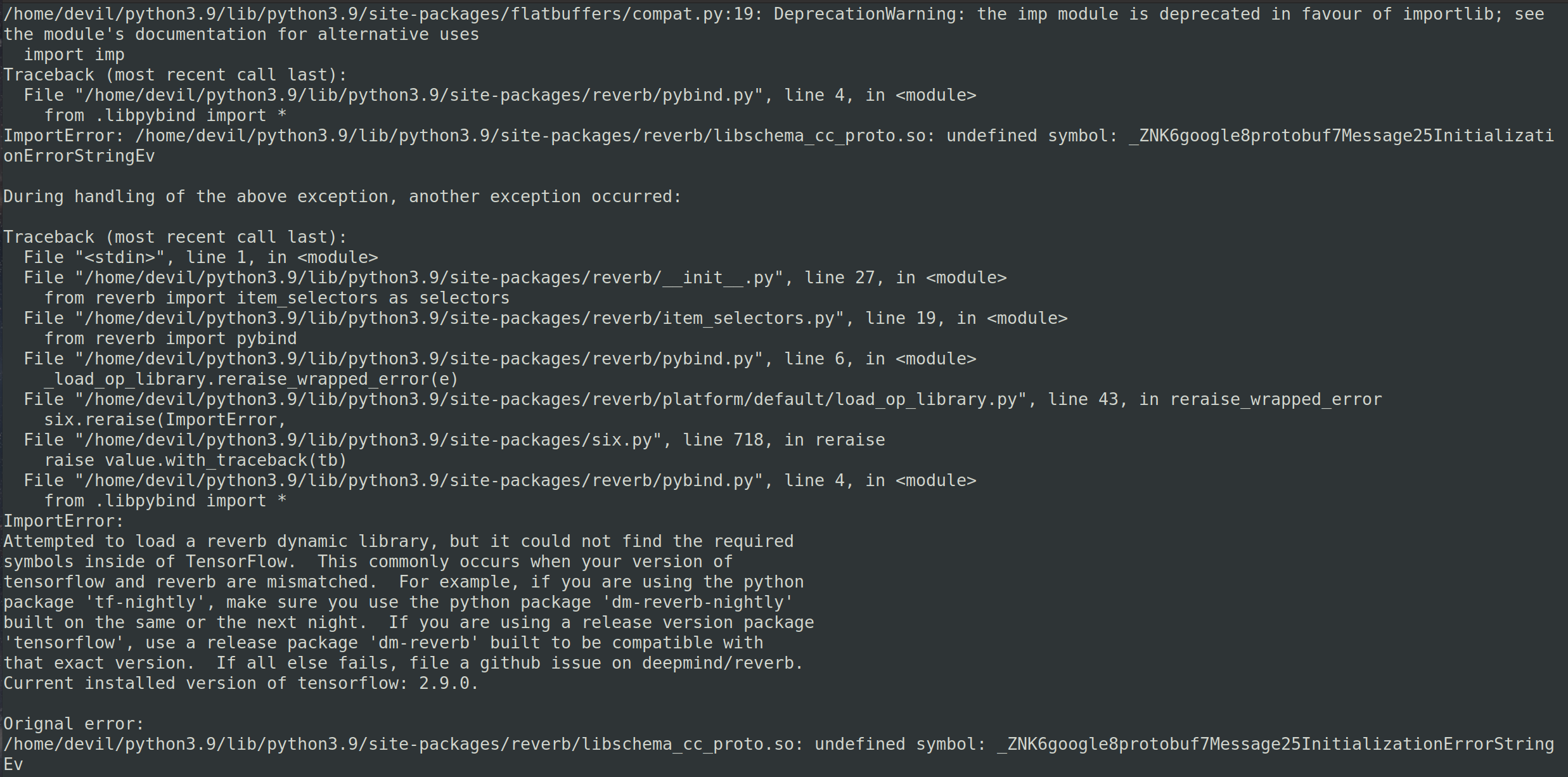

如果安装的是TensorFlow-2.9.0,那么安装reverb后运行则会报错:

这个错误大致意思就是说reverb编译时的TensorFlow和现在安装环境下的TensorFlow版本不同,这里安装的最新版本dm_reverb-0.7.3.dist-info,不支持TensorFlow-2.9.0但支持TensorFlow-2.8.0 。

================================================

强化学习分布式经验回放框架(experience replay)reverb的安装的更多相关文章

- 强化学习(十七) 基于模型的强化学习与Dyna算法框架

在前面我们讨论了基于价值的强化学习(Value Based RL)和基于策略的强化学习模型(Policy Based RL),本篇我们讨论最后一种强化学习流派,基于模型的强化学习(Model Base ...

- Flink + 强化学习 搭建实时推荐系统

如今的推荐系统,对于实时性的要求越来越高,实时推荐的流程大致可以概括为这样: 推荐系统对于用户的请求产生推荐,用户对推荐结果作出反馈 (购买/点击/离开等等),推荐系统再根据用户反馈作出新的推荐.这个 ...

- 强化学习(八)价值函数的近似表示与Deep Q-Learning

在强化学习系列的前七篇里,我们主要讨论的都是规模比较小的强化学习问题求解算法.今天开始我们步入深度强化学习.这一篇关注于价值函数的近似表示和Deep Q-Learning算法. Deep Q-Lear ...

- 【转】强化学习(一)Deep Q-Network

原文地址:https://www.hhyz.me/2018/08/05/2018-08-05-RL/ 1. 前言 虽然将深度学习和增强学习结合的想法在几年前就有人尝试,但真正成功的开端就是DeepMi ...

- 【转载】 强化学习(八)价值函数的近似表示与Deep Q-Learning

原文地址: https://www.cnblogs.com/pinard/p/9714655.html ------------------------------------------------ ...

- 强化学习(3)-----DQN

看这篇https://blog.csdn.net/qq_16234613/article/details/80268564 1.DQN 原因:在普通的Q-learning中,当状态和动作空间是离散且维 ...

- 强化学习之六:Deep Q-Network and Beyond

本文是对Arthur Juliani在Medium平台发布的强化学习系列教程的个人中文翻译,该翻译是基于个人分享知识的目的进行的,欢迎交流!(This article is my personal t ...

- 【论文研读】强化学习入门之DQN

最近在学习斯坦福2017年秋季学期的<强化学习>课程,感兴趣的同学可以follow一下,Sergey大神的,有英文字幕,语速有点快,适合有一些基础的入门生. 今天主要总结上午看的有关DQN ...

- 强化学习模型实现RL-Adventure

源代码:https://github.com/higgsfield/RL-Adventure 在Pytorch1.4.0上解决bug后的复现版本:https://github.com/lucifer2 ...

- DRL强化学习:

IT博客网 热点推荐 推荐博客 编程语言 数据库 前端 IT博客网 > 域名隐私保护 免费 DRL前沿之:Hierarchical Deep Reinforcement Learning 来源: ...

随机推荐

- mysql GROUP_CONCAT给每个值加上单引号后再拼接

经常使用group_concat拼接数值,但有一些中文在拼接时添加单引号会比较好, 该怎么操作呢? 可以使用如下语句,在字段前添加四个单引号和逗号,并在字段后也添加一个引号和四个单引号: 1 SELE ...

- vue安装及升级

先装好note.js 安装过程很简单,一直点下一步就ok了.1.1我们通过打开命令行工具(win+R),输入node -v查看node的版本,若出现相应的版本号说明你安装成功了 1.2.npm包管理器 ...

- Java对象转Map<String,String>

Java对象转Map<String,String> import org.springframework.beans.BeanUtils; import org.springframewo ...

- FinalReference 如何使 GC 过程变得拖拖拉拉

本文基于 OpenJDK17 进行讨论,垃圾回收器为 ZGC. 提示: 为了方便大家索引,特将在上篇文章 <以 ZGC 为例,谈一谈 JVM 是如何实现 Reference 语义的> 中讨 ...

- Linux特殊权限之SUID,SGID

SUID定义 暂时借用属主身份运行二进制程序.(SGID则是借用属组) 应用场景 某些用户在运行二进制程序的过程中,没有权限访问此二进制程序中其他的一些文件.给此用户过高的权限又不安全. 比如,每个用 ...

- Chrome插件:Postman Interceptor 调试的终极利器

今天给大家介绍一款非常实用的工具--Postman Interceptor. 这个工具可以捕捉任何网站的请求,并将其发送到Postman客户端. 对于经常和API打交道的程序员来说,Postman I ...

- Elastic-Search 整理(二):高级篇

ES高级篇 集群部署 集群的意思:就是将多个节点归为一体罢了,这个整体就有一个指定的名字了 window中部署集群 - 了解 把下载好的window版的ES中的data文件夹.logs文件夹下的所有的 ...

- python3 requests 请求https报错: urllib3.exceptions.SSLError: [SSL: SSLV3_ALERT_HANDSHAKE_FAILURE] sslv3 alert handshake failure (_ssl.c:992)

正文 代码示例: #-*- coding:utf-8 -*- import requests url = "https://tst.com" res = requests.get( ...

- 新版SpringBoot-Spring-Mybatis 数据库相关配置

application.properties server.port=8081 # ========================数据库相关配置===================== sprin ...

- 循环冗余检验CRC

先约定一个除数,除数根据生成多项式来决定,余数的位数就是除数位数减一,在被除数后面添加余数个0,然后进行运算. 注意虽然叫做除数被除数,但是是按位进行异或操作,相同为1,不同为0,最后的余数就叫帧检验 ...