部署ELK+filebeat收集nginx日志

前言

简介

ELK(Elasticsearch、Logstash、Kibana)是开源的实时日志收集分析解决方案。

- Elasticsearch:开源搜索引擎,是一个基于Lucene、分布式、通过Restful方式进行交互的近实时搜索平台框架。Elasticsearch为所有类型的数据提供近乎实时的搜索和分析。无论是结构化文本还是非结构化文本,数字数据或地理空间数据,Elasticsearch都能以支持快速搜索的方式有效地对其进行存储和索引。在ELK中负责日志分析与存储。

- Logstash:日志收集、过滤、转发的日志收集引擎。能够从多个来源采集数据,转换数据,然后将数据发送到“存储库”中。Logstash能够动态地采集、转换和传输数据,不受格式或复杂度的影响。在本文中负责接收处理filebeat的数据

- Kibana:负责页面可视化展示。

- Filebeat:日志数据采集

完整日志系统的基本特征:

- 收集:能够采集多种来源的日志数据

- 传输:能够稳定的把日志数据解析过滤并传输到存储系统

- 存储:存储日志数据

- 分析:支持UI分析

- 警告:能够提供错误报告,监控机制

部署位置

| IP | 应用 | 版本 | 说明 |

|---|---|---|---|

| 192.168.2.249 | elasticsearch | 7.5.1 | 日志分析和存储,简称“es” |

| 192.168.2.249 | logstash | 7.5.1 | 日志处理 |

| 192.168.2.249 | kibana | 7.5.1 | 数据可视化 |

| 192.168.2.249 | filebeat | 7.5.1 | 日志采集 |

| 192.168.2.249 | nginx | 1.21.5 | 日志源 |

步骤

准备工作

- 安装docker和docker-compose,可参考 博客园 - 花酒锄作田 - linux离线安装docker与compose

- docker拉取es、logstash和kibana的docker镜像(version 7.5.1)

- 下载filebeat的二进制程序压缩包(官方下载地址)

- 安装nginx

记录的一些命令(使用普通用户admin,有docker的使用权限)

# 拉取镜像

docker pull elasticsearch:7.5.1

docker pull logstash:7.5.1

docker pull kibana:7.5.1

# 准备数据和配置文件目录

mkdir -p $HOME/apps/{elasticsearch,logstash,kibana}

安装elasticsearch

- 编辑

es-compose.yaml

version: '3'

services:

elasticsearch:

image: elasticsearch:7.5.1

container_name: es

environment:

- discovery.type=single-node

- bootstrap.memory_lock=true

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

ulimits:

memlock:

soft: -1

hard: -1

hostname: elasticsearch

ports:

- "9200:9200"

- "9300:9300"

- 创建docker容器

docker-compose -f es-compose.yaml

- 从容器中复制一些配置

docker cp es:/usr/share/elasticsearch/data $HOME/apps/elasticsearch

docker cp es:/usr/share/elasticsearch/config $HOME/apps/elasticsearch

docker cp es:/usr/share/elasticsearch/modules $HOME/apps/elasticsearch

docker cp es:/usr/share/elasticsearch/plugins $HOME/apps/elasticsearch

- 修改es-compose.yaml(主要用于挂载数据持久化目录)

version: '3'

services:

elasticsearch:

image: elasticsearch:7.5.1

container_name: es

environment:

- discovery.type=single-node

- bootstrap.memory_lock=true

- "ES_JAVA_OPTS=-Xms1024m -Xmx1024m"

ulimits:

memlock:

soft: -1

hard: -1

volumes:

- /etc/localtime:/etc/localtime:ro

- /etc/timezone:/etc/timezone:ro

- /home/admin/apps/elasticsearch/modules:/usr/share/elasticsearch/modules

- /home/admin/apps/elasticsearch/plugins:/usr/share/elasticsearch/plugins

- /home/admin/apps/elasticsearch/data:/usr/share/elasticsearch/data

- /home/admin/apps/elasticsearch/config:/usr/share/elasticsearch/config

hostname: elasticsearch

ports:

- "9200:9200"

- "9300:9300"

- 重新启动

docker-compose -f es-compose.yaml up -d

安装logstash

- 编辑logstash-compose.yaml

version: '3'

services:

logstash:

image: logstash:7.5.1

container_name: logstash

hostname: logstash

ports:

- "5044:5044"

- 启动docker容器

docker-compose -f logstash-compose.yaml up -d

- 从docker容器中复制配置

docker cp logstash:/usr/share/logstash/config $HOME/apps/logstash

docker cp logstash:/usr/share/logstash/pipeline $HOME/apps/logstash

- 修改

$HOME/apps/logstash.config/logstash.yml,示例如下

http.host: "0.0.0.0"

xpack.monitoring.elasticsearch.hosts: [ "http://192.168.2.249:9200" ]

- 修改

$HOME/apps/logstash/pipeline/logstash.conf

input {

beats {

port => 5044

codec => "json"

}

}

output {

elasticsearch {

hosts => ["http://192.168.2.249:9200"]

index => "logstash-nginx-%{[@metadata][version]}-%{+YYYY.MM.dd}"

}

}

- 修改logstash-compose.yaml

version: '3'

services:

logstash:

image: logstash:7.5.1

container_name: logstash

hostname: logstash

ports:

- "5044:5044"

volumes:

- /etc/localtime:/etc/locatime:ro

- /etc/timezone:/etc/timezone:ro

- /home/admin/apps/logstash/pipeline:/usr/share/logstash/pipeline

- /home/admin/apps/logstash/config:/usr/share/logstash/config

- 重新启动

docker-compose -f logstash-compose.yaml up -d

安装kibana

- 编辑kibana-compose.yaml

version: '3'

services:

kibana:

image: kibana:7.5.1

container_name: kibana

hostname: kibana

ports:

- "5601:5601"

- 启动

docker-compose -f kibana-compose.yaml up -d

- 从docker容器中复制配置

docker cp kibana:/usr/share/kibana/config $HOME/apps/kibana

- 修改

$HOME/apps/kibana/config/kibana.yml,修改es地址和指定中文

server.name: kibana

server.host: "0"

elasticsearch.hosts: [ "http://192.168.2.249:9200" ]

xpack.monitoring.ui.container.elasticsearch.enabled: true

i18n.locale: "zh-CN"

- 修改kibana-compose.yaml

version: '3'

services:

kibana:

image: kibana:7.5.1

container_name: kibana

hostname: kibana

ports:

- "5601:5601"

volumes:

- /etc/localtime:/etc/locatime:ro

- /etc/timezone:/etc/timezone:ro

- /home/admin/apps/kibana/config:/usr/share/kibana/config

- 重新启动

docker-compose -f kibana-compose.yaml up -d

修改nginx日志格式

log_format json '{"@timestamp": "$time_iso8601", '

'"connection": "$connection", '

'"remote_addr": "$remote_addr", '

'"remote_user": "$remote_user", '

'"request_method": "$request_method", '

'"request_uri": "$request_uri", '

'"server_protocol": "$server_protocol", '

'"status": "$status", '

'"body_bytes_sent": "$body_bytes_sent", '

'"http_referer": "$http_referer", '

'"http_user_agent": "$http_user_agent", '

'"http_x_forwarded_for": "$http_x_forwarded_for", '

'"request_time": "$request_time"}';

在http块中设置:access_log logs/access.log json;

安装filebeat

- 假设filebeat的压缩包已下载并解压,解压和重命名之后,二进制文件所在目录为

/home/admin/apps/filebeat - 编辑

filebeat.yaml,找到以下内容,取消输出到es,改为输出到logstash,示例:

#-------------------------- Elasticsearch output ------------------------------

#output.elasticsearch:

# Array of hosts to connect to.

#hosts: ["localhost:9200"]

# Optional protocol and basic auth credentials.

#protocol: "https"

#username: "elastic"

#password: "changeme"

#----------------------------- Logstash output --------------------------------

output.logstash:

# The Logstash hosts

hosts: ["192.168.2.249:5044"]

- 启用nginx模块

./filebeat modules enable nginx

- 配置nginx模块。修改

./modules.d/nginx.yml,主要修改nginx日志的路径,示例如下

# Module: nginx

# Docs: https://www.elastic.co/guide/en/beats/filebeat/7.5/filebeat-module-nginx.html

- module: nginx

# Access logs

access:

enabled: true

# Set custom paths for the log files. If left empty,

# Filebeat will choose the paths depending on your OS.

var.paths: ["/home/admin/apps/nginx/logs/*access.log"]

# Error logs

error:

enabled: true

# Set custom paths for the log files. If left empty,

# Filebeat will choose the paths depending on your OS.

var.paths: ["/home/admin/apps/nginx/logs/*error.log"]

- 检查配置

./filebeat test config

./filebeat test output

- 验证通过后,启动

nohup ./filebeat -e -c ./filebeat.yml > /dev/null 2>&1 &

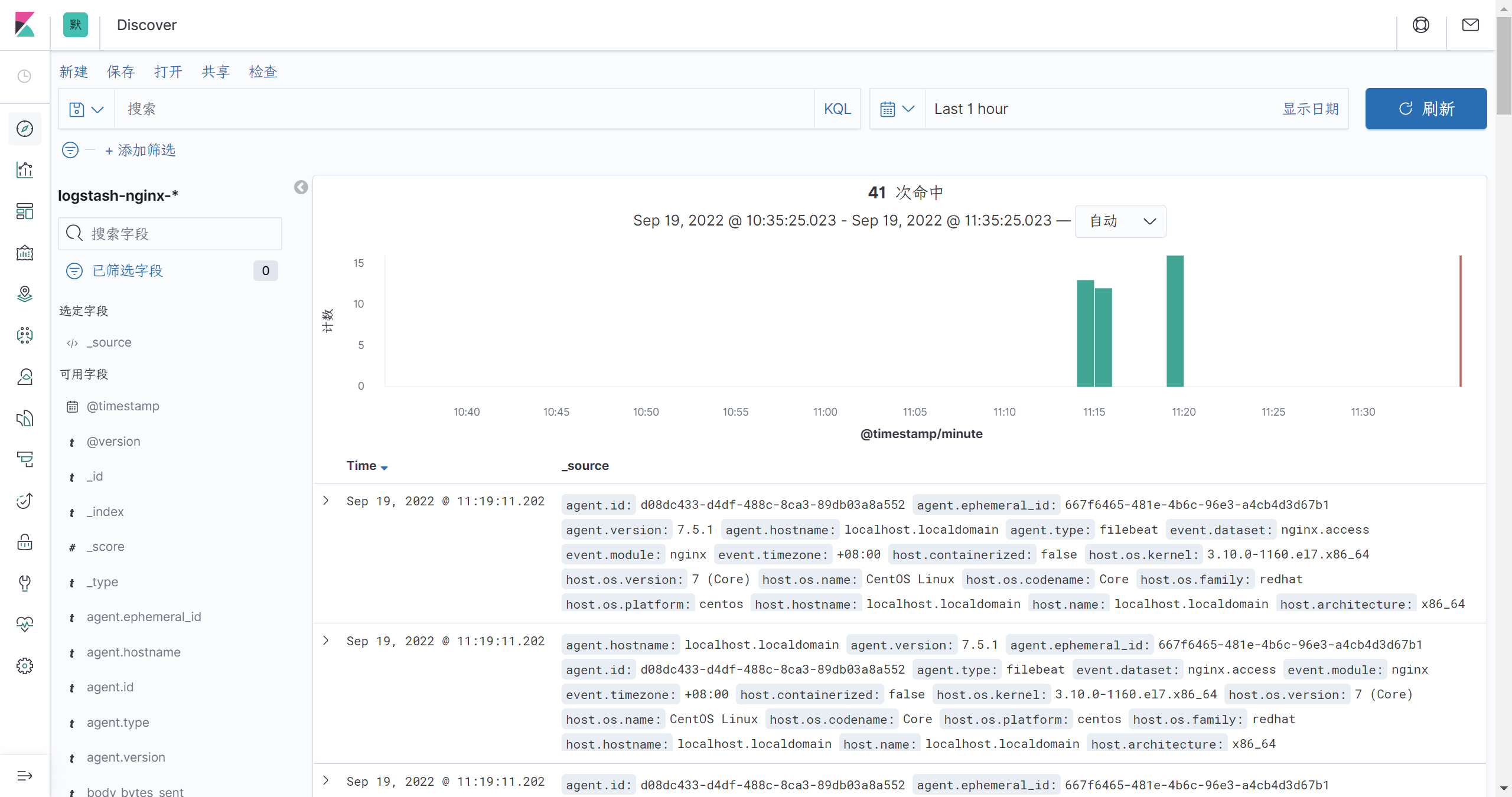

kibana展示

- 打开kibana的web页面,端口5061

- 打开左侧菜单栏的设置(management) - 索引模式 - 创建索引模式

- 输入

logstash-nginx-*,点击下一步(如果点不了,选择timestamp) - 打开左侧菜单栏的discover,选择

logstash-nginx-*就可以试试查看nginx输出日志了

参考资料

- 搞懂ELK并不是一件特别难的事

- 王小东:《Nginx应用与运维实战》

部署ELK+filebeat收集nginx日志的更多相关文章

- ELK Stack (2) —— ELK + Redis收集Nginx日志

ELK Stack (2) -- ELK + Redis收集Nginx日志 摘要 使用Elasticsearch.Logstash.Kibana与Redis(作为缓冲区)对Nginx日志进行收集 版本 ...

- Kubernetes实战之部署ELK Stack收集平台日志

主要内容 1 ELK概念 2 K8S需要收集哪些日志 3 ELK Stack日志方案 4 容器中的日志怎么收集 5 K8S平台中应用日志收集 准备环境 一套正常运行的k8s集群,kubeadm安装部署 ...

- ELK日志系统之使用Rsyslog快速方便的收集Nginx日志

常规的日志收集方案中Client端都需要额外安装一个Agent来收集日志,例如logstash.filebeat等,额外的程序也就意味着环境的复杂,资源的占用,有没有一种方式是不需要额外安装程序就能实 ...

- ELK整合Filebeat监控nginx日志

ELK 日志分析 1. 为什么用到 ELK 一般我们需要进行日志分析场景:直接在日志文件中 grep. awk 就可以获得自己想要的信息.但在规模较大的场景中,此方法效率低下,面临问题包括日志量太大如 ...

- ELK 二进制安装并收集nginx日志

对于日志来说,最常见的需求就是收集.存储.查询.展示,开源社区正好有相对应的开源项目:logstash(收集).elasticsearch(存储+搜索).kibana(展示),我们将这三个组合起来的技 ...

- ELK学习实验018:filebeat收集docker日志

Filebeat收集Docker日志 1 安装docker [root@node4 ~]# yum install -y yum-utils device-mapper-persistent-data ...

- ELK学习实验016:filebeat收集tomcat日志

filebeat收集tomcat日志 1 安装tomcat [root@node4 ~]# yum -y install tomcat tomcat-webapps tomcat-admin-weba ...

- ELK filter过滤器来收集Nginx日志

前面已经有ELK-Redis的安装,此处只讲在不改变日志格式的情况下收集Nginx日志. 1.Nginx端的日志格式设置如下: log_format access '$remote_addr - $r ...

- Docker 部署 elk + filebeat

Docker 部署 elk + filebeat kibana 开源的分析与可视化平台logstash 日志收集工具 logstash-forwarder(原名lubmberjack)elastics ...

- ELK+FileBeat+Log4Net搭建日志系统

ELK+FileBeat+Log4Net搭建日志系统 来源:https://www.zybuluo.com/muyanfeixiang/note/608470 标签(空格分隔): ELK Log4Ne ...

随机推荐

- PaddlePaddle 自动求导

自动求导 在 PaddlePaddle 中使用自动求导来计算导数. 要求:$ f(x)=\sin{x} $,绘制 \(f(x)\) 和 \(\dfrac{\mathrm{d}f(x)}{\mathrm ...

- 2022-08-12:方案1 : {7, 10}; xxxx : {a , b}; 1 2 3 4; FunnyGoal = 100; OffenseGoal = 130。 找到一个最少方案数,让Fu

2022-08-12:方案1 : {7, 10}: xxxx : {a , b}: 1 2 3 4: FunnyGoal = 100: OffenseGoal = 130. 找到一个最少方案数,让Fu ...

- 2022-07-30:以下go语言代码输出什么?A:[]byte{} []byte;B:[]byte{} []uint8;C:[]uint8{} []byte;D:[]uin8{} []uint8。

2022-07-30:以下go语言代码输出什么?A:[]byte{} []byte:B:[]byte{} []uint8:C:[]uint8{} []byte:D:[]uin8{} []uint8. ...

- 2022-01-01:给定int[][] meetings,比如 { {66, 70} 0号会议截止时间66,获得收益70 {25, 90} 1号会议截止时间25,获得收益90

2022-01-01:给定int[][] meetings,比如 { {66, 70} 0号会议截止时间66,获得收益70 {25, 90} 1号会议截止时间25,获得收益90 {50, 30} 2号 ...

- 使用4G通信模块和MQTT协议,完成物联网设备开发。

使用4G通信模块和MQTT协议,完成物联网设备开发. (1)安装并使用4G模块通信模块,建立microPython开发环境: (2)使用提供的Demo开发例程,使用MQTT传输协议连接阿里或腾讯网站, ...

- jmeter跨线程组引用变量的3种方法

利用BeanShell后置处理程序将参数设置为全局变量,用于跨线程传参(注:1.把提取变量的线程组放到引用变量的线程组前2.在测试计划中勾选"独立运行每个线程组") 方法1(jme ...

- AcWing 1230. K倍区间

给定一个长度为 N 的数列,A1,A2,-AN,如果其中一段连续的子序列 Ai,Ai+1,-Aj 之和是 K 的倍数,我们就称这个区间 [i,j] 是 K倍区间. 你能求出数列中总共有多少个 K倍区间 ...

- 【RocketMQ】NameServer总结

NameServer是一个注册中心,提供服务注册和服务发现的功能.NameServer可以集群部署,集群中每个节点都是对等的关系(没有像ZooKeeper那样在集群中选举出一个Master节点),节点 ...

- 【HarmonyOS】元服务和APP的相互跳转、相互成就

[关键字] 卡片.跳转.加桌 [背景介绍] 随着鸿蒙生态的发展,各种类型的应用都已经可以在Harmony OS上无差异的运行,面对鸿蒙新兴元服务的兴起,各大厂家可能都在考虑一个问题:如果已经有AP ...

- 如何批量修改 GitHub 代码提交作者

批量修改 GitHub 代码提交作者需要进行以下步骤: 首先,你需要 clone 远程仓库到本地,使用以下命令: git clone <repository-url> ``` 将 `< ...