12-UA池和代理池

一、UA池和代理池

1、UA池

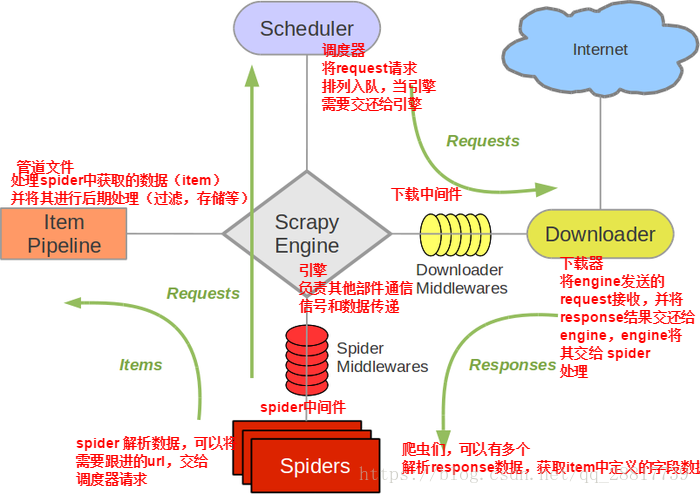

scrapy的下载中间件:

下载中间件(Downloader Middlewares) 位于scrapy引擎和下载器之间的一层组件。

作用:

(1)引擎将请求传递给下载器过程中, 下载中间件可以对请求进行一系列处理。比如设置请求的 User-Agent,设置代理等

(2)在下载器完成将Response传递给引擎中,下载中间件可以对响应进行一系列处理。比如进行gzip解压等。

我们主要使用下载中间件处理请求,一般会对请求设置随机的User-Agent ,设置随机的代理。目的在于防止爬取网站的反爬虫策略。

UA池作用:尽可能多的将scrapy框架中的请求伪装成不同类型的浏览器以及不同电脑的身份。

- 操作流程:

1.下载中间件中拦截请求

2.将拦截到的请求的请求头信息中的UA进行伪装

3.在配置文件中开启下载中间件

代码展示:(只需要看proccess_request方法)

# -*- coding: utf-8 -*- # Define here the models for your spider middleware

#

# See documentation in:

# https://docs.scrapy.org/en/latest/topics/spider-middleware.html from scrapy import signals

from scrapy.http import HtmlResponse

import random

from time import sleep class WangyixinwenDownloaderMiddleware(object):

# Not all methods need to be defined. If a method is not defined,

# scrapy acts as if the downloader middleware does not modify the

# passed objects.

user_agent_list = [

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.1 "

"(KHTML, like Gecko) Chrome/22.0.1207.1 Safari/537.1",

"Mozilla/5.0 (X11; CrOS i686 2268.111.0) AppleWebKit/536.11 "

"(KHTML, like Gecko) Chrome/20.0.1132.57 Safari/536.11",

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.6 "

"(KHTML, like Gecko) Chrome/20.0.1092.0 Safari/536.6",

"Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.6 "

"(KHTML, like Gecko) Chrome/20.0.1090.0 Safari/536.6",

"Mozilla/5.0 (Windows NT 6.2; WOW64) AppleWebKit/537.1 "

"(KHTML, like Gecko) Chrome/19.77.34.5 Safari/537.1",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/536.5 "

"(KHTML, like Gecko) Chrome/19.0.1084.9 Safari/536.5",

"Mozilla/5.0 (Windows NT 6.0) AppleWebKit/536.5 "

"(KHTML, like Gecko) Chrome/19.0.1084.36 Safari/536.5",

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.3 "

"(KHTML, like Gecko) Chrome/19.0.1063.0 Safari/536.3",

"Mozilla/5.0 (Windows NT 5.1) AppleWebKit/536.3 "

"(KHTML, like Gecko) Chrome/19.0.1063.0 Safari/536.3",

"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_8_0) AppleWebKit/536.3 "

"(KHTML, like Gecko) Chrome/19.0.1063.0 Safari/536.3",

"Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.3 "

"(KHTML, like Gecko) Chrome/19.0.1062.0 Safari/536.3",

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.3 "

"(KHTML, like Gecko) Chrome/19.0.1062.0 Safari/536.3",

"Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.3 "

"(KHTML, like Gecko) Chrome/19.0.1061.1 Safari/536.3",

"Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/536.3 "

"(KHTML, like Gecko) Chrome/19.0.1061.1 Safari/536.3",

"Mozilla/5.0 (Windows NT 6.1) AppleWebKit/536.3 "

"(KHTML, like Gecko) Chrome/19.0.1061.1 Safari/536.3",

"Mozilla/5.0 (Windows NT 6.2) AppleWebKit/536.3 "

"(KHTML, like Gecko) Chrome/19.0.1061.0 Safari/536.3",

"Mozilla/5.0 (X11; Linux x86_64) AppleWebKit/535.24 "

"(KHTML, like Gecko) Chrome/19.0.1055.1 Safari/535.24",

"Mozilla/5.0 (Windows NT 6.2; WOW64) AppleWebKit/535.24 "

"(KHTML, like Gecko) Chrome/19.0.1055.1 Safari/535.24"

]

# 代理池

PROXY_http = [

'153.180.102.104:80',

'195.208.131.189:56055',

]

PROXY_https = [

'120.83.49.90:9000',

'95.189.112.214:35508',

] def process_request(self, request, spider):

"""

在这里可以设置UA,如果要设置IP就需要等自己IP出现问题再前去process_exception中设置代理IP

但最后一定要返回request对象

:param request:

:param spider:

:return:

"""

# ua = random.choice(self.user_agent_list)#随机选择一个元素(反爬策略(即不同浏览器和机型))出来

# request.headers["User-Agent"] = ua

#return request#将修正的request对象重新进行发送

return None def process_response(self, request, response, spider):

#刚才响应体缺失,因此从这里我们应该重新返回新的响应体

#这里要用到爬虫程序中的urls,判断url是否在里面,在urls里面的就会出现响应缺失,

# 、因此需要返回新的响应体

if request.url in spider.urls:

#响应缺失是因为是动态加载数据,因此我们配合selenium使用

#在这里实例化selenium的话会被实例化多次,然而selenium只需要实例化一次,

#这个时候我们可以将selenium放在实例化一次的爬虫程序开始的时候,实例化完成引入

sleep(2)

bro = spider.bro.get(url=request.url)#浏览器中发送请求

sleep(1)

spider.bro.execute_script("window.scrollTo(0,document.body.scrollHeight)")

sleep(1.5)

spider.bro.execute_script("window.scrollTo(0,document.body.scrollHeight)")

sleep(0.7)

spider.bro.execute_script("window.scrollTo(0,document.body.scrollHeight)")

sleep(1)

spider.bro.execute_script("window.scrollTo(0,document.body.scrollHeight)")

#发送到请求我们需要获取浏览器当前页面的源码数据 获取数据之前需要翻滚页面

page_text = spider.bro.page_source

#改动返回响应对象 scrapy提供了一个库url=spider.bro.current_url, body=page_text, encoding='utf-8', request=request

new_response = HtmlResponse(url=request.url,body=page_text,encoding="utf-8",request=request)

return new_response

else:

return response

#提交完新的响应体之后,去设置将下载中间件打开 def process_exception(self, request, exception, spider):

# Called when a download handler or a process_request()

# (from other downloader middleware) raises an exception. # Must either:

# - return None: continue processing this exception

# - return a Response object: stops process_exception() chain

# - return a Request object: stops process_exception() chain

#如果抛出异常,那么就换代理IP

# 代理ip的设定

# if request.url.split(':')[0] == 'http':

# request.meta['proxy'] = random.choice(self.PROXY_http)

# else:

# request.meta['proxy'] = random.choice(self.PROXY_https)

# # 将修正后的请求对象重新进行请求发送

# return request

pass

然后去配置文件开启中间件settings.py:

# Enable or disable downloader middlewares

# See https://docs.scrapy.org/en/latest/topics/downloader-middleware.html

DOWNLOADER_MIDDLEWARES = {

'Wangyixinwen.middlewares.WangyixinwenDownloaderMiddleware': 543,

}

2、代理池

作用:尽可能多的将scrapy框架中的请求的IP设置成不同的,当服务器禁止自己电脑的ip的时候将自动调用process_exception中的ip代理设置

操作流程:

1.在下载中间件中拦截请求

2.将拦截到的请求的IP修改成某一代理IP

3.在配置文件中开启下载中间件

def process_exception(self, request, exception, spider):

# Called when a download handler or a process_request()

# (from other downloader middleware) raises an exception. # Must either:

# - return None: continue processing this exception

# - return a Response object: stops process_exception() chain

# - return a Request object: stops process_exception() chain

#如果抛出异常,那么就换代理IP

# 代理ip的设定

if request.url.split(':')[0] == 'http':

request.meta['proxy'] = random.choice(self.PROXY_http)

else:

request.meta['proxy'] = random.choice(self.PROXY_https)

# 将修正后的请求对象重新进行请求发送

return request

# Enable or disable downloader middlewares

# See https://docs.scrapy.org/en/latest/topics/downloader-middleware.html

DOWNLOADER_MIDDLEWARES = {

'Wangyixinwen.middlewares.WangyixinwenDownloaderMiddleware': 543,

}

拦截请求直接在上面中间件代码的process_exception中,配置文件也在上面。

12-UA池和代理池的更多相关文章

- 10 UA池和代理池

在Scrapy中,引擎和下载器之间有一个组件,叫下载中间件(Downloader Middlewares).因它是介于Scrapy的request/response处理的钩子,所以有2方面作用: (1 ...

- scrapy下载中间件,UA池和代理池

一.下载中间件 框架图: 下载中间件(Downloader Middlewares) 位于scrapy引擎和下载器之间的一层组件. - 作用: (1)引擎将请求传递给下载器过程中, 下载中间件可以对请 ...

- 爬虫的UA池和代理池

爬虫的UA池和代理池 一.下载中间件 先祭出框架图: 下载中间件(Downloader Middlewares) 位于scrapy引擎和下载器之间的一层组件. - 作用: (1)引擎将请求传递给下 ...

- 14.UA池和代理池

今日概要 scrapy下载中间件 UA池 代理池 今日详情 一.下载中间件 先祭出框架图: 下载中间件(Downloader Middlewares) 位于scrapy引擎和下载器之间的一层组件. - ...

- UA池和代理池

scrapy下载中间件 UA池 代理池 一.下载中间件 先祭出框架图: 下载中间件(Downloader Middlewares) 位于scrapy引擎和下载器之间的一层组件. - 作用: (1)引擎 ...

- UA池和代理池在scrapy中的应用

一.下载中间件 下载中间件(Downloader Middlewares) 位于scrapy引擎和下载器之间的一层组件. - 作用: (1)引擎将请求传递给下载器过程中, 下载中间件可以对请求进行一系 ...

- 爬虫开发13.UA池和代理池在scrapy中的应用

今日概要 scrapy下载中间件 UA池 代理池 今日详情 一.下载中间件 下载中间件(Downloader Middlewares) 位于scrapy引擎和下载器之间的一层组件. - 作用: ( ...

- 14,UA池和代理池

今日概要 scrapy下载中间件 UA池 代理池 一,下载中间件(Downloader Middlewares) 位于scrapy引擎和下载器之间的一层组件. - 作用: (1)引擎将请求传递给下载器 ...

- scrapy的UA池和代理池

一.下载中间件(Downloader Middlewares) 框架图如下 下载中间件(Downloader Middlewares)位于scrapy引擎和下载器之间的一层组件. - 作用: (1)引 ...

随机推荐

- java 初学 :求 s=a+aa+aaa+aaaa+aa...a 的值,其中 a 是一个数字。几个 数相加由键盘控制。

import java.util.Scanner; public static void main(String[] args) { Scanner input=new Scanner(S ...

- Centos 7.5私有域名服务器部署(coredns+etcd)

单机配置: 一.安装etcd: 1.安装 yum install etcd -y 2.启动 systemctl start etcd 3.设置开机启动 systemctl enable e ...

- Java类BufferedImage

https://docs.oracle.com/javase/7/docs/api/java/awt/image/BandedSampleModel.html

- quarter软件的破解

链接;http://www.openedv.com/forum.php?mod=viewthread&tid=275857&extra=page%3D1 这个是正点原子提供的破解方法, ...

- 记一起Java大对象引起的FullGC事件及GC知识梳理

背景 最近发生了一起 Java 大对象引起的 FullGC 事件.记录一下. 有一位商家刷单,每单内有 50+ 商品.然后进行订单导出.订单导出每次会从订单详情服务取100条订单数据.由于 100 条 ...

- 【koa2】用户注册、登录校验与加盐加密

加密与解密 先介绍一下关于服务端用户名跟密码的存储状态,我们知道当前端在注册一个新用户时,会在表单内填入用户名和密码,并通过post请求提交到服务器,服务器再把用户名和密码从ctx.request.b ...

- 总结在ssm整合中,Mybatis出现Mapped Statements collection already contains value for xxxxx的解决方案

先贴一段报错信息: 前面的都不是很重要,看最后灰色标注的那段.... 严重: 异常将上下文初始化事件发送到类的侦听器实例.[org.springframework.web.context.Contex ...

- Pandas处理超大规模数据

对于超大规模的csv文件,我们无法一下将其读入内存当中,只能分块一部分一部分的进行读取: 首先进行如下操作: import pandas as pd reader = pd.read_csv('dat ...

- Google Chome浏览器下如何开发UHF读写器

google Chrome浏览器不支持ocx,也就不能通过ocx来连接UHF读写器,只能使用RFID读写器云服务插件,通过javascript语言来连接和操控UHF读写器YW-602H.RFID读写器 ...

- SQL server利用脚本添加链接服务器,可设置别名

USE [master]GO EXEC master.dbo.sp_addlinkedserver @server = N'你的别名', @srvproduct=N'', @provider=N'SQ ...