Hadoop 部署之 Spark (六)

一、Spark 是什么

Spark是UC Berkeley AMP lab所开源的类Hadoop MapReduce的通用分布式并行计算框架。Spark拥有hadoop MapReduce所具有的优点,但和MapReduce 的最大不同之处在于Spark是基于内存的迭代式计算——Spark的Job处理的中间输出结果可以保存在内存中,从而不再需要读写HDFS,除此之外,一个MapReduce 在计算过程中只有map 和reduce 两个阶段,处理之后就结束了,而在Spark的计算模型中,可以分为n阶段,因为它内存迭代式的,我们在处理完一个阶段以后,可以继续往下处理很多个阶段,而不只是两个阶段。

因此Spark能更好地适用于数据挖掘与机器学习等需要迭代的MapReduce的算法。其不仅实现了MapReduce的算子map 函数和reduce函数及计算模型,还提供更为丰富的算子,如filter、join、groupByKey等。是一个用来实现快速而同用的集群计算的平台。

Spark是一个用来实现快速而通用的集群计算的平台。扩展了广泛使用的MapReduce计算模型,而且高效地支持更多的计算模式,包括交互式查询和流处理。在处理大规模数据集的时候,速度是非常重要的。Spark的一个重要特点就是能够在内存中计算,因而更快。即使在磁盘上进行的复杂计算,Spark依然比MapReduce更加高效。

二、Scala的安装(所有节点)

下载安装包

wget https://downloads.lightbend.com/scala/2.11.7/scala-2.11.7.tgz

解压安装包

tar xf scala-2.11.7.tgz

mv scala-2.11.7 /usr/local/scala

配置scala环境变量/etc/profile.d/scala.sh

# Scala ENV

export SCALA_HOME=/usr/local/scala

export PATH=$PATH:$SCALA_HOME/bin

使scala环境变量生效

source /etc/profile.d/scala.sh

三、Spark 安装(所有节点)

1、下载安装

# 下载安装包

wget https://mirrors.aliyun.com/apache/spark/spark-2.3.1/spark-2.3.1-bin-hadoop2.7.tgz

# 解压安装包

tar xf spark-2.3.1-bin-hadoop2.7.tgz

mv spark-2.3.1-bin-hadoop2.7 /usr/local/spark

2、配置 Spark 环境变量

编辑文件/etc/profile.d/spark.sh,修改为如下:

# Spark ENV

export SPARK_HOME=/usr/local/spark

export PATH=$PATH:$SPARK_HOME/bin:

生效环境变量

source /etc/profile.d/spark.sh

四、Spark 配置(namenode01)

1、配置 spark-env.sh

编辑文件/usr/local/spark/conf/spark-env.sh,修改为如下内容:

export JAVA_HOME=/usr/java/default

export SCALA_HOME=/usr/local/scala

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop

export SPARK_MASTER_IP=namenode01

export SPARK_WORKER_MEMORY=4g

export SPARK_WORKER_CORES=2

export SPARK_WORKER_INSTANCES=1

2、配置 slaves

编辑文件/usr/local/spark/conf/slaves,修改为如下内容:

datanode01

datanode02

datanode03

3、配置文件同步到其他节点

scp /usr/local/spark/conf/* datanode01:/usr/local/spark/conf/

scp /usr/local/spark/conf/* datanode02:/usr/local/spark/conf/

scp /usr/local/spark/conf/* datanode03:/usr/local/spark/conf/

4、启动 Spark 集群

Spark服务只使用hadoop的hdfs集群。

/usr/local/spark/sbin/start-all.sh

五、检查

1、JPS

[root@namenode01 ~]# jps

14512 NameNode

23057 RunJar

14786 ResourceManager

30355 Jps

15894 HMaster

30234 Master

[root@datanode01 ~]# jps

3509 DataNode

3621 NodeManager

1097 QuorumPeerMain

9930 RunJar

15514 Worker

15581 Jps

3935 HRegionServer

[root@datanode02 ~]# jps

3747 HRegionServer

14153 Worker

3322 DataNode

3434 NodeManager

1101 QuorumPeerMain

14221 Jps

[root@datanode03 ~]# jps

3922 DataNode

4034 NodeManager

19186 Worker

19255 Jps

1102 QuorumPeerMain

4302 HRegionServer

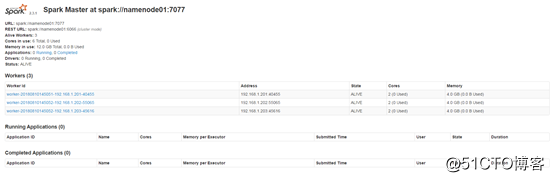

2、Spark WEB 界面

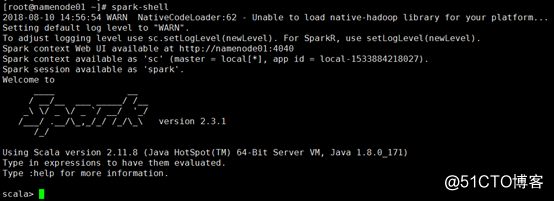

3、spark-shell

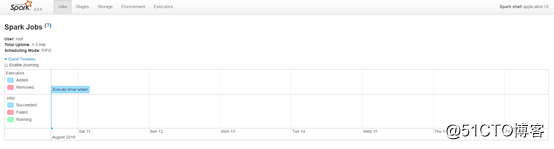

同时,因为shell在运行,我们也可以通过192.168.1.200:4040访问WebUI查看当前执行的任务。

Hadoop 部署之 Spark (六)的更多相关文章

- hadoop进阶----hadoop经验(一)-----生产环境hadoop部署在超大内存服务器的虚拟机集群上vs几个内存较小的物理机

生产环境 hadoop部署在超大内存服务器的虚拟机集群上 好 还是 几个内存较小的物理机上好? 虚拟机集群优点 虚拟化会带来一些其他方面的功能. 资源隔离.有些集群是专用的,比如给你三台设备只跑一个 ...

- Hadoop部署方式-伪分布式(Pseudo-Distributed Mode)

Hadoop部署方式-伪分布式(Pseudo-Distributed Mode) 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.下载相应的jdk和Hadoop安装包 JDK:h ...

- Hadoop集群+Spark集群搭建(一篇文章就够了)

本文档环境基于ubuntu16.04版本,(转发请注明出处:http://www.cnblogs.com/zhangyongli2011/ 如发现有错,请留言,谢谢) 一.准备 1.1 软件版本 Ub ...

- Hadoop阅读笔记(六)——洞悉Hadoop序列化机制Writable

酒,是个好东西,前提要适量.今天参加了公司的年会,主题就是吃.喝.吹,除了那些天生话唠外,大部分人需要加点酒来作催化剂,让一个平时沉默寡言的码农也能成为一个喷子!在大家推杯换盏之际,难免一些画面浮现脑 ...

- hadoop部署小结的命令

hadoop部署总结的命令 学习笔记,转自:hadoop部署总结的命令http://www.aboutyun.com/thread-5385-1-1.html(出处: about云开发)

- Hadoop和Apache Spark的异同

谈到大数据,相信大家对Hadoop和Apache Spark这两个名字并不陌生.但我们往往对它们的理解只是提留在字面上,并没有对它们进行深入的思考,下面不妨跟我一块看下它们究竟有什么异同. 1.解决问 ...

- Hadoop 部署文档

Hadoop 部署文档 1 先决条件 2 下载二进制文件 3 修改配置文件 3.1 core-site.xml 3.2 hdfs-site.xml 3.3 mapred-site.xml 3.4 ya ...

- Hadoop部署方式-完全分布式(Fully-Distributed Mode)

Hadoop部署方式-完全分布式(Fully-Distributed Mode) 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 本博客搭建的虚拟机是伪分布式环境(https://w ...

- Hadoop部署方式-本地模式(Local (Standalone) Mode)

Hadoop部署方式-本地模式(Local (Standalone) Mode) 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. Hadoop总共有三种运行方式.本地模式(Local ...

随机推荐

- java8的相关特性

1,为什么要介绍java8的相关特性? 因为现在的企业大部分已经从java7向java8开始迈进了,用java8的公司越来越多了,java8中的一些知识还是需要了解一些的; java8具有以下特点: ...

- K3CLOUD 常用数据表

二.K3 Cloud 开发插件<K3 Cloud 常用数据表整理>一.数据库查询常用表 按 Ctrl+C 复制代码 按 Ctrl+C 复制代码 通过表T_META_OBJECTTYPE的F ...

- BZOJ 4864: [BeiJing 2017 Wc]神秘物质 (块状链表/平衡树 )

这就是一道数据结构裸题啊,最大极差就是区间最大值减最小值,最小极差就是相邻两个数差的最小值.然后平衡树splay/treap或者块状链表维护就行了. 第一次自己写块状链表,蛮好写,就是长..然后就BZ ...

- List 中 forEach 的用法

1.forEach List list = new ArrayList<String>(); list.add("small"); list.add("sun ...

- 【vue】vue-cli中 对于public文件夹的处理

pubcli和assets文件夹都是用来存储静态资源的,: [assets文件夹] 通过相对路径被引入,这类引用会被webpack处理: 比如: 会被编译成: 再比如: 会被编译成: [public文 ...

- mousemove([[data],fn])

mousemove([[data],fn]) 概述 当鼠标指针在指定的元素中移动时,就会发生 mousemove 事件.大理石构件来图加工 mousemove事件处理函数会被传递一个变量——事件对象, ...

- vue编辑、新增弹框(引用外部页面)

vue编辑.新增弹框(引用外部页面) 2018年06月15日 09:37:20 会飞的猪biubiu 阅读数 10265 版权声明:本文为博主原创文章,未经博主允许不得转载. https://b ...

- css偷懒神奇

偷懒神奇链接:https://qishaoxuan.github.io/css_tricks/glass/

- laotech老师唠科mac 深入浅出MAC OS X ceshi ruguokeyi

laotech老师唠科mac 深入浅出MAC OS X http://study.163.com/plan/planLearn.htm?id=1637004#/learn/resVideo?lesso ...

- AcWing:242. 一个简单的整数问题(树状数组)

给定长度为N的数列A,然后输入M行操作指令. 第一类指令形如“C l r d”,表示把数列中第l~r个数都加d. 第二类指令形如“Q X”,表示询问数列中第x个数的值. 对于每个询问,输出一个整数表示 ...