(六)6.7 Neurons Networks whitening

PCA的过程结束后,还有一个与之相关的预处理步骤,白化(whitening)

对于输入数据之间有很强的相关性,所以用于训练数据是有很大冗余的,白化的作用就是降低输入数据的冗余,通过白化可以达到(1)降低特征之间的相关性(2)所有特征同方差,白化是需要与平滑与PCA结合的,下边来看如何结合。

对于训练数据{ },找到其所有特征组成的新基U,计算在新基的坐标

},找到其所有特征组成的新基U,计算在新基的坐标  ,这里

,这里 就会消除数据的相关性:

就会消除数据的相关性:

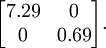

这个数据的协方差矩阵如下:

协方差矩阵对角元素的值为

协方差矩阵对角元素的值为  和

和  ,且非对角线元素取值为0,课件不同纬度的特征之间是不相关的,对应的

,且非对角线元素取值为0,课件不同纬度的特征之间是不相关的,对应的  和

和  是不相关的,这便满足白化的第一个要求,降低相关性,下面就要使特征之间同方差(注意是变化后的特征同方差

是不相关的,这便满足白化的第一个要求,降低相关性,下面就要使特征之间同方差(注意是变化后的特征同方差 )

) 中每个特征 i 的方差为

中每个特征 i 的方差为  我们可以直接使用

我们可以直接使用  作为缩放因子来缩放每个特征

作为缩放因子来缩放每个特征  。具体地,我们定义白化后的数据

。具体地,我们定义白化后的数据  如下:

如下:

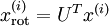

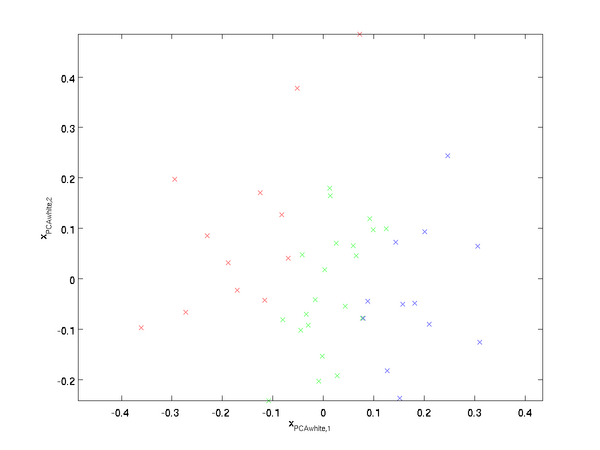

绘制出  ,可以得到:

,可以得到:

这些数据现在的协方差矩阵为单位矩阵  。

。 是数据经过PCA白化后的版本:

是数据经过PCA白化后的版本:  中不同的特征之间不相关并且具有单位方差。

中不同的特征之间不相关并且具有单位方差。

白化与降维相结合。 如果你想要得到经过白化后的数据,并且比初始输入维数更低,可以仅保留  中前

中前  个成分。当我们把PCA白化和正则化结合起来时(在稍后讨论),

个成分。当我们把PCA白化和正则化结合起来时(在稍后讨论), 中最后的少量成分将总是接近于0,因而舍弃这些成分不会带来很大的问题。

中最后的少量成分将总是接近于0,因而舍弃这些成分不会带来很大的问题。

最后要说明的是,使数据的协方差矩阵变为单位矩阵  的方式并不唯一。具体地,如果

的方式并不唯一。具体地,如果  是任意正交矩阵,即满足

是任意正交矩阵,即满足  (说它正交不太严格,

(说它正交不太严格, 可以是旋转或反射矩阵), 那么

可以是旋转或反射矩阵), 那么  仍然具有单位协方差。在ZCA白化中,令

仍然具有单位协方差。在ZCA白化中,令  。定义ZCA白化的结果为:

。定义ZCA白化的结果为:

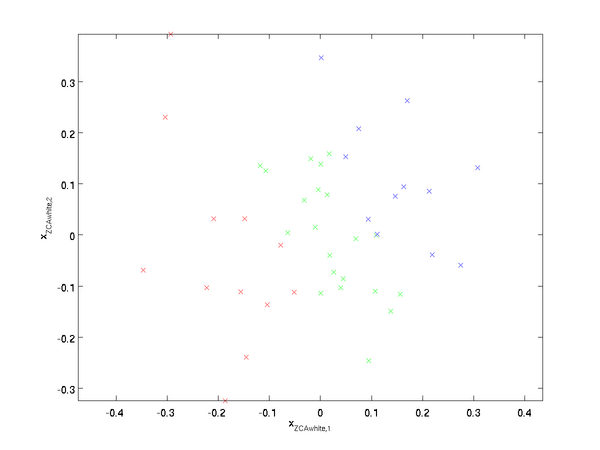

绘制  ,得到:

,得到:

可以证明,对所有可能的  ,这种旋转使得

,这种旋转使得  尽可能地接近原始输入数据

尽可能地接近原始输入数据  。

。

当使用 ZCA白化时(不同于 PCA白化),我们通常保留数据的全部  个维度,不尝试去降低它的维数。

个维度,不尝试去降低它的维数。

实践中需要实现PCA白化或ZCA白化时,有时一些特征值  在数值上接近于0,这样在缩放步骤时我们除以

在数值上接近于0,这样在缩放步骤时我们除以  将导致除以一个接近0的值;这可能使数据上溢 (赋为大数值)或造成数值不稳定。因而在实践中,我们使用少量的正则化实现这个缩放过程,即在取平方根和倒数之前给特征值加上一个很小的常数

将导致除以一个接近0的值;这可能使数据上溢 (赋为大数值)或造成数值不稳定。因而在实践中,我们使用少量的正则化实现这个缩放过程,即在取平方根和倒数之前给特征值加上一个很小的常数  :

:

当  在区间

在区间  上时, 一般取值为

上时, 一般取值为  。

。

对图像来说, 这里加上  ,对输入图像也有一些平滑(或低通滤波)的作用。这样处理还能消除在图像的像素信息获取过程中产生的噪声,改善学习到的特征。

,对输入图像也有一些平滑(或低通滤波)的作用。这样处理还能消除在图像的像素信息获取过程中产生的噪声,改善学习到的特征。

(六)6.7 Neurons Networks whitening的更多相关文章

- (六) 6.1 Neurons Networks Representation

面对复杂的非线性可分的样本是,使用浅层分类器如Logistic等需要对样本进行复杂的映射,使得样本在映射后的空间是线性可分的,但在原始空间,分类边界可能是复杂的曲线.比如下图的样本只是在2维情形下的示 ...

- (六) 6.2 Neurons Networks Backpropagation Algorithm

今天得主题是BP算法.大规模的神经网络可以使用batch gradient descent算法求解,也可以使用 stochastic gradient descent 算法,求解的关键问题在于求得每层 ...

- CS229 6.7 Neurons Networks whitening

PCA的过程结束后,还有一个与之相关的预处理步骤,白化(whitening) 对于输入数据之间有很强的相关性,所以用于训练数据是有很大冗余的,白化的作用就是降低输入数据的冗余,通过白化可以达到(1)降 ...

- (六) 6.3 Neurons Networks Gradient Checking

BP算法很难调试,一般情况下会隐隐存在一些小问题,比如(off-by-one error),即只有部分层的权重得到训练,或者忘记计算bais unit,这虽然会得到一个正确的结果,但效果差于准确BP得 ...

- (六)6.10 Neurons Networks implements of softmax regression

softmax可以看做只有输入和输出的Neurons Networks,如下图: 其参数数量为k*(n+1) ,但在本实现中没有加入截距项,所以参数为k*n的矩阵. 对损失函数J(θ)的形式有: 算法 ...

- CS229 6.10 Neurons Networks implements of softmax regression

softmax可以看做只有输入和输出的Neurons Networks,如下图: 其参数数量为k*(n+1) ,但在本实现中没有加入截距项,所以参数为k*n的矩阵. 对损失函数J(θ)的形式有: 算法 ...

- CS229 6.1 Neurons Networks Representation

面对复杂的非线性可分的样本是,使用浅层分类器如Logistic等需要对样本进行复杂的映射,使得样本在映射后的空间是线性可分的,但在原始空间,分类边界可能是复杂的曲线.比如下图的样本只是在2维情形下的示 ...

- (六)6.8 Neurons Networks implements of PCA ZCA and whitening

PCA 给定一组二维数据,每列十一组样本,共45个样本点 -6.7644914e-01 -6.3089308e-01 -4.8915202e-01 ... -4.4722050e-01 -7.4 ...

- (六)6.16 Neurons Networks linear decoders and its implements

Sparse AutoEncoder是一个三层结构的网络,分别为输入输出与隐层,前边自编码器的描述可知,神经网络中的神经元都采用相同的激励函数,Linear Decoders 修改了自编码器的定义,对 ...

随机推荐

- C# 与C/C++相互调用

C++调用C#的DLLhttp://www.csharpwin.com/csharpspace/11385r8940.shtml C#调用C/C++动态库必须注意的几个问题http://www.rob ...

- java如何追加写入txt文件

java中,对文件进行追加内容操作的三种方法 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 import java.io.BufferedWriter; import ...

- BestCoder 1st Anniversary($) 1003 Sequence

题目传送门 /* 官方题解: 这个题看上去是一个贪心, 但是这个贪心显然是错的. 事实上这道题目很简单, 先判断1个是否可以, 然后判断2个是否可以. 之后找到最小的k(k>2), 使得(m-k ...

- three.js 简介

What is Three.js? Let's try to describe it briefly: Three.js is a library that makes WebGL - 3D in t ...

- for (Map.Entry<Long, Integer> me : zlSendMap.entrySet())

public static void main(String[] args) throws IOException { Map<String,String> map = new HashM ...

- 近期学习js总结

都是一个细节问题老是犯错,还有就是之前的知识点没有去复习,老是犯错误.总结一下避免以后又犯错. 1.没有去检查对象是否存在 写完js就是忘记去检查是否存在,等到用到项目中才发现,代码如下:if(!ob ...

- QScrollArea可以帮助我们实现让一个widget的内容带有滚动条(QWidget里内置QScrollArea,QScrollArea里再内置其它QWidget)

使用QScrollArea可以帮助我们实现让一个widget的内容带有滚动条,用户可以通过拖动滚动条来查看更多内容, 代码示例如下: 1.带有滚动条的widget列表 #include "w ...

- Jboss调优——最佳线程数

在设置jboss的参数中,maxThreads(最大线程数)和acceptCount(最大等待线程数)是两个非常重要的指标,直接影响到程序的QPS.本文讲解jboss连接的运行原理,以及如何设置这两 ...

- Linux 下Git的安装和配置

Git是分布式的版本控制系统,实际上是不需要固定的服务器的,Git与svn的最大区别是,它的使用流程不需要联机,可以先将对代码的修改,评论,保存在本机.等上网之后,再实时推送过去.同时它创建分支与合并 ...

- guice的基本使用(一)

guice是google一个轻量级的DI注入框架,现在比较强大了,也与目前流行的struts2.jpa等都有集成了. 先看一个例子: package com.ming.user.test; publi ...