flume安装及配置介绍(二)

注: 环境: skylin-linux

Flume的下载方式:

wget http://www.apache.org/dyn/closer.lua/flume/1.6.0/apache-flume-1.6.0-bin.tar.

下载完成之后,使用tar进行解压

tar -zvxf apache-flume-1.6..0-bin.tar.

进入flume的conf配置包中,使用命令touch flume.conf,然后cp flume-conf.properties.template flume.conf

使vim/gedit flume.conf 编辑配置文件,需要说明的的是,Flume conf文件用的是Java版的property文件的key-value键值对模式.

在Flume配置文件中,我们需要

1. 需要命名当前使用的Agent的名称.

2. 命名Agent下的source的名字.

3. 命名Agent下的channal的名字.

4. 命名Agent下的sink的名字.

5. 将source和sink通过channal绑定起来.

一般来说,在Flume中会存在着多个Agent,所以我们需要给它们分别取一个名字来区分它们,注意名字不要相同,名字保持唯一!

例如:

#Agent取名为 agent_name

#source 取名为 source_name ,一次类推

agent_name.source = source_name

agent_name.channels = channel_name

agent_name.sinks = sink_name

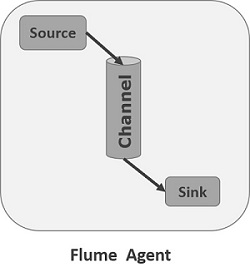

上图对应的是单个Agent,单个sink,单个channel情况,如下图

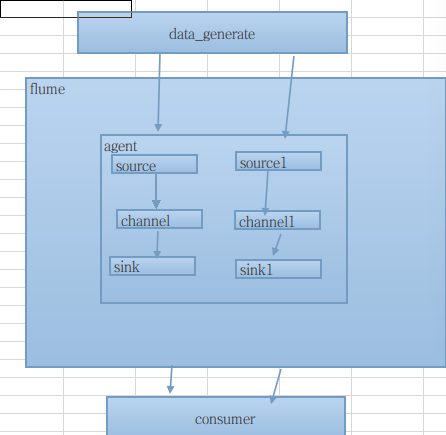

如果我们需要在一个Agent上配置n个sink,m个channel(n>1, m>1),

如果我们需要在一个Agent上配置n个sink,m个channel(n>1, m>1),

那么只需要这样配置即可:

#Agent取名为 agent_name

#source 取名为 source_name ,一次类推

agent_name.source = source_name ,source_name1

agent_name.channels = channel_name,channel_name1

agent_name.sinks = sink_name,sink_name1

上面的配置就表示一个Agent中有两个 source,sink,channel的情况,如图所示

以上是对多sink,channel,source情况,对于 多个Agent,只需要给每个Agent取一个独一无二的名字即可!

Flume支持各种各样的sources,sinks,channels,它们支持的类型如下:

| Sources | Channels | Sinks |

|---|---|---|

|

|

|

以上的类型,你可以根据自己的需求来搭配组合使用,当然如果你愿意,你可以为所欲为的搭配.比如我们使用Avro source类型,采用Memory channel,使用HDFS sink存储,那我们的配置可以接着上的配置这样写

#Agent取名为 agent_name

#source 取名为 source_name ,一次类推

agent_name.source = Avro

agent_name.channels = MemoryChannel

agent_name.sinks = HDFS

当你命名好Agent的组成部分后,你还需要对Agent的组成sources , sinks, channles去一一描述. 下面我们来逐一的细说;

Source的配置

注: 需要特别说明,在Agent中对于存在的N(N>1)个source,其中的每一个source都需要单独进行配置,首先我们需要对source的type进行设置,然后在对每一个type进行对应的属性设置.其通用的模式如下:

agent_name.sources. source_name.type = value

agent_name.sources. source_name.property2 = value

agent_name.sources. source_name.property3 = value

具体的例子,比如我们Source选用的是Avro模式

#Agent取名为 agent_name

#source 取名为 source_name ,一次类推

agent_name.source = Avro

agent_name.channels = MemoryChannel

agent_name.sinks = HDFS #——————————sourcec配置——————————————#

agent_name.source.Avro.type = avro

agent_name.source.Avro.bind = localhost

agent_name.source.Avro.port = 9696

#将source绑定到MemoryChannel管道上

agent_name.source.Avro.channels = MemoryChannel

Channels的配置

Flume在source和sink配间提供各种管道(channels)来传递数据.因而和source一样,它也需要配置属性,同source一样,对于N(N>0)个channels,

需要单个对它们注意设置属性,它们的通用模板为:

agent_name.channels.channel_name.type = value

agent_name.channels.channel_name. property2 = value

agent_name.channels.channel_name. property3 = value

具体的例子,假如我们选用memory channel类型,那么我先要配置管道的类型

agent_name.channels.MemoryChannel.type = memory

但是我们现在只是设置好了管道自个儿属性,我们还需要将其和sink,source链接起来,也就是绑定,绑定设置如下,我们可以分别写在source,sink处,也可以集中写在channel处

agent_name.sources.Avro.channels = MemoryChannel

agent_name.sinks.HDFS.channels = MemoryCHannel

Sink的配置

sink的配置和Source配置类似,它的通用格式:

agent_name.sinks. sink_name.type = value

agent_name.sinks. sink_name.property2 = value

agent_name.sinks. sink_name.property3 = value

具体例子,比如我们设置Sink类型为HDFS ,那么我们的配置单就如下:

agent_name.sinks.HDFS.type = hdfs

agent_name.sinks.HDFS.path = HDFS‘s path

以上就是对Flume的配置文件详细介绍,下面在补全一张完整的配置图:

# Licensed to the Apache Software Foundation (ASF) under one

# or more contributor license agreements. See the NOTICE file

# distributed with this work for additional information

# regarding copyright ownership. The ASF licenses this file

# to you under the Apache License, Version 2.0 (the

# "License"); you may not use this file except in compliance

# with the License. You may obtain a copy of the License at

#

# http://www.apache.org/licenses/LICENSE-2.0

#

# Unless required by applicable law or agreed to in writing,

# software distributed under the License is distributed on an

# "AS IS" BASIS, WITHOUT WARRANTIES OR CONDITIONS OF ANY

# KIND, either express or implied. See the License for the

# specific language governing permissions and limitations

# under the License. # The configuration file needs to define the sources,

# the channels and the sinks.

# Sources, channels and sinks are defined per agent,

# in this case called 'agent' #define agent

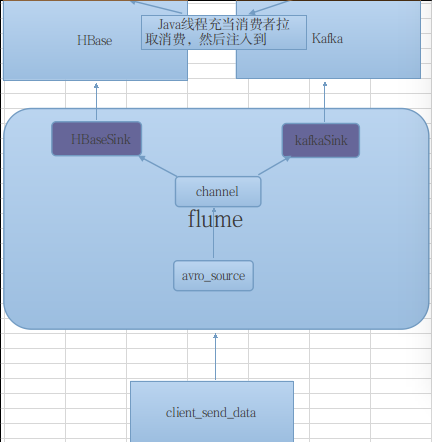

agent.sources = seqGenSrc

agent.channels = memoryChannel

agent.sinks = loggerSink kafkaSink #

# For each one of the sources, the type is defined

#默认模式 agent.sources.seqGenSrc.type = seq / netcat / avro

agent.sources.seqGenSrc.type = avro

agent.sources.seqGenSrc.bind = localhost

agent.sources.seqGenSrc.port = 9696

#####数据来源####

#agent.sources.seqGenSrc.coommand = tail -F /home/gongxijun/Qunar/data/data.log # The channel can be defined as follows.

agent.sources.seqGenSrc.channels = memoryChannel #+++++++++++++++定义sink+++++++++++++++++++++#

# Each sink's type must be defined agent.sinks.loggerSink.type = logger

agent.sinks.loggerSink.type = hbase

agent.sinks.loggerSink.channel = memoryChannel

#表名

agent.sinks.loggerSink.table = flume

#列名

agent.sinks.loggerSink.columnFamily= gxjun

agent.sinks.loggerSink.serializer = org.apache.flume.sink.hbase.MyHbaseEventSerializer

#agent.sinks.loggerSink.serializer = org.apache.flume.sink.hbase.RegexHbaseEventSerializer

agent.sinks.loggerSink.zookeeperQuorum=localhost:2181

agent.sinks.loggerSink.znodeParent= /hbase #Specify the channel the sink should use

agent.sinks.loggerSink.channel = memoryChannel # Each channel's type is defined.

#memory

agent.channels.memoryChannel.type = memory

agent.channels.memortChhannel.keep-alive = 10 # Other config values specific to each type of channel(sink or source)

# can be defined as well

# In this case, it specifies the capacity of the memory channel

#agent.channels.memoryChannel.checkpointDir = /home/gongxijun/Qunar/data

#agent.channels.memoryChannel.dataDirs = /home/gongxijun/Qunar/data , /home/gongxijun/Qunar/tmpData

agent.channels.memoryChannel.capacity = 10000000

agent.channels.memoryChannel.transactionCapacity = 10000 #define the sink2 kafka #+++++++++++++++定义sink+++++++++++++++++++++#

# Each sink's type must be defined agent.sinks.kafkaSink.type = logger

agent.sinks.kafkaSink.type = org.apache.flume.sink.kafka.KafkaSink agent.sinks.kafkaSink.channel = memoryChannel

#agent.sinks.kafkaSink.server=localhost:9092

agent.sinks.kafkaSink.topic= kafka-topic

agent.sinks.kafkaSink.batchSize = 20

agent.sinks.kafkaSink.brokerList = localhost:9092

#Specify the channel the sink should use

agent.sinks.kafkaSink.channel = memoryChannel

该配置类型如下如所示:

参考资料:

http://www.tutorialspoint.com/apache_flume/apache_flume_configuration.htm

作者: 龚细军

引用请注明出处:http://www.cnblogs.com/gongxijun/p/5661037.html

flume安装及配置介绍(二)的更多相关文章

- Flume简介与使用(一)——Flume安装与配置

Flume简介与使用(一)——Flume安装与配置 Flume简介 Flume是一个分布式的.可靠的.实用的服务——从不同的数据源高效的采集.整合.移动海量数据. 分布式:可以多台机器同时运行采集数据 ...

- CentOS6安装各种大数据软件 第七章:Flume安装与配置

相关文章链接 CentOS6安装各种大数据软件 第一章:各个软件版本介绍 CentOS6安装各种大数据软件 第二章:Linux各个软件启动命令 CentOS6安装各种大数据软件 第三章:Linux基础 ...

- P6 EPPM R16.1安装与配置指南(二)

P6 EPPM R16.1安装与配置指南(一) http://www.cnblogs.com/endv/p/5634620.html P6 EPPM R16.1安装与配置指南(二) 环境变量配置 新建 ...

- 第1章 开发环境安装和配置(二)安装JDK、SDK、NDK

原文 第1章 开发环境安装和配置(二)安装JDK.SDK.NDK 无论是用C#和VS2015开发Androd App还是用Java和Eclipse开发Androd App,都需要先安装JDK和Andr ...

- linux服务安装与配置(二):安装xinetd服务

linux服务安装与配置(二):安装xinetd服务 xinetd即extended internet daemon,xinetd是新一代的网络守护进程服务程序,又叫超级Internet服务器.经常用 ...

- Windows Server 2016 + SCO 2016 安装及配置介绍

Windows Server 2016 + SCO 2016 安装及配置介绍 高文龙关注1人评论6332人阅读2017-02-26 23:23:02 Windows Server 2016 + SCO ...

- Centos 7.3下 Linux For SQL Server安装及配置介绍

Centos 7.3下 Linux For SQL Server安装及配置介绍 高文龙关注13人评论2828人阅读2017-03-05 21:46:21 Centos 7.3下Linux For SQ ...

- 【C#】VS2015开发环境的安装和配置(二)2016-08-03更新

分类:C#.VS2015.WPF.ASP.NET MVC.Android.iOS.Unity3D: 更新日期:2016-08-03 按下面介绍的步骤安装即可. 一.安装JDK和Android SDK ...

- flume安装及配置

Flume安装 介绍 Flume本身的安装比较简单(flume的介绍请参考http://blog.csdn.net/rzhzhz/article/details/7448633),安装前先说明几个概念 ...

随机推荐

- C语言 04 进制

%d 或者%i 十进制 %c 输出字符 %p 输出地址 %f 输出小数 %o 八进制 %x 十六进制 一个int类型变量占4字节,占32bit(位) 例子:十进制 int=12 转二进制 0000 ...

- 关于32位windows和64位windows

SysWow64文件夹,是64位Windows,用来存放32位Windows系统文件的地方,而System32文件夹,是用来存放64位程序文件的地方. 当32位程序加载System32文件夹中的dll ...

- git 远程库命令

git 常用命令在这里就不在说了,初学者点击http://www.cnblogs.com/Vdiao/p/5267250.html Git是分布式版本控制系统,同一个Git仓库,可以分布到不同的机器上 ...

- ES数据-MySql处理Date类型的数据导入处理

用ES的小伙伴们,相信大家都遇到过Mapping处理Date类型的数据头疼问题吧. 不用头疼了,我来给你提供一种解决方案: 1.Maping定义为: { "mappings": ...

- 【GO】GO语言学习笔记二

基本类型: 布尔型:boolean 整型:int8,byte,int16,int,uint,uintptr等 浮点型:float32,float64 复数类型:complex64,complex128 ...

- ASP。net 之view

<%@ Page Language="C#" AutoEventWireup="true" CodeFile="Index.aspx.cs&qu ...

- js sql C#时间、时间戳相互转换

js. sql. C#时间.时间戳相互转换 //1.获取当前时间戳_c# ) / //2.时间戳->时间 C# DateTime b11 = GetTime(");//11位时间戳-& ...

- PHPStorm 与 XDebug 配置

XDebug 配置 环境 Nginx 1.4.7 32 bit PHP 5.4.25 32 bit Windows 10 64 bit 下载 PHP 5.4 VC9 (32 bit)[nts版本] 配 ...

- 如何使用JDBC实现数据访问对象层(DAO)

JAVA是面向对象的语言,开发者在操作数据的时候,通常更习惯面对一个特定类型的对象,如一个用户就是一个User类的对象.DAO层需要做的,就是为上层提供充分的对象支持,让上层再也看不到具体的数据,而是 ...

- placeholder右对齐的写法,兼容性比较高的一种方法

placeholder右对齐的写法,如果你不考虑移动端的话,完全可以使用text-align:right,不过如果考虑移动端的话,在有一些手机上,即使你写了text-align:right,place ...