【Hadoop离线基础总结】Hue与Hadoop集成

目录

1.更改所有hadoop节点的core-site.xml配置

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop/

vim core-site.xml

添加以下配置<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

发送到node02,node03

scp core-site.xml node02:$PWD

scp core-site.xml node03:$PWD

2.更改所有hadoop节点的hdfs-site.xml

vim hdfs-site.xml

添加以下配置<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

发送到node02,node03

scp hdfs-site.xml node02:$PWD

scp hdfs-site.xml node03:$PWD

3.重启hadoop集群

在node01执行

cd /export/servers/hadoop-2.6.0-cdh5.14.0

sbin/stop-dfs.sh

sbin/start-dfs.sh

sbin/stop-yarn.sh

sbin/start-yarn.sh

4.停止hue的服务,并继续配置hue.ini

cd /export/servers/hue-3.9.0-cdh5.14.0/desktop/conf

vim hue.ini 最好别用vim编辑

配置hue与hdfs集成

[[hdfs_clusters]]

[[[default]]]

fs_defaultfs=hdfs://node01.hadoop.com:8020

webhdfs_url=http://node01.hadoop.com:50070/webhdfs/v1

hadoop_hdfs_home=/export/servers/hadoop-2.6.0-cdh5.14.0 (前两行是修改,后三行是添加)

hadoop_bin=/export/servers/hadoop-2.6.0-cdh5.14.0/bin

hadoop_conf_dir=/export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

配置hue与yarn集成

[[yarn_clusters]]

[[[default]]]

resourcemanager_host=node01

resourcemanager_port=8032

submit_to=True

resourcemanager_api_url=http://node01:8088

history_server_api_url=http://node01:19888

启动hue进程,查看hadoop是否与Hue集成成功

cd /export/servers/hue-3.9.0-cdh5.14.0/

build/env/bin/supervisor

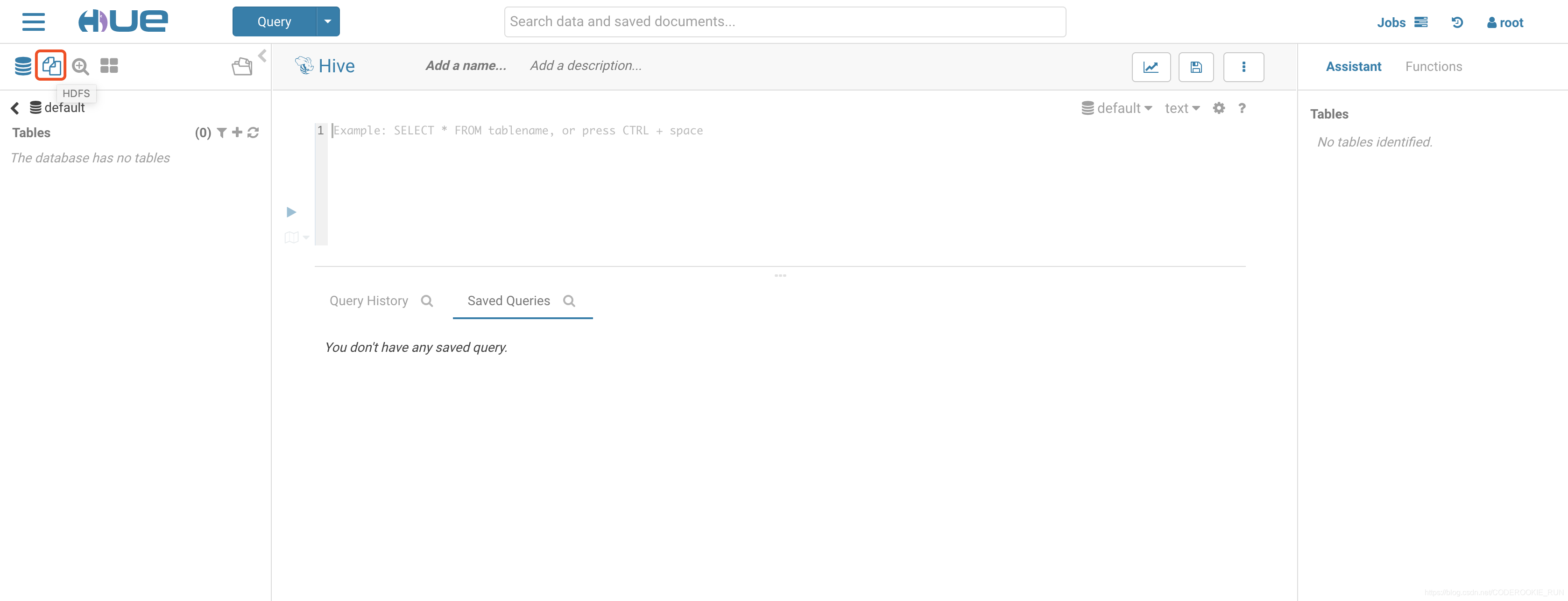

连接到web页面,显示如下图表示配置成功

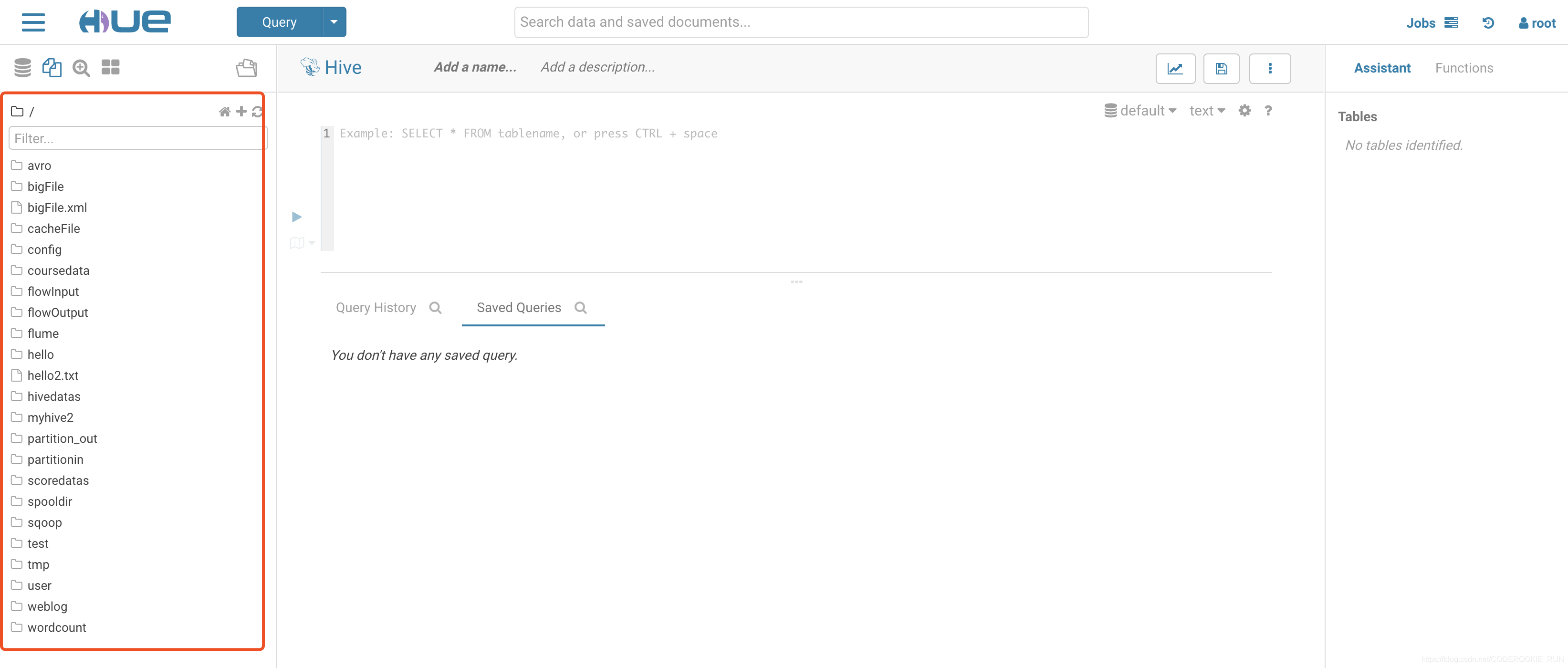

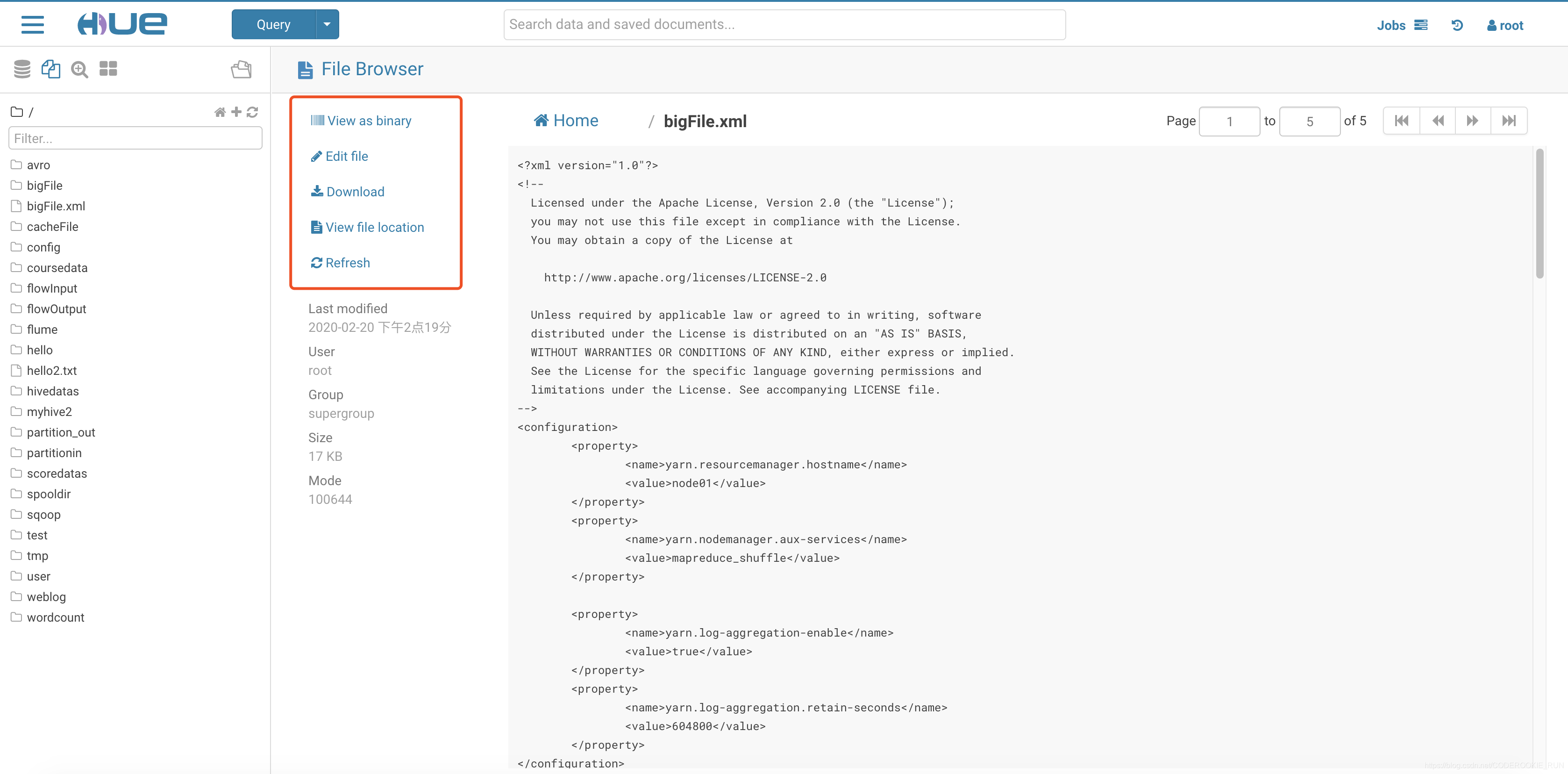

可以直接在网页对HDFS的文件进行操作

【Hadoop离线基础总结】Hue与Hadoop集成的更多相关文章

- 【Hadoop离线基础总结】Apache Hadoop的三种运行环境介绍及standAlone环境搭建

Apache Hadoop的三种运行环境介绍及standAlone环境搭建 三种运行环境 standAlone环境 单机版的hadoop运行环境 伪分布式环境 主节点都在一台机器上,从节点分开到其他机 ...

- 【Hadoop离线基础总结】Hue的简单介绍和安装部署

目录 Hue的简单介绍 概述 核心功能 安装部署 下载Hue的压缩包并上传到linux解压 编译安装启动 启动Hue进程 hue与其他框架的集成 Hue与Hadoop集成 Hue与Hive集成 Hue ...

- 【Hadoop离线基础总结】oozie的安装部署与使用

目录 简单介绍 概述 架构 安装部署 1.修改core-site.xml 2.上传oozie的安装包并解压 3.解压hadooplibs到与oozie平行的目录 4.创建libext目录,并拷贝依赖包 ...

- 【Hadoop离线基础总结】impala简单介绍及安装部署

目录 impala的简单介绍 概述 优点 缺点 impala和Hive的关系 impala如何和CDH一起工作 impala的架构及查询计划 impala/hive/spark 对比 impala的安 ...

- 【Hadoop离线基础总结】流量日志分析网站整体架构模块开发

目录 数据仓库设计 维度建模概述 维度建模的三种模式 本项目中数据仓库的设计 ETL开发 创建ODS层数据表 导入ODS层数据 生成ODS层明细宽表 统计分析开发 流量分析 受访分析 访客visit分 ...

- 【Hadoop离线基础总结】Sqoop常用命令及参数

目录 常用命令 常用公用参数 公用参数:数据库连接 公用参数:import 公用参数:export 公用参数:hive 常用命令&参数 从关系表导入--import 导出到关系表--expor ...

- 【Hadoop离线基础总结】Hive调优手段

Hive调优手段 最常用的调优手段 Fetch抓取 MapJoin 分区裁剪 列裁剪 控制map个数以及reduce个数 JVM重用 数据压缩 Fetch的抓取 出现原因 Hive中对某些情况的查询不 ...

- 【Hadoop离线基础总结】Hue与Mysql集成

Hue与Mysql集成 1.修改hue.ini配置文件 这里要去掉#,打开mysql注释,大概在1547行 [[[mysql]]] nice_name="My SQL DB" en ...

- 【Hadoop离线基础总结】Hue与Impala集成

Hue与Impala集成 1.修改hue.ini配置文件 [impala] server_host=node03 server_port=21050 impala_conf_dir=/etc/impa ...

随机推荐

- 控件:DataGridView列类型

DataGridView的列的类型提供有多种,包括有: (1)DataGridViewTextBoxColumn(文本列,默认的情况下就是这种) (2)DataGridViewComboBoxColu ...

- c++ string类的一些使用

初始化: string类的初始化是不可以用字符进行的,如; string str='c'; string str('c');必须传递字符串字面量作为参数:string本身是用模板类进行实例化的类. s ...

- stand up meeting 1-6

今日更新: 1.修复初始最佳战绩显示bug: 初始为击败全国0% 用户 2.挑战结果界面显示“哎,今天的饭又白吃了,回去多吃两碗###”, 去除API返回string中的“###”. 3.分享模块初 ...

- ASE team work proposal

Hi,我们是Azure Wrapper,欢迎来到我们的blog~我们将在这里记录下ASE课程的滴滴点点,美妙的旅程就要开始啦! 以下是每位队员提交的关于ASE 团队项目的提议: 朱玉影: 随着信息时代 ...

- 20200107——记spring的DataSource

spring项目中总要跟数据库打交道,其中怎么连接数据库的方法都有很多,大概分为3类: 1) 通过JNDI获取应用服务器(如JBOSS, Tomcat) 的数据源 2) Spring容器中直接配置数 ...

- JS-Array-新增方法

1. filter( ) var arr = [5,4,3,2,1]; newarr = arr.filter((item)=>{ return item<3 }) ; // => ...

- PHP代码审计理解(三)---EMLOG某插件文件写入

此漏洞存在于emlog下的某个插件---友言社会化评论1.3. 我们可以看到, uyan.php 文件在判断权限之前就可以接收uid参数.并且uid未被安全过滤即写入到了$uyan_code中. 我们 ...

- 解决sublime打开文档,出现中文乱码问题

sublime text 软件中出现中文乱码,大多是因为编码格式不支持,需要安装一个插件就可以解决中文乱码问题,推荐安装 ConvertToUtf8 安装步骤: 1.按“shift + ctrl + ...

- <algorithm>中sort()函数的用法

先说一下,本篇文章我没有讲sort()实现排序的原理,我写在另一篇文章中了,如果想了解的话,可以看一下,附上链接:https://www.cnblogs.com/buanxu/p/12772700.h ...

- Jenkins(3)- 安装Jenkins过程中遇到问题的排查思路

如果想从头学起Jenkins的话,可以看看这一系列的文章哦 https://www.cnblogs.com/poloyy/category/1645399.html 安装Jenkins过程中,可能会遇 ...