Python 爬取 热词并进行分类数据分析-[拓扑数据]

日期:2020.01.29

博客期:137

星期三

【本博客的代码如若要使用,请在下方评论区留言,之后再用(就是跟我说一声)】

所有相关跳转:

a.【简单准备】

b.【云图制作+数据导入】

c.【拓扑数据】(本期博客)

d.【数据修复】

e.【解释修复+热词引用】

f.【JSP演示+页面跳转】

g.【热词分类+目录生成】

h.【热词关系图+报告生成】

i . 【App制作】

j . 【安全性改造】

嗯,先声明一下 “拓扑数据”的意思,应老师需求,我们需要将热词的解释、引用等数据从百科网站中爬取下来,之后将统一的热词数据进行文件处理,组合成新的数据表,然后可以在网页上(暂时是网页)展示更多的信息。

嗯,可以对热词解释进行爬取了,给大家看一下 (以人工智能为例)

我发现了一个问题:

setAttr("value","人工智能")方法并不能实现input的value属性值变为想要的“人工智能”,我采用的是sendKeys("人工智能")方法来实现,不过这样又有了一个问题,每一次sendKeys()相当于再input内部又附加了这样的字符,比如原本input里有“茄子”字样,之后使用sendKeys(“蔬菜”),input里就变成了“茄子蔬菜”!这个问题就导致了我不能实现页面直接跳转。如何解决呢?

我从它的方法里找到了clear()方法,亲测可用(在sendKeys之前使用)。

我在这里提供测试类代码:

import parsel

from urllib import request

import codecs

from selenium import webdriver

import time # [ 对字符串的特殊处理方法-集合 ]

class StrSpecialDealer:

# 取得当前标签内的文本

@staticmethod

def getReaction(stri):

strs = StrSpecialDealer.simpleDeal(str(stri))

strs = strs[strs.find('>')+1:strs.rfind('<')]

return strs # 去除基本的分隔符

@staticmethod

def simpleDeal(stri):

strs = str(stri).replace(" ", "")

strs = strs.replace("\t", "")

strs = strs.replace("\r", "")

strs = strs.replace("\n", "")

return strs # 删除所有标签标记

@staticmethod

def deleteRe(stri):

strs = str(stri)

st = strs.find('<')

while(st!=-1):

str_delete = strs[strs.find('<'):strs.find('>')+1]

strs = strs.replace(str_delete,"")

st = strs.find('<') return strs # 删除带有 日期 的句子

@staticmethod

def de_date(stri):

lines = str(stri).split("。")

strs = ""

num = lines.__len__()

for i in range(0,num):

st = str(lines[i])

if (st.__contains__("年") | st.__contains__("月")):

pass

else:

strs += st + "。"

strs = strs.replace("。。", "。")

return strs # 取得带有 日期 的句子之前的句子

@staticmethod

def ut_date(stri):

lines = str(stri).split("。")

strs = ""

num = lines.__len__()

for i in range(0, num):

st = str(lines[i])

if (st.__contains__("年")| st.__contains__("月")):

break

else:

strs += st + "。"

strs = strs.replace("。。","。")

return strs @staticmethod

def beat(stri,num):

strs = str(stri)

for i in range(0,num):

strs = strs.replace("["+str(i)+"]","") return strs # [ 连续网页爬取的对象 ]

class WebConnector:

profile = ""

sw = "" # ---[定义构造方法]

def __init__(self):

self.profile = webdriver.Firefox()

self.profile.get('https://baike.baidu.com/') # ---[定义释放方法]

def __close__(self):

self.profile.quit() # 获取 url 的内部 HTML 代码

def getHTMLText(self):

a = self.profile.page_source

return a # 获取页面内的基本链接

def getFirstChanel(self):

index_html = self.getHTMLText()

index_sel = parsel.Selector(index_html)

links = index_sel.css('.lemma-summary').extract()[0]

tpl = StrSpecialDealer.simpleDeal(str(links))

tpl = StrSpecialDealer.beat(tpl,20)

tpl = StrSpecialDealer.deleteRe(tpl)

tpl = StrSpecialDealer.ut_date(tpl)

return tpl def getMore(self,refers):

self.profile.find_element_by_id("query").clear()

self.profile.find_element_by_id("query").send_keys(refers)

self.profile.find_element_by_id("search").click()

time.sleep(1) def main():

wc = WebConnector()

wc.getMore("人工智能")

s = wc.getFirstChanel()

print(s)

wc.getMore("5G")

t = wc.getFirstChanel()

print(t)

wc.__close__() main()

test.py

嗯,然后我继续整合,将数据导入成文件批处理

对应代码:

import parsel

from urllib import request

import codecs

from selenium import webdriver

import time # [ 整理后的数据 ]

class Info: # ---[ 方法区 ]

# 构造方法

def __init__(self,name,num,more):

self.name = name

self.num = num

self.more = more def __toString__(self):

return (self.name+"\t"+str(self.num)+"\t"+self.more) def __toSql__(self,table):

return ("Insert into "+table+" values ('"+self.name+"',"+self.num+",'"+self.more+"');") # ---[ 数据区 ]

# 名称

name = ""

# 频数

num = 0

# 中文解释

more = 0 # [写文件的方法集合]

class FileToWebAndContent: fileReaderPath = ""

wc = ""

sw = "" def __init__(self,r,w):

self.fileReaderPath = r

self.wc = WebConnector()

self.sw = StringWriter(w)

self.sw.makeFileNull() def __free__(self):

self.wc.__close__() def __deal__(self):

fw = open(self.fileReaderPath, mode='r', encoding='utf-8')

lines = fw.readlines()

num = lines.__len__()

for i in range(0,num):

str_line = lines[i]

gr = str_line.split("\t")

name_b = StrSpecialDealer.simpleDeal(gr[0])

num_b = StrSpecialDealer.simpleDeal(gr[1])

if(int(num_b)<=2):

break

self.wc.getMore(name_b)

more_b = self.wc.getFirstChanel()

if(more_b==""):

continue

info = Info(name_b,num_b,more_b)

self.sw.write(info.__toString__()) # [ 对字符串的特殊处理方法-集合 ]

class StrSpecialDealer:

# 取得当前标签内的文本

@staticmethod

def getReaction(stri):

strs = StrSpecialDealer.simpleDeal(str(stri))

strs = strs[strs.find('>')+1:strs.rfind('<')]

return strs # 去除基本的分隔符

@staticmethod

def simpleDeal(stri):

strs = str(stri).replace(" ", "")

strs = strs.replace("\t", "")

strs = strs.replace("\r", "")

strs = strs.replace("\n", "")

return strs # 删除所有标签标记

@staticmethod

def deleteRe(stri):

strs = str(stri)

st = strs.find('<')

while(st!=-1):

str_delete = strs[strs.find('<'):strs.find('>')+1]

strs = strs.replace(str_delete,"")

st = strs.find('<') return strs # 删除带有 日期 的句子

@staticmethod

def de_date(stri):

lines = str(stri).split("。")

strs = ""

num = lines.__len__()

for i in range(0,num):

st = str(lines[i])

if (st.__contains__("年") | st.__contains__("月")):

pass

else:

strs += st + "。"

strs = strs.replace("。。", "。")

return strs # 取得带有 日期 的句子之前的句子

@staticmethod

def ut_date(stri):

lines = str(stri).split("。")

strs = ""

num = lines.__len__()

for i in range(0, num):

st = str(lines[i])

if (st.__contains__("年")| st.__contains__("月")):

break

else:

strs += st + "。"

strs = strs.replace("。。","。")

return strs @staticmethod

def beat(stri,num):

strs = str(stri)

for i in range(0,num):

strs = strs.replace("["+str(i)+"]","") return strs # [写文件的方法集合]

class StringWriter:

filePath = "" def __init__(self,str):

self.filePath = str

pass def makeFileNull(self):

f = codecs.open(self.filePath, "w+", 'utf-8')

f.write("")

f.close() def write(self,stri):

f = codecs.open(self.filePath, "a+", 'utf-8')

f.write(stri + "\n")

f.close() # [ 连续网页爬取的对象 ]

class WebConnector:

profile = ""

sw = "" # ---[定义构造方法]

def __init__(self):

self.profile = webdriver.Firefox()

self.profile.get('https://baike.baidu.com/')

# self.sw = StringWriter("../testFile/rc/moreinfo.txt")

# self.sw.makeFileNull() # ---[定义释放方法]

def __close__(self):

self.profile.quit() # 获取 url 的内部 HTML 代码

def getHTMLText(self):

a = self.profile.page_source

return a # 获取页面内的基本链接

def getFirstChanel(self):

try:

index_html = self.getHTMLText()

index_sel = parsel.Selector(index_html)

links = index_sel.css('.lemma-summary').extract()[0]

tpl = StrSpecialDealer.simpleDeal(str(links))

tpl = StrSpecialDealer.beat(tpl, 20)

tpl = StrSpecialDealer.deleteRe(tpl)

tpl = StrSpecialDealer.ut_date(tpl)

return tpl

except:

return "" def getMore(self,refers):

self.profile.find_element_by_id("query").clear()

self.profile.find_element_by_id("query").send_keys(refers)

self.profile.find_element_by_id("search").click()

time.sleep(1) def main():

ftwac = FileToWebAndContent("../testFile/rc/output.txt", "../testFile/rc/moreinfo.txt")

ftwac.__deal__()

ftwac.__free__() main()

MoreInfo.py

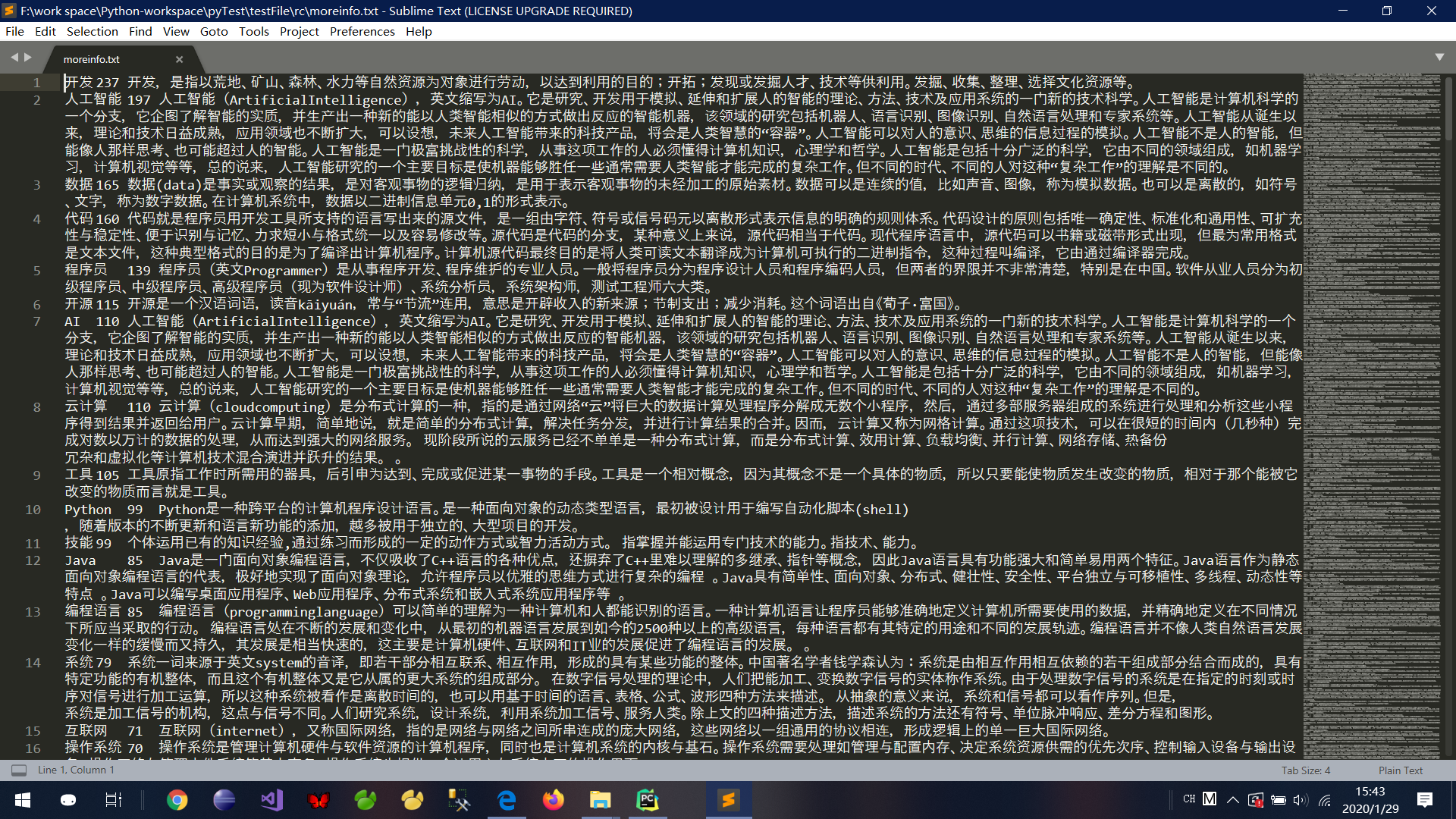

对应得到文件截图:

Python 爬取 热词并进行分类数据分析-[拓扑数据]的更多相关文章

- Python 爬取 热词并进行分类数据分析-[解释修复+热词引用]

日期:2020.02.02 博客期:141 星期日 [本博客的代码如若要使用,请在下方评论区留言,之后再用(就是跟我说一声)] 所有相关跳转: a.[简单准备] b.[云图制作+数据导入] c.[拓扑 ...

- Python 爬取 热词并进行分类数据分析-[热词分类+目录生成]

日期:2020.02.04 博客期:143 星期二 [本博客的代码如若要使用,请在下方评论区留言,之后再用(就是跟我说一声)] 所有相关跳转: a.[简单准备] b.[云图制作+数据导入] c.[ ...

- Python 爬取 热词并进行分类数据分析-[云图制作+数据导入]

日期:2020.01.28 博客期:136 星期二 [本博客的代码如若要使用,请在下方评论区留言,之后再用(就是跟我说一声)] 所有相关跳转: a.[简单准备] b.[云图制作+数据导入](本期博客) ...

- Python 爬取 热词并进行分类数据分析-[简单准备] (2020年寒假小目标05)

日期:2020.01.27 博客期:135 星期一 [本博客的代码如若要使用,请在下方评论区留言,之后再用(就是跟我说一声)] 所有相关跳转: a.[简单准备](本期博客) b.[云图制作+数据导入] ...

- Python 爬取 热词并进行分类数据分析-[数据修复]

日期:2020.02.01 博客期:140 星期六 [本博客的代码如若要使用,请在下方评论区留言,之后再用(就是跟我说一声)] 所有相关跳转: a.[简单准备] b.[云图制作+数据导入] c.[拓扑 ...

- Python 爬取 热词并进行分类数据分析-[App制作]

日期:2020.02.14 博客期:154 星期五 [本博客的代码如若要使用,请在下方评论区留言,之后再用(就是跟我说一声)] 所有相关跳转: a.[简单准备] b.[云图制作+数据导入] c.[拓扑 ...

- Python 爬取 热词并进行分类数据分析-[JSP演示+页面跳转]

日期:2020.02.03 博客期:142 星期一 [本博客的代码如若要使用,请在下方评论区留言,之后再用(就是跟我说一声)] 所有相关跳转: a.[简单准备] b.[云图制作+数据导入] c.[拓扑 ...

- Python 爬取 热词并进行分类数据分析-[热词关系图+报告生成]

日期:2020.02.05 博客期:144 星期三 [本博客的代码如若要使用,请在下方评论区留言,之后再用(就是跟我说一声)] 所有相关跳转: a.[简单准备] b.[云图制作+数据导入] c.[拓扑 ...

- Python爬取热搜存入数据库并且还能定时发送邮件!!!

一.前言 微博热搜榜每天都会更新一些新鲜事,但是自己处于各种原因,肯定不能时刻关注着微博,为了与时代接轨,接受最新资讯,就寻思着用Python写个定时爬取微博热搜的并且发送QQ邮件的程序,这样每天可以 ...

随机推荐

- Bugku-CTF之本地包含( 60)

Day36

- Maven快速创建SpringMVC web(1)

Maven快速创建SpringMVC web工程详解 转自:http://blog.csdn.net/cndmss/article/details/52184836

- Educational Codeforces Round 76 (Rated for Div. 2) B. Magic Stick

Recently Petya walked in the forest and found a magic stick. Since Petya really likes numbers, the f ...

- swiper移动端全屏播放动态获取数据

html: <link rel="stylesheet" href="css/swiper.min.css"> <div class=& ...

- 【PAT甲级】1111 Online Map (30分)(dijkstra+路径记录)

题意: 输入两个正整数N和M(N<=500,M<=N^2),分别代表点数和边数.接着输入M行每行包括一条边的两个结点(0~N-1),这条路的长度和通过这条路所需要的时间.接着输入两个整数表 ...

- Unity UGUI事件接口概述

UGUI 系统虽然提供了很多封装好的组件,但是要实现一些特定的功能还是显得非常有限,这时候就需要使用事件接口来完成UI功能的实现.比如我们想实现鼠标移动到图片上时自动显示图片的文字介绍,一般思路会想到 ...

- 苗条的生成树 Slim Span--洛谷

传送门 钢哥终于没给黑题紫题了(卑微v 稍稍需要多想一点点 ---------------------------------------------------------------------- ...

- 6_8 树(UVa548)<从中序和后序恢复二叉树>

你的任务是找出一棵二叉树中最小路径上终端节点(树叶,leaf node)的值.所谓路径乃指从根节点(root)旅行到任一终端节点.路径的值为所经过的节点的值的和(包含根节点及终端节点).而最小路径就是 ...

- oracle 11g快捷版的安装与使用

oracle 11g快捷版的安装与使用 [oracle 11g 下载地址(]https://www.oracle.com/technetwork/cn/database/enterprise-edit ...

- 获得APP的包名package和activity

方法一: Aapt dumpbadging xxxx.apk(包的路径) 第一个框为包名 第二个框为主Activity名 方法二: 如果你装了Appium 可以这么操作下 进入设置页,选择APK 路 ...