Spark开发环境搭建(IDEA、Scala、SVN、SBT)

软件版本

| 软件名称 | 版本 | 下载地址 | 备注 |

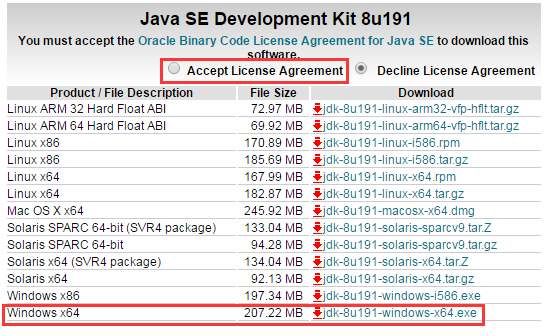

| Java | 1.8 | https://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html | 64位版本的 |

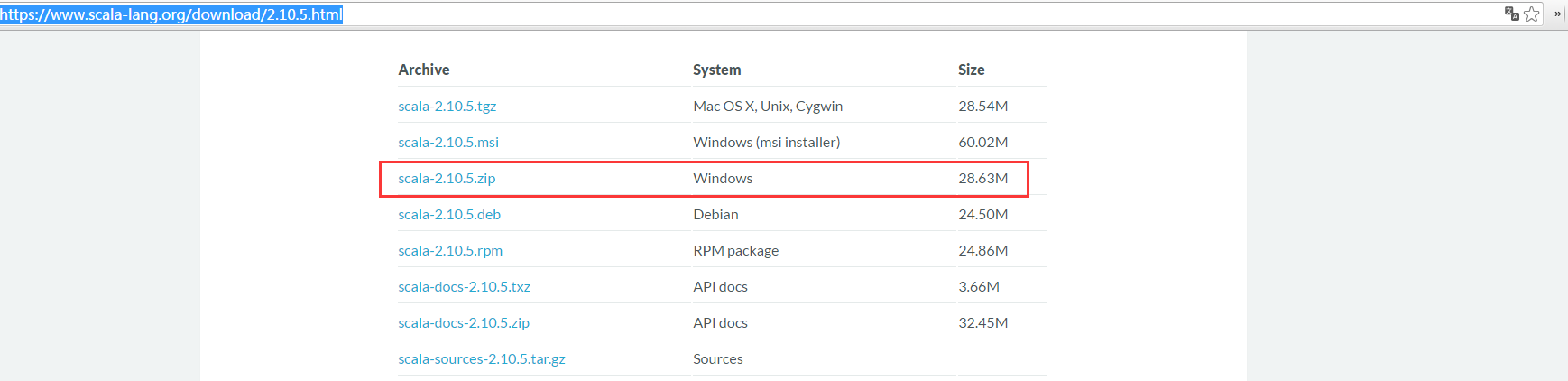

| Scala | 2.10.5 | https://www.scala-lang.org/download/2.10.5.html | |

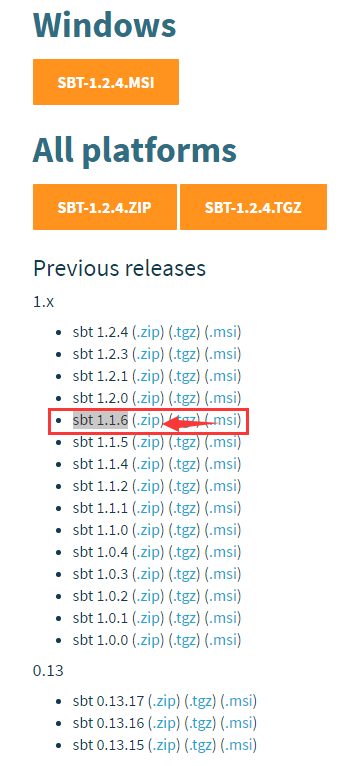

| SBT | sbt 1.1.6 | https://www.scala-sbt.org/download.html | |

| SVN | 最新版本 | https://tortoisesvn.net/downloads.html | 64位版本 |

| IDEA | http://www.jetbrains.com/idea/ |

安装JDK

下载JDK

安装JDK

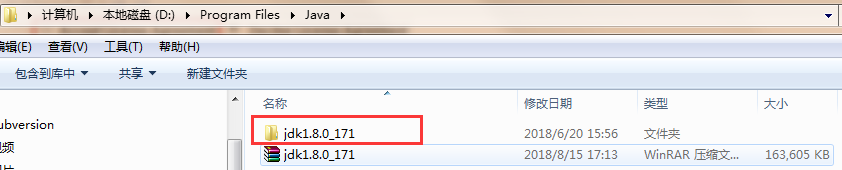

下载后直接安装就好了,设置一下安装路径:D:\Program Files\Java

安装完后的文件结构(我的版本是171的)

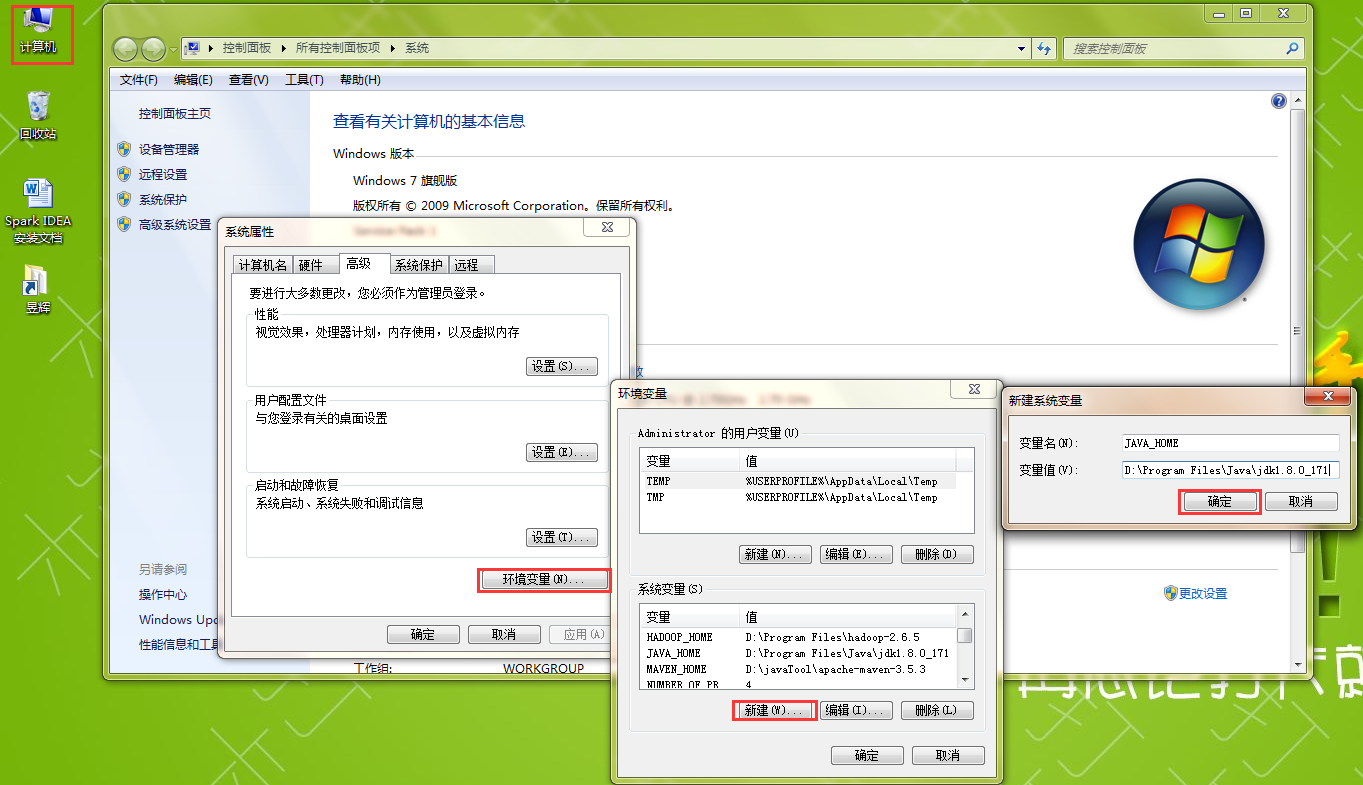

配置环境变量

创建JAVA_HOME:

配置path:%JAVA_HOME%\bin;

查看安装情况

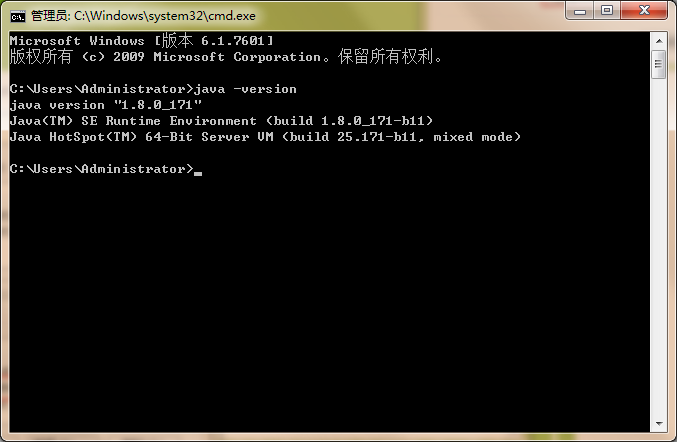

打开cmd终端 输入java -version

出现java版本号则表示安装成功

安装Scala

下载Scala

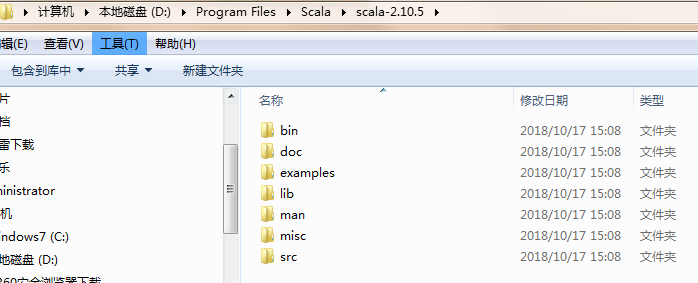

安装Scala

直接解压到D:\Program Files\Scala

解压后文件结构

配置环境变量

参考JDK环境变量设置

查看安装情况

输入scala,出现版本号则表示安装成功

安装SVN

下载SVN

安装SVN

制定安装路径:D:\javaTool

这里有个要注意的地方

command line client tools 选项一定要勾选上,否则IDEA配置的时候会找不到svn.exe

配置环境变量

参考JDK环境变量的配置

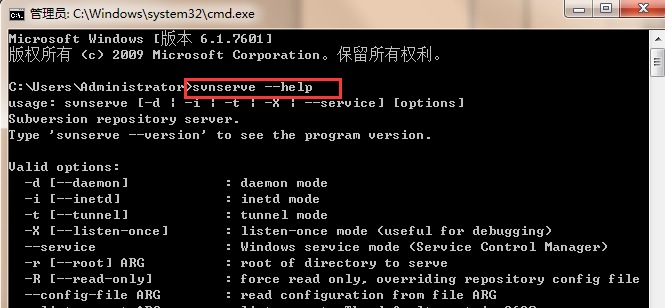

查看安装情况

执行svnserve --help,出现一下页面

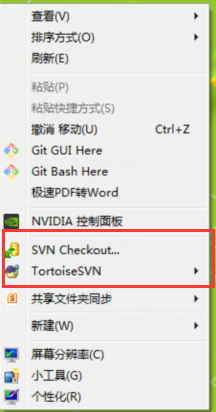

桌面任意位置右键,出现

安装SBT

下载SBT

安装SBT

解压到D:\javaTool,文件结构如下

配置环境变量

参考JDK环境变量设置

配置SBT

repo.repositories

进入D:\javaTool\sbt\conf 下

创建一个文件repo.repositories

编辑以下内容

[repositories]

local

cloudera: https://repository.cloudera.com/artifactory/cloudera-repos/

aliyun: http://maven.aliyun.com/nexus/content/groups/public/

- maven-local: D:/javaTool/mavenLocalRepository cloudera:这是cdh版本的库,如果使用的是cloudera的hadoop全家桶需要使用这个库

aliyun:阿里云的库,国内的比较快

maven-local:因为我还配置了一个Maven,所以可以吧maven的本地仓库加进来,如果没有就不需要加了。

以上是repo.repositories文件的内容

修改完后如下

sbtconfig

编辑sbtconfig文件输入以下内容

# Set the java args to high

-Xmx512M -XX:MaxPermSize=256m -XX:ReservedCodeCacheSize=128m # Set the extra SBT options -Dsbt.log.format=true -Dsbt.ivy.home=D:/javaTool/sbt/ivy

-Dsbt.global.base=D:/javaTool/sbt/.sbt

-Dsbt.repository.config=D:/javaTool/sbt/conf/repo.properties

-Dsbt.log.format=true 说明:前一部分是jvm的一些配置

-Dsbt.ivy.home:是本地库,类似与maven的本地库

-Dsbt.repository.config:指定使用的配置文件

另外另个还没去查找啥意思

配置完如下

到目前为止sbt配置部分就结束了,接下来只要到开一个命令行输入sbt,不出意外的话sbt就会构建成功,会生成D:/javaTool/sbt/ivy等等

但是可能是版本原因,配置的本地仓库并没有生效,jar还是下载到了C盘,在查找资料后,发现还有另一个地方需要配置。

D:\javaTool\sbt\bin\sbt-launch.jar

配置文件是在D:\javaTool\sbt\bin\sbt-launch.jar中的\sbt\sbt.boot.properties中(可用rar解压工具直接打开修改并覆盖,记住是用rar打开文件不需要解压,否则弄不回jar了),修改里面的内容:

[scala]

version: ${sbt.scala.version-auto} [app]

org: ${sbt.organization-org.scala-sbt}

name: sbt

version: ${sbt.version-read(sbt.version)[1.1.6]}

class: ${sbt.main.class-sbt.xMain}

components: xsbti,extra

cross-versioned: ${sbt.cross.versioned-false}

resources: ${sbt.extraClasspath-} [repositories]

local

spring: http://conjars.org/repo/

cloudera: https://repository.cloudera.com/artifactory/cloudera-repos/

aliyun: http://maven.aliyun.com/nexus/content/groups/public/

maven-central

sbt-maven-releases: https://repo.scala-sbt.org/scalasbt/maven-releases/, bootOnly

sbt-maven-snapshots: https://repo.scala-sbt.org/scalasbt/maven-snapshots/, bootOnly

typesafe-ivy-releases: https://repo.typesafe.com/typesafe/ivy-releases/, [organization]/[module]/[revision]/[type]s/[artifact](-[classifier]).[ext], bootOnly

sbt-ivy-snapshots: https://repo.scala-sbt.org/scalasbt/ivy-snapshots/, [organization]/[module]/[revision]/[type]s/[artifact](-[classifier]).[ext], bootOnly [boot]

directory: ${sbt.boot.directory-${sbt.global.base-${user.home}/.sbt}/boot/}

lock: ${sbt.boot.lock-true} [ivy]

ivy-home: D:/javaTool/sbt/ivy

checksums: ${sbt.checksums-sha1,md5}

override-build-repos: ${sbt.override.build.repos-false}

repository-config: ${sbt.repository.config-${sbt.global.base-${user.home}/.sbt}/repositories}

修改后如下:

查看安装情况

再终端执行sbt

经测试,此时下载的jar会放在D:/javaTool/sbt/ivy中,即自己设置的本地库中

安装IDEA

因为我的IDEA早就安装完了,所以在网上找了个教程,参照下面教程就可以把IDEA安装完毕

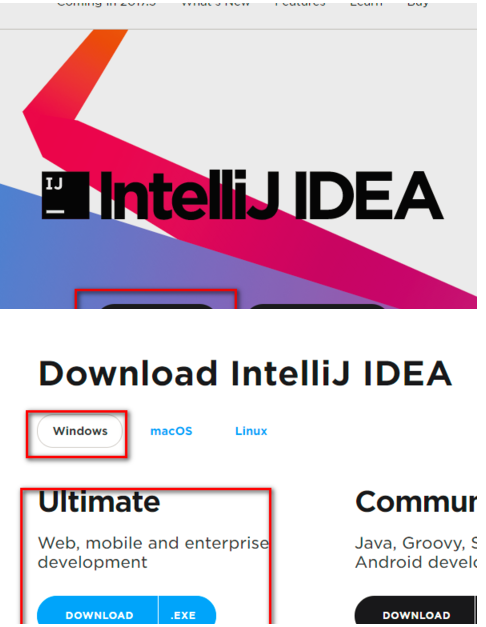

下载IDEA

关于JDK版本,在scala的官网上有这么一段话

Installation

1.Make sure you have the Java 8 JDK (also known as 1.8)

o Run javac -version on the command line and make sure you seejavac 1.8.___

o If you don’t have version 1.8 or higher, install the JDK

2.Next, download and install IntelliJ Community Edition

3.Then, after starting up IntelliJ, you can download and install the Scala plugin by following the instructions on how to install IntelliJ plugins (search for “Scala” in the plugins menu.)

When we create the project, we’ll install the latest version of Scala. Note: If you want to open an existing Scala project, you can click Open when you start IntelliJ.

大概意思是 需要1.8以上版本的jdk,所以我们需要安装jdk1.8或以上版本

IntelliJ IDEA有免费的社区版(Community Edition)和收费的旗舰版(Ultimate Edition),我安装的是社区版本

安装IDEA

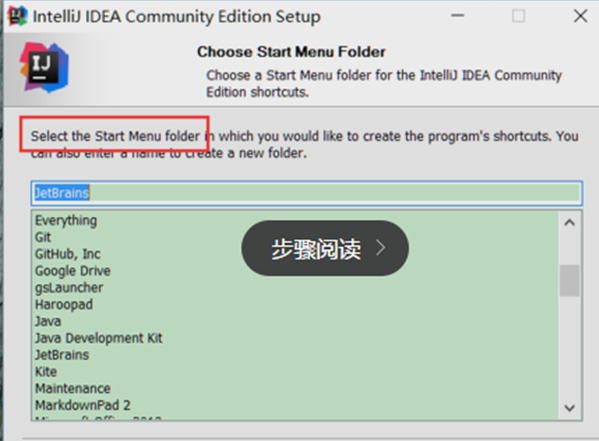

Windows版本安装比较简单,找到我们下载好的exe执行文件,傻瓜式安装,其中的一些选项建议参考下面的

将IDEA安装到:D:\javaTool

操作系统位数选择,大家选择自己操作系统的位数,还有需要安装的一些插件

接下来就是选择我们的菜单,然后点击【install】安装就会进入安装过程

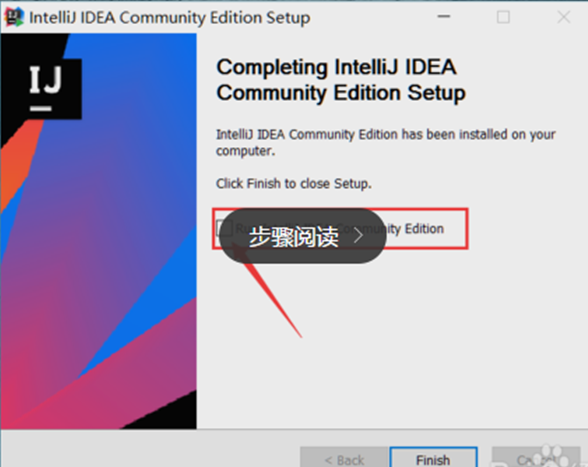

安装完成后,会出现下图【finish】,结束按钮,上面的选项是问我们是否现在打开IDEA

到现在,我们的安装过程就讲完了,我们讲解下如何配置IDEA,假如已经有配置的话,可以直接导入之前的配置,我们选择不导入配置

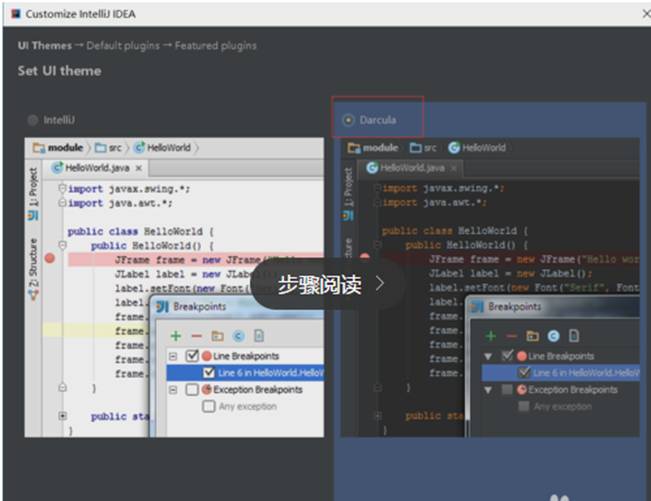

开始进入配置,首先配置的是IDEA的主题颜色,这里选择了黑色的炫酷色

接下来是设置IDEA的一些默认的plugins,也就是默认的插件,大家根据自己的开发需要选择

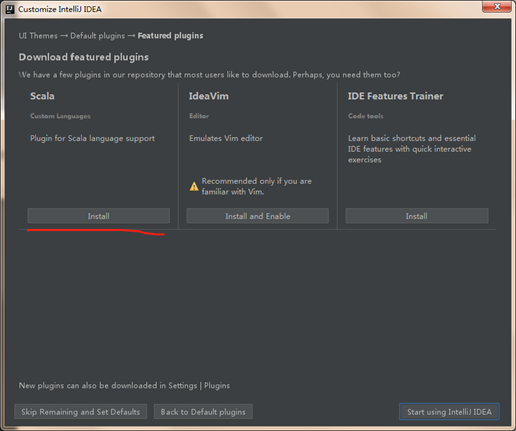

选择,一些第三方的编辑方式,例如vim,可以方便我们在键盘上跳舞,如果要进行scala开发 不建议在此处选择scala插件,下载实在太慢了,可以进入idea后在setting中的plugins中下载插件或者添加已下载的插件

接下来就可以直接开始使用我们的IDEA啦

IDEA的配置

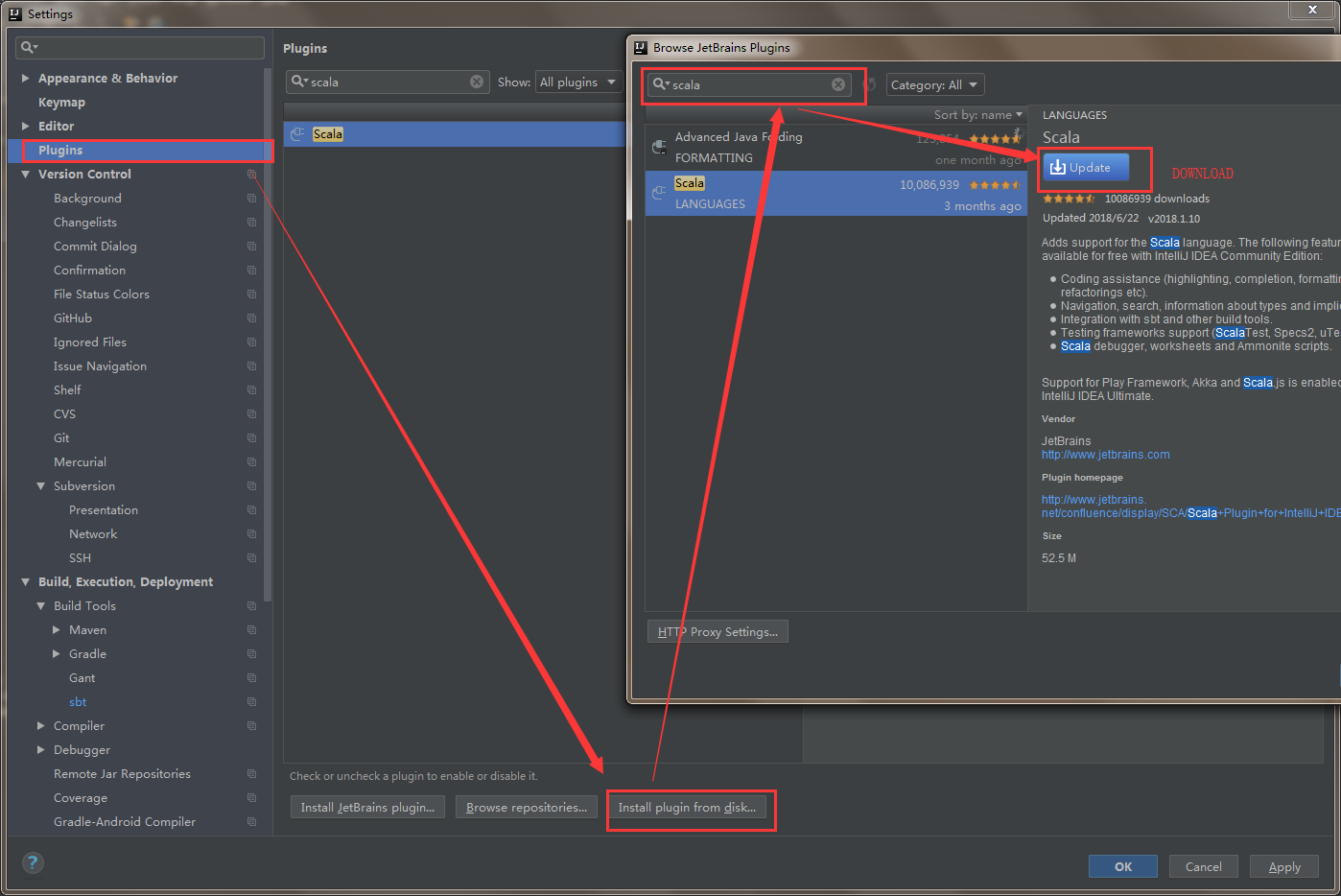

Scala插件安装

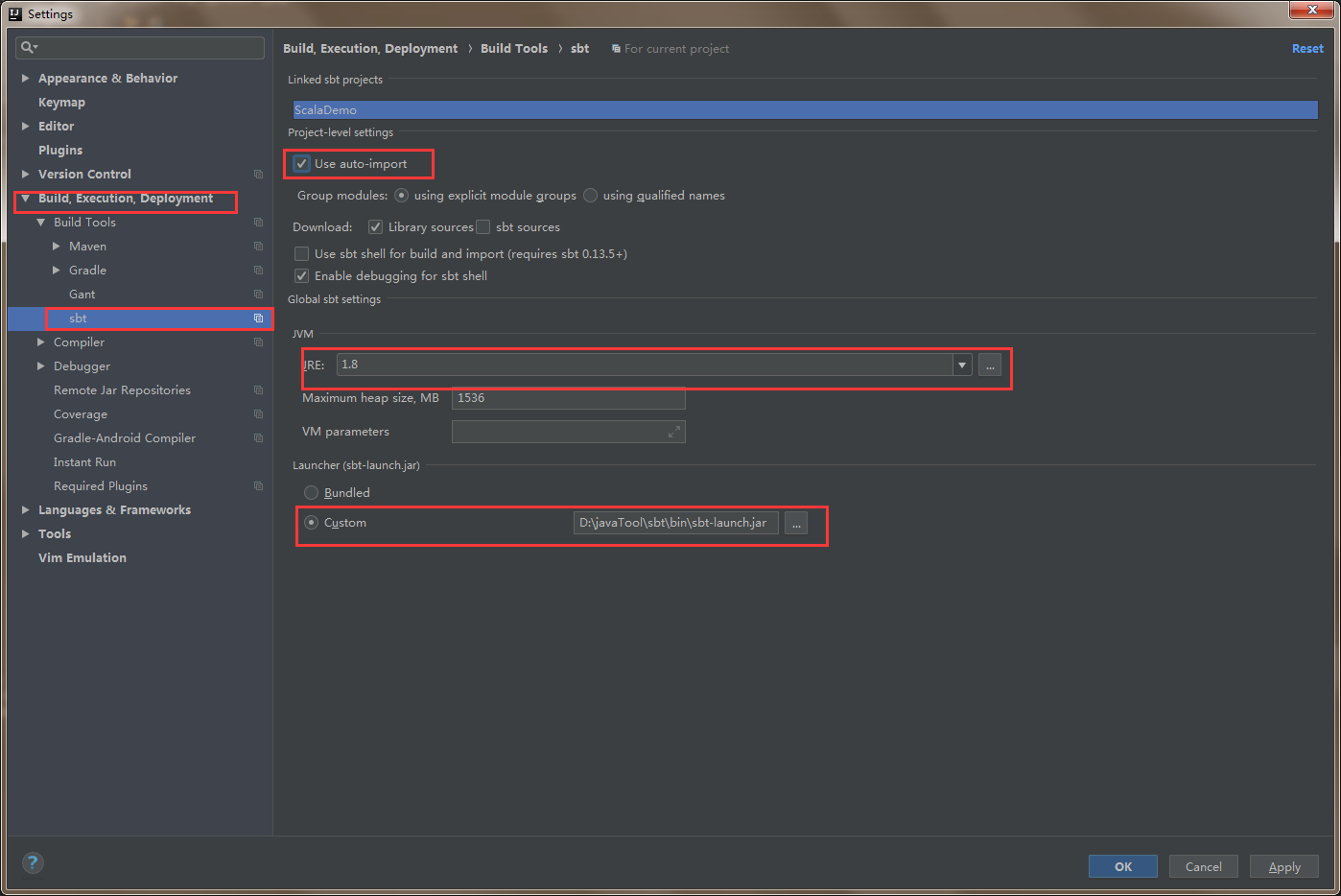

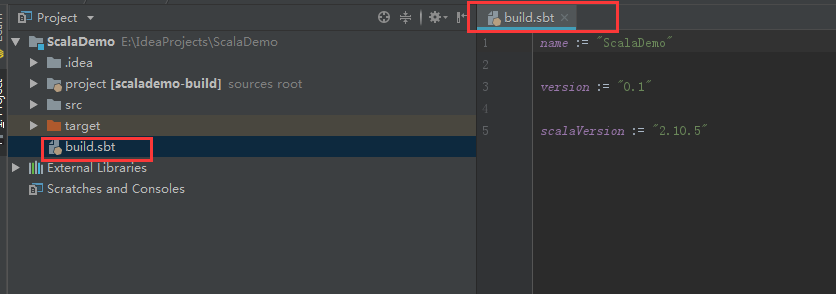

SBT配置

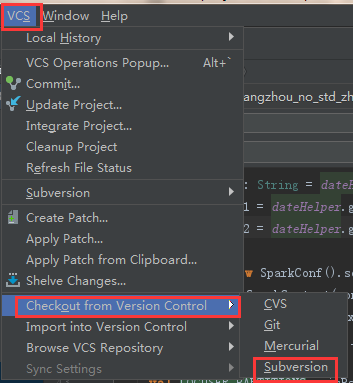

SVN配置

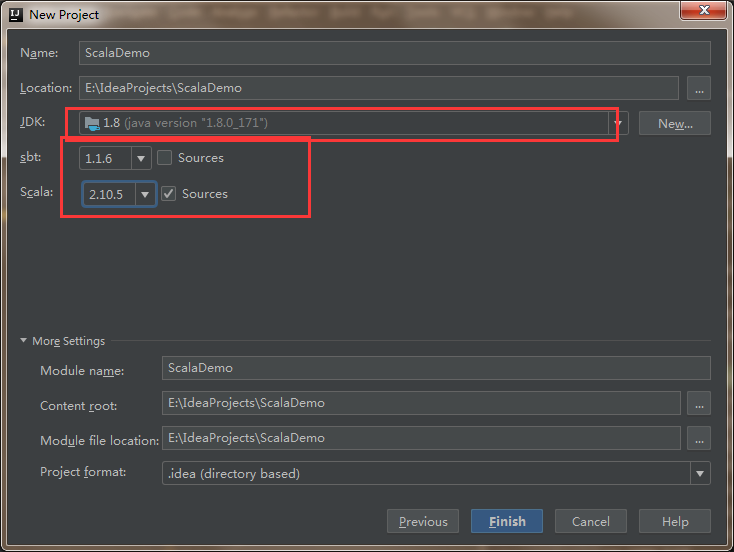

项目配置

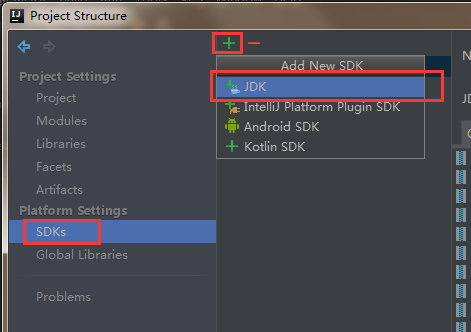

配置JDK

配置scala

至此配置如果不出意外应该在你的build文件加入相关依赖后,会自动下载相关的jar

最后一点在IDEA中使用SVN

剩下的看着就知道怎么弄了这里就不累赘了

还有更新和提交代码

搞定

遇到的问题(不定期更新)

1、在添加svn项目的时候,由于svn的目录(建议类似的目录不要包含空格和中文)带有中文,

导致项目虽然加进了idea,但是在本地测试的时候由于中文的乱满会导致一些奇怪的错,这个好像是idea的bug,eclipse就没有这样的问题。

解决办法,在导入svn项目的时候,本地存储路径修改为不含有中文和空的的路径即可

Spark开发环境搭建(IDEA、Scala、SVN、SBT)的更多相关文章

- Spark 开发环境搭建

原文见 http://xiguada.org/spark-develop/ 本文基于Spark 0.9.0,由于它基于Scala 2.10,因此必须安装Scala 2.10,否则将无法运行Spar ...

- 【原创干货】大数据Hadoop/Spark开发环境搭建

已经自学了好几个月的大数据了,第一个月里自己通过看书.看视频.网上查资料也把hadoop(1.x.2.x).spark单机.伪分布式.集群都部署了一遍,但经历短暂的兴奋后,还是觉得不得门而入. 只有深 ...

- Spark编译及spark开发环境搭建

最近需要将生产环境的spark1.3版本升级到spark1.6(尽管spark2.0已经发布一段时间了,稳定可靠起见,还是选择了spark1.6),同时需要基于spark开发一些中间件,因此需要搭建一 ...

- Spark开发环境搭建和作业提交

Spark高可用集群搭建 在所有节点上下载或上传spark文件,解压缩安装,建立软连接 配置所有节点spark安装目录下的spark-evn.sh文件 配置slaves 配置spark-default ...

- HBase、Hive、MapReduce、Hadoop、Spark 开发环境搭建后的一些步骤(export导出jar包方式 或 Ant 方式)

步骤一 若是,不会HBase开发环境搭建的博文们,见我下面的这篇博客. HBase 开发环境搭建(Eclipse\MyEclipse + Maven) 步骤一里的,需要补充的.如下: 在项目名,右键, ...

- 【Spark机器学习速成宝典】基础篇01Windows下spark开发环境搭建+sbt+idea(Scala版)

注意: spark用2.1.1 scala用2.11.11 材料准备 spark安装包 JDK 8 IDEA开发工具 scala 2.11.8 (注:spark2.1.0环境于scala2.11环境开 ...

- Spark学习之路(二)—— Spark开发环境搭建

一.安装Spark 1.1 下载并解压 官方下载地址:http://spark.apache.org/downloads.html ,选择Spark版本和对应的Hadoop版本后再下载: 解压安装包: ...

- Spark 系列(二)—— Spark开发环境搭建

一.安装Spark 1.1 下载并解压 官方下载地址:http://spark.apache.org/downloads.html ,选择 Spark 版本和对应的 Hadoop 版本后再下载: 解压 ...

- 入门大数据---Spark开发环境搭建

一.安装Spark 1.1 下载并解压 官方下载地址:http://spark.apache.org/downloads.html ,选择 Spark 版本和对应的 Hadoop 版本后再下载: 解压 ...

随机推荐

- tp备份数据

<?php namespace Chenlin2103\Controller; class BaksqlController extends MainController{ public $co ...

- install openjdk & tomcat on the centos

1.检查当前服务器是否已安装openjdk

- shell脚本学习总结(不断更新中)

前言:自从大学毕业参加工作以来,接触的开发工作都是在服务端完成,于是接触了比较多的Linux当做开发机使用,或多或少有一些重复性的工作,于是开始琢磨学习一些shell脚本的知识,以便处理这些繁琐的事情 ...

- ForkJoinPool 源码

ForkJoinPool----FJP先看task.fork方法,含义是将当前任务,放到当前线程的工作队列中.但是第一次执行这个方法是在主线程中,主线程是不可能被FJP管理的.那么就进入ForkJoi ...

- Centos6.5 安装 RabbitMQ 3.7.11

RabbitMQ是一个开源的AMQP实现,服务器端用Erlang语言编写,支持多种客户端,如:Python.Ruby..NET.Java.JMS.C.PHP.ActionScript.XMPP.STO ...

- java第七周----json

JSON(JavaScript Object Notation, JS 对象标记) 是一种轻量级的数据交换格式.它基于 ECMAScript (欧洲计算机协会制定的js规范)的一个子集,采用完全独立于 ...

- ABP中mapping中忽略属性

创建一个XXXXProfile继承Profile,然后在构造函数中写忽略相关的,如下 public class ProductPriceDtoProfile: Profile { /// <su ...

- JAVA高级-面试题总结

最近面试了一些公司,针对面试中遇到的问题在此记录,提升自己,造福大家 一.java源码相关 ArrayList创建和add等各种api使用原理 HashMap 的创建,put原理,和HashTable ...

- Qt设置创建部分半透明,上面控件不透明

//头文件#pragma once #include <QWidget> #include "ui_widgetFullAD.h" class widgetFullAD ...

- 4--TestNG测试报告

第一:自带测试报告(略) 第二:Reportng测试报告(略) 第三:ExtentReport--extentreports.com (1) pom.xml:不是总的pom,是文件夹下的pom < ...