Graph Regularized Feature Selection with Data Reconstruction

Abstract

• 从图正则数据重构方面处理无监督特征选择;

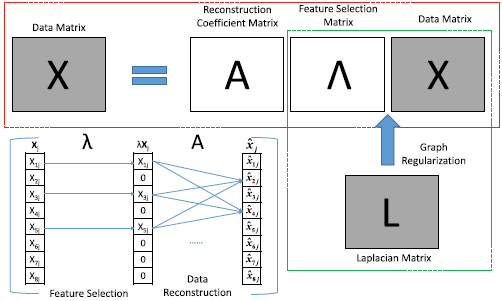

• 模型的思想是所选特征不仅通过图正则保留了原始数据的局部结构,也通过线性组合重构了每个数据点;

• 所以重构误差成为判断所选特征质量的自然标准。

• 通过最小化重构误差,选择最好保留相似性和判别信息的特征;

1 Introduction

• 目前有两大类无监督特征选择算法:Similarity preserving 和 clustering performance maximization;Similarity preserving 算法选择最好保留原始数据的局部结构的代表性特征。例如,如果数据点在原始空间分布很近,那么在选择的特征上也应该分布很近;clustering performance maximization 选择能最大化某个聚类标准的判别特征。例如,引入伪标签选择最大化数据聚类效果的判别特征。

• 模型的目标是选择能同时最好保留数据在原始空间的局部结构和判别信息的特征。

• highlight:

(1)从图正则数据重构的角度考虑无监督特征选择问题。通过最小化图正则重构误差,我们选择了最好保留数据结构和判别信息的特征;

(2)通过在混合目标函数上的稀疏学习考虑特征选择问题。引入了一个 l1-norm 稀疏项作用于特征选择矩阵,特征选择矩阵的稀疏性减少了冗余和噪声特征;

(3)提出了一个迭代梯度算法。

2 Related Work

2.1 Similarity Preserving Based Feature Selection

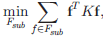

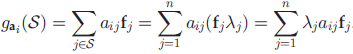

f 是特征向量,K 是预先定义的 Affinity 矩阵。因此,与流形结构相一致的特征被认为是重要的。

2.2 Clustering Based Feature Selection

clustering based feature selection 目标是选择判别特征

3 The Problem Of Graph Regularized Feature Selection With Data Reconstruction

进行了一些符号说明

特征选择矩阵的学习同时保留了数据重构过程和图正则化过程。

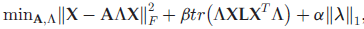

4 The Objective Function

• 我们希望原始数据在所选特征上有一个紧致的表示,即 信息损失最小以及数据的局部结构也得到保留;

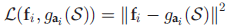

• 从所选特征上重构原始数据第 i 维的信息损失表示为:

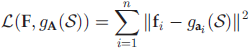

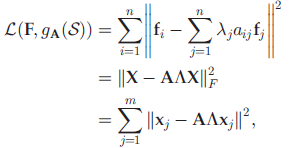

全局数据重构误差为:

• 进一步,局部不变性。如果两个数据点在原始空间距离相近,那么在所选特征的投影上距离也相近。

• 进一步,局部不变性。如果两个数据点在原始空间距离相近,那么在所选特征的投影上距离也相近。

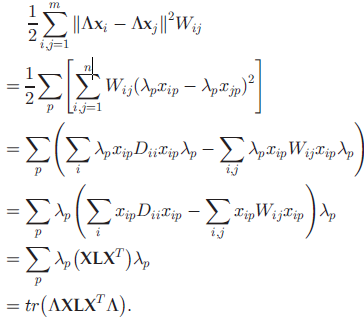

通过最小化下式,保留数据在所选特征上的局部几何信息:

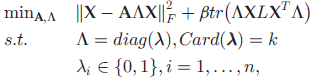

• 模型为:

但是上述模型难以求解,需要分支定界法。于是将约束放松

beta 是平衡对判别信息和相似性的保留。当 beta 较大时,保留相似性。当 beta 较小时,保留判别信息;alpha 控制所选特征的数目。

5 The Optimization

6 Experiment Results

7 Conclusion

判别信息通过最小化数据重构误差保留,相似性通过图正则保留。

Graph Regularized Feature Selection with Data Reconstruction的更多相关文章

- 【转】[特征选择] An Introduction to Feature Selection 翻译

中文原文链接:http://www.cnblogs.com/AHappyCat/p/5318042.html 英文原文链接: An Introduction to Feature Selection ...

- 单因素特征选择--Univariate Feature Selection

An example showing univariate feature selection. Noisy (non informative) features are added to the i ...

- Feature Selection Can Reduce Overfitting And RF Show Feature Importance

一.特征选择可以减少过拟合代码实例 该实例来自机器学习实战第四章 #coding=utf-8 ''' We use KNN to show that feature selection maybe r ...

- highly variable gene | 高变异基因的选择 | feature selection | 特征选择

在做单细胞的时候,有很多基因属于noise,就是变化没有规律,或者无显著变化的基因.在后续分析之前,我们需要把它们去掉. 以下是一种找出highly variable gene的方法: The fea ...

- 机器学习-特征选择 Feature Selection 研究报告

原文:http://www.cnblogs.com/xbinworld/archive/2012/11/27/2791504.html 机器学习-特征选择 Feature Selection 研究报告 ...

- the steps that may be taken to solve a feature selection problem:特征选择的步骤

參考:JMLR的paper<an introduction to variable and feature selection> we summarize the steps that m ...

- The Practical Importance of Feature Selection(变量筛选重要性)

python机器学习-乳腺癌细胞挖掘(博主亲自录制视频) https://study.163.com/course/introduction.htm?courseId=1005269003&u ...

- [Feature] Feature selection

Ref: 1.13. Feature selection Ref: 1.13. 特征选择(Feature selection) 大纲列表 3.1 Filter 3.1.1 方差选择法 3.1.2 相关 ...

- [Feature] Feature selection - Embedded topic

基于惩罚项的特征选择法 一.直接对特征筛选 Ref: 1.13.4. 使用SelectFromModel选择特征(Feature selection using SelectFromModel) 通过 ...

随机推荐

- 通过HTML和CSS1:1还原风暴英雄官方网站

<!--HTML代码--> <!DOCTYPE html> <html lang="en"> <head> <meta cha ...

- 05.JS函数

前言: 学习一门编程语言的基本步骤(01)了解背景知识(02)搭建开发环境(03)语法规范(04)常量和变量(05)数据类型(06)数据类型转换(07)运算符(08)逻辑结构(09)函数9.函数——f ...

- 解决Fail to post notification on channel "null"的方法

mNotifyMgr = (NotificationManager) getSystemService(NOTIFICATION_SERVICE);mNotifyMgr.cancelAll(); St ...

- 静态存储SRAM设计

SRAM即静态随机存取存储器.它是具有静止存取功能的内存,不需要刷新电路便能保存它内部存储的数据.在工业与科学用的很多子系统,汽车电子等等都用到了SRAM.现代设备中很多都嵌入了几千字节的SRAM.实 ...

- opencv —— setMouseCallback 响应鼠标操作事件

鼠标操作:setMouseCallback 函数 借助回调函数,实现对鼠标每次操作的相应,即每进行一步鼠标操作,都会执行一次回调函数. void setMouseCallback(const stri ...

- junit 运行(eclipse + IDEA)

记得刚用IDEA 开发的时候, 什么都还不熟,以为junit 运行还跟eclipse 一样, 结果试了后才知道是不一样的. 现在刚好写junit 相关的,也就都记录下来吧 Eclipse:eclip ...

- Java-利用位数猜年龄

题目: 美国数学家维纳(N.Wiener)智力早熟,11岁就上了大学.他曾在1935~1936年应邀来中国清华大学讲学.一次,他参加某个重要会议,年轻的脸孔引人注目.于是有人询问他的年龄,他回答说:“ ...

- windows服务踩的坑

最近写了一个windows服务 有一些bug最后终于解决了还是写点经验把. 第一点.版本问题,因为是小白,第一次写windows服务,选择的是.net4.6.1的目标框架,因为我的电脑是windows ...

- Spring的BeanFactory和FactoryBean

官方定义 BeanFactory:Spring Bean容器的根接口 FactoryBean:各个对象的工厂接口,如果bean实现了这个接口,它将被用作对象的工厂,而不是直接作为bean实例. 源码解 ...

- ajax-属性、原理、实现html5进度条上传文件

一.远古ajax实现方式如下: 1.前端请求后台,后台设置返回 http状态码204 2.运用img图片(或css/javascript等)的加载机制,请求后台 3.post提交数据,运用iframe ...