Mac安装Hadoop

软件版本

hadoop3.2.1

一、打开本地ssh登录

# 生成公钥默认

$ ssh-keygen -t rsa -C "robots_wang@163.com" -b 4096

# 拷贝

$ cat ~/.ssh/id_rsa.pub

# 拷贝至电脑信任列表

$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

测试:ssh localhost

二、安装Hadoop

【1】下载地址:

https://archive.apache.org/dist/hadoop/common/

解压:tar -zxvf hadoop-3.2.1.tar.gz -C /Users/mac/SoftWare

【2】配置环境变量

vim ~/.bash_profile

export JAVA_HOME="/Library/Java/JavaVirtualMachines/jdk1.8.0_201.jdk/Contents/Home"

export CLASSPAHT=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH="${JAVA_HOME}:${PATH}"

export HADOOP_HOME=/Users/mac/SoftWare/hadoop-3.2.1

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_OPTS="-Djava.library.path=${HADOOP_HOME}/lib/native"

export PATH=${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:$PATH

source ~/.bash_profile

【3】修改配置文件(cd /Users/mac/SoftWare/hadoop-3.2.1/etc/hadoop)

hadoop-env.sh

修改JAVA_HOME=/Library/Java/JavaVirtualMachines/jdk1.8.0_201.jdk/Contents/Home

core-site.xml

新加

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/Users/mac/SoftWare/Cache/hadoop/tmp</value>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.native.lib</name>

<value>false</value>

<description>Should native hadoop libraries, if present, be used.</description>

</property>

</configuration>

hdfs-site.xml

新加

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/Users/mac/SoftWare/Cache/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.namenode.data.dir</name>

<value>file:/Users/mac/SoftWare/Cache/hadoop/tmp/dfs/data</value>

</property>

</configuration>

mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.application.classpath</name>

<value>$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/*:$HADOOP_MAPRED_HOME/share/hadoop/mapreduce/lib/*</value>

</property>

<!-- spark配置日志 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>localhost:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>localhost:19888</value>

</property>

<!-- 配置正在运行中的日志在hdfs上的存放路径 -->

<property>

<name>mapreduce.jobhistory.intermediate-done-dir</name>

<value>/history/done_intermediate</value>

</property>

<!-- 配置运行过的日志存放在hdfs上的存放路径 -->

<property>

<name>mapreduce.jobhistory.done-dir</name>

<value>/history/done</value>

</property>

</configuration>yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

<!-- 日志设置 -->

<property>

<description>Whether to enable log aggregation</description>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

</configuration>mac的因为/bin/java 的特殊配置

修改

$HADOOP_HOME/libexec/hadoop-config.sh

在注释下新增JAVA_HOME

# do all the OS-specific startup bits here

# this allows us to get a decent JAVA_HOME,

# call crle for LD_LIBRARY_PATH, etc.

export JAVA_HOME=/Library/Java/JavaVirtualMachines/jdk1.8.0_311.jdk/Contents/Home三、启动Hadoop

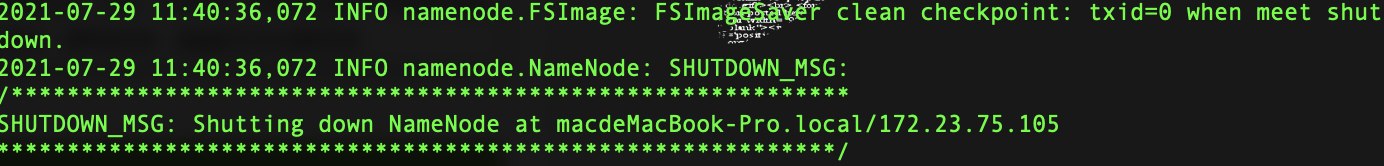

【1】初始化Hadoop仅一次

cd /Users/mac/SoftWare/hadoop-3.2.1/bin

hdfs namenode -format

【2】启动dfs

cd /Users/mac/SoftWare/hadoop-3.2.1/sbin

./start-dfs.sh

域名:http://localhost:9870

HDFS文件系统地址:http://localhost:9870/explorer.html#

Starting namenodes on [localhost]

Starting datanodes

Starting secondary namenodes [account.jetbrains.com]

account.jetbrains.com: Warning: Permanently added 'account.jetbrains.com,0.0.0.0' (ECDSA) to the list of known hosts.

2021-07-29 11:42:41,550 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

【3】启动yarn

./start-yarn.sh

http://localhost:8088

【4】jobhistory的启动与停止

启动: 在hadoop/sbin/目录下执行

./mr-jobhistory-daemon.sh start historyserver

停止:在hadoop/sbin/目录下执行

./mr-jobhistory-daemon.sh stop historyserver

【5】提交spark任务

spark-submit --master yarn --deploy-mode cluster --class org.apache.spark.examples.SparkPi --name SparkPi --num-executors 1 --executor-memory 1g --executor-cores 1 /Users/Robots2/softWare/spark-3.1.3/examples/jars/spark-examples_2.12-3.1.3.jar 100

参考文档

https://blog.csdn.net/pgs1004151212/article/details/104391391

Mac安装Hadoop的更多相关文章

- mac安装Hadoop,mysql,hive,sqoop教程

在安装Hadoop,mysql,hive之前,首先要保证电脑上安装了jdk 一.配置jdk 1. 下载jdk http://www.oracle.com/technetwork/java/javase ...

- Mac OS X Yosemite安装Hadoop 2.6记录

整个安装过程分为四部分: 一. 安装Homebrew 二. ssh localhost 三. 安装Hadoop已经进行配置文件设置 (伪分布式) 四. 执行栗子 一. 安装Homebrew 採用H ...

- 在Linux上安装Hadoop

先决条件: Hadoop是用JAVA写的,所以首先要安装Java.在Ubuntu上安装JDK见:http://blog.csdn.net/microfhu/article/details/766739 ...

- CentOS7 安装Hadoop集群环境

先按照上一篇安装与配置好CentOS以及zookeeper http://www.cnblogs.com/dopeter/p/4609276.html 本章介绍在CentOS搭建Hadoop集群环境 ...

- Mac配置Hadoop最详细过程

Mac配置Hadoop最详细过程 原文链接: http://www.cnblogs.com/blog5277/p/8565575.html 原文作者: 博客园-曲高终和寡 https://www.cn ...

- (第2篇)一篇文章教你轻松安装hadoop

摘要: 这篇文章将会手把手教你安装hadoop,只要你细心按照文章中的步骤操作,hadoop肯定能正确安装,绝对不会让你崩溃 博主福利 给大家赠送一套hadoop视频课程 授课老师是百度 hadoop ...

- ubuntu在虚拟机下的安装 ~~~ Hadoop的安装及配置 ~~~ Hdfs中eclipse的安装

前言 Hadoop是基于Java语言开发的,具有很好跨平台的特性.Hadoop的所要求系统环境适用于Windows,Linux,Mac系统,我们推荐选择使用Linux或Mac系统.而Linux系统则 ...

- CentOS下安装hadoop

CentOS下安装hadoop 用户配置 添加用户 adduser hadoop passwd hadoop 权限配置 chmod u+w /etc/sudoers vi /etc/sudoers 在 ...

- Linux下安装Hadoop完全分布式(Ubuntu12.10)

Hadoop的安装非常简单,可以在官网上下载到最近的几个版本,最好使用稳定版.本例在3台机器集群安装.hadoop版本如下: 工具/原料 hadoop-0.20.2.tar.gz Ubuntu12.1 ...

- Ubuntu安装Hadoop与Spark

更新apt 用 hadoop 用户登录后,我们先更新一下 apt,后续我们使用 apt 安装软件,如果没更新可能有一些软件安装不了.按 ctrl+alt+t 打开终端窗口,执行如下命令: sudo a ...

随机推荐

- 理解Java BlockingQueue

数据结构与算法是天生一对. BlockingQueue叫做阻塞队列,在Java线程池相关的实现中有广泛的使用. BlockingQueue实现的功能如下: 当队列为空时,往队列中读数据将被阻塞. 当队 ...

- canvas(一)描边与填充

1.画布大小 canvas默认的大小是 300*150,通过操作width/height属性可以设置画布的大小,属性值只能是具体是像素值,而不能是百分比. <body> <div c ...

- Nuxt.js 应用中的 beforeResponse 事件钩子

title: Nuxt.js 应用中的 beforeResponse 事件钩子 date: 2024/12/5 updated: 2024/12/5 author: cmdragon excerpt: ...

- 《前端运维》五、k8s--2pod、services与Ingress部署

前一篇啊,我们学完了基本的配置.这一篇,我们来看下服务部署的配置.我们先来看张图,理解下k8s的应用场景和调用流程: 看上图,首先,master是控制节点,负责编排.管理.调度用户提交的作业.kube ...

- vue-elementui 因滚动条引发的table错位问题

修复后效果 在网上看到的方法都是设置样式属性,试过之后也不生效,也不知道原因 所以就自己用原生js解决了,代码如下 //修错位 x(){ var u = document.getElementsByC ...

- 【原创】ARM64 实时linux操作系xenomai4(EVL)构建安装简述

目录 0 环境说明 1 内核构建 2 库编译 方式1 交叉编译 方式2 本地编译 3 测试 单元测试 hectic:EVL 上下文切换 latmus:latency测试 4 RK3588 xenoma ...

- Qt音视频开发42-网络推流(视频推流/本地摄像头推流/桌面推流/网络摄像头转发推流等)

一.前言 上次实现的文件推流,尽管优点很多,但是只能对现在存在的生成好的音视频文件推流,而现在更多的场景是需要将实时的视频流重新推流分发,用户在很多设备比如手机/平板/网页/电脑/服务器上观看,这样就 ...

- Qt编写物联网管理平台47-通用数据库设置

一.前言 为了做这个通用的数据库组件,专门安装了虚拟机来安装各种版本的不同类型的数据库做测试,包括编译对应的数据库插件,我一直坚信的是一切从实际出发+有实际采用发言权,包括不同Qt版本编译mysql. ...

- Qt开源作品44-超级曲线图表

按照国际惯例,先吹吹牛,QCustomPlot这个开源图表组件,作者绝对是全宇宙Qt领域的天花板,设计的极其巧妙和精美,各种情况都考虑到了,将每个功能细分到不同的类,每个类负责管理自己的绘制和各种属性 ...

- Qt开源作品29-NTP服务器时间同步

一.前言 很多软件都有时间同步的功能,尤其是Qt在嵌入式设备上的,有时候还有很多是没有UI界面的程序,而硬件上有个时钟,时间久了难免没有电,需要从服务器来同步时间来保证本地的时间是正确的,不然本地记录 ...