矩池云 | GPU 分布式使用教程之 Pytorch

GPU 分布式使用教程之 Pytorch

Pytorch 官方推荐使用 DistributedDataParallel(DDP) 模块来实现单机多卡和多机多卡分布式计算。DDP 模块涉及了一些新概念,如网络(World Size/Local Rank),代码修改(数据分配加载),多种启动方式(torchrun/launch),使用前请参考官方文档以及更多学习资料。

选择机器

单机多卡分布式:租用同个计算节点的多张卡即可。

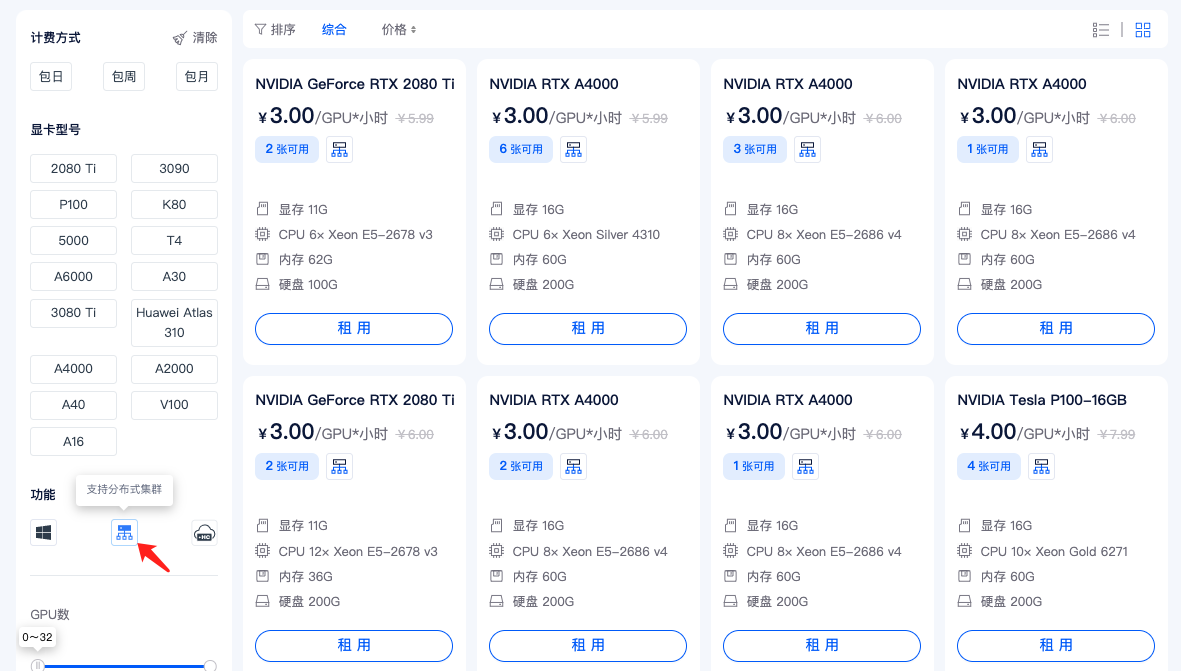

多机多卡分布式:需要先申请开通 分布式集群 功能,点击这里申请开通,在租用时,请选择带有如图所示图标的机器。没有这个图标的机器不支持加入分布式网络。

单机多卡

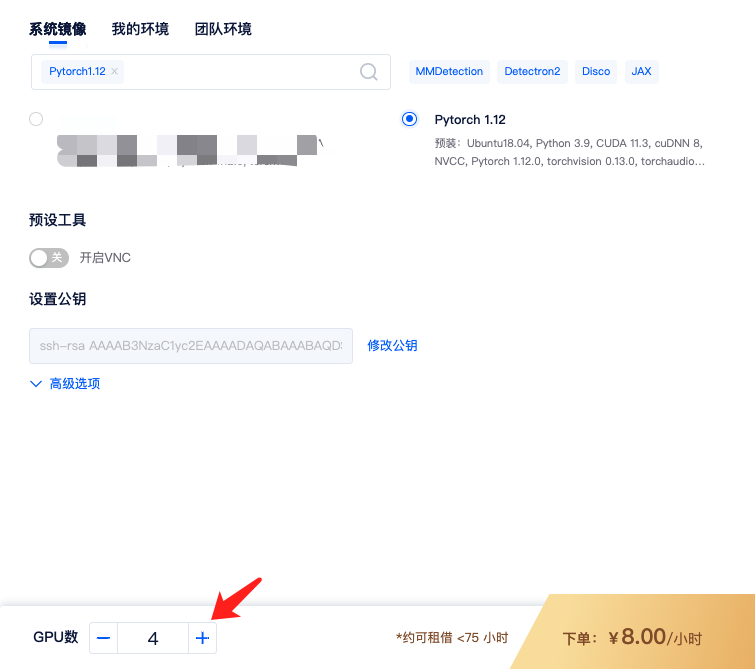

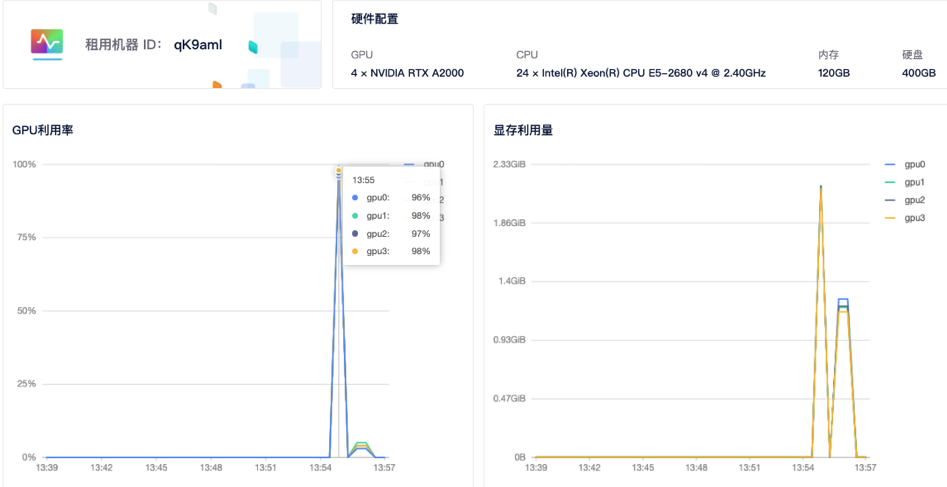

1)租用机器: 为实现Pytorch的单机多卡分布式,首先,您需要按正常流程租用GPU,如单节点 4 卡 A2000,选择Pytorch镜像,如Pytorch 1.12镜像。

租用的时候 GPU 数设置成 4,即表示 4 卡,对应显存、内存等配置也会翻倍。

2)适配代码: 分布式需对脚本进行相应修改,可参考官方文档。此处使用开源demo.py

3)运行代码: 进入运行脚本所在目录,输入命令行,如:

cd /mnt/test/multi-card/torch

python -m torch.distributed.launch --nproc_per_node=4 mnmc_ddp_launch.py

这里使用的是 launch 启动方式,也可使用torchrun以及其他启动方式。--nproc_per_node 指定每个节点的GPU数量,mnmc_ddp_launch.py 为执行脚本文件(如需下载 cifar10 数据集,修改download=True)。

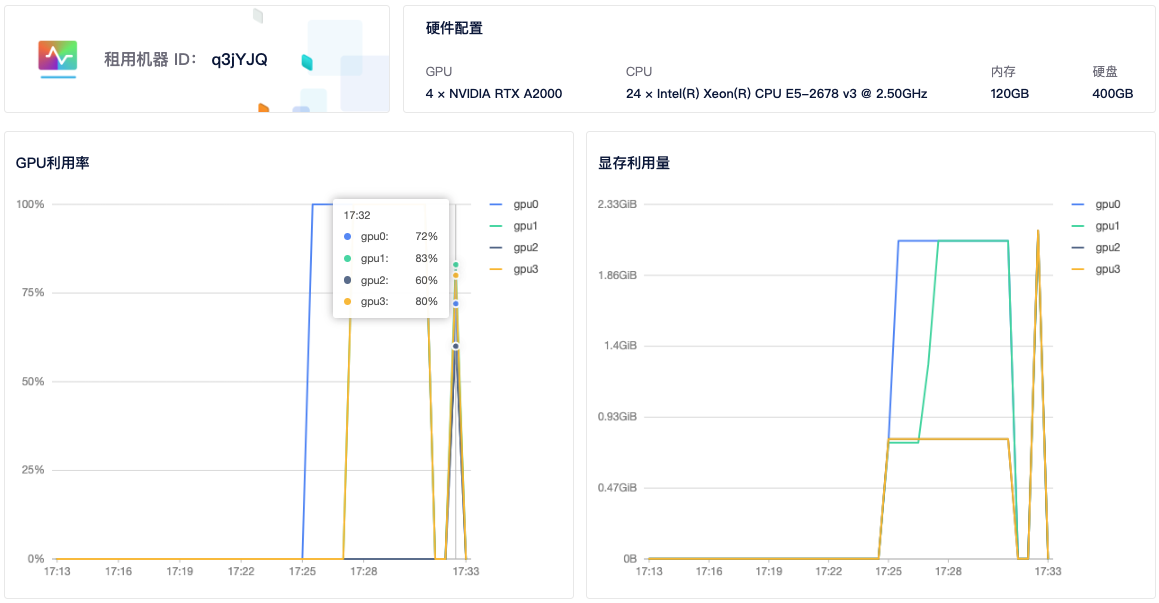

4)查看GPU使用情况: 租用界面点击详情按钮即可查看 GPU、CPU使用情况。从截图中可以看到 4 个显卡都有使用到。

多机多卡

多机多卡使用需要先申请开通 分布式集群 功能,点击这里申请开通

1)租用机器: 首先,您需要按正常流程租用 GPU,主机市场筛选栏选择 支持分布式集群 筛选,然后选择自己需要的机器租用即可。

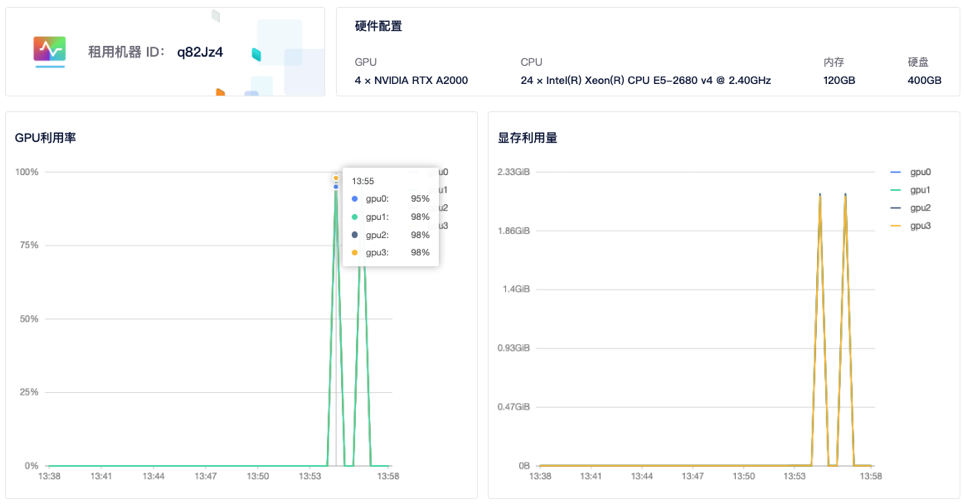

如两个计算节点,租用两台 A2000 4 卡,共计 8 卡。选择相同的Pytorch镜像,如Pytorch 1.12。

注意: 多机多卡中每个节点的 GPU 卡数应该一样,才能都使用上,机器类型也最好一样。

2)创建集群: 进入 【个人中心】 — 【我的租用】 — 【分布式集群】。

分布式集群需要先进行申请,申请通过后,点击【添加集群】- 【添加机器】—【确定】。

3)添加机器: 点击集群页面添加机器按钮,勾选要加入集群的机器,点击确定,即可将租用机器添加到集群。

添加机器成功后,系统会给每个节点分配集群 IP,当状态为已连接时,代表机器间可相互通信。

4)添加机器: 登录任一节点。因秘钥由您掌握,故需由您按以下步骤完成节点间的ssh连通:

ssh-keygen -t rsa # 一路默认,生成公私钥

ssh-copy-id root@其他节点IP #分发给其他节点,输入对应秘钥。IP可在我的集群页面查看,如192.168.1.1

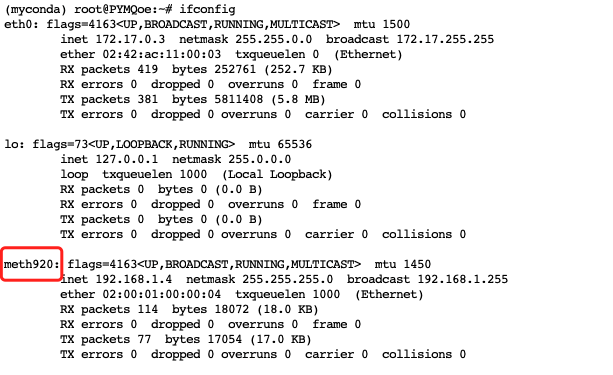

5)添加以下环境变量: 在每一个节点,使用 ifconfig 命令查询节点网卡名称,如 meth01,meth02。登陆各个节点添加相同环境变量(可用 ssh 登录)

export NCCL_SOCKET_IFNAME=meth919,meth920

export GLOO_IFACE=meth919,meth920

export NCCL_DEBUG=INFO #可选,如需获得额外的nccl信息

可以将以上内容添加到~/.bashrc文件中(meth917 meth918记得改成自己的网卡名称)。

6)适配代码: 分布式需对脚本进行相应修改,可参考官方文档。此处使用开源demo.py

6)运行程序: 登录主节点,进入运行脚本所在目录,输入命令行,如:

cd /mnt/test/multi-card/torch

python -m torch.distributed.launch --nproc_per_node=2 --nnodes=2 --node_rank=0 --master_addr="192.168.1.2" --master_port=12345 mnmc_ddp_launch.py

--nproc_per_node 指定每个节点的GPU数量,每个节点GPU数量应该一样,不然无法运行成功,--nnodes 指定节点数(总共2个节点),--node_rank 指定节点顺序(主节点故为0号),--master_addr和master_port 设定主节点ip和端口号。demo.py 为执行脚本(如需下载cifar10数据集,修改download=True)。

登录剩余节点,运行:

cd /mnt/test/multi-card/torch

python -m torch.distributed.launch --nproc_per_node=2 --nnodes=2 --node_rank=1 --master_addr="192.168.1.2" --master_port=12345 mnmc_ddp_launch.py

其中,--node_rank 指定节点顺序(第二个节点故为1号),如有更多节点,需做相应修改,其他参数不用修改。运行后,系统会自动连接并运行训练任务。

7)查看GPU使用情况: 租用界面点击详情按钮即可查看 GPU、CPU使用情况。

矩池云 | GPU 分布式使用教程之 Pytorch的更多相关文章

- 使用 MobaXterm 连接矩池云 GPU服务器

Host Name(主机名):hz.matpool.com 或 hz-t2.matpool.com,请以您 SSH 中给定的域名为准. Port(端口号):矩池云租用记录里 SSH 链接里冒号后的几位 ...

- 解决矩池云GPU显存未释放问题

很多用户反馈说终止程序之后,显存依然被占用,这里我们提供了两种解决方案,帮助用户解决这个问题. nvidia-smi查看 我们可以先用如下命令 nvidia-smi 查看一下当前GPU进程情况. _ ...

- 使用 Xshell 连接矩池云 GPU服务器

下单租用 租用成功 打开软件 完成 错误用法不能这样使用

- 矩池云 | 高性价比的GPU租用深度学习平台

矩池云是一个专业的国内深度学习云平台,拥有着良好的深度学习云端训练体验.在性价比上,我们以 2080Ti 单卡为例,36 小时折扣后的价格才 55 元,每小时单价仅 1.52 元,属于全网最低价.用户 ...

- 矩池云升级JupyterLab版本教程

先使用 Xshell 连接矩池云 GPU服务器,可以查看教程. 要在base环境下执行,用下面命令 conda deactivate ps -aux | grep jupyter 我这个进程是616 ...

- 如何使用 PuTTY 远程连接矩池云主机

PuTTY 是一款开源的连接软件,用来远程连接服务器,支持 SSH.Telnet.Serial 等协议. 矩池云的主机支持 SSH 登录,以下为使用 PuTTY 连接矩池云 GPU 的使用教程. 如您 ...

- 矩池云 | 新冠肺炎防控:肺炎CT检测

连日来,新型冠状病毒感染的肺炎疫情,牵动的不仅仅是全武汉.全湖北,更是全国人民的心,大家纷纷以自己独特的方式为武汉加油!我们相信坚持下去,终会春暖花开. 今天让我们以简单实用的神经网络模型,来检测肺炎 ...

- 矩池云 | 教你如何使用GAN为口袋妖怪上色

在之前的Demo中,我们使用了条件GAN来生成了手写数字图像.那么除了生成数字图像以外我们还能用神经网络来干些什么呢? 在本案例中,我们用神经网络来给口袋妖怪的线框图上色. 第一步: 导入使用库 fr ...

- 矩池云上使用nvidia-smi命令教程

简介 nvidia-smi全称是NVIDIA System Management Interface ,它是一个基于NVIDIA Management Library(NVML)构建的命令行实用工具, ...

- 矩池云里查看cuda版本

可以用下面的命令查看 cat /usr/local/cuda/version.txt 如果想用nvcc来查看可以用下面的命令 nvcc -V 如果环境内没有nvcc可以安装一下,教程是矩池云上如何安装 ...

随机推荐

- [转帖]Oracle入门精读28-字符集 AL32UTF8与UTF8

字符(Character) 字符是各种文字和符号的总称,包括各国家文字.标点符号.图形符号.数字等. 字符编码(Character Encoding) 是一套法则,使用该法则能够对自然语言的字符的一个 ...

- 服务器Raid配置的一些思考

背景 随着公司软件的发展.客户越来越多. 测试环境和兼容环境也越来越多. 不管是虚拟化,还是裸金属做数据库 存储都是绕不开的一道门槛. 最近又上架了几台服务器, 所以想趁着周末总结一下 最近服务器上架 ...

- mysql8 CentOS7 简要安装说明

1. 卸载mariadb rpm -qa |grep mariadb |xargs yum remove -y比较简单的卸载办法. 2. 安装所有的rpm包. yum localinstall *.r ...

- iframe 在线预览pdf、word、excel、ppt、txt、图片、视频

第一种方式通过 iframe 在线预览 pdf,word,excel,ppt,txt,图片,视频 <template> <el-button @click="openHan ...

- 使用Java读取Excel文件数据

通过编程方式读取Excel数据能实现数据导入.批量处理.数据比对和更新等任务的自动化.这不仅可以提高工作效率还能减少手动处理的错误风险.此外读取的Excel数据可以与其他系统进行交互或集成,实现数据的 ...

- 【代码分享】使用 avx512 + 查表法,优化凯撒加密

作者:张富春(ahfuzhang),转载时请注明作者和引用链接,谢谢! cnblogs博客 zhihu Github 公众号:一本正经的瞎扯 关于凯撒加密,具体请看:https://en.wikipe ...

- python.exe和pythonw.exe的区别(区分.py、.pyw、.pyc、.pyo文件)

python和pythonw 在Windows系统搭建好Python的环境后,进入Python的安装目录,大家会发现目录中有python.exe和pythonw.exe两个程序.如下图所示: 它们到底 ...

- vim 从嫌弃到依赖(23)——最后的闲扯

截止到上一篇文章,关于vim的基础操作都已经讨论完了,这篇我主要就是闲扯,瞎聊.就想毕业论文都有一个致谢一样,这篇我们就作为整个系列的致谢吧 学习vim到底能给我们带来什么 学习vim到底能给我们带来 ...

- 【5】Vscode Todo Tree插件使用和TODO、FIXME和XXX的注释使用说明以及自制自己的TODO图标样式!

相关文章: [一]tensorflow安装.常用python镜像源.tensorflow 深度学习强化学习教学 [二]tensorflow调试报错.tensorflow 深度学习强化学习教学 [三]t ...

- 4.5 Windows驱动开发:内核中实现进程数据转储

多数ARK反内核工具中都存在驱动级别的内存转存功能,该功能可以将应用层中运行进程的内存镜像转存到特定目录下,内存转存功能在应对加壳程序的分析尤为重要,当进程在内存中解码后,我们可以很容易的将内存镜像导 ...