JSOUP 爬虫

作者QQ:1095737364 QQ群:123300273 欢迎加入!

1.mavne 依赖:

<!--html 解析 : jsoup HTML parser library @ http://jsoup.org/-->

<dependency>

<groupId>org.jsoup</groupId>

<artifactId>jsoup</artifactId>

<version>1.10.2</version>

</dependency>

2.JSONPUtils工具:

package com.hiione.common.util;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements; import java.io.IOException;

import java.util.Iterator; public class JsoupUtils { public static String jsoupElement(String content){

Document doc = Jsoup.parse(content);

Element body = doc.body();

Elements aHref=body.select("a");

Elements jsScript = body.select("script");

Elements form = body.select("form");

Elements link = body.select("link");

Elements ifrom = body.select("iframe ");

Elements http = body.select("http");

if(jsScript.size()!=0 ||aHref.size()!=0||form.size()!=0||link.size()!=0||ifrom.size()!=0||http.size()!=0){

return "0";

}

return "";

}

public static String jsoupElementByURL(String content){

String url = "http://as.meituan.com/meishi/all";

Document doc = null;

try {

doc = Jsoup.connect(url).get();

} catch (IOException e1) {

e1.printStackTrace();

}

Element body = doc.body();

Elements aHref=body.select("a");

Elements es=body.select("a");

for (Iterator it = es.iterator(); it.hasNext();) {

Element e = (Element) it.next();

System.out.println(e.text()+" "+e.attr("href"));

}

Elements jsScript = body.select("script");

Elements form = body.select("form");

Elements link = body.select("link");

Elements ifrom = body.select("iframe ");

Elements http = body.select("http");

if(jsScript.size()!=0 ||aHref.size()!=0||form.size()!=0||link.size()!=0||ifrom.size()!=0||http.size()!=0){

return "0";

}

return "";

}

}

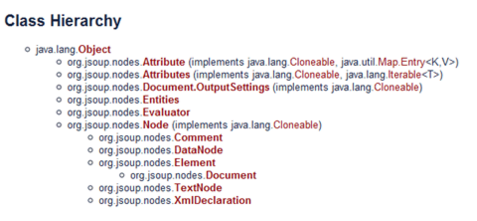

3.jsoup 简介

4.文档输入

// 直接从字符串中输入 HTML 文档

String html = "<html><head><title>JSONP</title></head>" +

"<body><p>这里是 jsoup 项目的相关文章</p></body></html>";

Document doc = Jsoup.parse(html);

// 从URL直接加载 HTML 文档

Document doc = Jsoup.connect("http://www.baidu.net/").get();

String title = doc.title();

Document doc = Jsoup.connect("http://www.baidu.net/")

.data("query", "Java") //请求参数

.userAgent("I’m jsoup") //设置User-Agent

.cookie("auth", "token") //设置cookie

.timeout(3000) //设置连接超时时间

.post(); //使用POST方法访问URL

// 从文件中加载 HTML 文档

File input = new File("D:/test.html");

Document doc = Jsoup.parse(input,"UTF-8","http://www.oschina.net/");

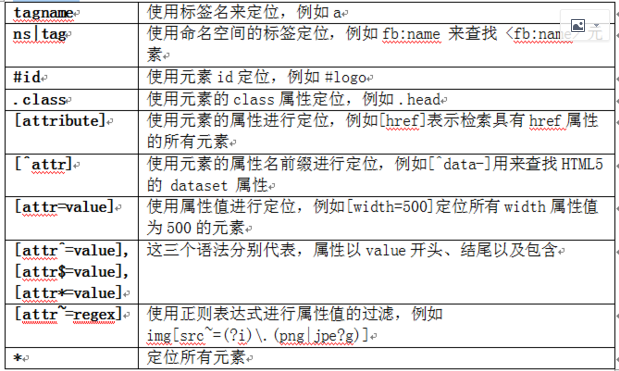

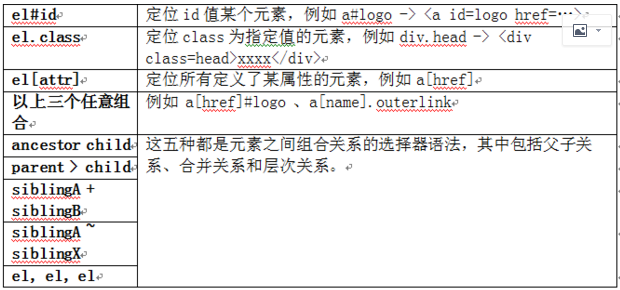

5.解析并提取 HTML 元素

File input = new File("D:/test.html");

Document doc = Jsoup.parse(input, "UTF-8", "http://www.baidu.net/");

Element content = doc.getElementById("content");

Elements links = content.getElementsByTag("a");

for (Element link : links) {

String linkHref = link.attr("href");

String linkText = link.text();

}

File input = new File("D:\test.html");

Document doc = Jsoup.parse(input,"UTF-8","http://www.baidu.net/");

Elements links = doc.select("a[href]"); // 具有 href 属性的链接

Elements pngs = doc.select("img[src$=.png]");//所有引用png图片的元素

Element masthead = doc.select("div.masthead").first();

// 找出定义了 class="masthead" 的元素

Elements resultLinks = doc.select("h3.r > a"); // direct a after h3

6.修改数据

doc.select("div.comments a").attr("rel", "nofollow");

//为所有链接增加 rel=nofollow 属性

doc.select("div.comments a").addClass("mylinkclass");

//为所有链接增加 class="mylinkclass" 属性

doc.select("img").removeAttr("onclick"); //删除所有图片的onclick属性

doc.select("input[type=text]").val(""); //清空所有文本输入框中的文本

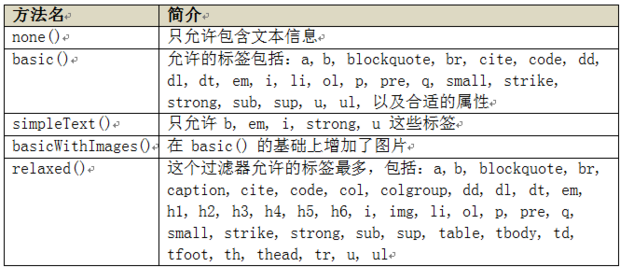

7.HTML 文档清理

String unsafe = "<p><a href='http://www.oschina.net/' onclick='stealCookies()'>JSONP</a></p>";

String safe = Jsoup.clean(unsafe, Whitelist.basic());

// 输出:

// <p><a href="http://www.baidu.net/" rel="nofollow">JSONP</a></p>

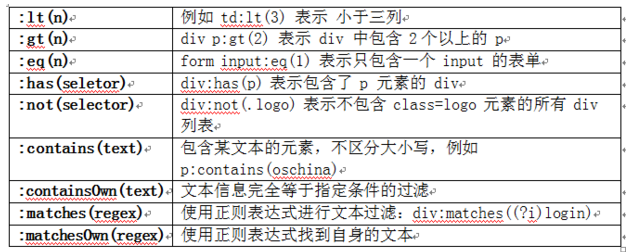

8.jsoup 的过人之处——选择器

JSOUP 爬虫的更多相关文章

- jsoup爬虫简书首页数据做个小Demo

代码地址如下:http://www.demodashi.com/demo/11643.html 昨天LZ去面试,遇到一个大牛,被血虐一番,发现自己基础还是很薄弱,对java一些原理掌握的还是不够稳固, ...

- (java)Jsoup爬虫学习--获取智联招聘(老网站)的全国java职位信息,爬取10页

Jsoup爬虫学习--获取智联招聘(老网站)的全国java职位信息,爬取10页,输出 职位名称*****公司名称*****职位月薪*****工作地点*****发布日期 import java.io.I ...

- (java)Jsoup爬虫学习--获取网页所有的图片,链接和其他信息,并检查url和文本信息

Jsoup爬虫学习--获取网页所有的图片,链接和其他信息,并检查url和文本信息 此例将页面图片和url全部输出,重点不太明确,可根据自己的需要输出和截取: import org.jsoup.Jsou ...

- 【Java】Jsoup爬虫,一个简单获取京东商品信息的小Demo

简单记录 - Jsoup爬虫入门实战 数据问题?数据库获取,消息队列中获取中,都可以成为数据源,爬虫! 爬取数据:(获取请求返回的页面信息,筛选出我们想要的数据就可以了!) 我们经常需要分析HTML网 ...

- JSOUP爬虫示例

利用JSOUP做爬虫,爬取我博客中的所有标题加链接,代码示例如下: package com.test.jsoup; import java.io.IOException; import org.jso ...

- HttpClient&Jsoup爬虫的简单应用

详细的介绍已经有很多前辈总结,引用一下该篇文章:https://blog.csdn.net/zhuwukai/article/details/78644484 下面是一个代码的示例: package ...

- Jsoup爬虫任务总结

这两周由于公司需要大量数据爬取进数据库给用户展示素材,在不停的做爬虫工作,现在总算基本完成就剩清理数据的工作: 公司有一个采集器管理后台的项目,可以直接把爬虫代码打包成jar导入进去设置定时参数即可: ...

- 利用jsoup爬虫工具,爬取数据,并利用excel导出

import java.io.BufferedInputStream; import java.io.BufferedReader; import java.io.FileInputStream; i ...

- Jsoup爬虫解析

需要下载jsoup-1.8.1.jar包 jsoup 是一款Java 的HTML解析器,可直接解析某个URL地址.HTML文本内容.它提供了一套非常省力的API,可通过DOM,CSS以及类似于jQue ...

- jsoup爬虫,项目实战,欢迎收看

import com.mongodb.BasicDBObject import com.mongodb.DBCollection import org.jsoup.Jsoup import org.j ...

随机推荐

- LOJ#3104「TJOI2019」甲苯先生的字符串

题目描述 一天小甲苯得到了一条神的指示,他要把神的指示写下来,但是又不能泄露天机,所以他要用一种方法把神的指示记下来. 神的指示是一个字符串,记为字符串 \(s_1\),\(s_1\) 仅包含小写字母 ...

- 一 创建一个springboot项目之(微信点餐系统的设计与开发)

第一步:收到项目需求,进行数据库表的设计. 1.角色的划分: 卖家: 订单,类目 买家: 商品列表 2.功能模块的划分: 商品:商品列表 订单: 订单创建,订单查询,订单取消 类目:基于管理的功 ...

- Java并发(九)【转载】不可不说的Java“锁”事

转载自 美团技术团队,原文链接 不可不说的Java“锁”事 前言 Java提供了种类丰富的锁,每种锁因其特性的不同,在适当的场景下能够展现出非常高的效率.本文旨在对锁相关源码(本文中的源码来自JDK ...

- Nginx请求处理流程

因为 Nginx 运行在企业内网的最外层也就是边缘节点,那么他处理的的流量是其他应用服务器处理流量的数倍,甚至几个数量级,我们知道任何一种问题在不同的数量级下,他的解决方案是完全不同的,所以在 Ngi ...

- LINQ查询表达式(2) - 在 C# 中编写 LINQ 查询

在 C# 中编写 LINQ 查询 C# 中编写 LINQ 查询的三种方式: 使用查询语法. 使用方法语法. 组合使用查询语法和方法语法. // 查询语法 IEnumerable<int> ...

- Dynamics 365 目录

Dynamics 365 目录 1.Dynamics 365 on-premises 安装 2.Dynamics 365 安装过程中的问题 2.1Dynamics 365 安装问题——无法访MSCRM ...

- 浅谈JS高阶函数

引入 我们都知道函数是被设计为执行特定任务的代码块,会在某代码调用它时被执行,获得返回值或者实现其他功能.函数有函数名和参数,而函数参数是当调用函数接收的真实的值. 今天要说的高阶函数的英文为High ...

- VS - Microsoft.Practices.Unity

PM> Install-Package Unity Web.config <configSections> <section name="unity" t ...

- Windows系统清除占用的串口号列表批处理

蛋疼总是无缘无故被占用 @echo off reg query "HKLM\SYSTEM\CurrentControlSet\Control\COM Name Arbiter" / ...

- 说明os,sys模块有什么不同

官方解释: os: This module provides a portable way of usingoperating system dependent functionality. 翻译:提 ...