MySQL数据导入到Mongo

背景:如题干所述,需要将一份数据导入到mongo数据库,减少项目依赖的数据源。

解决方案:

使用mongo自带的mongoimport工具。

首先在test库里创建一个空集合:【import_test】,起初用的导入指令如下:

[root@localhost mongodb]# ./bin/mongoimport --host 192.168.104.178: -u adminuser -p --authenticationDatabase=admin -d test -c import_test --fields=userid,serial,create_time --type csv -file csvToMongo.csv

--11T18::07.075+ connected to: 192.168.104.178:

--11T18::07.083+ imported documents

指令讲解:

- --authenticationDatabase:测试集群使用了身份验证,需要在admin库里登陆后,才能操作

- -d:集合所在的库

- --fields:集合中的字段名

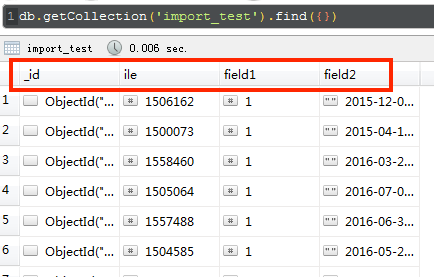

结果发现mongo的字段不能正常被创建,如下

只能换一种方式进行导入,后来发现将字段名称写到文件后,再导入就不会有问题,具体如下:

[root@localhost mongodb]# cat myfields.txt

userid

serial

create_time

myfields文件中保存了这三个字段,每行一个,然后执行导入命令:

[root@localhost mongodb]# ./bin/mongoimport --host 192.168.104.178: -u adminuser -p --authenticationDatabase=admin -d test -c import_test --fieldFile myfields.txt --type csv --file csvToMongo.csv

--11T18::06.894+ connected to: 192.168.104.178:

--11T18::06.903+ imported documents

结果如下:

最后贴上测试用的csv数据:

[root@localhost mongodb]# cat csvToMongo.csv

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

,,-- ::

注意:最后的最后,我终于知道为什么字段名不正常了,和mongo的指令无关,只是第一个指令最后一个参数写的有误,file前面只有一个横杠“-”,如果写两个横杠,也一样有正确的结果,哈哈哈

./bin/mongoimport --host 192.168.104.178:17017 -u adminuser -p 112233 --authenticationDatabase=admin -d test -c import_test --fields=userid,serial,create_time --type csv --file csvToMongo.csv

说完了。

补充一个json文件的导入指令

./bin/mongoimport --host 192.168.104.178:17017 -u adminuser -p 112233 --authenticationDatabase=admin --drop -d test -c session_info --file jsonToMongo.json -j 10

-j,多线程跑,可以自定义

--drop,导入之前先清空表里所有数据

MySQL数据导入到Mongo的更多相关文章

- Sqoop将mysql数据导入hbase的血与泪

Sqoop将mysql数据导入hbase的血与泪(整整搞了大半天) 版权声明:本文为yunshuxueyuan原创文章.如需转载请标明出处: https://my.oschina.net/yunsh ...

- 使用sqoop把mysql数据导入hive

使用sqoop把mysql数据导入hive export HADOOP_COMMON_HOME=/hadoop export HADOOP_MAPRED_HOME=/hadoop cp /hive ...

- MySQL数据导入导出方法与工具mysqlimport

MySQL数据导入导出方法与工具mysqlimport<?xml:namespace prefix = o ns = "urn:schemas-microsoft-com:office ...

- 使用MapReduce将mysql数据导入HDFS

package com.zhen.mysqlToHDFS; import java.io.DataInput; import java.io.DataOutput; import java.io.IO ...

- 使用 sqoop 将mysql数据导入到hive表(import)

Sqoop将mysql数据导入到hive表中 先在mysql创建表 CREATE TABLE `sqoop_test` ( `id` ) DEFAULT NULL, `name` varchar() ...

- 使用 sqoop 将mysql数据导入到hdfs(import)

Sqoop 将mysql 数据导入到hdfs(import) 1.创建mysql表 CREATE TABLE `sqoop_test` ( `id` ) DEFAULT NULL, `name` va ...

- Logstash:把MySQL数据导入到Elasticsearch中

Logstash:把MySQL数据导入到Elasticsearch中 前提条件 需要安装好Elasticsearch及Kibana. MySQL安装 根据不同的操作系统我们分别对MySQL进行安装.我 ...

- 使用sqoop将mysql数据导入到hive中

首先准备工具环境:hadoop2.7+mysql5.7+sqoop1.4+hive3.1 准备一张数据库表: 接下来就可以操作了... 一.将MySQL数据导入到hdfs 首先我测试将zhaopin表 ...

- Logstash学习之路(四)使用Logstash将mysql数据导入elasticsearch(单表同步、多表同步、全量同步、增量同步)

一.使用Logstash将mysql数据导入elasticsearch 1.在mysql中准备数据: mysql> show tables; +----------------+ | Table ...

随机推荐

- s4-6 二层交换

为什么需要二层交换? 有很多LAN,如何将它们连接起来? 可用网桥(bridges )将它们连接起来. 网桥工作在DLL层,通过检查MAC地址做出转发帧的决策 不会检查网络层,所以,IPv ...

- java中定时器总结

java实现定时器的四种方式: 一. /** * 延迟20000毫秒执行 java.util.Timer.schedule(TimerTask task, long delay) */ public ...

- C#-.Net Framework和.Net Compact Framework-摘

.Net Compact Framework 一种独立于硬件的环境,用于在资源受限制的计算设备上运行程序.它继承了公共语言运行时的完整 .NET Framework 结构,支持 .NET Framew ...

- Shell编程-11-子Shell和Shell嵌套

目录 什么是子Shell 子Shell产生的途径 Shell脚本调用模式 什么是子Shell 子Shell的概念其实是贯穿整个Shell的,如果想要更好的理解和写Shell脚本则必须要了解子S ...

- MySQL连接查询(多表查询)

基本含义 连接就是指两个或两个以上的表(数据源) “连接起来成为一个数据源”. 连接语法的基本形式:from 表1 [连接方式] join 表2 [on 连接条件]; 连接的结果可以当做一个“表”来使 ...

- mysql 中 datetime和 timestamp的区别

DATETIME日期和时间的组合.支持的范围是'1000-01-01 00:00:00'到'9999-12-31 23:59:59'.MySQL以'YYYY-MM-DD HH:MM:SS'格式显示DA ...

- Legal or Not HDU

Legal or Not Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Others) Tot ...

- cocos游戏的例子(摘抄记录,非原创)

3.1 搭建Cocos2d-JS v3.x 开发环境 下载所需的软件包 下载 Cocos Code IDE.目前 Cocos Code IDE 最新发布版本是 1.0.0-RC2.我们为什么 Coco ...

- HMAILSERVER集成WEB邮件系统(ROUNDCUBE WEBMAIL)

hMailServer集成web邮件系统(Roundcube Webmail) 文/玄魂 前言 在上篇文章(使用hMailServer搭建邮件服务器)中,介绍了hMailServer的安装和简单配置. ...

- 工作随笔——elasticsearch数据冷热分离、数据冷备

概述: 适合日志类型的数据存储方案.即当日数据写入,历史数据只读. 节省部分硬件成本.热数据采用更好的硬件. 环境: 已有6个ES节点,使用docker-compose方式搭建. es1:master ...