tachyon of zybo cluster

把Tachyon层加入spark和hadoop之间,以加速集群

官网:http://tachyon-project.org/

github:https://github.com/amplab/tachyon/releases

(1)准备工作:

wget http://tachyon-project.org/downloads/tachyon-0.4.1-bin.tar.gz

tar xvfz tachyon-0.4.1-bin.tar.gz

cd tachyon-0.4.1

cp conf/tachyon-env.sh.template conf/tachyon-env.sh

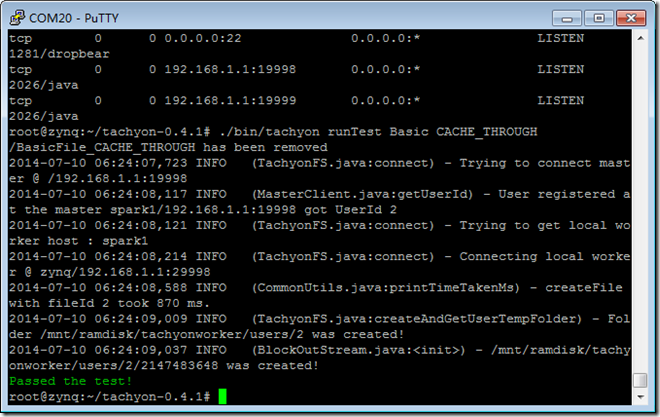

(2)在本地测试:

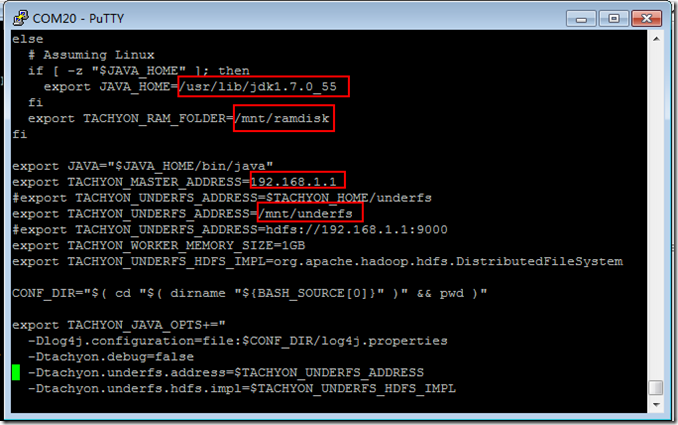

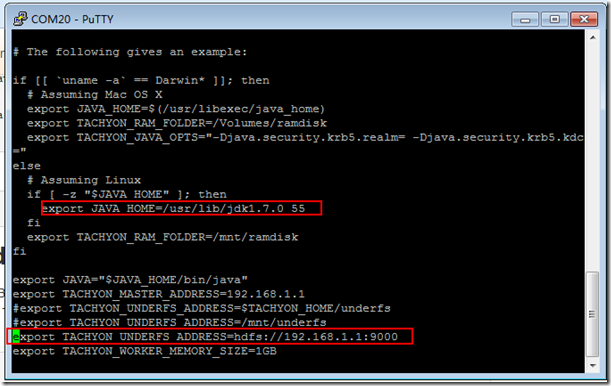

vi conf/tachyon-env.sh

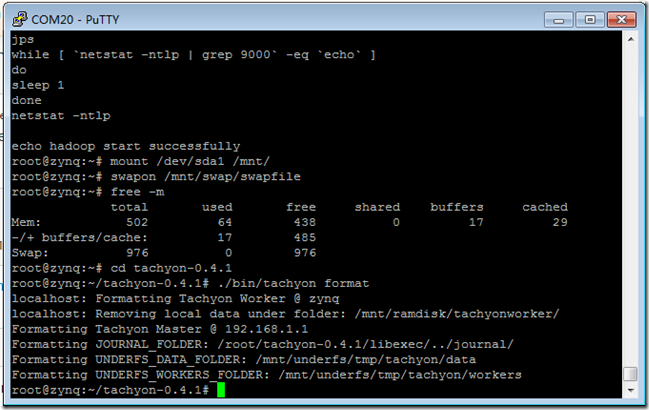

./bin/tachyon format

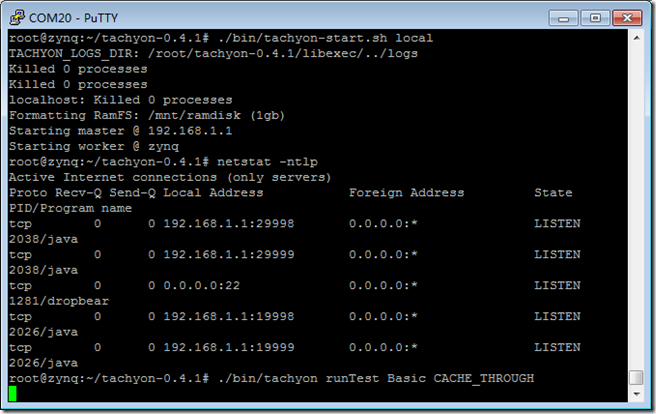

./bin/tachyon-start.sh local

./bin/tachyon runTest Basic CACHE_THROUGH

(3)与Hadoop结合:Set HDFS as Tachyon’s under filesystem

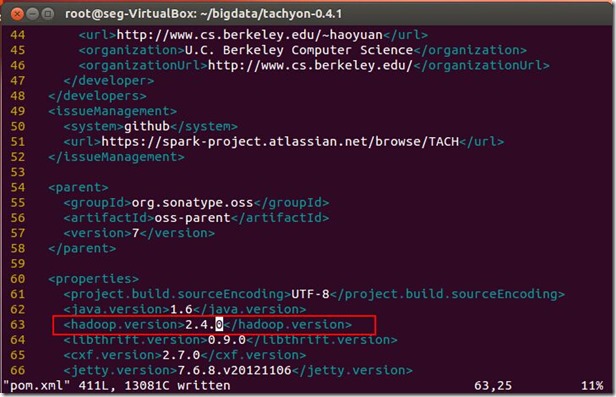

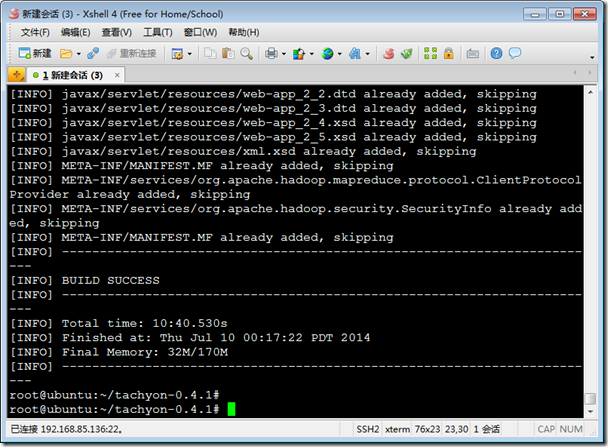

因为2.4.0的hadoop需要重新编译,在arm平台安装maven会出错,故转移到x64pc机编译:

apt-get install maven

vi pom.xml

mvn -Dhadoop.version=2.4.0 clean package

cp -r /root/tachyon-0.4.1 /media/fs/root/

cd /root/tachyon-0.4.1

cd ..

cd hadoop-2.4.0/

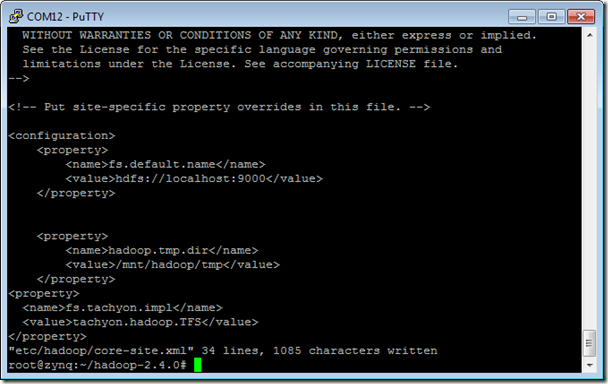

vi etc/hadoop/core-site.xml

<property>

<name>fs.tachyon.impl</name>

<value>tachyon.hadoop.TFS</value>

</property>vi etc/hadoop/hadoop-env.sh

加入一行:

export HADOOP_CLASSPATH=$HADOOP_CLASSPATH:/root/tachyon-0.4.1/target/tachyon-0.4

.1-jar-with-dependencies.jar

cd /root

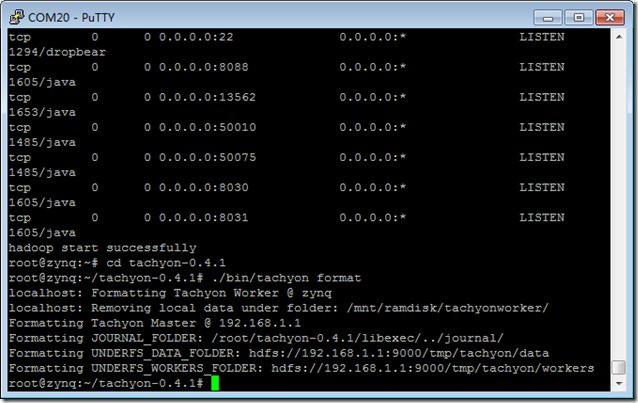

./gohadoop.sh

cd tachyon-0.4.1

./bin/tachyon format

./bin/tachyon-start.sh local

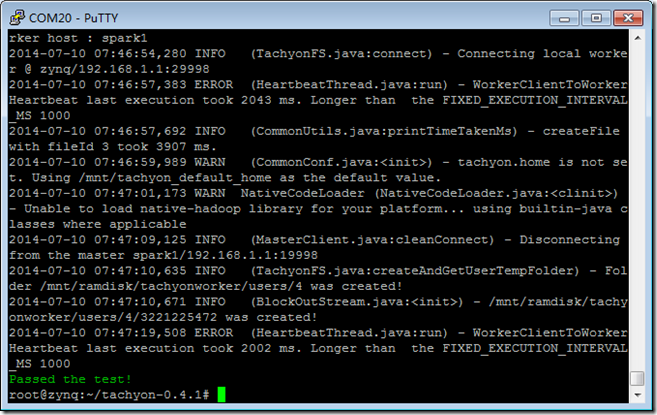

./bin/tachyon runTest Basic CACHE_THROUGH

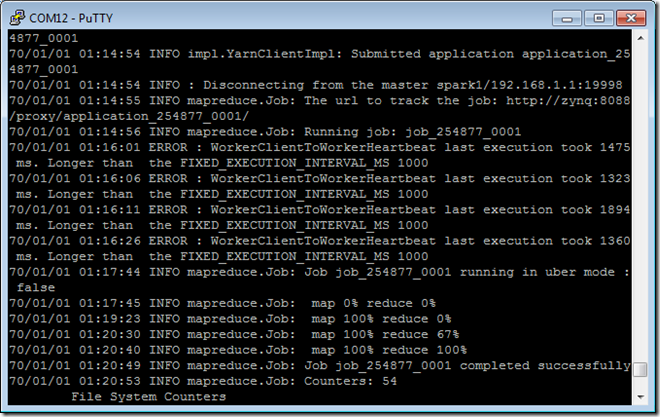

cd $HADOOP_HOME执行如下命令:./bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.4.0.jar \

wordcount -libjars /root/tachyon-0.4.1/target/tachyon-0.4.1-jar-with-dependencies.jar \

tachyon://192.168.1.1:19998/in/file /out/file

(4)与Spark结合:Running Spark on Tachyon

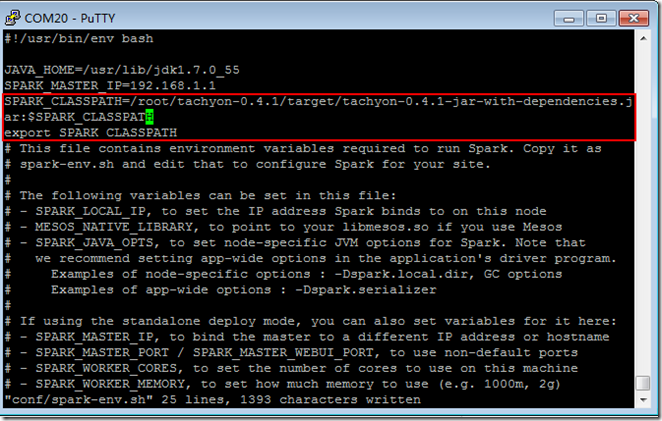

cd spark-0.9.1-bin-hadoop2

vi conf/spark-env.sh

SPARK_CLASSPATH=/root/tachyon-0.4.1/target/tachyon-0.4.1-jar-with-dependencies.jar:$SPARK_CLASSPATH

export SPARK_CLASSPATH

export TACHYON_MASTER="192.168.1.1:19998"

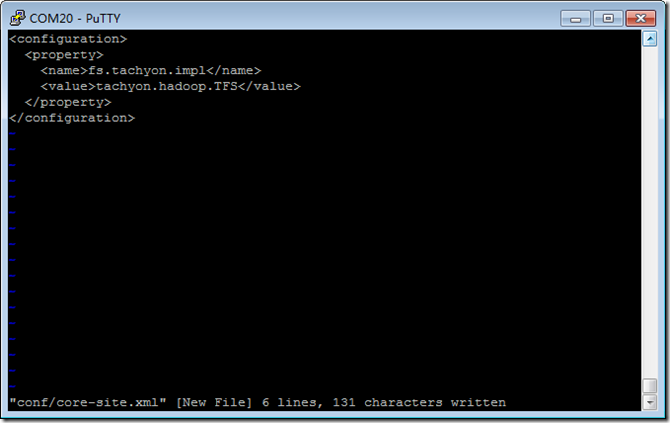

新建一个配置文件:

vi conf/core-site.xml

<configuration>

<property>

<name>fs.tachyon.impl</name>

<value>tachyon.hadoop.TFS</value>

</property>

</configuration>

运行

MASTER=spark://192.168.1.1:7077 ./bin/pyspark

file = sc.textFile("tachyon://192.168.1.1:19998/in/file")

counts = file.flatMap(lambda line: line.split(" ")) \

.map(lambda word: (word, 1)) \

.reduceByKey(lambda a, b: a + b)

counts.collect()

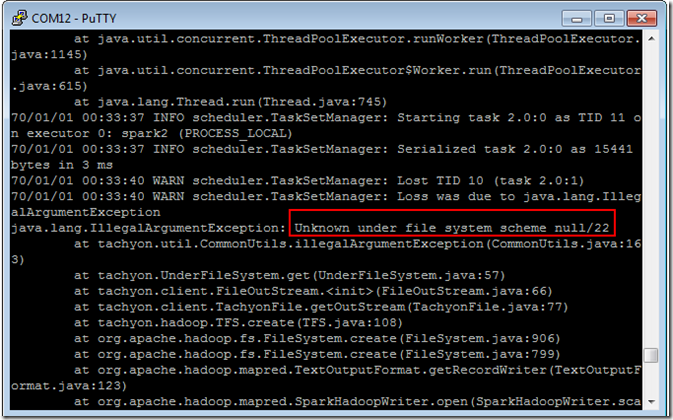

counts.saveAsTextFile("tachyon://192.168.1.1:19998/out/mycount")

counts.saveAsTextFile("hdfs://192.168.1.1:9000/out/mycount1")

collect()正确执行,

save to hadoop 正确执行,

save to tachyon 后出错:

参考网站:http://tachyon-project.org/Syncing-the-Underlying-Filesystem.html

暂未解决。

先只测试用Tachyon读数据1G大小的文本文件:

使用hadoop读取使用了16分钟。

scp tachyon-0.4.1.bak2.tar.gz root@spark4:/root/

tachyon of zybo cluster的更多相关文章

- hadoop+tachyon+spark的zybo cluster集群综合配置

1.zybo cluster 架构简述: 1.1 zybo cluster 包含5块zybo 开发板组成一个集群,zybo的boot文件为digilent zybo reference design提 ...

- Learn ZYNQ(10) – zybo cluster word count

1.配置环境说明 spark:5台zybo板,192.168.1.1master,其它4台为slave hadoop:192.168.1.1(外接SanDisk ) 2.单节点hadoop测试: 如果 ...

- Learn ZYNQ (9)

创建zybo cluster的spark集群(计算层面): 1.每个节点都是同样的filesystem,mac地址冲突,故: vi ./etc/profile export PATH=/usr/loc ...

- Tachyon Cluster: 基于Zookeeper的Master High Availability(HA)高可用配置实现

1.Tachyon简介 Tachyon是一个高容错的分布式文件系统,允许文件以内存的速度在集群框架中进行可靠的共享,就像Spark和 MapReduce那样.通过利用信息继承,内存侵入,Tachyon ...

- Tachyon在Spark中的作用(Tachyon: Reliable, Memory Speed Storage for Cluster Computing Frameworks 论文阅读翻译)

摘要: Tachyon是一种分布式文件系统,能够借助集群计算框架使得数据以内存的速度进行共享.当今的缓存技术优化了read过程,可是,write过程由于须要容错机制,就须要通过网络或者 ...

- 分布式内存文件系统Tachyon

UCBerkeley研发的Tachyon(超光子['tækiːˌɒn],名字要不要这么太嚣张啊:)是一款为各种集群并发计算框架提供内存数据管理的平台,也可以说是一种内存式的文件系统吧.如下图,它就处于 ...

- Spark(十二) -- Spark On Yarn & Spark as a Service & Spark On Tachyon

Spark On Yarn: 从0.6.0版本其,就可以在在Yarn上运行Spark 通过Yarn进行统一的资源管理和调度 进而可以实现不止Spark,多种处理框架并存工作的场景 部署Spark On ...

- [Berkeley]弹性分布式数据集RDD的介绍(RDD: A Fault-Tolerant Abstraction for In-Memory Cluster Computing 论文翻译)

摘要: 本文提出了分布式内存抽象的概念--弹性分布式数据集(RDD,Resilient Distributed Datasets).它同意开发者在大型集群上运行基于内存的计算.RDD适用于两种 ...

- Node.js:进程、子进程与cluster多核处理模块

1.process对象 process对象就是处理与进程相关信息的全局对象,不需要require引用,且是EventEmitter的实例. 获取进程信息 process对象提供了很多的API来获取当前 ...

随机推荐

- 【荐】PHP采集工具curl快速入门教程

为什么要用CURL? CURL(Client URL Library Functions)是一个利用URL语法在命令行方式下工作的文件传输工具.它支持很多协议:FTP, FTPS, HTTP, HTT ...

- PHP的继承方法如何获取子类名?get_class() 和 get_called_class()

PHP里的__CLASS__这类东西是静态绑定的,如果不在子类里重载的话,那么继承父类方法所得到的依旧是父类的名称,而不是子类的名称,比如: <?php class A { function _ ...

- 【Go入门教程2】内置基础类型(Boolean、数值、字符串、错误类型),分组,iota枚举,array(数值),slice(切片),map(字典),make/new操作,零值

这小节我们将要介绍如何定义变量.常量.Go内置类型以及Go程序设计中的一些技巧. 定义变量 Go语言里面定义变量有多种方式. 使用var关键字是Go最基本的定义变量方式,与C语言不同的是Go把变量类型 ...

- Scrum Meeting ——总结

冲刺总结 0*.燃尽图 迟来的燃尽图,别看它是最后一天掉了一堆,感觉很假,像是人为的把issues都关闭掉.其实不然,很多功能是大家平时做好,但是没整合在一起,所以没燃掉,在最后几天的整合中,通过测试 ...

- 1.2Web API 2中的Action返回值

本主题描述 ASP.NET Web API 将返回值转换从一个控制器动作到 HTTP 响应消息. 一个 Web API 控制器动作可以返回下列任一操作 ︰ 1.void 2.IHttpActionRe ...

- VMware中的Ubuntu网络设置

网络配置: VMware安装后会有两个默认网卡,分别是VMnet8(192.168.83.1)和VMnet1(192.168.19.1),当然不同的机器上,这两个网卡的 IP会不同的.在windows ...

- eclipse 快捷键

Eclipse快捷键大全 Ctrl+1 快速修复(最经典的快捷键,就不用多说了) Ctrl+D: 删除当前行 Ctrl+Alt+↓ 复制当前行到下一行(复制增加) Ctrl+Alt+↑ 复制当前行到 ...

- 核型SVM

(本文内容和图片来自林轩田老师<机器学习技法>) 1. 核技巧引入 如果要用SVM来做非线性的分类,我们采用的方法是将原来的特征空间映射到另一个更高维的空间,在这个更高维的空间做线性的SV ...

- espcms会员二次开发文件说明——会员,时间格式

[espcms会员图片字段] 添加字段加入图片类型/webadm/include/inc_formtypelist.php 会员修改页面模型/webadm/templates/member/membe ...

- Spring Data JPA @EnableJpaRepositories配置详解

@EnableJpaRepositories注解用于Srping JPA的代码配置,用于取代xml形式的配置文件,@EnableJpaRepositories支持的配置形式丰富多用,本篇文章详细讲解. ...