spark学习之路1--用IDEA编写第一个基于java的程序打包,放standalone集群,client和cluster模式上运行

1,首先确保hadoop和spark已经运行。(如果是基于yarn,hdfs的需要启动hadoop,否则hadoop不需要启动)。

2.打开idea,创建maven工程。编辑pom.xml文件。增加dependency.

<dependency> <!-- Spark dependency -->

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.10</artifactId>

<version>1.6.0</version>

</dependency>

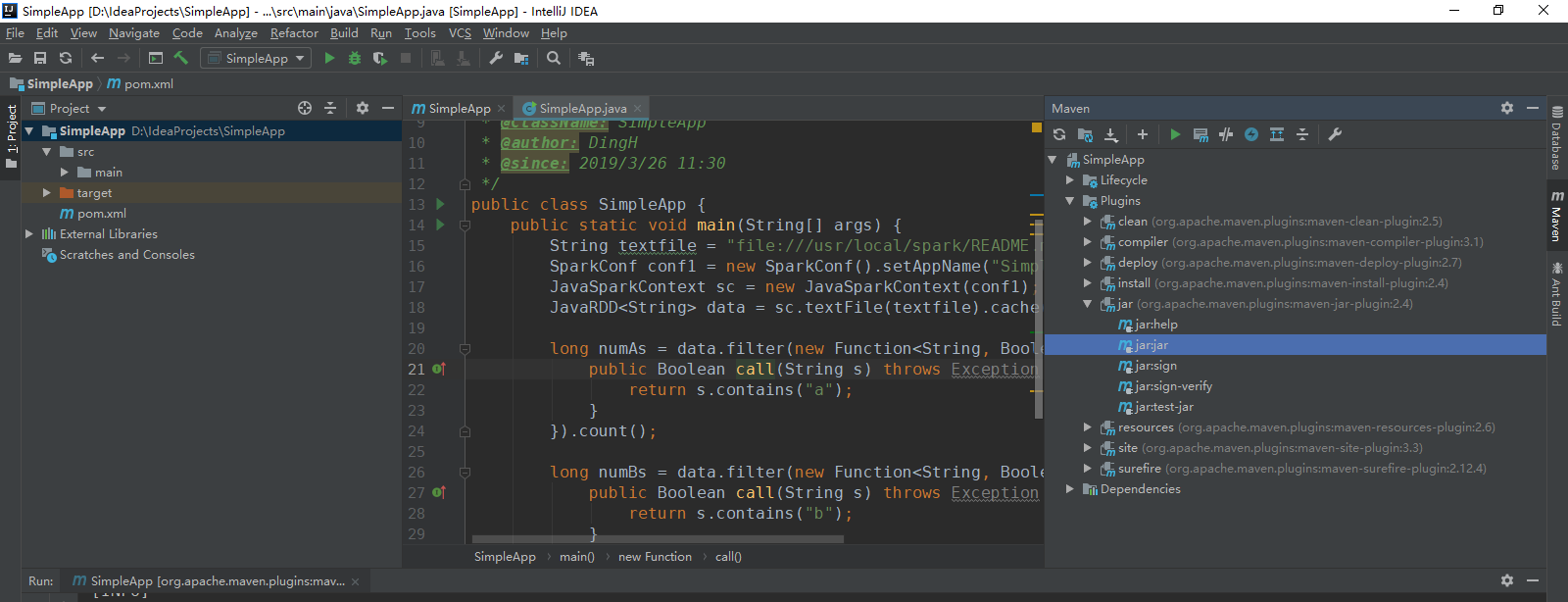

3.编写SimpleApp.java

import org.apache.spark.SparkConf;

import org.apache.spark.api.java.JavaRDD;

import org.apache.spark.api.java.JavaSparkContext;

import org.apache.spark.api.java.function.Function; /**

* TODO

*

* @ClassName: SimpleApp

* @author: DingH

* @since: 2019/3/26 11:30

*/

public class SimpleApp {

public static void main(String[] args) {

String textfile = "file:///usr/local/spark/README.md";

SparkConf conf1 = new SparkConf().setAppName("SimpleApp");

JavaSparkContext sc = new JavaSparkContext(conf1);

JavaRDD<String> data = sc.textFile(textfile).cache(); long numAs = data.filter(new Function<String, Boolean>() {

public Boolean call(String s) throws Exception {

return s.contains("a");

}

}).count(); long numBs = data.filter(new Function<String, Boolean>() {

public Boolean call(String s) throws Exception {

return s.contains("b");

}

}).count(); System.out.println("Lines with a: " + numAs + ", lines with b: " + numBs);

}

}

4.执行程序(肯定会有错,因为这个路径是ubuntu上spark的readme文件路径,如果想要在本地实验,修改本地文件系统中的一个文件路径就行,这个同时还有conf.setmaster("local")),打包。

5.将目标路径下的target文件夹拷贝到服务器端。

6.如果是client模式,直接执行:

ubuntu@master:/usr/local/spark$ ./bin/spark-submit --class "SimpleApp" --deploy-mode client --master spark://172.19.57.221:7077 ~/target/SimpleApp-1.0-SNAPSHOT.jar

7.如果是cluster上,则需要把target上传到slave01的用户目录下。然后执行:

ubuntu@master:/usr/local/spark$ ./bin/spark-submit --class "SimpleApp" --deploy-mode cluster --master spark://172.19.57.221:7077 ~/target/SimpleApp-1.0-SNAPSHOT.jar

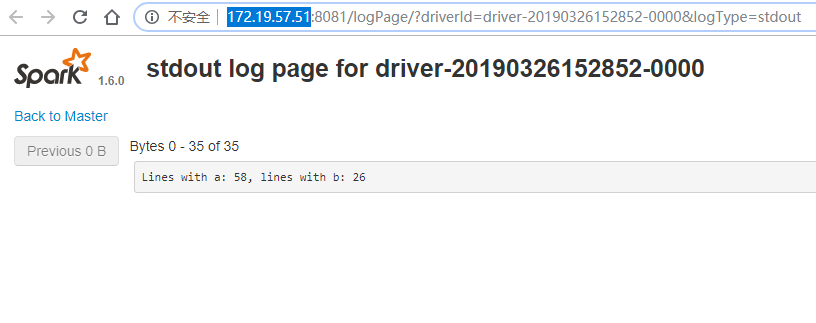

这个方式执行的结果只能在webUI上看。

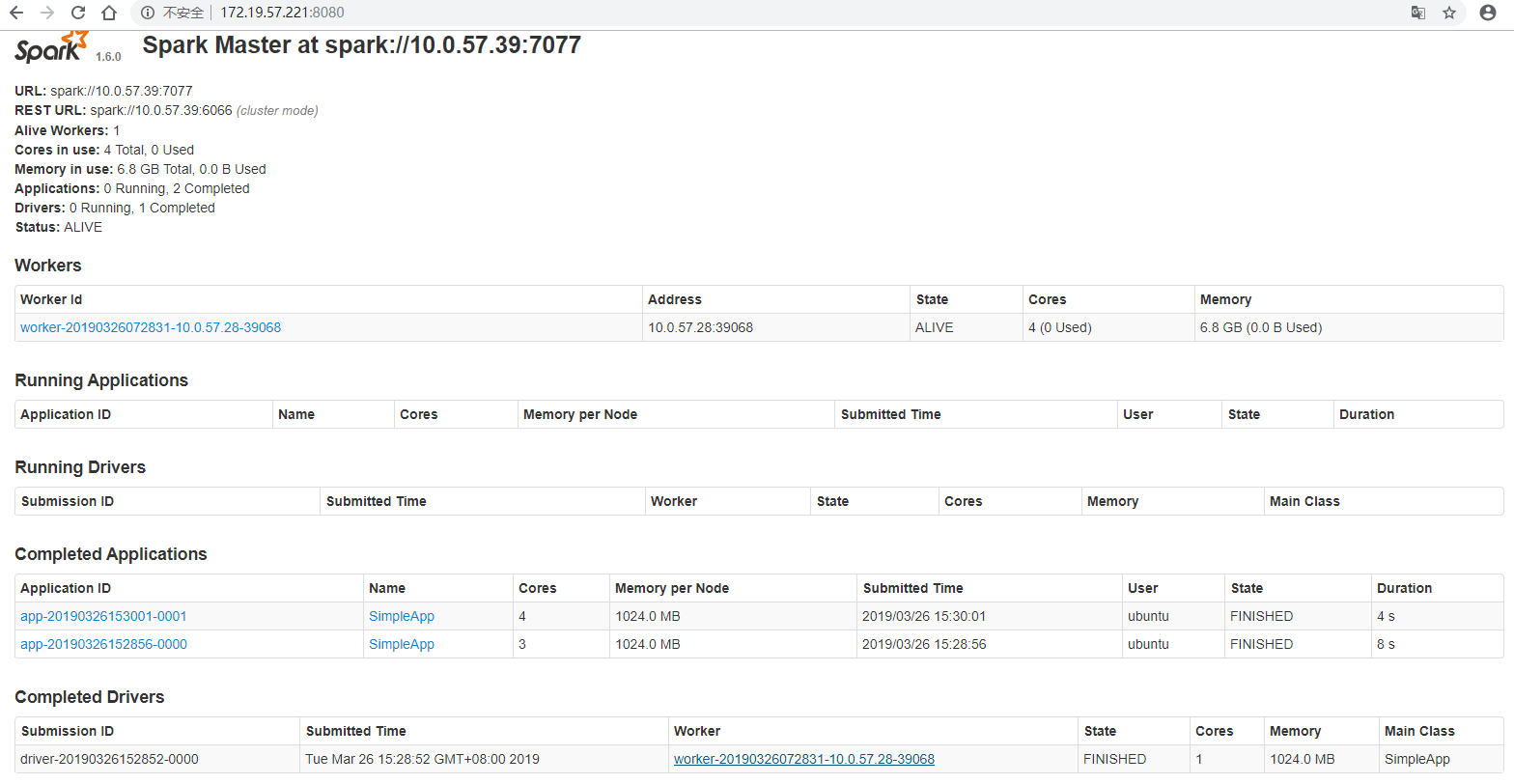

在http://172.19.57.221:8080/上,可以看到spark master。

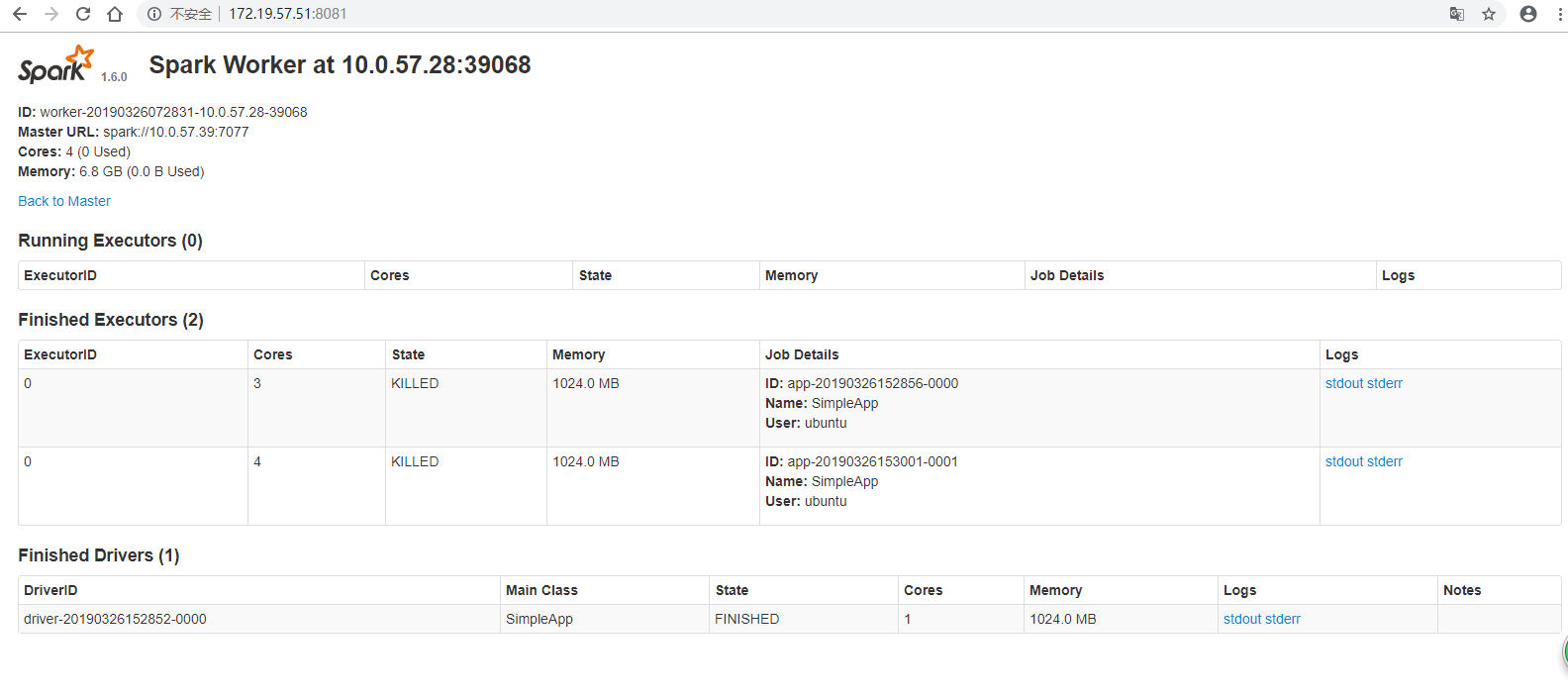

在http://172.19.57.51:8081/上,可以看到spark worker。

点击Finished Drivers里面的stdout就可以查看执行的结果。

完结~

spark学习之路1--用IDEA编写第一个基于java的程序打包,放standalone集群,client和cluster模式上运行的更多相关文章

- [转]Spark学习之路 (三)Spark之RDD

Spark学习之路 (三)Spark之RDD https://www.cnblogs.com/qingyunzong/p/8899715.html 目录 一.RDD的概述 1.1 什么是RDD? ...

- Spark学习之路 (十二)SparkCore的调优之资源调优

摘抄自:https://tech.meituan.com/spark-tuning-basic.html 一.概述 在开发完Spark作业之后,就该为作业配置合适的资源了.Spark的资源参数,基本都 ...

- Spark学习之路 (十二)SparkCore的调优之资源调优[转]

概述 在开发完Spark作业之后,就该为作业配置合适的资源了.Spark的资源参数,基本都可以在spark-submit命令中作为参数设置.很多Spark初学者,通常不知道该设置哪些必要的参数,以及如 ...

- Spark学习之路 (八)SparkCore的调优之开发调优

摘抄自:https://tech.meituan.com/spark-tuning-basic.html 前言 在大数据计算领域,Spark已经成为了越来越流行.越来越受欢迎的计算平台之一.Spark ...

- Spark学习之路 (七)Spark 运行流程

一.Spark中的基本概念 (1)Application:表示你的应用程序 (2)Driver:表示main()函数,创建SparkContext.由SparkContext负责与ClusterMan ...

- Spark学习之路(七)—— 基于ZooKeeper搭建Spark高可用集群

一.集群规划 这里搭建一个3节点的Spark集群,其中三台主机上均部署Worker服务.同时为了保证高可用,除了在hadoop001上部署主Master服务外,还在hadoop002和hadoop00 ...

- Spark学习之路(五)—— Spark运行模式与作业提交

一.作业提交 1.1 spark-submit Spark所有模式均使用spark-submit命令提交作业,其格式如下: ./bin/spark-submit \ --class <main- ...

- Spark学习之路(四)—— RDD常用算子详解

一.Transformation spark常用的Transformation算子如下表: Transformation算子 Meaning(含义) map(func) 对原RDD中每个元素运用 fu ...

- Spark学习之路 (八)SparkCore的调优之开发调优[转]

前言 在大数据计算领域,Spark已经成为了越来越流行.越来越受欢迎的计算平台之一.Spark的功能涵盖了大数据领域的离线批处理.SQL类处理.流式/实时计算.机器学习.图计算等各种不同类型的计算操作 ...

随机推荐

- bootstrap简单使用布局、栅格系统、modal标签页等常用组件入门

<!DOCTYPE html> <html> <head> <title>bootstrap</title> <!-- 引入boots ...

- 缓存系列之四:redis持久化与redis主从复制

一:redis 虽然是一个内存级别的缓存程序,即redis 是使用内存进行数据的缓存的,但是其可以将内存的数据按照一定的策略保存到硬盘上,从而实现数据持久保存的目的,redis支持两种不同方式的数据持 ...

- go import 使用方法记录

import "fmt" 最常用的一种形式 import "./test" 导入同一目录下test包中的内容 import f "fmt ...

- python-面向对象入门

一.面向对象介绍 介绍面向对象之前,先来回顾一下以前学的面向过程的编程思想 面向过程编程: 核心是过程二字,过程指的是解决问题的步骤,即先干什么,再干什么后干什么,基于该思想编程就好比是在设计一条流水 ...

- Synchronizing timer

http://blog.csdn.net/zjq001x/article/details/53107159 集合点: 简单来理解一下,虽然我们的“性能测试”理解为“多用户并发测试”,但真正的并发是不存 ...

- python HTML报告

http://www.cnblogs.com/puresoul/p/7490737.html # coding:utf-8import timeimport unittestimport HTMLTe ...

- Confluence 6 配置推荐更新邮件通知默认的初始化设置

Confluence 为订阅者发送常规邮件报告,这个邮件报告中包含有用户具有查看权限的空间的最新的内容.这个被称为 推荐更新(Recommended Updates)通知. 如果你具有 Conflue ...

- deepin 桌面突然卡死

deepin桌面突然卡死 使用快捷键Ctrl+alt+F2 重启systemctl

- Java测试代码(很不完整,建议大家别看,过几天会再发一次难的版本)

package ATM; import java.io.BufferedReader; import java.io.InputStreamReader; class Account{ priv ...

- java实现 排序算法(鸡尾酒排序&选择排序&插入排序&二分插入排序)

1.鸡尾酒排序算法 源程序代码: package com.SuanFa; public class Cocktial { public static void main(String[] arg ...