轻松上手nodeJs爬取想要页面的数据

开始之前请先确保自己安装了Node.js环境!!!!!!!!

1.在项目文件夹安装两个必须的依赖包

npm install superagent -S

SuperAgent(官网是这样解释的)

-----SuperAgent is light-weight progressive ajax API crafted for flexibility, readability, and a low learning curve after being frustrated with many of the existing request APIs. It also works with Node.js!

-----superagent 是一个轻量的,渐进式的ajax api,可读性好,学习曲线低,内部依赖nodejs原生的请求api,适用于nodejs环境下

npm install cheerio -S

2.Cheerio

-----cheerio是nodejs的抓取页面模块,为服务器特别定制的,快速、灵活、实施的jQuery核心实现。适合各种Web爬虫程序。相当于node.js中的jQuery

3.新建 crawler.js 文件

在里面输入

1 //导入依赖包

2 const http = require("http");

3 const path = require("path");

const url = require("url");

const fs = require("fs");

const superagent = require("superagent");

const cheerio = require("cheerio");

superagent

.get("https://www.zhipin.com/job_detail/?city=100010000&source=10&query=%E5%89%8D%E7%AB%AF")

.end((error, response) => {

//获取页面文档数据

var content = response.text;

//cheerio也就是nodejs下的jQuery 将整个文档包装成一个集合,定义一个变量$接收

var $ = cheerio.load(content);

//定义一个空数组,用来接收数据

var result = [];

//分析文档结构 先获取每个li 再遍历里面的内容(此时每个li里面就存放着我们想要获取的数据)

$(".job-list li .job-primary").each((index, value) => {

//地址和类型为一行显示,需要用到字符串截取

//地址

let address = $(value).find(".info-primary").children().eq(1).html();

//类型

let type = $(value).find(".info-company p").html();

//解码

address = unescape(address.replace(/&#x/g, '%u').replace(/;/g, ''));

type = unescape(type.replace(/&#x/g, '%u').replace(/;/g, ''))

//字符串截取

let addressArr = address.split('<em class="vline"></em>');

let typeArr = type.split('<em class="vline"></em>');

//将获取的数据以对象的形式添加到数组中

result.push({

title: $(value).find(".name .job-title").text(),

money: $(value).find(".name .red").text(),

address: addressArr,

company: $(value).find(".info-company a").text(),

type: typeArr,

position: $(value).find(".info-publis .name").text(),

txImg: $(value).find(".info-publis img").attr("src"),

time: $(value).find(".info-publis p").text()

});

// console.log(typeof $(value).find(".info-primary").children().eq(1).html());

});

//将数组转换成字符串

result = JSON.stringify(result);

//将数组输出到json文件里 刷新目录 即可看到当前文件夹多出一个boss.json文件(打开boss.json文件,ctrl+A全选之后 ctrl+K,再Ctrl+F即可将json文件自动排版)

fs.writeFile("boss.json", result, "utf-8", (error) => {

//监听错误,如正常输出,则打印null

if (error == null) {

console.log("恭喜您,数据爬取成功!请打开json文件,先Ctrl+A,再Ctrl+K,最后Ctrl+F格式化后查看json文件(仅限Visual Studio Code编辑器)");

}

});

});

4.更改数据(如果是静态页面上面的操作基本上就已经完成了 直接node .\cralwer.js,但是现实中很多都不是)

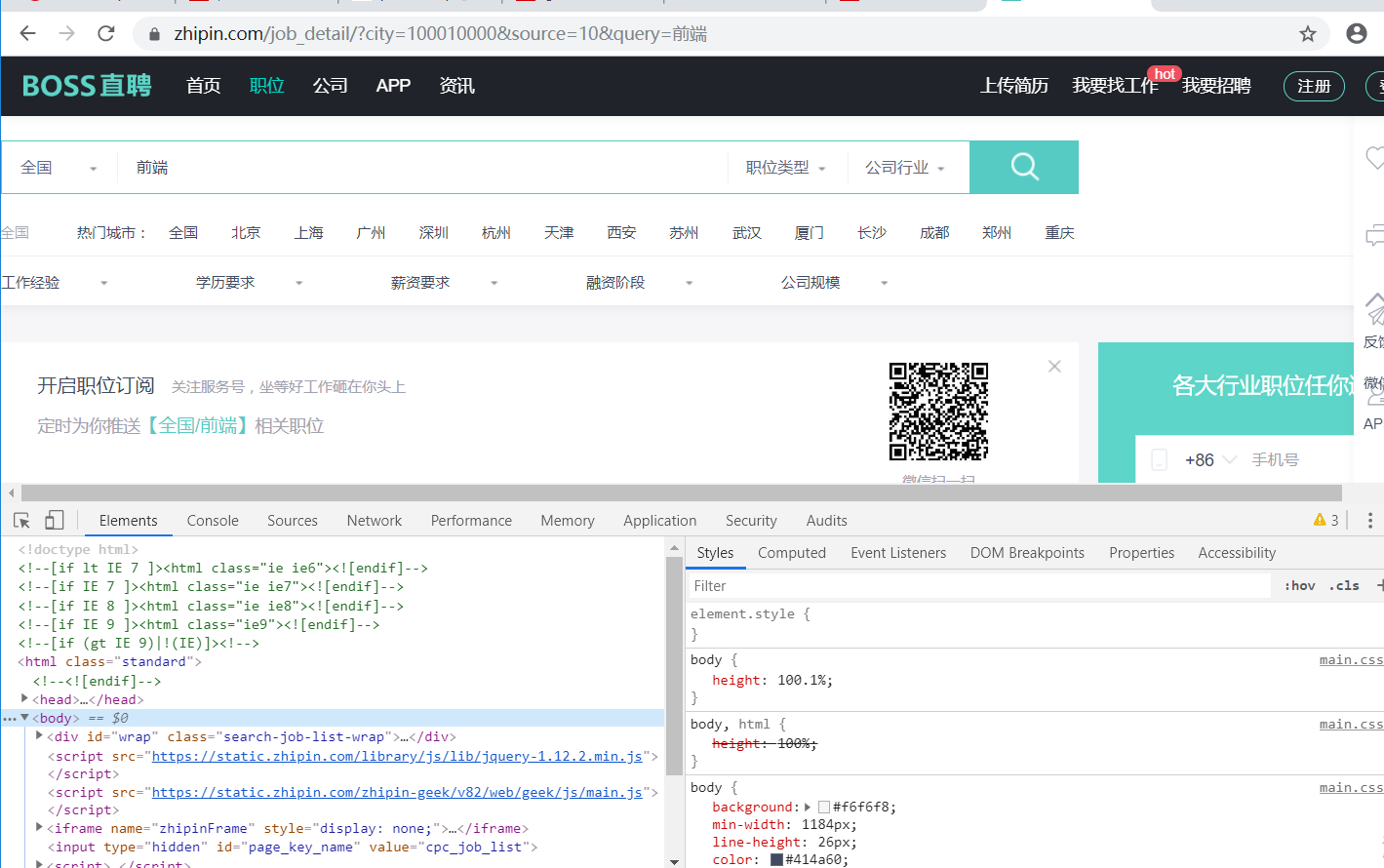

1.在游览器中输入想要爬取的地址

例如:https://www.zhipin.com/job_detail/?city=100010000&source=10&query=%E5%89%8D%E7%AB%AF

2.进入控制台选中body copy element

3.在编辑器中粘贴即可

5.在服务器环境下运行这个网页

7.复制这个地址栏地址

然后粘贴在文件 cralwer.js .get()中

8. 在终端中运行

node .\cralwer.js

最后 本文借鉴于https: //blog.csdn.net/twodogya/article/details/80204322

轻松上手nodeJs爬取想要页面的数据的更多相关文章

- [爬虫]采用Go语言爬取天猫商品页面

最近工作中有一个需求,需要爬取天猫商品的信息,整个需求的过程如下: 修改后端广告交易平台的代码,从阿里上传的素材中解析url,该url格式如下: https://handycam.alicdn.com ...

- Python 2.7_爬取CSDN单页面利用正则提取博客文章及url_20170114

年前有点忙,没来的及更博,最近看爬虫正则的部分 巩固下 1.爬取的单页面:http://blog.csdn.net/column/details/why-bug.html 2.过程 解析url获得网站 ...

- 以豌豆荚为例,用 Scrapy 爬取分类多级页面

本文转载自以下网站:以豌豆荚为例,用 Scrapy 爬取分类多级页面 https://www.makcyun.top/web_scraping_withpython17.html 需要学习的地方: 1 ...

- 大神:python怎么爬取js的页面

大神:python怎么爬取js的页面 可以试试抓包看看它请求了哪些东西, 很多时候可以绕过网页直接请求后面的API 实在不行就上 selenium (selenium大法好) selenium和pha ...

- Python 2.7_爬取CSDN单页面博客文章及url(二)_xpath提取_20170118

上次用的是正则匹配文章title 和文章url,因为最近在看Scrapy框架爬虫 需要了解xpath语法 学习了下拿这个例子练手 1.爬取的单页面还是这个rooturl:http://blog.csd ...

- python 爬取天猫美的评论数据

笔者最近迷上了数据挖掘和机器学习,要做数据分析首先得有数据才行.对于我等平民来说,最廉价的获取数据的方法,应该是用爬虫在网络上爬取数据了.本文记录一下笔者爬取天猫某商品的全过程,淘宝上面的店铺也是类似 ...

- 通过scrapy,从模拟登录开始爬取知乎的问答数据

这篇文章将讲解如何爬取知乎上面的问答数据. 首先,我们需要知道,想要爬取知乎上面的数据,第一步肯定是登录,所以我们先介绍一下模拟登录: 先说一下我的思路: 1.首先我们需要控制登录的入口,重写star ...

- Java爬虫系列四:使用selenium-java爬取js异步请求的数据

在之前的系列文章中介绍了如何使用httpclient抓取页面html以及如何用jsoup分析html源文件内容得到我们想要的数据,但是有时候通过这两种方式不能正常抓取到我们想要的数据,比如看如下例子. ...

- Python3爬取王者官方网站英雄数据

爬取王者官方网站英雄数据 众所周知,王者荣耀已经成为众多人们喜爱的一款休闲娱乐手游,今天就利用python3 爬虫技术爬取官方网站上的几十个英雄的资料,包括官方给出的人物定位,英雄名称,技能名称,CD ...

随机推荐

- 《Redis深度历险:核心原理和应用实践》学习笔记一

1.redis五种数据结构 1.1 String字符串类型,对应java字符串类型 用户信息序列化后,可以用string类型存入redis中批量读写string类型,见效网络消耗数字类型的string ...

- Hibernate入门核心配置文件和orm元数据配置文件详解

框架是什么? 框架是用来提高开发效率的 封装了一些功能,我们需要使用这些功能时,调用即可,不用手动实现 所以框架可以理解为一个半成品的项目,只要懂得如何使用这些功能即可 Hibernate是完全面向对 ...

- ServletContext对象初识

什么是ServletContext? ServletContext代表一个web应用的环境(上下文)对象,ServletContext对象内部封装的是该web应用的信息.一个web应用只有一个Serv ...

- SQL SERVER内部函数大全

SQL SERVER内部函数是SQL数据库中非常重要的一类函数,下面就为您介绍SQL SERVER内部函数,如果您对此方面感兴趣的话,不妨一看. SQL SERVER内部函数: select @@CO ...

- JAVA(JDK,JRE)更改目录安装及环境变量配置

重温一下 JAVA(JDK,JRE)更改目录安装及环境变量配置 https://jingyan.baidu.com/article/e2284b2b5b7ae5e2e7118d11.html 备注:随 ...

- JS知识—面试准备(一)

1.JS内置类型 分为基本数据类型和Object.基本数据类型有:null,undefined,string,boolean,number,symbol. console.log(typeof nul ...

- 重写ArcGIS的TiledMapServiceLayer调用天地图瓦片

require(["esri/layers/TiledMapServiceLayer"], function () { dojo.declare("com.StrongI ...

- vs2005安装 和 Fatal Error C1902

win10系统不能激活 win7可以激活,运行会出现兼容错误,解决办法装2个sp1补丁 拷贝mspdb80.dll到系统目录后会出现 Fatal Error C1902, 解决方法如下: VC++20 ...

- USB入门开发的八个问题&USB枚举『转』

USB 基本知识 USB的重要关键字: 1.端点:位于USB设备或主机上的一个数据缓冲区,用来存放和发送USB的各种数据,每一个端点都有惟一的确定地址,有不同的传输特性(如输入端点.输出端点.配置端点 ...

- 用 Flask 来写个轻博客 (26) — 使用 Flask-Celery-Helper 实现异步任务

Blog 项目源码:https://github.com/JmilkFan/JmilkFan-s-Blog 目录 目录 前文列表 扩展阅读 Celery 将 Celery 加入到应用中 实现向新用户发 ...