爬虫学习笔记(1)-- 利用Python从网页抓取数据

最近想从一个网站上下载资源,懒得一个个的点击下载了,想写一个爬虫把程序全部下载下来,在这里做一个简单的记录

Python的基础语法在这里就不多做叙述了,黑马程序员上有一个基础的视频教学,可以跟着学习一下

本篇博客为基础章:利用Python从网页端抓取数据,闲话不多说,开始正题:

首先需要学习这几个模块:

1 webbrowser:Python自带的模块,打开浏览器获取到指定的页面

2 requests:从英特网上下载文件和网页

3 Beautiful Soup:解析HTML,即网页编写的格式

4 selenium:启动并控制一个Web浏览器。selenium能够填写表单,并模拟鼠标在这个浏览器上点击

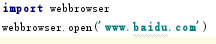

1 webbrowser模块:

可以利用.open()方法打开指定的Url。例如在idea中输入如下代码:

运行Python文件,系统会自动打开一个浏览器,打开百度

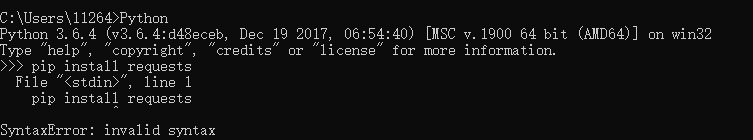

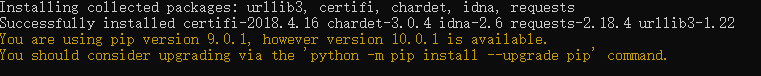

2 requests模块:

这是一个第三方模块,需要先从网上下载:

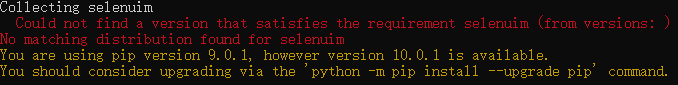

我在Python的运行环境下报错:

切换到cmd环境:

安装成功,在项目中加载requests模块:

import requests

# 调用requests.get()下载文件

res = requests.get('http://www.gutenberg.org/files/57156/57156-h/57156-h.htm')

# 确保程序正在下载失败时候停止

res.raise_for_status()

# Python文件使用“wb”方式打开,写入字符串会报错,因为这种打开方式为:

# 以二进制格式打开一个文件只用于写入。如果该文件已存在则将其覆盖。如果该文件不存在,创建新文件。

playFile = open('test.txt','wb')

# 利用iter_content()方法做循环

# 一段为10000字节

for chuck in res.iter_content(10000):

playFile.write(chuck)

playFile.close()

示例

这里放两个对于这个模块写的比较详细的Blog:

2.1 快速上手

2.2 用法总结

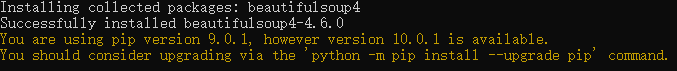

3 Beautiful Soup模块:

用于从html中提取元素信息

首先安装第三方模块:

在项目中加载

首先在项目中添加名为example的html网页,代码如下:

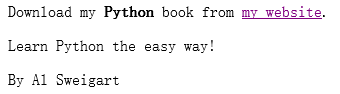

<html><head><title>The Website Title</title></head>

<body>

<p>Download my <strong>Python</strong> book from <a href="http://inventwithpython.com">my website</a>.</p>

<p class="slogan">Learn Python the easy way!</p>

<p>By <span id="author">Al Sweigart</span></p>

</body></html>

example

显示效果如下:

示例代码如下:

import requests,bs4

exampleFile = open('example.html')

exampleSoup = bs4.BeautifulSoup(exampleFile.read(),"html.parser")

print('----------通过id----------')

# 返回一个带有id = "author" 的元素,将这个Tag对象的列表保存在变量elems中

elems = exampleSoup.select("#author")

print(type(elems))

# 列表中只有一个Tag对象,只有一次匹配

print(len(elems))

print(type(elems[0]))

# 元素的文本

print(elems[0].getText())

# 一个字符串,包含开始和结束标签,以及该元素的文本

print(str(elems[0]))

# 字典,包含元素的属性以及属性值

print(elems[0].attrs)

print()

print('----------通过元素----------')

pelements = exampleSoup.select('p')

print(len(pelements))

print(str(pelements[0]))

print(pelements[0].getText())

print(str(pelements[1]))

print(pelements[1].getText())

print()

print('----------通过属性----------')

spqnelem = exampleSoup.select('span')[0]

print(len(spqnelem))

print(str(spqnelem))

print(spqnelem.get('id'))

print(spqnelem.attrs)

BeautifulSoup模块

运行结果如图所示:

值得一提的是,一开始在项目运行的时候吗,爆出如下的错误:

解决方法很简单,在调用bs4.BeautifulSoup()函数时添加“html.parser”参数

一些常用的css选择器的模式:

| 传递给select()方法的选择器 | 将匹配为... |

| soup.select('div’) | 所有名为<div>的元素 |

| soup.select('#author’) | 带有id属性为author的元素 |

| soup.select('.notice’) | 所有使用css class属性为notice的元素 |

| soup.select('div span’) | 所有在<div>元素之内的<span>元素 |

| soup.select('div>span’) | 所有直接在<div>元素之内的<span>元素,中间没有其他元素 |

| soup.select('input[name]’) | 所有名为<input>,并有一个name属性,其值无所谓的元素 |

| soup.select('input[type = 'button']’) | 所有名为<input>,并有一个type属性,其值为button的元素 |

最后贴一个BeautifulSoup的文档以便参考

4 selenium模块:

该模块可以让Python直接控制浏览器

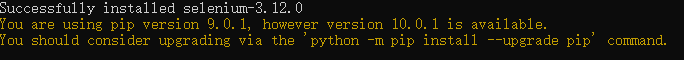

首先导入模块,方法与之前的略有不同,首先需要下载压缩包,直接运行会报错:

解压后在当前文件夹运行pip install selenium,按住Shift,右键选择在此处打开Powershell窗口

在项目中导入模块,方法较之前几个模块,略有不同,示例代码如下:

from selenium import webdriver

import time

bo = webdriver.Firefox()

bo.get('https://www.baidu.com/')

# 模拟点击页面按钮

link = bo.find_element_by_partial_link_text('贴吧')

link.click()

# 模拟填写表单并注册

bo.get('https://mail.qq.com/cgi-bin/loginpage')

bo.switch_to.frame('login_frame')

bo.find_element_by_css_selector('#switcher_plogin').click()

emailelem = bo.find_element_by_id('u')

emailelem.send_keys('账号')

passelem = bo.find_element_by_id('p')

passelem.send_keys('密码')

passelem.submit()

selenium

运行时报以下错误:

缺少geckodriver文件,在这里找到对应的版本后,下载之后解压到Python.exe和FireFox所在的文件夹里面即可

爬虫学习笔记(1)-- 利用Python从网页抓取数据的更多相关文章

- Python网络爬虫笔记(一):网页抓取方式和LXML示例

(一) 三种网页抓取方法 1. 正则表达式: 模块使用C语言编写,速度快,但是很脆弱,可能网页更新后就不能用了. 2. Beautiful Soup 模块使用Python编写,速度慢. ...

- Python爬虫【三】利用requests和正则抓取猫眼电影网上排名前100的电影

#利用requests和正则抓取猫眼电影网上排名前100的电影 import requests from requests.exceptions import RequestException imp ...

- 用python做网页抓取与解析入门笔记[zz]

(from http://chentingpc.me/article/?id=961) 事情的起因是,我做survey的时候搜到了这两本书:Computational Social Network A ...

- 利用python scrapy 框架抓取豆瓣小组数据

因为最近在找房子在豆瓣小组-上海租房上找,发现搜索困难,于是想利用爬虫将数据抓取. 顺便熟悉一下Python. 这边有scrapy 入门教程出处:http://www.cnblogs.com/txw1 ...

- ASP.NET网页抓取数据

我的数据通过一个TextBox输入,这些代码是写在一个button的点击事件里的. 网页数据抓取大概分为两步,第一步是获取网页源代码: 具体注释如下: var currentUrl = TextBox ...

- python3下scrapy爬虫(第六卷:利用cookie模拟登陆抓取个人中心页面)

之前我们爬取的都是那些无需登录就要可以使用的网站但是当我们想爬取自己或他人的个人中心时就需要做登录,一般进入登录页面有两种 ,一个是独立页面登陆,另一个是弹窗,我们先不管验证码登陆的问题 ,现在试一下 ...

- Python爬虫学习笔记之爬虫基础库

知识预览 beautifulsoup的简单使用 beautifulsoup的遍历文档树 beautifulsoup的搜索文档树 beautifulsoup的css选择器 回到顶部 beautifuls ...

- 商业爬虫学习笔记day7-------解析方法之bs4

一.Beautiful Soup 1.简介 Beautiful Soup 是python的一个库,最主要的功能是从网页抓取数据.其特点如下(这三个特点正是bs强大的原因,来自官方手册) a. Beau ...

- python网络爬虫学习笔记

python网络爬虫学习笔记 By 钟桓 9月 4 2014 更新日期:9月 4 2014 文章文件夹 1. 介绍: 2. 从简单语句中開始: 3. 传送数据给server 4. HTTP头-描写叙述 ...

随机推荐

- css实现礼券效果2

<template> <div class="quan clear"> <div class="quanleft"> < ...

- python基础-->流程控制-->分支结构-->单项分支-->双向分支

# ###流程控制 ''' 流程:代码执行过程 流程控制:对代码执行过程的管控 顺序结构:代码默认从上到下依次执行 分支结构:对代码执行过程的管控 循环机构: while for ..in.... 分 ...

- python 选课系统

couser.py: import sys,osBASE_DIR = os.path.dirname(os.path.dirname(os.path.abspath(__file__)))sys.pa ...

- Oracle 11g R2性能优化 tkprof

另一篇博文总结了关于SQL TRACE工具的使用方式,但是产生的trace文件格式阅读起来并不是十分友好,为了更好的分析trace文件,Oracle也自带了一个格式化工具tkprof.tkprof工具 ...

- windows 下面安装make

1.前面文章中已经提到了wingw32的安装,安装好之后设置相应环境变量.2.打开cmd,输入 mingw-get install mingw32-make,会进行安装.3.输入 mingw32-ma ...

- python selenium处理windows窗口

selenium本身处理不了windows窗口,需要借助,PyAutoit包 与autoit工具 这里以文件上传窗口为例: 1.安装python pyauto包 pip install PyAutoi ...

- Oracle游标介绍

Oracle游标使用详解: 游标: 用来查询数据库,获取记录集合(结果集)的指针,我们所说的游标通常是指显式游标,因此从现在起没有特别指明的情况,我们所说的游标都是指显式游标.要在程序中使用游标,必须 ...

- Oracle创建表空间、表、一级用户授权

---恢复内容开始--- 1. 安装: 百度一下你就知道 2. sqlplus登录/sqlplus命令登录 在安装Oracle时,你需要记住设置的“全局数据库名”(默认为orcl) 和 口令,在以两种 ...

- GridView用法

首先,gridview是封装好的,直接在设计界面使用,基本不需要写代码: 1.绑定数据源 GridView最好与LinQDatasourse配合使用,相匹配绑定数据: 2.外观控制 整体控制 自动选择 ...

- java串口通信丢包

java串口通信丢包问题 前段时间公司要求做一个java应用和pos串口通信的工具,调试好了好久每次都是只能接收到一包数据后续的数据都丢失了. 经过修改读写的流的缓存大小亲测都正常代码如下: seri ...