机器学习:评价分类结果(Precision - Recall 的平衡、P - R 曲线)

一、Precision - Recall 的平衡

1)基础理论

- 调整阈值的大小,可以调节精准率和召回率的比重;

- 阈值:threshold,分类边界值,score > threshold 时分类为 1,score < threshold 时分类为 0;

- 阈值增大,精准率提高,召回率降低;阈值减小,精准率降低,召回率提高;

- 精准率和召回率是相互牵制,互相矛盾的两个变量,不能同时增高;

- 逻辑回归的决策边界不一定非是

,也可以是任意的值,可根据业务而定:

,也可以是任意的值,可根据业务而定: ,大于 threshold 时分类为 1,小于 threshold 时分类为 0;

,大于 threshold 时分类为 1,小于 threshold 时分类为 0; - 推广到其它算法,先计算出一个分数值 score ,再与 threshold 比较做分类判定;

2)举例说明精准率和召回率相互制约的关系(一)

- 计算结果 score > 0 时,分类结果为 ★;score < 0 时,分类结果为 ●;

- ★ 类型为所关注的事件;

情景1:threshold = 0

- 精准率:4 / 5 = 0.80;

- 召回率:4 / 6 = 0.67;

情景2:threshold > 0;

- 精准率:2 / 2 = 1.00;

- 召回率:2 / 6 = 0.33;

情景3:threshold < 0;

- 精准率:6 / 8 = 0.75;

- 召回率:6 / 6 = 1.00;

3)举例说明精准率和召回率相互制约的关系(二)

- LogisticRegression() 类中的 predict() 方法中,默认阈值 threshold 为 0,再根据 decision_function() 方法计算的待预测样本的 score 值进行对比分类:score < 0 分类结果为 0,score > 0 分类结果为 1;

- log_reg.decision_function(X_test):计算所有待预测样本的 score 值,以向量的数量类型返回结果;

- 此处的 score 值不是概率值,是另一种判断分类的方式中样本的得分,根据样本的得分对样本进行分类;

例

import numpy as np

from sklearn import datasets digits = datasets.load_digits()

X = digits.data

y = digits.target.copy()

y[digits.target==9] = 1

y[digits.target!=9] = 0 from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=666) from sklearn.linear_model import LogisticRegression

log_reg = LogisticRegression()

log_reg.fit(X_train, y_train)

阈值 threshold = 0

y_predict_1 = log_reg.predict(X_test) from sklearn.metrics import confusion_matrix

confusion_matrix(y_test, y_predict_1)

# 混淆矩阵:array([[403, 2],

[9, 36]], dtype=int64) from sklearn.metrics import precision_score

precision_score(y_test, y_predict_1)

# 精准率:0.9473684210526315 from sklearn.metrics import recall_score

recall_score(y_test, y_predict_1)

# 召回率:0.8阈值 threshold = 5

decision_score = log_reg.decision_function(X_test) # 更改 decision_score ,经过向量变化得到新的预测结果 y_predict_2;

# decision_score > 5,增大阈值为 5;(也就是提高判断标准)

y_predict_2 = np.array(decision_score >= 5, dtype='int') confusion_matrix(y_test, y_predict_2)

# 混淆矩阵:array([[404, 1],

[ 21, 24]], dtype=int64) precision_score(y_test, y_predict_2)

# 精准率:0.96 recall_score(y_test, y_predict_2)

# 召回率:0.5333333333333333# 更改阈值的思路:基于 decision_function() 方法,改变 score 值,简介更阈值,不再经过 predict() 方法,而是经过向量变化得到新的分类结果;

阈值 threshold = -5

decision_score = log_reg.decision_function(X_test)

y_predict_3 = np.array(decision_score >= -5, dtype='int') confusion_matrix(y_test, y_predict_3)

# 混淆矩阵:array([[390, 15],

[5, 40]], dtype=int64) precision_score(y_test, y_predict_3)

# 精准率:0.7272727272727273 recall_score(y_test, y_predict_3)

# 召回率:0.8888888888888888

分析:

- 精准率和召回率相互牵制,相互平衡的,一个升高,另一个就会降低;

- 阈值越大,精准率越高,召回率越低;阈值越小,精准率越低,召回率越高;

- 更改阈值:1)通过 LogisticRegression() 模块下的 decision_function() 方法得到预测得分;2)不使用 predict() 方法,而是重新设定阈值,通过向量转化,直接根据预测得分进行样本分类;

二、精准率 - 召回率曲线(P - R 曲线)

- 对应分类算法,都可以调用其 decision_function() 方法,得到算法对每一个样本的决策的分数值;

- LogisticRegression() 算法中,默认的决策边界阈值为 0,样本的分数值大于 0,该样本分类为 1;样本的分数值小于 0,该样本分类为 0。

- 思路:随着阈值 threshold 的变化,精准率和召回率跟着相应变化;

- 设置不同的 threshold 值:

decision_scores = log_reg.decision_function(X_test)

thresholds = np.arange(np.min(decision_scores), np.max(decision_scores), 0.1)# 0.1 是区间取值的步长;

1)编码实现 threshold - Precision、Recall 曲线和 P - R曲线

import numpy as np

import matplotlib.pyplot as plt

from sklearn import datasets digits = datasets.load_digits()

X = digits.data

y = digits.target.copy()

y[digits.target==9] = 1

y[digits.target!=9] = 0 from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=666) from sklearn.linear_model import LogisticRegression

log_reg = LogisticRegression()

log_reg.fit(X_train, y_train)

decision_scores = log_reg.decision_function(X_test) from sklearn.metrics import precision_score

from sklearn.metrics import recall_score precisions = []

recalls = []

thresholds = np.arange(np.min(decision_scores), np.max(decision_scores), 0.1) for threshold in thresholds:

y_predict = np.array(decision_scores >= threshold, dtype='int')

precisions.append(precision_score(y_test, y_predict))

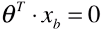

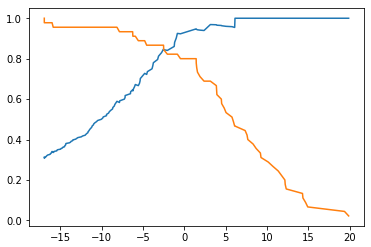

recalls.append(recall_score(y_test, y_predict))threshold - Precision、Recall 曲线

plt.plot(thresholds, precisions)

plt.plot(thresholds, recalls)

plt.show()

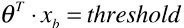

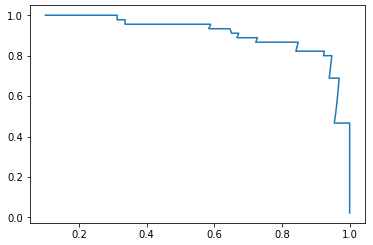

P - R 曲线

plt.plot(precisions, recalls)

plt.show()

2)scikit-learn 中 precision_recall_curve() 方法

- 根据 y_test、y_predicts 直接求解 precisions、recalls、thresholds;

from sklearn.metrics import precision_recall_curve

from sklearn.metrics import precision_recall_curve precisions, recalls, thresholds = precision_recall_curve(y_test, decision_scores) precisions.shape

# (145,) recalls.shape

# (145,) thresholds.shape

# (144,)

- 现象:thresholds 中的元素个数,比 precisions 和recalls 中的元素个数少 1 个;

- 原因:当 precision = 1、recall = 0 时,不存在 threshold;

threshold - Precision、Recall 曲线

plt.plot(thresholds, precisions[:-1])

plt.plot(thresholds, recalls[:-1])

plt.show()

P - R 曲线

plt.plot(precisions, recalls)

plt.show()

- 途中曲线开始急剧下降的点,可能就是精准率和召回率平衡位置的点;

3)分析

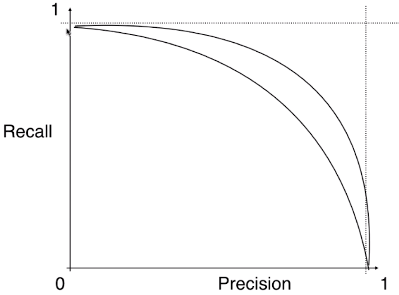

- 不同的模型对应的不同的 Precision - Recall 曲线:

- 外层曲线对应的模型更优;或者称与坐标轴一起包围的面积越大者越优。

- P - R 曲线也可以作为选择算法、模型、超参数的指标;但一般不适用此曲线,而是使用 ROC 曲线;

机器学习:评价分类结果(Precision - Recall 的平衡、P - R 曲线)的更多相关文章

- 目标检测的评价标准mAP, Precision, Recall, Accuracy

目录 metrics 评价方法 TP , FP , TN , FN 概念 计算流程 Accuracy , Precision ,Recall Average Precision PR曲线 AP计算 A ...

- 机器学习--如何理解Accuracy, Precision, Recall, F1 score

当我们在谈论一个模型好坏的时候,我们常常会听到准确率(Accuracy)这个词,我们也会听到"如何才能使模型的Accurcy更高".那么是不是准确率最高的模型就一定是最好的模型? 这篇博文会向大家解释 ...

- 机器学习基础梳理—(accuracy,precision,recall浅谈)

一.TP TN FP FN TP:标签为正例,预测为正例(P),即预测正确(T) TN:标签为负例,预测为负例(N),即预测正确(T) FP:标签为负例,预测为正例(P),即预测错误(F) FN:标签 ...

- 机器学习classification_report方法及precision精确率和recall召回率 说明

classification_report简介 sklearn中的classification_report函数用于显示主要分类指标的文本报告.在报告中显示每个类的精确度,召回率,F1值等信息. 主要 ...

- 机器学习:评价分类结果(ROC 曲线)

一.基础理解 1)定义 ROC(Receiver Operation Characteristic Curve) 定义:描述 TPR 和 FPR 之间的关系: 功能:应用于比较两个模型的优劣: 模型不 ...

- 机器学习:评价分类结果(F1 Score)

一.基础 疑问1:具体使用算法时,怎么通过精准率和召回率判断算法优劣? 根据具体使用场景而定: 例1:股票预测,未来该股票是升还是降?业务要求更精准的找到能够上升的股票:此情况下,模型精准率越高越优. ...

- 通过Precision/Recall判断分类结果偏差极大时算法的性能

当我们对某些问题进行分类时,真实结果的分布会有明显偏差. 例如对是否患癌症进行分类,testing set 中可能只有0.5%的人患了癌症. 此时如果直接数误分类数的话,那么一个每次都预测人没有癌症的 ...

- 机器学习之分类问题实战(基于UCI Bank Marketing Dataset)

导读: 分类问题是机器学习应用中的常见问题,而二分类问题是其中的典型,例如垃圾邮件的识别.本文基于UCI机器学习数据库中的银行营销数据集,从对数据集进行探索,数据预处理和特征工程,到学习模型的评估与选 ...

- Precision,Recall,F1的计算

Precision又叫查准率,Recall又叫查全率.这两个指标共同衡量才能评价模型输出结果. TP: 预测为1(Positive),实际也为1(Truth-预测对了) TN: 预测为0(Negati ...

随机推荐

- Shell脚本实现SSH免密登录及批量配置管理

本节索引 场景分析 ssh免密登录 pssh工具批量管理 SHELL自动化脚本 本篇总结 场景分析 作为一个运维工程师,不是每个人工作的环境都想阿里.腾讯那样,动不动就上亿的PV量,上万台服务器.我们 ...

- 什么是OOM?如何解决OOM问题!

1.什么是OOM? 程序申请内存过大,虚拟机无法满足我们,然后自杀了.这个现象通常出现在大图片的APP开发,或者需要用到很多图片的时候.通俗来讲就是我们的APP需要申请一块内存来存放图片的时候,系统认 ...

- Fatal error: cannot create 'R_TempDir'

[user@mgmt dir]$ R Fatal error: cannot create 'R_TempDir' [user@mgmt dir]$ ll -ad /tmp drwxrwxrwt. 2 ...

- python进阶01

基础部分python学完,咱们可以深入了解下python高阶知识点,让我们一起来学习吧! 1.面向对象进阶 1)元类 1.1.1:python创建类原理 python创建类: class Object ...

- HBase-存储-概览

概览 HBase主要处理两种文件:一种是预写日志(Write-Ahead Log,WAL),另一种是实际的数据文件.这两种文件主要由HRegionServer管理.在某些情况下,HMaster也可以进 ...

- C++两种字符串传参构造函数

第一种: #include"iostream" #include"string" using namespace std; class Motor{ prote ...

- PHP error_get_last() 函数

error_get_last() 函数返回最后发生的错误 返回了一个关联数组,描述了最后错误的信息,以该错误的 "type". "message"." ...

- python中的SMTP发送邮件

一. 介绍 python3中自带了smtplib模块和email模块 smtplib模块:负责与邮件服务器的交互 email模块:负责组织邮件内容 二. smtplib模块 smtplib模块:主要是 ...

- Unity 3D 离线协议

在联网状态下,获得离线协议,然后导入到Untiy的协议管理器里. 以后在断网的情况下,也能离线使用Unity. 步骤: 1.生成 Request 文件.(Unity_v5.3.1f1.alf) 1) ...

- IDEA 上传更新的代码到码云上

1.Commit Changes 2. .