python爬虫之requests的高级使用

1、requests能上传文件

# 导入requests模块

import requests

# 定义一个dict

files = {'file': open('D:/360Downloads/1.txt', 'rb')}

# post请求

response = requests.post("http://httpbin.org/post",files=files)

# 以字符串形式返回

print(response.text)

结果:

{

"args": {},

"data": "",

"files": {

"file": "data:application/octet-stream;base64,ZGVtbzAxxOO6ww=="

},

"form": {},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Content-Length": "151",

"Content-Type": "multipart/form-data; boundary=9502063320dadabde8e0197a299a933c",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.23.0",

"X-Amzn-Trace-Id": "Root=1-5e71d1bc-221f2f9c5a23aa1c11d21b3c"

},

"json": null,

"origin": "111.77.5.100",

"url": "http://httpbin.org/post"

}

Process finished with exit code 0

2、requests能获取cookies(网页识别码)

# 导入requests模块

import requests

# get请求

response=requests.get("https://fanyi.baidu.com")

# 获取cookies

print(response.cookies)

# 获取cookies信息

print(tuple(response.cookies))

# 调用items,遍历一个dict的key和value

for key,value in response.cookies.items():

print(key+"="+value)

结果:

<RequestsCookieJar[<Cookie BAIDUID=72BE4EB04DB39349C036BA1BDF4D2895:FG=1 for .baidu.com/>]>

(Cookie(version=0, name='BAIDUID', value='72BE4EB04DB39349C036BA1BDF4D2895:FG=1', port=None, port_specified=False, domain='.baidu.com', domain_specified=True, domain_initial_dot=True, path='/', path_specified=True, secure=False, expires=1616058282, discard=False, comment=None, comment_url=None, rest={}, rfc2109=True),)

BAIDUID=405DCB00DFE182D6581CBFAA3297C6BA:FG=1

Process finished with exit code 0

知道cookies的name,快速访问cookies的value:

# 导入requests模块

import requests

# get请求

response= requests.get('http://fanyi.baidu.com')

# 访问cookies的值

print(response.cookies['BAIDUID'])

# 以元组形式返回cookies

print(tuple(response.cookies))

结果:

B5A1A6A7B622F295DF802DA4D10F92CB:FG=1

(Cookie(version=0, name='BAIDUID', value='B5A1A6A7B622F295DF802DA4D10F92CB:FG=1', port=None, port_specified=False, domain='.baidu.com', domain_specified=True, domain_initial_dot=True, path='/', path_specified=True, secure=False, expires=1616068429, discard=False, comment=None, comment_url=None, rest={}, rfc2109=True),)

Process finished with exit code 0

3、会话维持

cookies一个作用就是模拟登入,做会话维持,如何把自己的cookies发送到服务器上:

# 导入requests模块

import requests

# 导入json模块

import json

# 定义cookies,dict形式

cookies={"number":"1234567"}

# get请求,加上

response=requests.get("http://httpbin.org/cookies",cookies=cookies)

# 以字符串形式返回

print(response.text)

结果:

{

"cookies": {

"number": "1234567"

}

}

Process finished with exit code 0

或者用requests.session也可以把自己的cookies发到服务器上:

# 导入requests模块

import requests

# 建立session对象

session = requests.session()

# get请求

response = session.get('http://httpbin.org/cookies/set/number/1234567')

# 以字符串形式返回

print(response.text)

结果:

{

"cookies": {

"number": "1234567"

}

}

Process finished with exit code 0

4、证书验证

# 导入requests模块

import requests

# get请求

response = requests.get('https://www.12306.cn')

# 在请求https时,request会进行证书的验证,如果验证失败则会抛出异常

print(response.status_code)

如果无证书验证,会抛出异常。有证书验证,返回200。

怎么关闭证书验证:

# 导入requests模块

import requests

# get请求,关闭证书验证

response = requests.get('https://www.12306.cn',verify=False)

# 在请求https时,request会进行证书的验证,如果验证失败则会抛出异常

print(response.status_code)

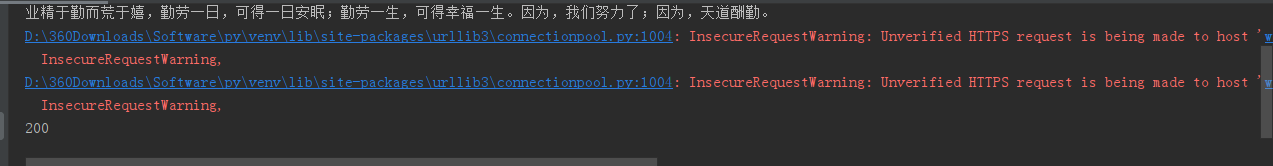

结果:显示有warning

关闭证书验证后,怎么消除waring:

# 导入urllib3函数

from requests.packages import urllib3

# 导入requests模块

import requests

# 消除警告

urllib3.disable_warnings()

# get请求

response = requests.get('https://www.12306.cn', verify=False)

# 返回状态代码

print(response.status_code)

结果:200

python爬虫之requests的高级使用的更多相关文章

- Python爬虫Urllib库的高级用法

Python爬虫Urllib库的高级用法 设置Headers 有些网站不会同意程序直接用上面的方式进行访问,如果识别有问题,那么站点根本不会响应,所以为了完全模拟浏览器的工作,我们需要设置一些Head ...

- 孤荷凌寒自学python第六十七天初步了解Python爬虫初识requests模块

孤荷凌寒自学python第六十七天初步了解Python爬虫初识requests模块 (完整学习过程屏幕记录视频地址在文末) 从今天起开始正式学习Python的爬虫. 今天已经初步了解了两个主要的模块: ...

- Python爬虫练习(requests模块)

Python爬虫练习(requests模块) 关注公众号"轻松学编程"了解更多. 一.使用正则表达式解析页面和提取数据 1.爬取动态数据(js格式) 爬取http://fund.e ...

- python爬虫之requests库

在python爬虫中,要想获取url的原网页,就要用到众所周知的强大好用的requests库,在2018年python文档年度总结中,requests库使用率排行第一,接下来就开始简单的使用reque ...

- Python爬虫之requests

爬虫之requests 库的基本用法 基本请求: requests库提供了http所有的基本请求方式.例如 r = requests.post("http://httpbin.org/pos ...

- Python 爬虫二 requests模块

requests模块 Requests模块 get方法请求 整体演示一下: import requests response = requests.get("https://www.baid ...

- python爬虫之requests的基本使用

简介 Requests是用python语言基于urllib编写的,采用的是Apache2 Licensed开源协议的HTTP库,Requests它会比urllib更加方便,可以节约我们大量的工作. 一 ...

- python爬虫之requests库介绍(二)

一.requests基于cookie操作 引言:有些时候,我们在使用爬虫程序去爬取一些用户相关信息的数据(爬取张三“人人网”个人主页数据)时,如果使用之前requests模块常规操作时,往往达不到我们 ...

- Python爬虫之requests库介绍(一)

一:Requests: 让 HTTP 服务人类 虽然Python的标准库中 urllib2 模块已经包含了平常我们使用的大多数功能,但是它的 API 使用起来让人感觉不太好,而 Requests 自称 ...

随机推荐

- 使用java程序jxl操作Excel表格

在实际开发中企业办公系统都会涉及到一个打印报表的功能,也许你的需求就是把web前端展示的员工信息以Excel表格形式打印出来 ,那么具体怎么操作下面我来实现一下 首先我们使用的是 java的jxl技术 ...

- 软件基础1Word文档编辑

word文档编辑 启动Word2010 创建文档,<你好word>. 编辑文字. 保存的三种方式. ctrl+s. 点击文件选择保存,或另存为. 快速工具栏保存按钮. 设置字体 1.通过工 ...

- 去除 inline-block 元素间距

案例重现 布局时经常能发现inline元素和inline-block元素水平呈现的元素间,会存在着一些意想不到的间距,举例: .inline-block { display: inline-block ...

- Vue2.0 【第一季】第7节 v-bind指令

目录 Vue2.0 [第一季] 第7节 v-bind指令 第7节 v-bind指令 v-bind缩写 绑定CSS样式 Vue2.0 [第一季] 第7节 v-bind指令 第7节 v-bind指令 v- ...

- scrapydweb的初步使用(管理分布式爬虫)

https://github.com/my8100/files/blob/master/scrapydweb/README_CN.md 一.安装配置 1.请先确保所有主机都已经安装和启动 Scrapy ...

- python基础学习day6

代码块.缓存机制.深浅拷贝.集合 id.is.== id: 可类比为身份号,具有唯一性,若id 相同则为同一个数据. #获取数据的内存地址(随机的地址:内存临时加载,存储数据,当程序运行结束后,内存地 ...

- 【视频+图文】Java基础经典练习题(一)输出2-100之间的素数,及素数个数

目录 第一题:判断2-100之间有多少个素数,并输出所有素数. 1.视频讲解: 2.思路分析: 代码讲解:以i=4为例 4.为大家准备了彩蛋: 能解决题目的代码并不是一次就可以写好的 我们需要根据我们 ...

- HTTP中主要的头字段

HTTP中主要的头字段 头字段类型 含义 备注 通用头:适用于请求和响应消息的头字段 Date 表示请求和响应生成的日期 Pragma 表示数据是否允许缓存的通信选项 Cache-Contro ...

- Java并发编程学习前期知识下篇

Java并发编程学习前期知识下篇 通过上一篇<Java并发编程学习前期知识上篇>我们知道了在Java并发中的可见性是什么?volatile的定义以及JMM的定义.我们先来看看几个大厂真实的 ...

- Java-迭代器(新手)

//导入的包.import java.util.ArrayList;import java.util.Collection;import java.util.Iterator;//创建的一个类.pub ...