虚假新闻检测(CADM)《Unsupervised Domain Adaptation for COVID-19 Information Service with Contrastive Adversarial Domain Mixup》

论文信息

论文标题:Unsupervised Domain Adaptation for COVID-19 Information Service with Contrastive Adversarial Domain Mixup

论文作者:Huimin Zeng, Zhenrui Yue, Ziyi Kou, Lanyu Shang, Yang Zhang, Dong Wang

论文来源:aRxiv 2022

论文地址:download

论文代码:download

1 Introduction

2 Problem Statement

Regarding misinformation detection, we aim at training a model $f$ , which takes an input text $\boldsymbol{x}$ (a COVID-19 claim or a piece of news) to predict whether the information contained in $\boldsymbol{x}$ is valid or not (i.e., a binary classification task). Moreover, in our domain adaptation problem, we use $\mathcal{P}$ to denote source domain data distribution and $\mathcal{Q}$ for the target domain data distribution. Each data point ($\boldsymbol{x}$, $y$) contains an input segment of COVID-19 claim or news ($\boldsymbol{x}$) and a label $y \in\{0,1\}$ ( $y=1$ for true information and $y=0$ for false information). To differentiate the notations of the data sampled from the source distribution $\mathcal{P}$ and the target distribution $\mathcal{Q}$ , we further introduce two definitions of the domain data:

- Source domain: The subscript $s$ is used to denote the source domain data: $\mathcal{X}_{s}=\left\{\left(\boldsymbol{x}_{s}, y_{s}\right) \mid\left(\boldsymbol{x}_{s}, y_{s}\right) \sim \mathcal{P}\right\}$ .

- Target domain: Similarly, the subscript t is used to denote the target domain data: $\mathcal{X}_{t}=\left\{\boldsymbol{x}_{t} \mid \boldsymbol{x}_{t} \sim \mathcal{P}\right\}$ . Note that in our unsupervised setting, the ground truth labels of target domain data $y_{t}$ are not used during training.

Our goal is to adapt a classifier $f$ trained on $\mathcal{P}$ to $\mathcal{Q}$ . For a given target domain input $\boldsymbol{x}_{t}$ , a well-adapted model aims at making predictions as correctly as possible.

3 Method

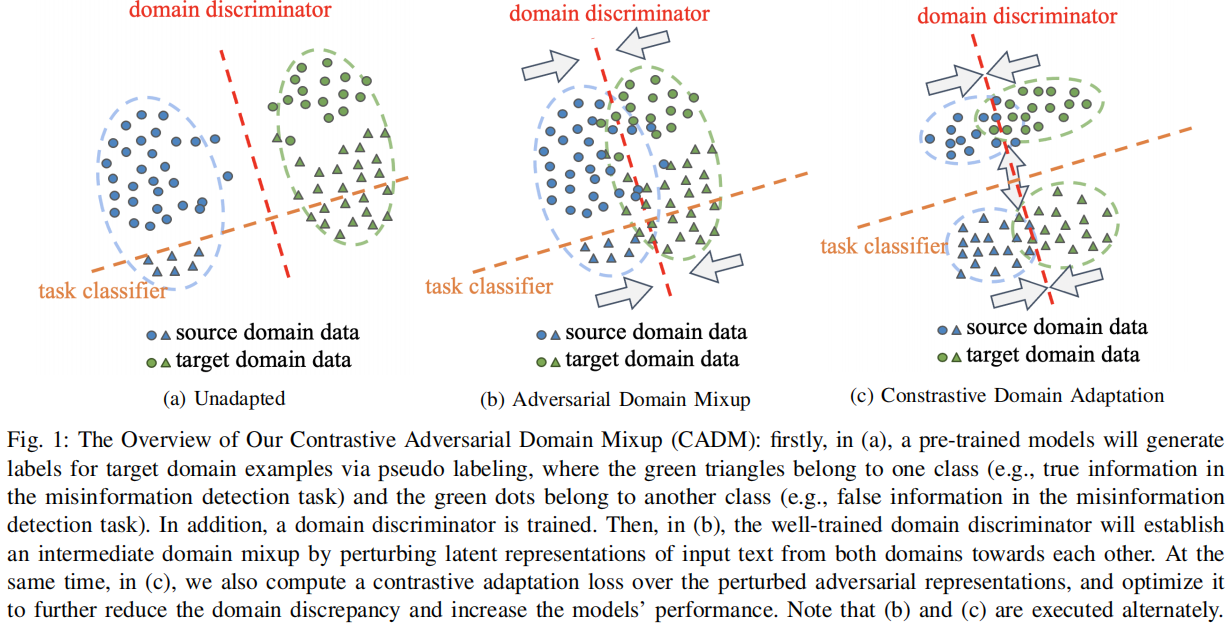

整体框架:

3.1 Domain Discriminator

第一步是训练一个域鉴别器 $f_{D}$ 来分类输入数据是属于源域还是属于目标域。该域鉴别器与 COVID 模型共享相同的 BERT Encoder $f_{e}$,并具有不同的二进制分类模块 $f_{D}$。域鉴别器以 BERT Encoder 中的标记 [CLS] 表示作为输入,以预测输入数据的域,如所示:

$\hat{y}=f_{D}(\boldsymbol{z}) \quad\quad(1)$

其中,$z$ 是 token [CLS] 的表示。

对于 $f_{D}$ 的训练,明确地将源域数据的域标签 $y_{D}$ 定义为 $y_{D}=0$,将目标域数据的域标签定义为 $y_{D}=1$。因此,对域鉴别器的训练可以表述为:

$\underset{f_{D}}{\text{min}} \;\; \mathbb{E}_{\left(\boldsymbol{x}, y_{D}\right) \sim \mathcal{X}^{\prime}}\left[l\left(f_{D}\left(f_{e}(\boldsymbol{x})\right), y_{D}\right)\right] \quad\quad(2)$

其中,$\mathcal{X}^{\prime}$ 表示带有域标签的源域和目标域训练数据的合并数据集。

3.2 Adversarial Domain Mixup

在训练了域鉴别器后,我们提出直接干扰来自源域和目标域的输入数据的潜在表示到域鉴别器的决策边界,如 Figure 1b 所示。为此,来自两个域的扰动表示(即域对抗表示)可以变得更接近,表明域间隙减小。在此,从两个域生成的域对抗性表示在模型的潜在特征空间中形成了一个平滑的中间域混合。在数学上,通过求解一个优化问题,可以找到干扰训练样本 $ \boldsymbol{x}$ 的潜在表示 $ \boldsymbol{z}$ 的最优扰动 $\delta^{*}$:

$\begin{array}{r}\mathcal{A}\left(f_{e}, f_{D}, \boldsymbol{x}, y_{D}, \epsilon\right)=\underset{\boldsymbol{\delta}}{\text{max}} \left[l\left(f_{D}(\boldsymbol{z}+\boldsymbol{\delta}), y_{D}\right)\right] \\\text { s.t. } \quad\|\boldsymbol{\delta}\| \leq \epsilon, \quad \boldsymbol{z}=f_{e}(\boldsymbol{x})\end{array}\quad\quad(3)$

注意,在上面的方程中,我们引入了一个超参数 $\epsilon$ 来约束扰动 $\delta$ 的范数,从而避免了无穷大解。最后,将 $\text{Eq.3}$ 应用于合并训练集 $\mathcal{X}^{\prime}$ 中的所有训练样本,得到对抗域混合 $\mathcal{Z}^{\prime}$:

$\begin{aligned}\mathcal{Z}^{\prime} & =\left\{\boldsymbol{z}^{\prime} \mid \boldsymbol{z}^{\prime}=\boldsymbol{z}+\mathcal{A}\left(f_{e}, f_{D}, \boldsymbol{x}, y_{D}, \epsilon\right),\left(\boldsymbol{x}, y_{D}\right) \in \mathcal{X}^{\prime}\right\} \\& :=\mathcal{Z}_{s}^{\prime} \cup \mathcal{Z}_{t}^{\prime}\end{aligned}\quad\quad(4)$

其中,$\mathcal{Z}_{s}^{\prime}$ 是扰动的源特性,$\mathcal{Z}_{t}^{\prime}$ 是受干扰的目标特征。我们使用投影梯度下降(PGD)来近似 $\text{Eq.3}$ 的解,如在[7],[8]。

3.3 Contrastive Domain Adaptation

接下来,受[6]的启发,我们提出了 $\mathcal{Z}_{a d v}$ 的双重对比自适应损失,以进一步将源数据域的知识适应到目标数据域。首先,我们减少了类内表示之间的域差异。也就是说,如果一个表示从源数据域的标签是真(或假)和一个表示从目标数据域的伪标签是真(或假),那么这两个表示被视为类内表示,我们减少域之间的差异。其次,如 Figure 1c 所示,真实信息和虚假信息的表示之间的差异将被扩大。

为了计算我们提出的对比自适应损失,我们建议使用径向基函数(RBF)来度量标记类之间的差异。在[11]中,RBF 被证明是量化深度神经网络中不确定性的有效工具。由于我们的伪标记过程是为了自动过滤出目标域数据的低置信度标签,因此使用RBF来衡量标记类之间的差异可以有效地提高伪标签的质量,最终有助于模型的域适应。

在形式上,使用 RBF 内核的定义:$k\left(z_{1}, z_{2}\right)=\exp \left[-\frac{\left\|\boldsymbol{z}_{1}-\boldsymbol{z}_{2}\right\|^{2}}{2 \sigma^{2}}\right]$

我们定义了错误信息检测任务的类感知损失如下:

$\begin{aligned}\mathcal{L}_{\text {con }}\left(\mathcal{Z}^{\prime}\right) =&-\sum_{i=1}^{\left|\mathcal{Z}_{s}^{\prime}\right|} \sum_{j=1}^{\left|\mathcal{Z}_{t}^{\prime}\right|} \frac{\mathbb{1}\left(y_{s}^{(i)}=0, \hat{y}_{t}^{(j)}=0\right) k\left(\boldsymbol{z}_{s}^{(i)}, \boldsymbol{z}_{t}^{(j)}\right)}{\sum_{l=1}^{\left|\mathcal{Z}_{s}^{\prime}\right|} \sum_{m=1}^{\left|\mathcal{Z}_{t}^{\prime}\right|} \mathbb{1}\left(y_{s}^{(l)}=0, \hat{y}_{t}^{(m)}=0\right)} \\& -\sum_{i=1}^{\left|\mathcal{Z}_{s}^{\prime}\right|} \sum_{j=1}^{\left|\mathcal{Z}_{t}^{\prime}\right|} \frac{\mathbb{1}\left(y_{s}^{(i)}=1, \hat{y}_{t}^{(j)}=1\right) k\left(\boldsymbol{z}_{s}^{(i)}, \boldsymbol{z}_{t}^{(j)}\right)}{\sum_{l=1}^{\left|\mathcal{Z}_{s}^{\prime}\right|} \sum_{m=1}^{\left|\mathcal{Z}_{t}^{\prime}\right|} \mathbb{1}\left(y_{s}^{(l)}=1, \hat{y}_{t}^{(m)}=1\right)} \\& +\sum_{i=1}^{\left|\mathcal{Z}_{s}^{\prime}\right|} \sum_{j=1}^{\left|\mathcal{Z}_{s}^{\prime}\right|} \frac{\mathbb{1}\left(y_{s}^{(i)}=1, y_{s}^{(j)}=0\right) k\left(\boldsymbol{z}_{s}^{(i)}, \boldsymbol{z}_{s}^{(j)}\right)}{\sum_{l=1}^{\left|\mathcal{Z}_{s}^{\prime}\right|} \sum_{m=1}^{\left|\mathcal{Z}_{s}^{\prime}\right|} \mathbb{1}\left(y_{s}^{(l)}=1, y_{s}^{(m)}=0\right)} \\& +\sum_{i=1}^{\left|\mathcal{Z}_{t}^{\prime}\right|} \sum_{j=1}^{\left|\mathcal{Z}_{t}^{\prime}\right|} \frac{\mathbb{1}\left(\hat{y}_{t}^{(i)}=1, \hat{y}_{t}^{(j)}=0\right) k\left(\boldsymbol{z}_{t}^{(i)}, \boldsymbol{z}_{t}^{(j)}\right)}{\sum_{l=1}^{\left|\mathcal{Z}_{t}^{\prime}\right|} \sum_{m=1}^{\left|\mathcal{Z}_{t}^{\prime}\right|} \mathbb{1}\left(\hat{y}_{t}^{(l)}=1, \hat{y}_{t}^{(m)}=0\right)}\end{aligned}\quad\quad(5)$

其中,$\hat{y}_{t}$ 为目标域样本的伪标签,$z$ 表示标记 CLS 的表示。

3.4 Overall Contrastive Adaptation Loss

现在,我们将任务分类问题的交叉熵损失和上述对比自适应损失合并为 COVID 模型的单一优化目标:

$\mathcal{L}_{\text {all }}=\mathcal{L}_{c e}(\boldsymbol{\mathcal { X }})+\lambda \mathcal{L}_{\text {con }}\left(\mathcal{Z}^{\prime}\right) \quad\quad(6)$

其中,$\mathcal{L}_{c e}$ 代表交叉熵损失函数。

4 Experiment

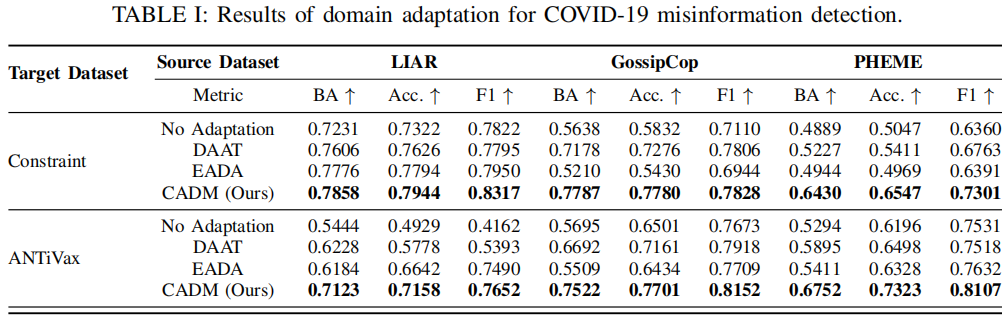

在我们的实验中,我们使用了三个 source misinformation datasets :GossipCop , LIAR and PHEME,两个 COVID misinformation datasets:Constraint and ANTiVax。

Results:

虚假新闻检测(CADM)《Unsupervised Domain Adaptation for COVID-19 Information Service with Contrastive Adversarial Domain Mixup》的更多相关文章

- Domain Adaptation (3)论文翻译

Abstract The recent success of deep neural networks relies on massive amounts of labeled data. For a ...

- Unsupervised Domain Adaptation by Backpropagation

目录 概 主要内容 代码 Ganin Y. and Lempitsky V. Unsupervised Domain Adaptation by Backpropagation. ICML 2015. ...

- Deep Transfer Network: Unsupervised Domain Adaptation

转自:http://blog.csdn.net/mao_xiao_feng/article/details/54426101 一.Domain adaptation 在开始介绍之前,首先我们需要知道D ...

- 论文阅读 | A Curriculum Domain Adaptation Approach to the Semantic Segmentation of Urban Scenes

paper链接:https://arxiv.org/pdf/1812.09953.pdf code链接:https://github.com/YangZhang4065/AdaptationSeg 摘 ...

- Domain Adaptation (1)选题讲解

1 所选论文 论文题目: <Unsupervised Domain Adaptation with Residual Transfer Networks> 论文信息: NIPS2016, ...

- A Primer on Domain Adaptation Theory and Applications

目录 概 主要内容 符号说明 Prior shift Covariate shift KMM Concept shift Subspace mapping Wasserstein distance 应 ...

- 关于模式识别中的domain generalization 和 domain adaptation

今晚听了李文博士的报告"Domain Generalization and Adaptation using Low-Rank Examplar Classifiers",讲的很精 ...

- 【论文笔记】Domain Adaptation via Transfer Component Analysis

论文题目:<Domain Adaptation via Transfer Component Analysis> 论文作者:Sinno Jialin Pan, Ivor W. Tsang, ...

- 域适应(Domain adaptation)

定义 在迁移学习中, 当源域和目标的数据分布不同 ,但两个任务相同时,这种 特殊 的迁移学习 叫做域适应 (Domain Adaptation). Domain adaptation有哪些实现手段呢? ...

- Domain Adaptation论文笔记

领域自适应问题一般有两个域,一个是源域,一个是目标域,领域自适应可利用来自源域的带标签的数据(源域中有大量带标签的数据)来帮助学习目标域中的网络参数(目标域中很少甚至没有带标签的数据).领域自适应如今 ...

随机推荐

- Hive Beeline 命令行参数

[hadoop@hive ~]$ beeline --help[中文版] The Beeline CLI 支持以下命令行参数: Option Description --autoCommit=[tru ...

- 检测 MySQL 服务是否存活 shell脚本

#!/bin/bash # 检测 MySQL 服务是否存活 # host 为你需要检测的 MySQL 主机的 IP 地址,user 为 MySQL 账户名,passwd 为密码 # 这些信息需要根据实 ...

- 了解 Flutter 开发者们的 IDE 使用情况

作者 / JaYoung Lee, UX Researcher at Google Google 的 Flutter 团队负责构建和维护 Android Studio (基于 IntelliJ-IDE ...

- Linxu常用命令

一.Linux权限的概念 Linux下有两种用户:普通用户和超级用户: 普通用户:在linux下做有限的事情: 超级用户:可以在linux系统下做任何事情,不受限制. 普通用户的提示符是"$ ...

- 8.-Django应用及分布式路由

一.应用 应用在Django项目中是一个独立的业务模块,可以包含自己的路由.视图.模版.模型,可以看成一个小的mtv 创建步骤 1.项目下用manage.py中的子命令创建应用文件夹 python3 ...

- Droplet——一款轻量的Golang应用层框架

Github地址 如标题所描述的,Droplet 是一个 轻量 的 中间层框架,何为中间层呢? 通常来说,我们的程序(注意这里我们仅仅讨论程序的范围,而非作为一个系统,因此这里不设计如 LB.Gate ...

- 使用 StringUtils.split 的坑

点赞再看,动力无限. 微信搜「程序猿阿朗 」. 本文 Github.com/niumoo/JavaNotes 和 未读代码博客 已经收录,有很多知识点和系列文章. 在日常的 Java 开发中,由于 J ...

- JS学习笔记 (三) 对象进阶

1.JS对象 1.1 JS对象特征 1.JS对象是基本数据数据类型之一,是一种复合值,可以看成若干属性的集合. 属性是名值对的形式(key:value) 属性名是字符串,因此可以把对象看成是字符串到值 ...

- java将流量KB转换为GB、MB、KB格式

/** * 转换流量格式为xxGBxxMBxxKB * @param flow 156165(xxxxxx) */ public String changeFlowFormat(String flow ...

- 数组还是HashSet?

我记得大约在半年前,有个朋友问我一个问题,现在有一个选型: 一个性能敏感场景,有一个集合,需要确定某一个元素在不在这个集合中,我是用数组直接Contains还是使用HashSet<T>.C ...