利用Pycharm本地调试spark-streaming(包含kafka和zookeeper等操作)

环境准备就不说了!

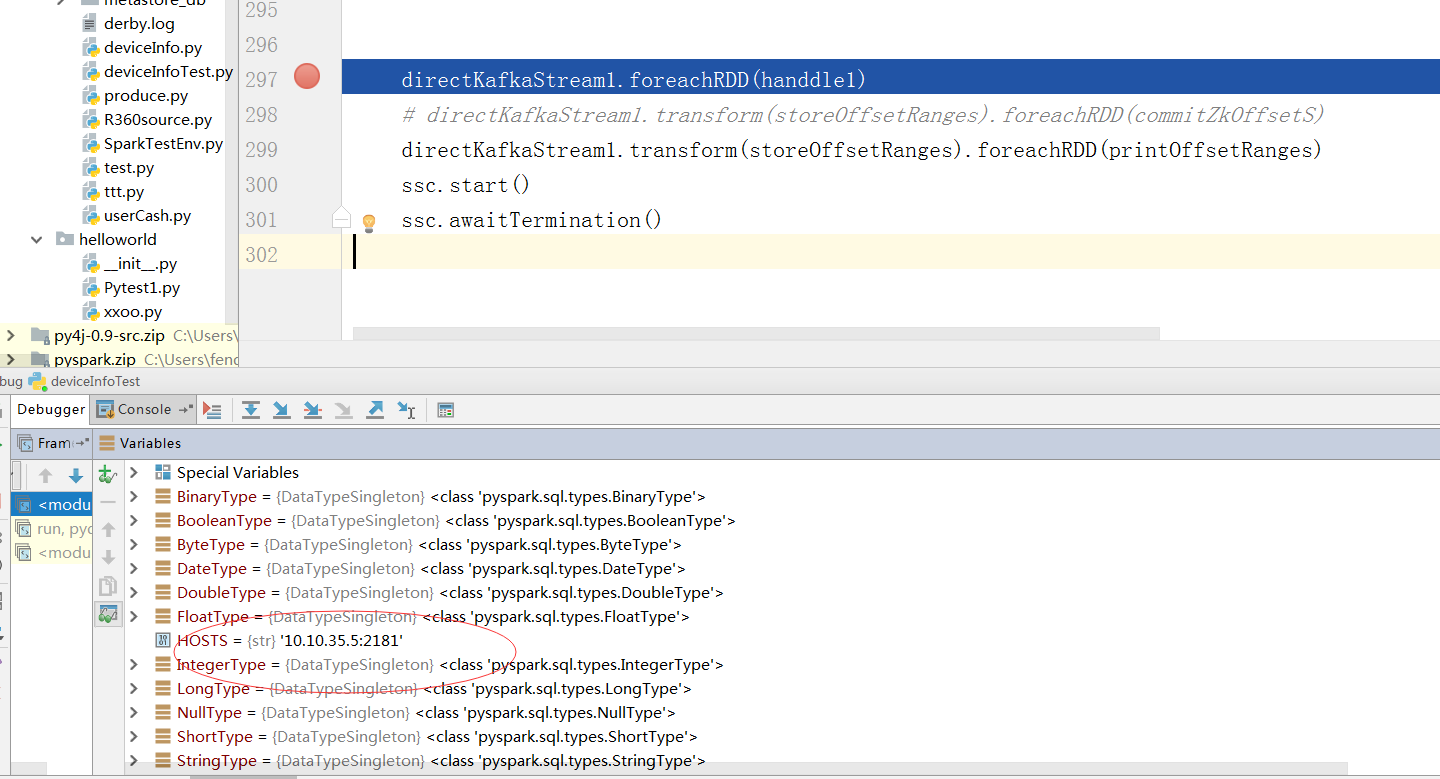

第一步:打开Pycharm,在File->Setting->Project Structure中点击Add Content Root 添加本地python调用java和spark的组件(因为python和spark通讯是通过调用Jvm的相关组件实现的) ,包含两个压缩包可以在spark的安装包里面找到

第二步:在项目文件内添加本地配置

os.environ['SPARK_HOME'] = r'C:\Users\fengxu\Desktop\bigdata-software\spark-1.6.0-bin-hadoop2.6'

os.environ['JAVA_HOME'] = r'C:\software\jdk1.8'

sys.path.append(r"C:\Users\fengxu\Desktop\bigdata-software\spark-1.6.0-bin-hadoop2.6\python") 第三步:也是最重要的一步需要在本地的spark安装包内找到spark-defaults.conf的配置文件在末尾添加一行

spark.jars.packages org.apache.spark:spark-streaming-kafka-0-8_2.10:2.0.1

这是本地操作kafka和一些组件的必备jar包。配置完毕以后就可以在maven仓库下载相关jar包了

(报了很多错误,查阅了很多英文文档才找到答案,国内没有找到相关问题答案) 成功后就可以利用本地的python和本地相关组件(spark,kafka hdfs)调试和操作远程组件了!

成功后会在本地环境生成(多线程模拟集群)写入的hdfs文件可以调试了,操作本地文件还是很有用的哈!

利用Pycharm本地调试spark-streaming(包含kafka和zookeeper等操作)的更多相关文章

- Spark streaming消费Kafka的正确姿势

前言 在游戏项目中,需要对每天千万级的游戏评论信息进行词频统计,在生产者一端,我们将数据按照每天的拉取时间存入了Kafka当中,而在消费者一端,我们利用了spark streaming从kafka中不 ...

- Spark学习之路(十六)—— Spark Streaming 整合 Kafka

一.版本说明 Spark针对Kafka的不同版本,提供了两套整合方案:spark-streaming-kafka-0-8和spark-streaming-kafka-0-10,其主要区别如下: s ...

- Spark 系列(十六)—— Spark Streaming 整合 Kafka

一.版本说明 Spark 针对 Kafka 的不同版本,提供了两套整合方案:spark-streaming-kafka-0-8 和 spark-streaming-kafka-0-10,其主要区别如下 ...

- Spark Streaming和Kafka整合保证数据零丢失

当我们正确地部署好Spark Streaming,我们就可以使用Spark Streaming提供的零数据丢失机制.为了体验这个关键的特性,你需要满足以下几个先决条件: 1.输入的数据来自可靠的数据源 ...

- spark streaming 整合kafka(二)

转载:https://www.iteblog.com/archives/1326.html 和基于Receiver接收数据不一样,这种方式定期地从Kafka的topic+partition中查询最新的 ...

- Spark Streaming之四:Spark Streaming 与 Kafka 集成分析

前言 Spark Streaming 诞生于2013年,成为Spark平台上流式处理的解决方案,同时也给大家提供除Storm 以外的另一个选择.这篇内容主要介绍Spark Streaming 数据接收 ...

- Spark Streaming和Kafka整合是如何保证数据零丢失

转载:https://www.iteblog.com/archives/1591.html 当我们正确地部署好Spark Streaming,我们就可以使用Spark Streaming提供的零数据丢 ...

- spark streaming 对接kafka记录

spark streaming 对接kafka 有两种方式: 参考: http://group.jobbole.com/15559/ http://blog.csdn.net/kwu_ganymede ...

- Spark Streaming、Kafka结合Spark JDBC External DataSouces处理案例

场景:使用Spark Streaming接收Kafka发送过来的数据与关系型数据库中的表进行相关的查询操作: Kafka发送过来的数据格式为:id.name.cityId,分隔符为tab zhangs ...

随机推荐

- MongoDB学习教程(3)-常用命令

1.MongoDB 条件操作符 描述 条件操作符用于比较两个表达式并从mongoDB集合中获取数据. 在本章节中,我们将讨论如何在MongoDB中使用条件操作符. MongoDB中条件操作符有: (& ...

- python urllib、urlparse、urllib2、cookielib

1.urllib模块 1.urllib.urlopen(url[,data[,proxies]]) 打开一个url的方法,返回一个文件对象,然后可以进行类似文件对象的操作.本例试着打开google i ...

- ZOJ2334 Monkey King 并查集 STL

题意:两家原始人(猴)打交道后成为一家猴,打交道时两家分别派出最帅的两位猴子,颜值各自减半,问每次打交道后新家族最帅的猴子的颜值.当然,已经是一家子就没有必要打交道了,因为没有猴希望颜值降低,毕竟还得 ...

- Two-phase clustering process for outliers detection 文章翻译

基于二阶段聚集模式的异常探测 M.F .Jiang, S.S. Tseng *, C.M. Su 国立交通大学计算机与信息科学系,中国台北市新竹路100150号 1999年11月17日; 2000年4 ...

- Opencv怎么读入,显示,保存图像-OpenCV步步精深

怎么读入图像呢? 我们用 img = cv2.imread('图像路径\原图像名称',0) 原图像名称要有后缀 .png , .jpg等等原图像带有的后缀. 这里我们着重说明一下图像路径,这个路径一定 ...

- jenkins、ant、selenium、testng搭建自动化测试框架

如果在你的理解中自动化测试就是在eclipse里面讲webdriver的包引入,然后写一些测试脚本,这就是你所说的自动化测试,其实这个还不能算是真正的自动化测试,你见过每次需要运行的时候还需要打开ec ...

- Appium python自动化测试系列之Android UIAutomator终极定位(七)

android uiautomator text定位 可能有人不知道为什么说android uiautomator是终极定位,而且android uiautomator和appium有什么关系呢?如果 ...

- ELK简介

什么是ELK ELK是ElasticSearch,LogStash以及Kibana三个产品的首字母缩写.是可以和商业产品 Splunk 相媲美开源项目. 2013 年,Logstash 被 Elast ...

- EF6中使用事务的方法

默认情况当你执行SaveChanges()的时候(insert update delete)来操作数据库时,Entity Framework会把这个操作包装在一个事务里,当操作结束后,事务也结束了. ...

- HTML5网站大观:15个精美的 HTML5 单页网站作品欣赏

HTML5 是现在Web开发领域的热点,更多的开发人员开始使用HTML5来开发交互性强.效果出众的Web应用和游戏.今天,本文收集了15个精美的 HTML5 单页网站作品,让大家感受一下 HTML5 ...