66、Spark Streaming:数据处理原理剖析与源码分析(block与batch关系透彻解析)

一、数据处理原理剖析

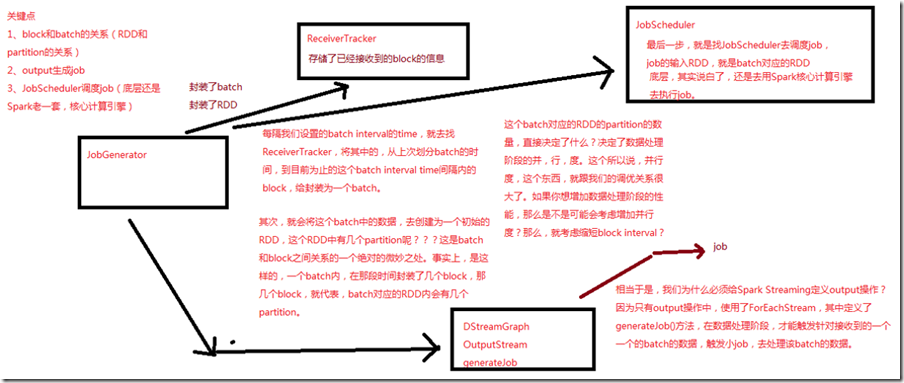

每隔我们设置的batch interval 的time,就去找ReceiverTracker,将其中的,从上次划分batch的时间,到目前为止的这个batch interval time间隔内的block封装为一个batch; 其次,会将这个batch中的数据,去创建为一个初始的RDD,一个batch内,在这段时间封装了几个block,就代表这个batch对应的RDD内会有几个partition; 这个batch对应的RDD的partition决定了数据处理阶段的并行度,这个跟调优关系很大,如果想增加数据处理阶段的性能,就考虑增加并行度,那么就考虑缩短block interval; 只有output操作中,使用了ForEachStream,其中定义了generatorJob()方法,在数据处理阶段,才触发针对接收到的一个一个batch的数据,触发小的job,去处理该batch的数据; 最后一步,去找JobScheduler去调度job,job的输入RDD,就是batch对应的RDD;

二、源码分析

入口,JobGenerator的generateJobs()方法

###org.apache.spark.streaming.scheduler/JobGenerator.scala /**

* 定时,调度generateJobs()方法,传入一个time,其实就是一个batch interval内的时间段

*/

private def generateJobs(time: Time) {

// Set the SparkEnv in this thread, so that job generation code can access the environment

// Example: BlockRDDs are created in this thread, and it needs to access BlockManager

// Update: This is probably redundant after threadlocal stuff in SparkEnv has been removed.

SparkEnv.set(ssc.env)

Try {

// 找到ReceiverTracker,调用其allocateBlocksToBatch方法,将当前时间段内的block分配给一个batch,并为其

// 创建一个RDD

jobScheduler.receiverTracker.allocateBlocksToBatch(time) // allocate received blocks to batch

// 调用DSteamGraph的generateJobs()来根据程序定义的DSteam之间的依赖关系和算子,生成job

graph.generateJobs(time) // generate jobs using allocated block

} match {

// 如果成功创建了job

case Success(jobs) =>

// 从ReceiverTracker中,获取当前batch interval对应的block数据

val receivedBlockInfos =

jobScheduler.receiverTracker.getBlocksOfBatch(time).mapValues { _.toArray }

// 用jobScheduler提交job,其对应的原始数据,是那批block

jobScheduler.submitJobSet(JobSet(time, jobs, receivedBlockInfos))

case Failure(e) =>

jobScheduler.reportError("Error generating jobs for time " + time, e)

}

eventActor ! DoCheckpoint(time)

}

66、Spark Streaming:数据处理原理剖析与源码分析(block与batch关系透彻解析)的更多相关文章

- 65、Spark Streaming:数据接收原理剖析与源码分析

一.数据接收原理 二.源码分析 入口包org.apache.spark.streaming.receiver下ReceiverSupervisorImpl类的onStart()方法 ### overr ...

- 64、Spark Streaming:StreamingContext初始化与Receiver启动原理剖析与源码分析

一.StreamingContext源码分析 ###入口 org.apache.spark.streaming/StreamingContext.scala /** * 在创建和完成StreamCon ...

- 18、TaskScheduler原理剖析与源码分析

一.源码分析 ###入口 ###org.apache.spark.scheduler/DAGScheduler.scala // 最后,针对stage的task,创建TaskSet对象,调用taskS ...

- 22、BlockManager原理剖析与源码分析

一.原理 1.图解 Driver上,有BlockManagerMaster,它的功能,就是负责对各个节点上的BlockManager内部管理的数据的元数据进行维护, 比如Block的增删改等操作,都会 ...

- 21、Shuffle原理剖析与源码分析

一.普通shuffle原理 1.图解 假设有一个节点上面运行了4个 ShuffleMapTask,然后这个节点上只有2个 cpu core.假如有另外一台节点,上面也运行了4个ResultTask,现 ...

- 20、Task原理剖析与源码分析

一.Task原理 1.图解 二.源码分析 1. ###org.apache.spark.executor/Executor.scala /** * 从TaskRunner开始,来看Task的运行的工作 ...

- 19、Executor原理剖析与源码分析

一.原理图解 二.源码分析 1.Executor注册机制 worker中为Application启动的executor,实际上是启动了这个CoarseGrainedExecutorBackend进程: ...

- 23、CacheManager原理剖析与源码分析

一.图解 二.源码分析 ###org.apache.spark.rdd/RDD.scalal ###入口 final def iterator(split: Partition, context: T ...

- 16、job触发流程原理剖析与源码分析

一.以Wordcount为例来分析 1.Wordcount val lines = sc.textFile() val words = lines.flatMap(line => line.sp ...

随机推荐

- 分页工具类PageResult

1.工具类 public class PageResult implements Serializable { private Long total;//总记录数 private List rows; ...

- CGContextRef&CGMutablePathRef&UIBezierPath简单学习

简单的四句介绍 Quartz是一个二维绘图引擎,使用的是CoreGraphics库,同时支持iOS和Mac系统 CGContextRef:获取图形上下文.或者叫作用域,即画布,他是专门用来保存绘画期间 ...

- head 与 tail

head head [-n] 数字『文件』 显示前面n行 例如 head -n 3 test 显示 test 文件的前 3 行,也可以写作 head -3 test 比较有趣的是 -n 后面的数字,可 ...

- MySQL数据库之互联网常用分库分表方案

一.数据库瓶颈 不管是IO瓶颈,还是CPU瓶颈,最终都会导致数据库的活跃连接数增加,进而逼近甚至达到数据库可承载活跃连接数的阈值.在业务Service来看就是,可用数据库连接少甚至无连接可用.接下来就 ...

- vue中监听页面是否有回车键按下

需求:当我在登录页面输入密码和账号后,按下回车键实现登录 mounted(){ let _this = this document.onkeydown = function(e) { if(e.key ...

- python多任务的实现:线程,进程,协程

什么叫“多任务”呢?简单地说,就是操作系统可以同时运行多个任务.打个比方,你一边在用浏览器上网,一边在听MP3,一边在用Word赶作业,这就是多任务,至少同时有3个任务正在运行.还有很多任务悄悄地在后 ...

- Cannot assign to read only property 'exports' of object '#<Object>' ,文件名大小写问题!!!

有些坑不知道怎么就掉进去,可能一辈子都爬不起来!!! 一.错误描述 昨天还好好的,今天早上来从git获取了一下别人提交的代码就出错了!而提交代码的人 运行一点错误都没有!!! cya@KQ-101 M ...

- svn 没有killall命令的解决方法 -bash: killall: command not found

debian.ubuntu系统下: apt-get install psmisc centos 下: yum install psmisc

- spring boot 过滤器、拦截器的区别与使用

原文:https://blog.csdn.net/heweimingming/article/details/79993591 拦截器与过滤器的区别: 1.过滤器和拦截器触发时机不一样,过滤器是在请求 ...

- windows10访问ftp中文乱码怎么办?

windows10访问ftp中文乱码怎么办? 打开控制面板 选择时间和区域 选择更改数字格式 点击管理并点击更改系统区域设置 打勾