Learning from delayed reward (Q-Learning的提出) (Watkins博士毕业论文)(建立了现在的reinforcement Learning模型)

最近在在学习强化学习方面的东西, 对于现有的很多文章中关于强化学习的知识很是不理解,很多都是一个公式套一个公式,也没有什么太多的解释,感觉像是在看天书一般,经过了较长时间的挣扎最后决定从一些基础的东西开始入手,于是便有了这篇论文的发现。

Learning from Delayed Reward

该论文的页面为: http://www.cs.rhul.ac.uk/~chrisw/thesis.html

下载地址为: http://www.cs.rhul.ac.uk/~chrisw/new_thesis.pdf

论文页面对这篇文章的描述:

The thesis introduces the notion of reinforcement learning as learning to control a Markov Decision Process by incremental dynamic programming,

and describes a range of algorithms for doing this, including Q-learning, for which a sketch of a proof of convergence is given.

这篇文章虽然在现有的很多文献中并不是很被提及,但是它却具有很大的意义。这篇文章(准确的说是作者在1987年发表的一篇会议论文,集成在了这篇学位论文中了)建立了现在意义上的强化学习模型,它第一次将trial-and-error 和 dynammic programming 和 temporal diffecrence 结合在了一起,并提出了Q-Learning算法。在某种意义上它可谓是“万恶之源”。

=====================================================

============================================================

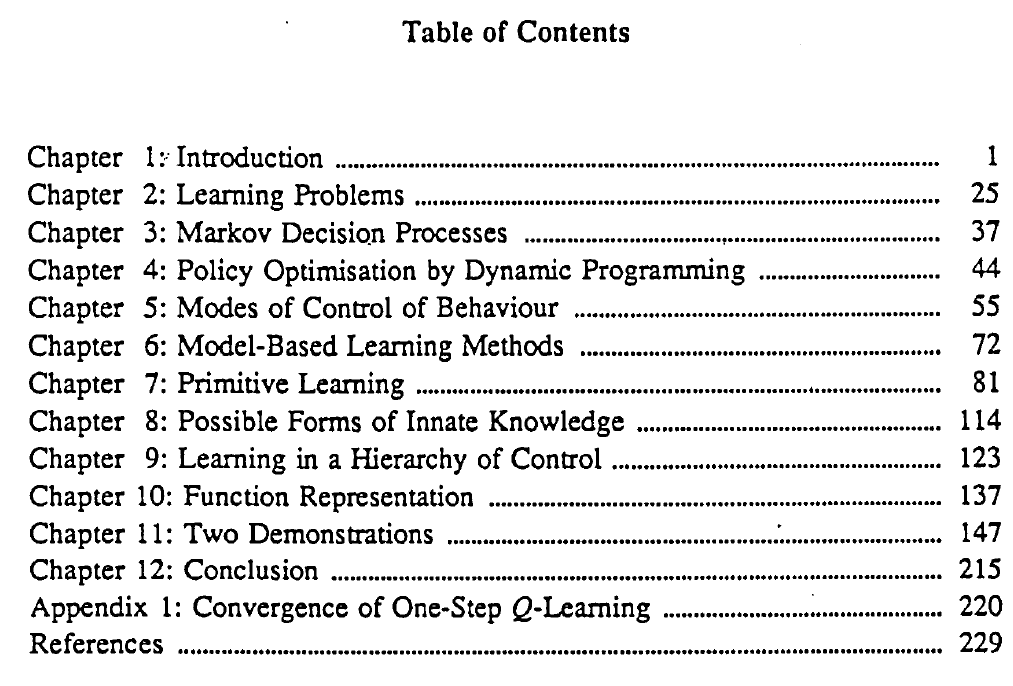

文章目录:

Learning from delayed reward (Q-Learning的提出) (Watkins博士毕业论文)(建立了现在的reinforcement Learning模型)的更多相关文章

- [DQN] What is Deep Reinforcement Learning

已经成为DL中专门的一派,高大上的样子 Intro: MIT 6.S191 Lecture 6: Deep Reinforcement Learning Course: CS 294: Deep Re ...

- 论文笔记之:Asynchronous Methods for Deep Reinforcement Learning

Asynchronous Methods for Deep Reinforcement Learning ICML 2016 深度强化学习最近被人发现貌似不太稳定,有人提出很多改善的方法,这些方法有很 ...

- Awesome Reinforcement Learning

Awesome Reinforcement Learning A curated list of resources dedicated to reinforcement learning. We h ...

- (转) Deep Reinforcement Learning: Pong from Pixels

Andrej Karpathy blog About Hacker's guide to Neural Networks Deep Reinforcement Learning: Pong from ...

- 论文笔记系列-Neural Architecture Search With Reinforcement Learning

摘要 神经网络在多个领域都取得了不错的成绩,但是神经网络的合理设计却是比较困难的.在本篇论文中,作者使用 递归网络去省城神经网络的模型描述,并且使用 增强学习训练RNN,以使得生成得到的模型在验证集上 ...

- (zhuan) Deep Reinforcement Learning Papers

Deep Reinforcement Learning Papers A list of recent papers regarding deep reinforcement learning. Th ...

- 【资料总结】| Deep Reinforcement Learning 深度强化学习

在机器学习中,我们经常会分类为有监督学习和无监督学习,但是尝尝会忽略一个重要的分支,强化学习.有监督学习和无监督学习非常好去区分,学习的目标,有无标签等都是区分标准.如果说监督学习的目标是预测,那么强 ...

- (zhuan) Paper Collection of Multi-Agent Reinforcement Learning (MARL)

this blog from: https://github.com/LantaoYu/MARL-Papers Paper Collection of Multi-Agent Reinforcemen ...

- Understanding dopamine and reinforcement learning: The dopamine reward prediction error hypothesis

郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布! Abstract 在中脑多巴胺能神经元的研究中取得了许多最新进展.要了解这些进步以及它们之间的相互关系,需要对作为解释框架并指导正在进行的 ...

随机推荐

- 升级php7一些需要注意的地方

1.升级过程涉及代码的主要处理的就是几个扩展(mysql.mssql .mcrypt.ereg)使用到的一些废弃函数(call_user_method.call_user_method_array等) ...

- shell 加法计算

Shell 相加目前发现有 3 种写法: 1. a=10 b=20 c=`expr ${a} + ${b}` echo "$c" 2. c=$[ `expr 10 + 20` ] ...

- STL_iterator返回值

1. iterator的类型 有 单向的/双向的/可以随意移动的... 2. 一些 容器/算法 的返回值 是 iterator类型的,如何确定 返回的 iterator是什么类型的? 3.

- visudo使用笔记

目录前言一.介绍二.配置文件简介三.实战配置 前言: su 的确为管理带来方便,通过切换到root下,能完成所有系统管理工具,只要把root的密码交给任何一个普通用户,他都能切换到root来完成 ...

- 部署ovf模板,突然出现用户取消任务。

查看了网上的文章,自己做了一下实验. 发觉导出ovf模板时,虚拟CDROM的选项要选[客户端设备],导入时才不会出事. 参考连接 http://lukebarklimore.wordpress.com ...

- Loading Xps from MemoryStream

A common way of loading XpsDocument is to load it from file: XpsDocument document = new XpsDocument( ...

- JDK并发工具之同步控制

一.synchronized的功能扩展:重入锁(java.util.concurrent.locks.ReentrantLock) 重入锁可以完全替代synchronized关键字.在JDK 5.0的 ...

- Multi-target tracking by Lagrangian relaxation to min-cost network flow

Multi-target tracking by Lagrangian relaxation to min-cost network flow high-order constraints min-c ...

- CF-500div2-A/B/C

A. Piles With Stones time limit per test 1 second memory limit per test 256 megabytes input standard ...

- 二分求LIS并打印结果

1275: God's ladder [DP] 时间限制: 1 Sec 内存限制: 128 MB Special Judge 题目描述 天明来到神之宫殿,在他眼前出现了若干个石柱,每个石柱上有1枚金 ...