tvm relay IR 可视化

本文地址:

https://www.cnblogs.com/wanger-sjtu/p/16819877.html

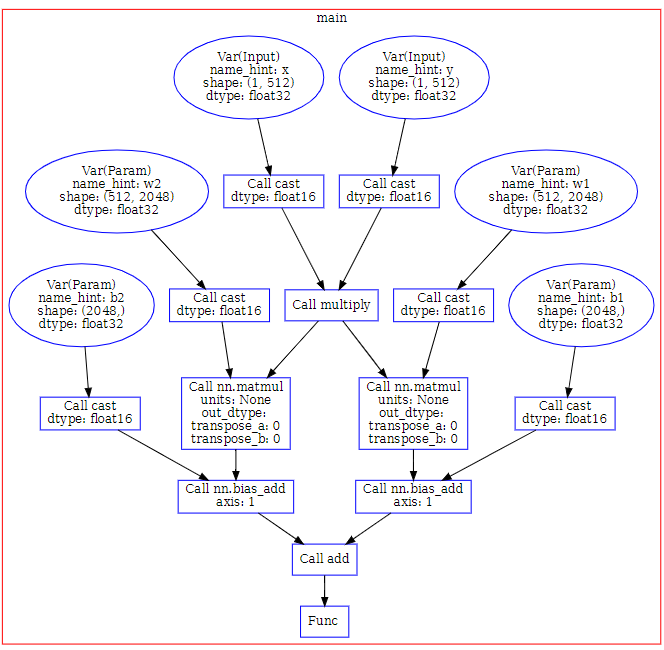

发现最近relay 的可视化已经在tvm主线上支持了,这里有一个简单的demo代码记录一下

需要安装 graphviz

import os

import numpy as np

from tvm import relay

from typing import (

Dict,

Union,

Tuple,

List,

)

import tvm

from tvm import relay

from tvm.contrib import relay_viz

from tvm.contrib.relay_viz.interface import (

VizEdge,

VizNode,

VizParser,

)

from tvm.contrib.relay_viz.terminal import (

TermGraph,

TermPlotter,

TermVizParser,

)

x = relay.var("x", shape=[1, 512])

y = relay.var("y", shape=[1, 512])

tmp = relay.multiply(x, y)

weight1 = relay.var("w1", shape=[512, 2048])

bias1 = relay.var("b1", shape=[2048])

m1 = relay.nn.matmul(tmp, weight1)

m1 = relay.nn.bias_add(m1, bias1)

weight2 = relay.var("w2", shape=[512, 2048])

bias2 = relay.var("b2", shape=[2048])

m2 = relay.nn.matmul(tmp, weight2)

m2 = relay.nn.bias_add(m2, bias2)

res = m1 + m2

w1 = tvm.nd.array(np.random.random([512, 2048]).astype(np.float32))

w2 = tvm.nd.array(np.random.random([512, 2048]).astype(np.float32))

b1 = tvm.nd.array(np.random.random([2048]).astype(np.float32))

b2 = tvm.nd.array(np.random.random([2048]).astype(np.float32))

params = {"w1":w1, "w2":w2, "b1":b1, "b2":b2}

func = relay.Function([x, y, weight1, weight2, bias1, bias2], res)

mod = tvm.IRModule.from_expr(func)

mod = relay.transform.ToMixedPrecision("float16")(mod)

graph_attr = {"color": "red"}

node_attr = {"color": "blue"}

edge_attr = {"color": "black"}

get_node_attr = {"color": "green"}

dot_plotter = relay_viz.DotPlotter(

graph_attr=graph_attr,

node_attr=node_attr,

edge_attr=edge_attr)

viz = relay_viz.RelayVisualizer(

mod,

relay_param=params,

plotter=dot_plotter,

parser=relay_viz.DotVizParser())

viz.render("eval")

可视化的图

tvm relay IR 可视化的更多相关文章

- TVM Pass IR如何使用

TVM Pass IR如何使用 随着Relay / tir中优化遍数的增加,执行并手动维护其依赖关系变得很棘手.引入了一个基础结构来管理优化过程,并应用于TVM堆栈中IR的不同层. Relay / t ...

- 桥接PyTorch和TVM

桥接PyTorch和TVM 人工智能最引人入胜的一些应用是自然语言处理.像BERT或GPT-2之类的模型及其变体,可以获住足够多的文本信息. 这些模型属于称为Transformers的神经网络类体系结 ...

- TVM图优化(以Op Fusion为例)

首先给出一个TVM 相关的介绍,这个是Tianqi Chen演讲在OSDI18上用的PPThttps://files.cnblogs.com/files/jourluohua/Tianqi-Chen- ...

- TVM代码生成codegen

TVM代码生成codegen 硬件后端提供程序(例如Intel,NVIDIA,ARM等),提供诸如cuBLAS或cuDNN之类的内核库以及许多常用的深度学习内核,或者提供框架例,如带有图形引擎的DNN ...

- TVM适配NN编译Compiler缺陷

TVM适配NN编译Compiler缺陷 内容纲要 前言 TVM针对VTA的编译流程 自定义VTA架构:TVM的缺陷与性能瓶颈 TVM缺陷与瓶颈 缺陷一:SRAM配置灵活性差 缺陷二:计算阵列配置僵硬 ...

- Relay外部库使用

Relay外部库使用 本文介绍如何将cuDNN或cuBLAS等外部库与Relay一起使用. Relay内部使用TVM生成目标特定的代码.例如,使用cuda后端,TVM为用户提供的网络中的所有层生成cu ...

- 如何使用TVM Pass红外线

如何使用TVM Pass红外线 随着Relay / tir中优化遍数的增加,执行并手动维护其依赖关系变得很棘手.引入了一个基础结构来管理优化过程,将其应用于TVM堆栈中IR的不同层. Relay / ...

- 向Relay添加算子

向Relay添加算子 为了在Relay IR中使用TVM算子,需要在Relay中注册算子,以确保将其集成到Relay的类型系统中. 注册算子需要三个步骤: 使用RELAY_REGISTER_OPC + ...

- 将代码生成器带入TVM

将代码生成器带入TVM 为了使数据科学家不必担心开发新模型时的性能,硬件后端提供程序(例如Intel,NVIDIA,ARM等)可以提供诸如cuBLAS或cuDNN之类的内核库以及许多常用的深度学习内核 ...

- TVM设计与构架构建

TVM设计与构架构建 本文档适用于希望了解TVM体系结构和/或在项目上进行积极开发的开发人员.该页面的组织如下: 实例编译流程Example Compilation Flow描述TVM把一个模型的高级 ...

随机推荐

- Flutter 下载篇 - 叁 | 网络库切换实践与思考

前言 本文是关于使用flutter_download_manager下载功能的实践和探索.我们将基于flutter_download_manager的功能扩展,改造成自己想要的样子.在阅读本文之前,建 ...

- Nginx主要功能

Nginx主要功能: 1.反向代理2.负载均衡3.HTTP服务器(包含动静分离)4.正向代理 一.反向代理 反向代理应该是 Nginx 做的最多的一件事了,什么是反向代理呢,以下是百度百科的说法:反向 ...

- w11修改ie保护模式方法

IE安全设置下有4个区域 对应的设置在不同的注册表中.[HKEY_CURRENT_USER\Software\Microsoft\Windows\CurrentVersion\Internet Set ...

- [灾备]独立磁盘阵列(RAID)技术

本文是对3个月前临时出差前往客户现场,安装交付我司大数据产品时使用的一项硬件级的灾备技术的简要复盘. 1 独立磁盘阵列--RAID:概述 1.1 定义 RAID := Redundant Arrays ...

- day29:计算机网络概念

目录 1.网络开发的两大架构 2.网络概念 3.OSI七层模型 4.ARP协议 5.TCP三次握手和四次挥手 1.网络开发的两大架构 1.没有网络的时候,文件是如何传输的? 早期没有网络 a.py - ...

- 帝国cms随机sql语句,mysql高效的随机查询

select * from AppleStorewhere rand()<0.015limit 100;

- Ubuntu18搭建vue3

第一步我们可以先更新源(我所有的步骤都在root账户下操作的) sudo apt-get update 然后安装node sudo apt-get install nodejs 安装成功后可以查看版本 ...

- 百度飞桨(PaddlePaddle)安装

注意:32位pip没有PaddlePaddle源 # 如果报下列错误,检查 Python 版本,不能过高也不要太低,并且不能是 32位的. ERROR: Could not find a versio ...

- Django笔记三十七之多数据库操作(补充版)

本文首发于公众号:Hunter后端 原文链接:Django笔记三十七之多数据库操作(补充版) 这一篇笔记介绍一下 Django 里使用多数据库操作. 在第二十二篇笔记中只介绍了多数据库的定义.同步命令 ...

- #AI 1分钟学会,利用AI制作思维导图 (NewBing&X-Mind )

思维导图是一种有效的思考和学习工具,它可以帮助你整理和呈现信息,激发你的创造力和记忆力.但是,传统的思维导图软件往往需要你花费大量的时间和精力来设计和绘制,而且难以修改和分享.有没有一种更简单和智能的 ...