spark(1.1) mllib 源代码分析

在spark mllib 1.1加入版本stat包,其中包括一些统计数据有关的功能。本文分析中卡方检验和实施的主要原则:

一个、根本

在stat包实现Pierxunka方检验,它包括以下类别

(1)适配度检验(Goodness of Fit test):验证一组观察值的次数分配是否异于理论上的分配。

(2)独立性检验(independence test) :验证从两个变量抽出的配对观察值组是否互相独立(比如:每次都从A国和B国各抽一个人,看他们的反应是否与国籍无关)

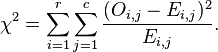

计算公式:

当中O表示观測值,E表示期望值

具体原理能够參考:http://zh.wikipedia.org/wiki/%E7%9A%AE%E7%88%BE%E6%A3%AE%E5%8D%A1%E6%96%B9%E6%AA%A2%E5%AE%9A

二、java api调用example

三、源代码分析

1、外部api

通过Statistics类提供了4个外部接口

// Goodness of Fit test

def chiSqTest(observed: Vector, expected: Vector): ChiSqTestResult = {

ChiSqTest.chiSquared(observed, expected)

}

//Goodness of Fit test

def chiSqTest(observed: Vector): ChiSqTestResult = ChiSqTest.chiSquared(observed) //independence test

def chiSqTest(observed: Matrix): ChiSqTestResult = ChiSqTest.chiSquaredMatrix(observed)

//independence test

def chiSqTest(data: RDD[LabeledPoint]): Array[ChiSqTestResult] = {

ChiSqTest.chiSquaredFeatures(data)

}

2、Goodness of Fit test实现

这个比較简单。关键是依据(observed-expected)2/expected计算卡方值

/*

* Pearon's goodness of fit test on the input observed and expected counts/relative frequencies.

* Uniform distribution is assumed when `expected` is not passed in.

*/

def chiSquared(observed: Vector,

expected: Vector = Vectors.dense(Array[Double]()),

methodName: String = PEARSON.name): ChiSqTestResult = { // Validate input arguments

val method = methodFromString(methodName)

if (expected.size != 0 && observed.size != expected.size) {

throw new IllegalArgumentException("observed and expected must be of the same size.")

}

val size = observed.size

if (size > 1000) {

logWarning("Chi-squared approximation may not be accurate due to low expected frequencies "

+ s" as a result of a large number of categories: $size.")

}

val obsArr = observed.toArray

// 假设expected值没有设置,默认取1.0 / size

val expArr = if (expected.size == 0) Array.tabulate(size)(_ => 1.0 / size) else expected.toArray / 假设expected、observed值都必需要大于1

if (!obsArr.forall(_ >= 0.0)) {

throw new IllegalArgumentException("Negative entries disallowed in the observed vector.")

}

if (expected.size != 0 && ! expArr.forall(_ >= 0.0)) {

throw new IllegalArgumentException("Negative entries disallowed in the expected vector.")

} // Determine the scaling factor for expected

val obsSum = obsArr.sum

val expSum = if (expected.size == 0.0) 1.0 else expArr.sum

val scale = if (math.abs(obsSum - expSum) < 1e-7) 1.0 else obsSum / expSum // compute chi-squared statistic

val statistic = obsArr.zip(expArr).foldLeft(0.0) { case (stat, (obs, exp)) =>

if (exp == 0.0) {

if (obs == 0.0) {

throw new IllegalArgumentException("Chi-squared statistic undefined for input vectors due"

+ " to 0.0 values in both observed and expected.")

} else {

return new ChiSqTestResult(0.0, size - 1, Double.PositiveInfinity, PEARSON.name,

NullHypothesis.goodnessOfFit.toString)

}

}

// 计算(observed-expected)2/expected

if (scale == 1.0) {

stat + method.chiSqFunc(obs, exp)

} else {

stat + method.chiSqFunc(obs, exp * scale)

}

}

val df = size - 1

val pValue = chiSquareComplemented(df, statistic)

new ChiSqTestResult(pValue, df, statistic, PEARSON.name, NullHypothesis.goodnessOfFit.toString)

}

3、independence test实现

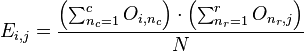

先通过以下的公式计算expected值,矩阵共同拥有 r 行 c 列

然后依据(observed-expected)2/expected计算卡方值

/*

* Pearon's independence test on the input contingency matrix.

* TODO: optimize for SparseMatrix when it becomes supported.

*/

def chiSquaredMatrix(counts: Matrix, methodName:String = PEARSON.name): ChiSqTestResult = {

val method = methodFromString(methodName)

val numRows = counts.numRows

val numCols = counts.numCols // get row and column sums

val colSums = new Array[Double](numCols)

val rowSums = new Array[Double](numRows)

val colMajorArr = counts.toArray

var i = 0

while (i < colMajorArr.size) {

val elem = colMajorArr(i)

if (elem < 0.0) {

throw new IllegalArgumentException("Contingency table cannot contain negative entries.")

}

colSums(i / numRows) += elem

rowSums(i % numRows) += elem

i += 1

}

val total = colSums.sum // second pass to collect statistic

var statistic = 0.0

var j = 0

while (j < colMajorArr.size) {

val col = j / numRows

val colSum = colSums(col)

if (colSum == 0.0) {

throw new IllegalArgumentException("Chi-squared statistic undefined for input matrix due to"

+ s"0 sum in column [$col].")

}

val row = j % numRows

val rowSum = rowSums(row)

if (rowSum == 0.0) {

throw new IllegalArgumentException("Chi-squared statistic undefined for input matrix due to"

+ s"0 sum in row [$row].")

}

val expected = colSum * rowSum / total

statistic += method.chiSqFunc(colMajorArr(j), expected)

j += 1

}

val df = (numCols - 1) * (numRows - 1)

val pValue = chiSquareComplemented(df, statistic)

new ChiSqTestResult(pValue, df, statistic, methodName, NullHypothesis.independence.toString)

}

版权声明:本文博客原创文章,博客,未经同意,不得转载。

spark(1.1) mllib 源代码分析的更多相关文章

- Spark机器学习之MLlib整理分析

友情提示: 本文档根据林大贵的<Python+Spark 2.0 + Hadoop机器学习与大数据实战>整理得到,代码均为书中提供的源码(python 2.X版本). 本文的可以利用pan ...

- Spark里边:Worker源代码分析和架构

首先由Spark图表理解Worker于Spark中的作用和地位: watermark/2/text/aHR0cDovL2Jsb2cuY3Nkbi5uZXQvYW56aHNvZnQ=/font/5a6L ...

- Spark SQL 源代码分析系列

从决定写Spark SQL文章的源代码分析,到现在一个月的时间,一个又一个几乎相同的结束很快,在这里也做了一个综合指数,方便阅读,下面是读取顺序 :) 第一章 Spark SQL源代码分析之核心流程 ...

- Spark MLlib之线性回归源代码分析

1.理论基础 线性回归(Linear Regression)问题属于监督学习(Supervised Learning)范畴,又称分类(Classification)或归纳学习(Inductive Le ...

- Spark MLlib LDA 基于GraphX实现原理及源代码分析

LDA背景 LDA(隐含狄利克雷分布)是一个主题聚类模型,是当前主题聚类领域最火.最有力的模型之中的一个,它能通过多轮迭代把特征向量集合按主题分类.眼下,广泛运用在文本主题聚类中. LDA的开源实现有 ...

- Spark SQL 源代码分析之 In-Memory Columnar Storage 之 in-memory query

/** Spark SQL源代码分析系列文章*/ 前面讲到了Spark SQL In-Memory Columnar Storage的存储结构是基于列存储的. 那么基于以上存储结构,我们查询cache ...

- Spark SQL Catalyst源代码分析之TreeNode Library

/** Spark SQL源代码分析系列文章*/ 前几篇文章介绍了Spark SQL的Catalyst的核心执行流程.SqlParser,和Analyzer,本来打算直接写Optimizer的,可是发 ...

- Spark SQL Catalyst源代码分析Optimizer

/** Spark SQL源代码分析系列*/ 前几篇文章介绍了Spark SQL的Catalyst的核心运行流程.SqlParser,和Analyzer 以及核心类库TreeNode,本文将具体解说S ...

- Spark SQL源代码分析之核心流程

/** Spark SQL源代码分析系列文章*/ 自从去年Spark Submit 2013 Michael Armbrust分享了他的Catalyst,到至今1年多了,Spark SQL的贡献者从几 ...

随机推荐

- 菜鸟版JAVA设计模式-从抽象与实现说桥接模式

桥接模式,初学的时候事实上非常不理解为什么要把这个模式命名为桥接模式,脑海里突然联想到.事实上我学习是一件比較痛苦的事情,由于我必需要知道来龙去脉才干学的进去,所以,非常快我就对这个命名产生了兴趣,桥 ...

- 使用Jfree实现吧条形图,java代码

使用Jfree实现吧条形图,java代码.它可能在生产的报告被常用,之后,主动生成自己的代码,可以随意查看.自由地配置图表的各种性质,为了达到他们的要求和目标 package test1; impor ...

- 微软研究院的分布式云计算框架orleans

orleans Orleans 客户端请求的消息流转以及消息在Silo中再路由机制 Witte 2015-04-29 21:58 阅读:196 评论:0 一种基于Orleans的分布式Id ...

- akka.net与微软分布式框架Orleans

微软分布式框架Orleans开源了 开源地址: https://github.com/dotnet/orleans 昨天编译了一下,这个最新的Orleans安装程序(用github源码编译的) 下载地 ...

- Source insight 3572安装和版本号An invalid source insight serial number was detected解

Source insight最新版本3572 下载链接:http://www.sourceinsight.com/down35.html, http://www.sourceinsight.com ...

- POJ 3691 DNA repair 基于AC自己主动机DP

dp[i][j] 它表示的长度 i 下游前缀 j 更改节点的最小数量. 很清楚dp[0][0] = 0; dp[ i ][ j ] = min(dp[ i ][ j ],dp[i-1][k] + (j ...

- 完美世界3D格斗手游[格斗宝贝]今日公測

狗刨学习网报道 / 经过近两年井喷式的发展,国内手游市场洗牌的信号愈加强烈.用户体验的提升.以及对产品核心品质的要求.促进了手游的精品化.而白热化的市场竞争,也催生了各大厂商在细分市场的抢滩.当中.更 ...

- java IdentityHashMap 与HashMap

这两个map的主要区别在于,比较key值什么时候: IdentityHashMap我觉得当k1 == k2 时刻key值一样的 HaspMap觉得k1 == null ? k2 == null:k1. ...

- NBA球员 ESPN前20排名:詹姆斯再居榜首

2014年 ESPN球员实力最后排名 没想到 保罗-乔治没有上榜.之前预測的火箭两大明星排名落后了,杜兰特排到第8有点出乎意料. 戴维斯升得那么快有点出乎意料,一个球队拥有两位排前十位的球队:骑士,快 ...

- 分布式数据库中间件–(2) Cobar与client握手身份验证

Cobar启动完毕,监听特定端口.整个认证的流程图: NIOAcceptor类继承自Thread类,该类的对象会以线程的方式执行,进行连接的监听. NIOAcceptor启动的初始化步骤例如以下: 1 ...