hadoop分片分析

上一篇分析了split的生成,现在接着来说具体的split具体内容及其相关的文件和类。以FileSplit(mapred包下org/apache/hadoop/mapreduce/lib/input/FileSplit.java)为例,它继承了InputSplit接口,包括以下属性:

public class FileSplit extends InputSplit implements Writable {

private Path file; //分片对应的文件路径

private long start; //分片在文件中的偏移量

private long length; //分片长度

private String[] hosts; //所在主机列表

其中路径信息file标示了split对应的文件,其格式是这样的:hdfs://localhost:9000/home/hadoop/input/text1.txt。这个可以在debug的时候看的很清楚。另外就是hosts数组,标示了split对应的block所在的主机列表。当然有这么一种情况:就是split可能跨多个block,这时hosts表示的是哪个block所在的主机列表呢?这个问题等以后看到这部分源码的时候再说吧。

JobClient端的submitJobInternal()方法在计划和划分split的同时,生成了两个文件:job.split和job.splitmetainfo,将其放在HDFS的${mapreduce.jobtracker.staging.root.dir}/${user}/.staging/${JobId}目录下。他们的作用分别为:

job.split:表示原始分片信息,Map task初始化时使用,用以获取要处理的数据。

job.splitmetainfo:表示分片元信息, JobTracker用来构造locality的task。

下面着重解析下这两个文件:

job.split文件:

SPL :job.split文件头

version:版本信息,为1,int类型

类名信息:

类名长度:int类型,表示其后的类名由多少个字符组成(47)

类名:org.apache.hadoop.mapreduce.lib.input.FileSplit(共47个字符)

对象信息:

长度:int类型,表示其后的文件名信息由多少字符组成(49)

文件名:hdfs://localhost:9000/home/hadoop/input/text1.txt(共49个字符)

start:Long类型,表示该split的偏移量,

length:Long类型,表示分片长度

然后就是类名信息和对象信息作为一个条目,如此一直重复下去。要注意一点:图中的的边界并不一定是对齐的。

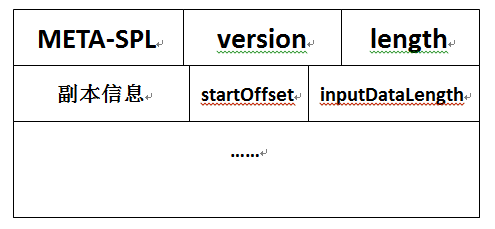

Job.splitmetainfo文件:

META-SPL :Job.splitmetainfo文件头

version:版本信息,为1,int类型

length:split的数目,int类型

副本信息:

副本个数:int类型

主机信息:int(表示主机名的长度),byte[](用来存储主机名) (如:8:gouyk-pc)

…… (以上边的形式重复写,因为会有多个split)

startOffset:split在job.split中的偏移量,Long

inputDataLength:分片长度, Long

然后就是副本信息和startOffset、inputDataLength作为一个条目,如此一直重复下去。同样,图中的的边界并不一定是对齐的。

下面说说关于读写split的基础类:SplitMetaInfo、TaskSplitMetaInfo和TaskSplitIndex,它们都封装在JobSplit类中。

SplitMetaInfo类代表了split的元数据信息,在生成job.split文件时被构造出来。主要属性如下:

public static class SplitMetaInfo implements Writable {

private long startOffset; //该split元信息在job.split文件中的偏移量

private long inputDataLength; //该split的数据长度

private String[] locations; //该split对应的host列表

TaskSplitMetaInfo类代表了Map Task要处理的split的元信息,在JobTracker端初始化Job时读取job.splitmetainfo文件后被构造出来。并将其存入到Map Task(TaskInProgress)中。在TaskTracker端,Map Task根据TaskSplitMetaInfo从job.split文件中读取split信息。主要属性如下:

public static class TaskSplitMetaInfo {

private TaskSplitIndex splitIndex; //split元信息在job.split文件中的索引

private long inputDataLength; //split的数据长度

private String[] locations; //split对应的host列表

TaskSplitIndex用于指定split在job.split中的位置。主要属性如下:

public static class TaskSplitIndex {

private String splitLocation; //job.split文件所在的位置

private long startOffset; //split在job.split文件中的索引

本文基于hadoop1.2.1

如有错误,还请指正

参考文章:《Hadoop技术内幕 深入理解MapReduce架构设计与实现原理》 董西成

http://blog.sina.com.cn/s/blog_9d31d3870101dtx8.html

转载请注明出处:http://www.cnblogs.com/gwgyk/p/4123414.html

hadoop分片分析的更多相关文章

- Hadoop源代码分析

http://wenku.baidu.com/link?url=R-QoZXhc918qoO0BX6eXI9_uPU75whF62vFFUBIR-7c5XAYUVxDRX5Rs6QZR9hrBnUdM ...

- Hadoop日志分析系统启动脚本

Hadoop日志分析系统启动脚本 #!/bin/bash #Flume日志数据的根文件夹 root_path=/flume #Mapreduce处理后的数据文件夹 process_path=/proc ...

- Hadoop源代码分析(完整版)

Hadoop源代码分析(一) 关键字: 分布式云计算 Google的核心竞争技术是它的计算平台.Google的大牛们用了下面5篇文章,介绍了它们的计算设施. GoogleCluster:http:// ...

- 使用hadoop mapreduce分析mongodb数据

使用hadoop mapreduce分析mongodb数据 (现在很多互联网爬虫将数据存入mongdb中,所以研究了一下,写此文档) 版权声明:本文为yunshuxueyuan原创文章.如需转载请标明 ...

- hadoop 分片与分块,map task和reduce task的理解

分块:Block HDFS存储系统中,引入了文件系统的分块概念(block),块是存储的最小单位,HDFS定义其大小为64MB.与单磁盘文件系统相似,存储在 HDFS上的文件均存储为多个块,不同的是, ...

- hadoop 日志分析

1:在每一个tomcat服务器上,生成的日志目录中,在java中用定时器每天将当天的日志上传到hadoop中 (技术要点:quatz+hadoop-client)具体的目录动态的采用时间品名 2:ha ...

- Hadoop源代码分析【IO专题】

由于Hadoop的MapReduce和HDFS都有通信的需求,需要对通信的对象进行序列化.Hadoop并没有采用Java的序列化(因为Java序列化比较复杂,且不能深度控制),而是引入了它自己的系统. ...

- Hadoop学习之Hadoop案例分析

一.日志数据分析1.背景1.1 ***论坛日志,数据分为两部分组成,原来是一个大文件,是56GB:以后每天生成一个文件,大约是150-200MB之间: 每行记录有5部分组成:1.访问ip:2.访问时间 ...

- hadoop日志分析

一.项目要求 本文讨论的日志处理方法中的日志,仅指Web日志.事实上并没有精确的定义,可能包含但不限于各种前端Webserver--apache.lighttpd.nginx.tomcat等产生的用户 ...

随机推荐

- redis3.0.6安装(linux和windows)

官网上描述安装方法如下:$ wget http://download.redis.io/releases/redis-3.0.6.tar.gz$ tar xzf redis-3.0.6.tar.gz$ ...

- 7.dotnet core 如何发邮件

需要用到的Nuget包 "MailKit": "1.8.1", 方法 /// <summary> /// 发送邮件(支持Html发送,支持添加一个附 ...

- HttpClient 4.5.x 工具类设计与实现

最近,业务需要在java服务端发起http请求,需要实现"GET","POST","PUT"等基本方法.于是想以 "HttpCli ...

- road习题(一)

答案:[D] 答案:[C] 分析需要靠人 答案:[B] 答案:[B] c语言本身支持自定义函数 答案:[B] Virtual User Generator:是一个脚本开发组件 说白了就是虚拟机用户发生 ...

- 如何实现修改FileUpload样式

这里先隐藏FileUpload 然后用一个input button和一个text来模拟FileUpload 具体代码为 <asp:FileUpload ID="FileUpload1& ...

- mysql存储过程语法及实例

存储过程如同一门程序设计语言,同样包含了数据类型.流程控制.输入和输出和它自己的函数库. --------------------基本语法-------------------- 一.创建存储过程cr ...

- weex 小结 --官方扩展组件

<wxc-tabbar> 页面底部的 tab 标签,通过点击在不同页面之间切换 属性: selected-index {number}:设置默认选中的 tab 索引,默认值为 0(第一个 ...

- Oracle Minus关键字

Oracle Minus关键字 SQL中的MINUS关键字 SQL中有一个MINUS关键字,它运用在两个SQL语句上,它先找出第一条SQL语句所产生的结果,然后看这些结果有没有在第二个SQL语句的结果 ...

- 规则“Windows Server 2003 FILESTREAM 修补程序检查” 失败。

近期在客户环境搭建SQL故障转移群集,操作系统为SQL Server 2012R2,数据库版本为SQL Server2008 R2,在安装过程中遇到问题:没有安装Windows Server 2003 ...

- openssl 非对称加密 RSA 加密解密以及签名验证签名

1. 简介 openssl rsa.h 提供了密码学中公钥加密体系的一些接口, 本文主要讨论利用rsa.h接口开发以下功能 公钥私钥的生成 公钥加密,私钥解密 私钥加密,公钥解密 签名:私钥签名 验 ...