Fast R-CNN(理解)

0 - 背景

经典的R-CNN存在以下几个问题:

- 训练分多步骤(先在分类数据集上预训练,再进行fine-tune训练,然后再针对每个类别都训练一个线性SVM分类器,最后再用regressors对bounding box进行回归,并且bounding box还需要通过selective search生成)

- 时间和空间开销大(在训练SVM和回归的时候需要用网络训练的特征作为输入,特征保存在磁盘上再读入的时间开销较大)

- 测试比较慢(每张图片的每个region proposal都要做卷积,重复操作太多)

在Fast RCNN之前提出过SPPnet来解决R-CNN中重复卷积问题,但SPPnet仍然存在与R-CNN类似的缺陷:

- 训练分多步骤(需要SVM分类器,额外的regressors)

- 空间开销大

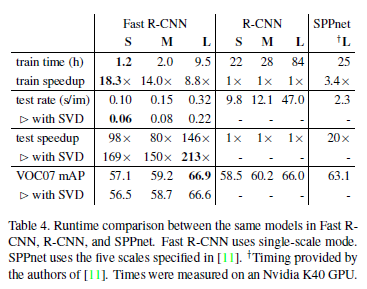

因此,该文提出的Fast RCNN便是解决上述不足,在保证效果的同时提高效率。基于VGG16的Fast RCNN模型在训练速度上比R-CNN快大约9倍,比SPPnet快大约3倍;测试速度比R-CNN快大约213倍,比SPPnet快大约10倍,在VOC2012数据集上的mAP大约为66%。

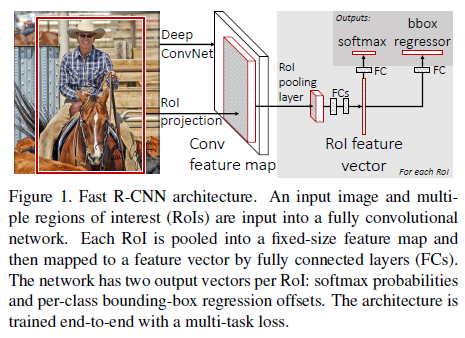

1 - 整体思路

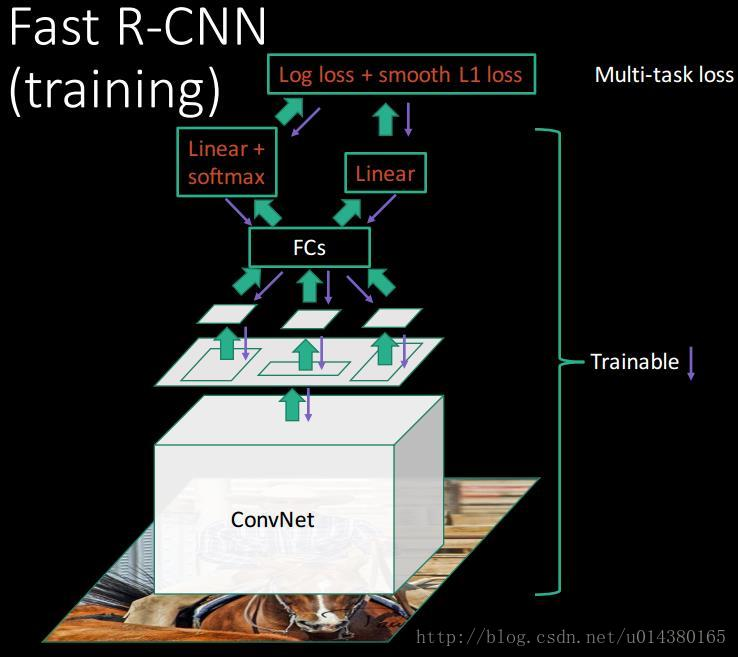

1.1 - 训练

- 输入是$224 \times 224$的固定大小图片

- 经过5个卷积层+2个降采样层(分别跟在第一和第二个卷积层后面)

- 进入ROIPooling层(其输入是conv5层的输出和region proposal,region proposal个数大约为2000个)

- 再经过两个output都为4096维的全连接层

- 分别经过output各为21和84维的全连接层(并列的,前者是分类输出,后者是回归输出)

- 最后接上两个损失层(分类是softmax,回归是smoothL1)

fast R-CNN模型的流程图如下:

1.1.1 - ROIPooling

由于region proposal的尺度各不相同,而期望提取出来的特征向量维度相同,因此需要某种特殊的技术来做保证。ROIPooling的提出便是为了解决这一问题的。其思路如下:

- 将region proposal划分为$H \times W$大小的网格

- 对每一个网格做MaxPooling(即每一个网格对应一个输出值)

- 将所有输出值组合起来便形成固定大小为$H \times W$的feature map

1.1.2 - 训练样本

训练过程中每个mini-batch包含2张图像和128个region proposal(即ROI,64个ROI/张),其中大约25%的ROI和ground truth的IOU值大于0.5(即正样本),且只通过随机水平翻转进行数据增强。

1.1.3 - 损失函数

多损失融合(分类损失和回归损失融合),分类采用log loss(即对真实分类的概率取负log,分类输出K+1维),回归的loss和R-CNN基本一样。

总的损失函数如下:

$$L(p,u,t^u,v)=L_{cls}(p,u)+\lambda [u\geqslant 1]L_{loc}(t^u,v)$$

分类损失函数如下:

$$L_{cls}(p,u)=-log\ p_u$$

回归损失函数如下:

$$L_{loc}(t^u,v)=\sum_{i\epsilon \{x,y,w,h\}}smooth_{L_1}(t_i^u-v_i)$$

其中有:

$$smooth_{L_1}(x)=\left\{\begin{matrix}0.5x^2\ \ \ \ \ \ if\ |x|< 1\\|x|-0.5\ \ otherwise\end{matrix}\right.$$

1.1.4 - 改进全连接层

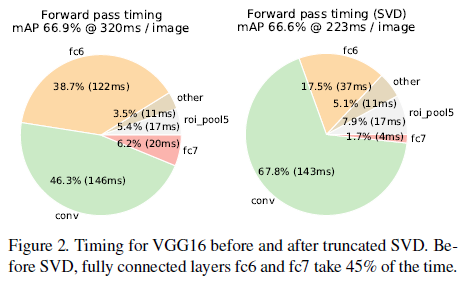

由于卷积层计算针对的是一整张图片,而全连接层需要对每一个region proposal都作用一次,所以全连接层的计算占网络计算的将近一半(如下图)。作者采用SVD来简化全连接层计算。

1.1.5 - 训练整体架构总结

图片引用自博客。

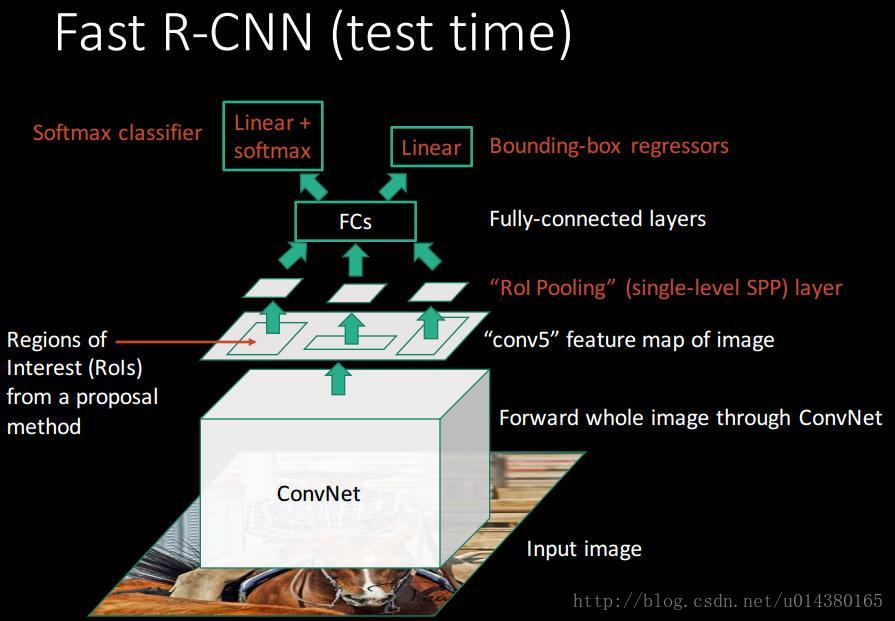

1.2 - 测试

1.2.1 - 测试整体架构总结

图片引用自博客。

2 - 思考

2.1 - 改进

- 卷积不再是重复对每一个region proposal,而是对于整张图像先提取了泛化特征,这样子减少了大量的计算量(注意到,R-CNN中对于每一个region proposal做卷积会有很多重复计算)

- ROIPooling的提出,巧妙的解决了尺度放缩的问题

- 将regressor放进网络一起训练,同时用softmax代替SVM分类器,更加简单高效

2.2 - 不足

region proposal的提取仍然采用selective search,整个检测流程时间大多消耗在这上面(生成region proposal大约2~3s,而特征提取+分类只需要0.32s),之后的Faster RCNN的改进之一便是此点。

3 - 结果

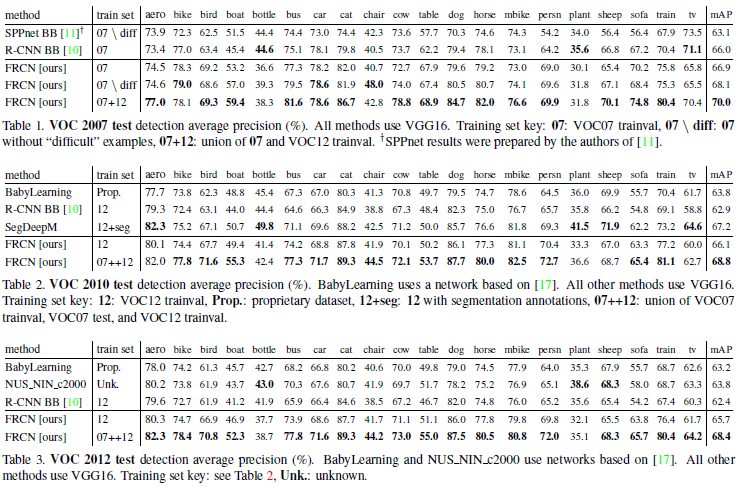

3.1 - mAP

FRCN相比其他算法表现更好,且注意到,VOC12由于数据集更大而使得模型效果提高很多。(这一角度也说明了数据对于当前深度学习的重要性不容忽视!)

3.2 - 速度

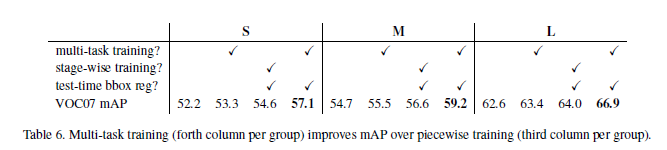

3.3 - 多任务训练(multi-task)

由于本文提出的模型是基于R-CNN通过multi-task训练方式进行改进的,因此要说明multi-task的有效性。一共分为S/M/L三组,每组对应四列,分别为:

- 仅采用分类训练,测试也没有回归

- 采用论文中的分类+回归训练,测试没有回归

- 采用分段训练,测试没有回归

- 采用论文中的分类+回归训练,测试有回归

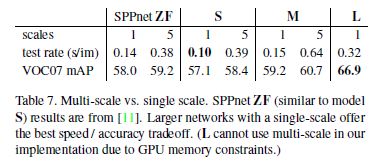

3.4 - 单尺度vs多尺度

多尺度表示输入图像采用多种尺度输入,在测试的时候发现多尺度虽然能在mAP上得到些许提升但也增加了时间开销(作者给出原因:深度卷积网络可以学习尺度不变性)。

4 - 参考资料

https://blog.csdn.net/u014380165/article/details/72851319

https://www.cnblogs.com/CZiFan/p/9901729.html

https://www.cnblogs.com/CZiFan/p/9901000.html

Fast R-CNN(理解)的更多相关文章

- F1 P R的理解

F1 P R的理解 precision:查准率 recall:查全率,召回率 查准率,基于预测的结果,预测为正的样本中 由多少真正的正样本.即,真正为正的越多越好. 查全率,针对原来的正样本,有多少正 ...

- CNN理解与实现

CNN理解与实现 组成部分 Convolution Layer Pool Layer: Max-pooling layer Average-pooling layer Full Connected(F ...

- Fast R-CNN论文理解

论文地址:https://arxiv.org/pdf/1504.08083.pdf 翻译请移步:https://blog.csdn.net/ghw15221836342/article/details ...

- 卷积神经网络CNN理解

自今年七月份以来,一直在实验室负责卷积神经网络(Convolutional Neural Network,CNN),期间配置和使用过theano和cuda-convnet.cuda-convnet2. ...

- R树--理解平面思维

R树数据结构 备注:参考wiki的内容. 简介 Guttman, A.; “R-trees: a dynamic index structure for spatial searching,” ACM ...

- Python '\r', '\n', '\r\n' 的彻底理解

回车和换行的历史: 机械打字机有回车和换行两个键作用分别是: 换行就是把滚筒卷一格,不改变水平位置. (即移到下一行,但不是行首,而是和上一行水平位置一样) 回车就是把水平位置复位,不卷动滚筒. ...

- RCNN--对象检测的又一伟大跨越 2(包括SPPnet、Fast RCNN)(持续更新)

继续上次的学习笔记,在RCNN之后是Fast RCNN,但是在Fast RCNN之前,我们先来看一个叫做SPP-net的网络架构. 一,SPP(空间金字塔池化,Spatial Pyramid Pool ...

- 基于pytorch的CNN、LSTM神经网络模型调参小结

(Demo) 这是最近两个月来的一个小总结,实现的demo已经上传github,里面包含了CNN.LSTM.BiLSTM.GRU以及CNN与LSTM.BiLSTM的结合还有多层多通道CNN.LSTM. ...

- 对RESTful Web API的理解与设计思路

距离上一篇关于Web API的文章(如何实现RESTful Web API的身份验证)有好些时间了,在那篇文章中提到的方法是非常简单而有效的,我在实际的项目中就这么用了,代码经过一段时间的磨合,已经很 ...

随机推荐

- 文本分类实战(四)—— Bi-LSTM模型

1 大纲概述 文本分类这个系列将会有十篇左右,包括基于word2vec预训练的文本分类,与及基于最新的预训练模型(ELMo,BERT等)的文本分类.总共有以下系列: word2vec预训练词向量 te ...

- python 中内存释放与函数传递numpy数组问题

numpy.array 作为参数传入函数中时,是作为引用进去的,函数内部对这个数组的修改会直接修改原始数据.在函数中需要暂时修改数据,不对原始数据造成影响的话,需要用 np.copy() 先拷贝一份, ...

- 分布式 cephfs

参考链接: http://docs.ceph.com/docs/mimic/cephfs/

- 纯代码系列:Python实现验证码图片(PIL库经典用法用法,爬虫12306思路)

现在的网页中,为了防止机器人提交表单,图片验证码是很常见的应对手段之一.这里就不详细介绍了,相信大家都遇到过. 现在就给出用Python的PIL库实现验证码图片的代码.代码中有详细注释. #!/usr ...

- Codeforces Round #551 (Div. 2) EF Solution

E. Serval and Snake 对于一个矩形,如果蛇的一条边与它相交,就意味着这条蛇从矩形内穿到矩形外,或者从矩形外穿到矩形内.所以如果某个矩形的答案为偶数,意味着蛇的头尾在矩形的同一侧(内或 ...

- SpringBoot整合RabbitMQ-消息可靠性投递

本系列是学习SpringBoot整合RabbitMQ的练手,包含服务安装,RabbitMQ整合SpringBoot2.x,消息可靠性投递实现等三篇博客. 学习路径:https://www.imooc. ...

- Equinox OSGi应用嵌入Jersey框架搭建REST服务

原文地址:https://www.cnblogs.com/kira2will/p/5040264.html 一.环境 eclipse版本:eclipse-luna 4.4 jre版本:1.8 二.Eq ...

- MariaDB第三章:数据库设计与备份--小白博客

数据库设计 1.第一范式(确保每列保持原子性) 第一范式是最基本的范式.如果数据库表中的所有字段值都是不可分解的原子值,就说明该数据库表满足了第一范式. 2.第二范式(确保表中的每列都和主键相关) 第 ...

- 使用Github生成燃尽图

经过一晚上折腾,终于算是把linux上成功生成了我们团队项目的燃尽图,效果还是不错,在过程中又发现了另一种生成燃尽图的方式,也是基于一个开源项目. 1.准备: 首先你的项目一定要有milestone. ...

- Cards and Joy CodeForces - 999F (贪心+set)

There are nn players sitting at the card table. Each player has a favorite number. The favorite numb ...