JDBC批量Insert深度优化(有事务)

CREATE TABLE tuser ( id bigint(20) NOT NULL AUTO_INCREMENT, name varchar(12) DEFAULT NULL, remark varchar(24) DEFAULT NULL, createtime datetime DEFAULT NULL, updatetime datetime DEFAULT NULL, PRIMARY KEY (id) ) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8;

import java.io.IOException;

import java.sql.*;

/**

* JDBC批量Insert优化(下)

*

* @author leizhimin 2009-7-29 10:03:10

*/

public class TestBatch {

public static DbConnectionBroker myBroker = null;

static {

try {

myBroker = new DbConnectionBroker("com.mysql.jdbc.Driver",

"jdbc:mysql://192.168.104.163:3306/testdb",

"vcom", "vcom", 2, 4,

"c:\\testdb.log", 0.01);

} catch (IOException e) {

e.printStackTrace();

}

}

/**

* 初始化测试环境

*

* @throws SQLException 异常时抛出

*/

public static void init() throws SQLException {

Connection conn = myBroker.getConnection();

conn.setAutoCommit(false);

Statement stmt = conn.createStatement();

stmt.addBatch("DROP TABLE IF EXISTS tuser");

stmt.addBatch("CREATE TABLE tuser (\n" +

" id bigint(20) NOT NULL AUTO_INCREMENT,\n" +

" name varchar(12) DEFAULT NULL,\n" +

" remark varchar(24) DEFAULT NULL,\n" +

" createtime datetime DEFAULT NULL,\n" +

" updatetime datetime DEFAULT NULL,\n" +

" PRIMARY KEY (id)\n" +

") ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8");

stmt.executeBatch();

conn.commit();

myBroker.freeConnection(conn);

}

/**

* 100000条静态SQL插入

*

* @throws Exception 异常时抛出

*/

public static void testInsert() throws Exception {

init(); //初始化环境

Long start = System.currentTimeMillis();

for (int i = 0; i < 100000; i++) {

String sql = "\n" +

"insert into testdb.tuser \n" +

"\t(name, \n" +

"\tremark, \n" +

"\tcreatetime, \n" +

"\tupdatetime\n" +

"\t)\n" +

"\tvalues\n" +

"\t('" + RandomToolkit.generateString(12) + "', \n" +

"\t'" + RandomToolkit.generateString(24) + "', \n" +

"\tnow(), \n" +

"\tnow()\n" +

")";

Connection conn = myBroker.getConnection();

conn.setAutoCommit(false);

Statement stmt = conn.createStatement();

stmt.execute(sql);

conn.commit();

myBroker.freeConnection(conn);

}

Long end = System.currentTimeMillis();

System.out.println("单条执行100000条Insert操作,共耗时:" + (end - start) / 1000f + "秒!");

}

/**

* 批处理执行静态SQL测试

*

* @param m 批次

* @param n 每批数量

* @throws Exception 异常时抛出

*/

public static void testInsertBatch(int m, int n) throws Exception {

init(); //初始化环境

Long start = System.currentTimeMillis();

for (int i = 0; i < m; i++) {

//从池中获取连接

Connection conn = myBroker.getConnection();

conn.setAutoCommit(false);

Statement stmt = conn.createStatement();

for (int k = 0; k < n; k++) {

String sql = "\n" +

"insert into testdb.tuser \n" +

"\t(name, \n" +

"\tremark, \n" +

"\tcreatetime, \n" +

"\tupdatetime\n" +

"\t)\n" +

"\tvalues\n" +

"\t('" + RandomToolkit.generateString(12) + "', \n" +

"\t'" + RandomToolkit.generateString(24) + "', \n" +

"\tnow(), \n" +

"\tnow()\n" +

")";

//加入批处理

stmt.addBatch(sql);

}

stmt.executeBatch(); //执行批处理

conn.commit();

// stmt.clearBatch(); //清理批处理

stmt.close();

myBroker.freeConnection(conn); //连接归池

}

Long end = System.currentTimeMillis();

System.out.println("批量执行" + m + "*" + n + "=" + m * n + "条Insert操作,共耗时:" + (end - start) / 1000f + "秒!");

}

/**

* 100000条预定义SQL插入

*

* @throws Exception 异常时抛出

*/

public static void testInsert2() throws Exception { //单条执行100000条Insert操作,共耗时:40.422秒!

init(); //初始化环境

Long start = System.currentTimeMillis();

String sql = "" +

"insert into testdb.tuser\n" +

" (name, remark, createtime, updatetime)\n" +

"values\n" +

" (?, ?, ?, ?)";

for (int i = 0; i < 100000; i++) {

Connection conn = myBroker.getConnection();

conn.setAutoCommit(false);

PreparedStatement pstmt = conn.prepareStatement(sql);

pstmt.setString(1, RandomToolkit.generateString(12));

pstmt.setString(2, RandomToolkit.generateString(24));

pstmt.setDate(3, new Date(System.currentTimeMillis()));

pstmt.setDate(4, new Date(System.currentTimeMillis()));

pstmt.executeUpdate();

conn.commit();

pstmt.close();

myBroker.freeConnection(conn);

}

Long end = System.currentTimeMillis();

System.out.println("单条执行100000条Insert操作,共耗时:" + (end - start) / 1000f + "秒!");

}

/**

* 批处理执行预处理SQL测试

*

* @param m 批次

* @param n 每批数量

* @throws Exception 异常时抛出

*/

public static void testInsertBatch2(int m, int n) throws Exception {

init(); //初始化环境

Long start = System.currentTimeMillis();

String sql = "" +

"insert into testdb.tuser\n" +

" (name, remark, createtime, updatetime)\n" +

"values\n" +

" (?, ?, ?, ?)";

for (int i = 0; i < m; i++) {

//从池中获取连接

Connection conn = myBroker.getConnection();

conn.setAutoCommit(false);

PreparedStatement pstmt = conn.prepareStatement(sql);

for (int k = 0; k < n; k++) {

pstmt.setString(1, RandomToolkit.generateString(12));

pstmt.setString(2, RandomToolkit.generateString(24));

pstmt.setDate(3, new Date(System.currentTimeMillis()));

pstmt.setDate(4, new Date(System.currentTimeMillis()));

//加入批处理

pstmt.addBatch();

}

pstmt.executeBatch(); //执行批处理

conn.commit();

// pstmt.clearBatch(); //清理批处理

pstmt.close();

myBroker.freeConnection(conn); //连接归池

}

Long end = System.currentTimeMillis();

System.out.println("批量执行" + m + "*" + n + "=" + m * n + "条Insert操作,共耗时:" + (end - start) / 1000f + "秒!");

}

public static void main(String[] args) throws Exception {

init();

Long start = System.currentTimeMillis();

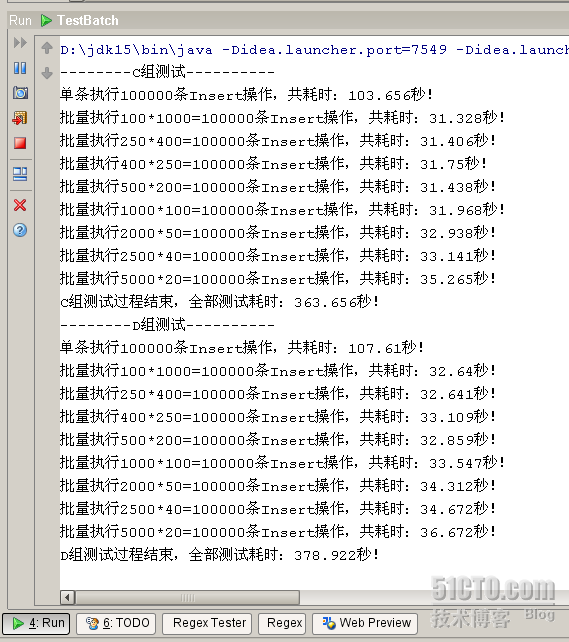

System.out.println("--------C组测试----------");

testInsert();

testInsertBatch(100, 1000);

testInsertBatch(250, 400);

testInsertBatch(400, 250);

testInsertBatch(500, 200);

testInsertBatch(1000, 100);

testInsertBatch(2000, 50);

testInsertBatch(2500, 40);

testInsertBatch(5000, 20);

Long end1 = System.currentTimeMillis();

System.out.println("C组测试过程结束,全部测试耗时:" + (end1 - start) / 1000f + "秒!");

System.out.println("--------D组测试----------");

testInsert2();

testInsertBatch2(100, 1000);

testInsertBatch2(250, 400);

testInsertBatch2(400, 250);

testInsertBatch2(500, 200);

testInsertBatch2(1000, 100);

testInsertBatch2(2000, 50);

testInsertBatch2(2500, 40);

testInsertBatch2(5000, 20);

Long end2 = System.currentTimeMillis();

System.out.println("D组测试过程结束,全部测试耗时:" + (end2 - end1) / 1000f + "秒!");

}

}

JDBC批量Insert深度优化(有事务)的更多相关文章

- JDBC批量插入数据优化,使用addBatch和executeBatch

JDBC批量插入数据优化,使用addBatch和executeBatch SQL的批量插入的问题,如果来个for循环,执行上万次,肯定会很慢,那么,如何去优化呢? 解决方案:用 preparedSta ...

- JDBC批量插入优化addbatch

// 获取要设置的Arp基准的List后,插入Arp基准表中 public boolean insertArpStandardList(List<ArpTable> list) { Con ...

- Mybatis与JDBC批量插入MySQL数据库性能测试及解决方案

转自http://www.cnblogs.com/fnz0/p/5713102.html 不知道自己什么时候才有这种钻研精神- -. 1 背景 系统中需要批量生成单据数据到数据库表,所以采用 ...

- JDBC批量执行executeBatch

JDBC事务 在数据库中,所谓事务是指一组逻辑操作单元,使数据从一种状态变换到另一种状态.为确保数据库中数据的一致性,数据的操纵应当是离散的成组的逻辑单元:当它全部完成时,数据的一致性可以保持,而当这 ...

- Spring源码深度解析之事务

Spring源码深度解析之事务 目录 一.JDBC方式下的事务使用示例 (1)创建数据表结构 (2)创建对应数据表的PO (3)创建表和实体之间的映射 (4)创建数据操作接口 (5)创建数据操作接口实 ...

- JDBC、JTA、Spring的事务管理

Java事务的类型有三种:JDBC事务.JTA(Java Transaction API)事务.容器事务. 事务就是对一系列的数据库操作(比如插入多条数据)进行统一的提交或回滚操作,如果插入成功,那么 ...

- java批量insert入mysql数据库

mysql 批量insert语句为 insert into Table_(col1,col2...) values(val11,val12...),(val11,val12...),...; java ...

- OracleHelper(对增删改查分页查询操作进行了面向对象的封装,对批量增删改操作的事务封装)

公司的一个新项目使用ASP.NET MVC开发,经理让我写个OracleHelper,我从网上找了一个比较全的OracleHelper类,缺点是查询的时候返回DataSet,数据增删改要写很多代码(当 ...

- MySQL内核深度优化

版权声明:本文由简怀兵原创文章,转载请注明出处: 文章原文链接:https://www.qcloud.com/community/article/179 来源:腾云阁 https://www.qclo ...

随机推荐

- struts标签小记

1.<s:iterator>标签的 奇偶数行使用不同样式 <s:iterator id="list" value="#request.listq&qu ...

- Java基础之读文件——使用通道复制文件(FileBackup)

控制台程序,除了使用Files类中使用copy()方法将文件复制外,还可以使用FileChannel对象复制文件,连接到输入文件的FileChannel对象能直接将数据传输到连接到输出文件的FileC ...

- Fusioncharts使用说明

背景 最近由于工作需要,再次接触到了Fusioncharts,但也有不足之处,现在官网上似乎是不支持flash的版本了,只能看到html5相关的javascript版本,无奈再次从网上搜索到了一些别人 ...

- JAVA类加载机制详解

“代码编译的结果从本地机器码转变为字节码,是存储格式发展的一小步,却是变成语言发展的一大步”,这句话出自<深入理解JAVA虚拟机>一书,后面关于jvm的系列文章主要都是参考这本书. JAV ...

- 学习OpenCV——用OpenCv画漫画

闲的时候用OpenCV画漫画也挺有意思,虽然效果不好(达不到上面所实现的效果), 参数需要调整,还是大头贴而且噪声小的图像比较合适 而且可以熟悉一下关于各种滤波的操作比如:双边滤波: #include ...

- Mac 显示和隐藏 隐藏文件

控制台运行: //显示 defaults write com.apple.finder AppleShowAllFiles -bool true //隐藏 defaults write com.app ...

- nyist 596 谁是最好的Coder

http://acm.nyist.net/JudgeOnline/problem.php?pid=596 谁是最好的Coder 时间限制:1000 ms | 内存限制:65535 KB 难度:0 ...

- C#删除xml中某个节点的子节点方法

if (File.Exists(xmlFilePath)) { XmlDocument xmlDoc = new XmlDocument(); xmlDoc.Load(xmlFilePath); Xm ...

- extjs grid 单元格 多选

new Ext.grid.CellSelectionModel({ last : false, // 上一次选中的单元格 selections : [], // 选择区缓存 handleMouseDo ...

- 变形--位移 translate()

translate()函数可以将元素向指定的方向移动,类似于position中的relative.或以简单的理解为,使用translate()函数,可以把元素从原来的位置移动,而不影响在X.Y轴上的任 ...