Kafka之--python-kafka测试kafka集群的生产者与消费者

前面两篇博客已经完成了Kafka的搭建,今天再来点稍高难度的帖子。

测试一下kafka的消息消费行为。虽然,kafka有测试的shell脚本可以直接测试,但既然我最近在玩python,那还是用python程序来做个测试。

1)首先需要kafka-python安装包。

这个包依赖的是python 3以上的版本,但是linux7默认都是安装2.7版本。

当然,你也可以在linux下安装一个3.x版本,但是如此又会需要调整yum(依赖python 2.7)等一大堆东西。

还有我习惯于windows下调试程序,那我何不在windows下安装3.X版本。用它来访问我的linux虚拟机呢?

说干就干,首先安装pycharm,再安装python 3.7。

https://www.python.org/ftp/python/3.7.2/python-3.7.2.exe

安装完后,可以直接用CMD>pip install kafka-python

C:\Users\Lenovo>pip install kafka-python

WARNING: Ignoring invalid distribution -ip (d:\programs\python\python37\lib\site-packages)

WARNING: Ignoring invalid distribution -ip (d:\programs\python\python37\lib\site-packages)

Requirement already satisfied: kafka-python in d:\programs\python\python37\lib\site-packages (2.0.2)

WARNING: Ignoring invalid distribution -ip (d:\programs\python\python37\lib\site-packages)

WARNING: Ignoring invalid distribution -ip (d:\programs\python\python37\lib\site-packages)

WARNING: Ignoring invalid distribution -ip (d:\programs\python\python37\lib\site-packages) C:\Users\Lenovo>pip list kafka

WARNING: Ignoring invalid distribution -ip (d:\programs\python\python37\lib\site-packages)

Package Version

---------------------- -------

dnspython 1.16.0

kafka-python 2.0.2

mysql-connector-python 8.0.19

pip 21.1.3

psutil 5.8.0

pygame 1.9.4

setuptools 41.2.0

WARNING: Ignoring invalid distribution -ip (d:\programs\python\python37\lib\site-packages)

WARNING: Ignoring invalid distribution -ip (d:\programs\python\python37\lib\site-packages)

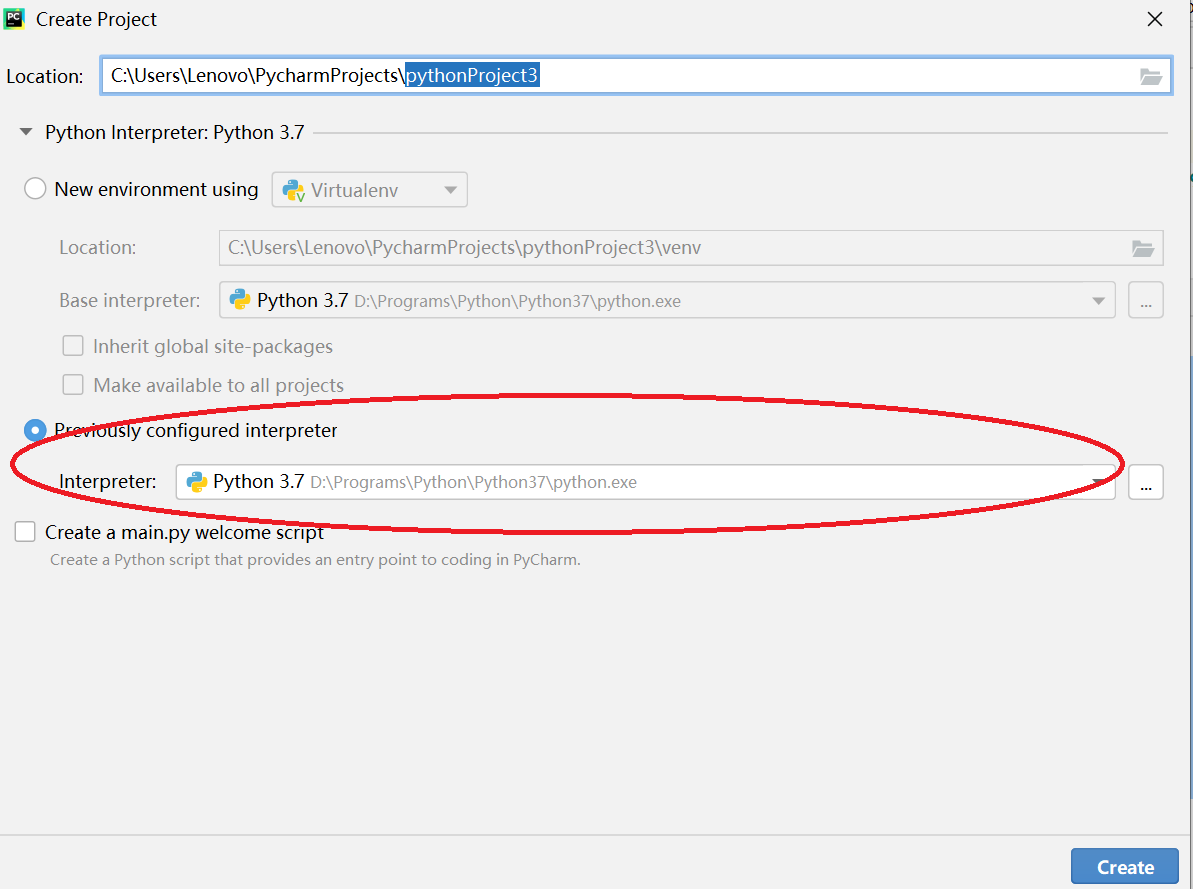

2)pycharm新建python项目,指定本地python环境(不要用默认的虚拟环境)

创建2个Python文件,producer.py & consumer.py

Producer.py

#!usr/bin/python

import json

import time

from kafka import KafkaProducer

from kafka.errors import KafkaError, KafkaTimeoutError topic = 'mytopic2'

producer = KafkaProducer(bootstrap_servers="192.168.56.151:9092,192.168.56.152:9092,192.168.56.153:9092")

msg_dict = {

'method':"post",

'header':'json',

'content':"17909",

} for i in range(100,1200):

si= str(i);

msg_dict['method'] = "post " + si;

msg_dict['content']=si;

msg = json.dumps(msg_dict).encode(encoding='utf-8')

print(msg)

try:

future = producer.send(topic, msg)

result = future.get(timeout=10)

print(result)

time.sleep(1)

except KafkaTimeoutError as err:

print(err)

except Exception as err:

print(err) producer.close()

Consumer.py

#!usr/bin/python

from kafka import KafkaConsumer

topic = 'mytopic2'

consumer = KafkaConsumer(topic, bootstrap_servers=['192.168.56.151:9092','192.168.56.152:9092','192.168.56.153:9092'],group_id='mygroup2')

for msg in consumer:

recv = "%s:%d:%d: key=%s value=%s" % (msg.topic, msg.partition, msg.offset, msg.key, msg.value)

print (recv)

3)执行过程

Producer每秒钟产生一个消息。

D:\Programs\Python\Python37\python.exe C:/Users/Lenovo/PycharmProjects/pythonProjectKafka2/Producer.py

b'{"method": "post 100", "header": "json", "content": "100"}'

RecordMetadata(topic='mytopic2', partition=1, topic_partition=TopicPartition(topic='mytopic2', partition=1), offset=0, timestamp=1626272823148, log_start_offset=0, checksum=None, serialized_key_size=-1, serialized_value_size=58, serialized_header_size=-1)

b'{"method": "post 101", "header": "json", "content": "101"}'

RecordMetadata(topic='mytopic2', partition=0, topic_partition=TopicPartition(topic='mytopic2', partition=0), offset=0, timestamp=1626272824211, log_start_offset=0, checksum=None, serialized_key_size=-1, serialized_value_size=58, serialized_header_size=-1)

b'{"method": "post 102", "header": "json", "content": "102"}'

Consumer接收消息。

当我只开始一个Consumer的时候,它可以接收到所有partition(我配置的parition=3)的消息。

当再启动2个Consumer的时候,可以看到每个consumer都只会消费某一个partition的数据了。

说明: mytopic2:1:1 对应的是 ( Topicname: parition-id: offset ),具体你看代码就清楚了。

D:\Programs\Python\Python37\python.exe C:/Users/Lenovo/PycharmProjects/pythonProjectKafka2/Consumer.py

mytopic2:1:1: key=None value=b'{"method": "post 103", "header": "json", "content": "103"}'

mytopic2:1:2: key=None value=b'{"method": "post 104", "header": "json", "content": "104"}'

mytopic2:1:3: key=None value=b'{"method": "post 105", "header": "json", "content": "105"}'

mytopic2:2:0: key=None value=b'{"method": "post 106", "header": "json", "content": "106"}'

mytopic2:1:4: key=None value=b'{"method": "post 107", "header": "json", "content": "107"}'

mytopic2:2:1: key=None value=b'{"method": "post 108", "header": "json", "content": "108"}'

mytopic2:0:2: key=None value=b'{"method": "post 109", "header": "json", "content": "109"}'

mytopic2:0:3: key=None value=b'{"method": "post 110", "header": "json", "content": "110"}'

mytopic2:1:5: key=None value=b'{"method": "post 111", "header": "json", "content": "111"}'

mytopic2:1:6: key=None value=b'{"method": "post 112", "header": "json", "content": "112"}'

mytopic2:0:4: key=None value=b'{"method": "post 114", "header": "json", "content": "114"}'

mytopic2:0:5: key=None value=b'{"method": "post 115", "header": "json", "content": "115"}'

mytopic2:1:7: key=None value=b'{"method": "post 116", "header": "json", "content": "116"}'

mytopic2:1:8: key=None value=b'{"method": "post 117", "header": "json", "content": "117"}'

mytopic2:0:6: key=None value=b'{"method": "post 118", "header": "json", "content": "118"}'

mytopic2:0:7: key=None value=b'{"method": "post 120", "header": "json", "content": "120"}'

mytopic2:0:8: key=None value=b'{"method": "post 121", "header": "json", "content": "121"}'

mytopic2:1:9: key=None value=b'{"method": "post 122", "header": "json", "content": "122"}'

mytopic2:1:10: key=None value=b'{"method": "post 123", "header": "json", "content": "123"}'

mytopic2:0:9: key=None value=b'{"method": "post 126", "header": "json", "content": "126"}'

mytopic2:0:10: key=None value=b'{"method": "post 127", "header": "json", "content": "127"}'

mytopic2:0:11: key=None value=b'{"method": "post 129", "header": "json", "content": "129"}'

mytopic2:0:12: key=None value=b'{"method": "post 130", "header": "json", "content": "130"}'

mytopic2:0:13: key=None value=b'{"method": "post 137", "header": "json", "content": "137"}'

mytopic2:0:14: key=None value=b'{"method": "post 138", "header": "json", "content": "138"}'

mytopic2:0:15: key=None value=b'{"method": "post 139", "header": "json", "content": "139"}'

mytopic2:0:16: key=None value=b'{"method": "post 140", "header": "json", "content": "140"}' Process finished with exit code -1

C:\Users\Lenovo\PycharmProjects\pythonProjectKafka2>python Consumer.py

mytopic2:2:2: key=None value=b'{"method": "post 113", "header": "json", "content": "113"}'

mytopic2:2:3: key=None value=b'{"method": "post 119", "header": "json", "content": "119"}'

mytopic2:2:4: key=None value=b'{"method": "post 124", "header": "json", "content": "124"}'

mytopic2:2:5: key=None value=b'{"method": "post 125", "header": "json", "content": "125"}'

mytopic2:1:11: key=None value=b'{"method": "post 131", "header": "json", "content": "131"}'

mytopic2:1:12: key=None value=b'{"method": "post 134", "header": "json", "content": "134"}'

mytopic2:1:13: key=None value=b'{"method": "post 144", "header": "json", "content": "144"}'

mytopic2:1:14: key=None value=b'{"method": "post 146", "header": "json", "content": "146"}'

C:\Users\Lenovo\PycharmProjects\pythonProjectKafka2>python Consumer.py

mytopic2:2:6: key=None value=b'{"method": "post 128", "header": "json", "content": "128"}'

mytopic2:2:7: key=None value=b'{"method": "post 132", "header": "json", "content": "132"}'

mytopic2:2:8: key=None value=b'{"method": "post 133", "header": "json", "content": "133"}'

mytopic2:2:9: key=None value=b'{"method": "post 135", "header": "json", "content": "135"}'

mytopic2:2:10: key=None value=b'{"method": "post 136", "header": "json", "content": "136"}'

mytopic2:2:11: key=None value=b'{"method": "post 141", "header": "json", "content": "141"}'

mytopic2:2:12: key=None value=b'{"method": "post 142", "header": "json", "content": "142"}'

mytopic2:2:13: key=None value=b'{"method": "post 143", "header": "json", "content": "143"}'

Kafka之--python-kafka测试kafka集群的生产者与消费者的更多相关文章

- 使用Kafka的一些简单介绍: 1集群 2原理 3 术语

目录 第一节 Kafka 集群 Kafka 集群搭建 Kafka 集群快速搭建 第二节 集群管理工具 集群管理工具 集群 Issues 第三节 使用命令操纵集群 第四节 Kafka 术语说明 第五节 ...

- Kafka 详解(二)------集群搭建

这里通过 VMware ,我们安装了三台虚拟机,用来搭建 kafka集群,虚拟机网络地址如下: hostname ipaddress ...

- python 连接 redis cluster 集群

一. redis集群模式有多种, cluster模式只是其中的一种实现方式, 其原理请自行谷歌或者百度, 这里只举例如何使用Python操作 redis cluster 集群 二. python 连接 ...

- python连接redis哨兵集群

一.redis集群模式有多种, 哨兵模式只是其中的一种实现方式, 其原理请自行谷歌或者百度 二.python 连接 redis 哨兵集群 1. 安装redis包 pip install redis 2 ...

- Kafka 0.9+Zookeeper3.4.6集群搭建、配置,新Client API的使用要点,高可用性测试,以及各种坑 (转载)

Kafka 0.9版本对java client的api做出了较大调整,本文主要总结了Kafka 0.9在集群搭建.高可用性.新API方面的相关过程和细节,以及本人在安装调试过程中踩出的各种坑. 关于K ...

- kafka项目经验之如何进行Kafka压力测试、如何计算Kafka分区数、如何确定Kaftka集群机器数量

@ 目录 Kafka压测 Kafka Producer(生产)压力测试 Kafka Consumer(消费)压力测试 计算Kafka分区数 Kafka机器数量计算 Kafka压测 用Kafka官方自带 ...

- kafka分布式消息队列介绍以及集群安装

简介 首先简单说下对kafka的理解: 1.kafka是一个分布式的消息缓存系统: 2.kafka集群中的服务器节点都被称作broker 3.kafka的客户端分为:一是producer(消息生产者) ...

- kafka 0.10.2 cetos6.5 集群部署

安装 zookeeper http://www.cnblogs.com/xiaojf/p/6572351.html安装 scala http://www.cnblogs.com/xiaojf/p/65 ...

- 05.kafka提前准备工作:搭建zookeeper集群环境

总体参考:http://www.cnblogs.com/zhangs1986/p/6564839.html 搭建之间同步下spark01.02.03的环境 复制/opt/flume这个文件夹到 spa ...

随机推荐

- 这款拓展让你的jupyter lab更高效

有一段时间没有分享过有关jupyter lab的内容了,今天给大家介绍一款实用的jupyter lab插件,可以帮助我们打造更灵活易用的jupyter lab. 图1 这款拓展的名称叫做jlab-en ...

- P1828 [USACO3.2]香甜的黄油 Sweet Butter

题目描述 农夫$John$发现做出全威斯康辛州最甜的黄油的方法:糖.把糖放在一片牧场上,他知道$N(1\leqslant N\leqslant 500)$只奶牛会过来舔它,这样就能做出能卖好价钱的超甜 ...

- NoSQL:如何使用NoSQL架构构建实时广告系统

JDNoSQL平台是什么 JDNoSQL平台是一个分布式面向列的KeyValue毫秒级存储服务,存储结构化数据和非机构化数据,支持随机读写与更新,灵活的动态列机制,架构上支持水平扩容,提供高并发.低延 ...

- MIT6.828 Lab2 内存管理

Lab2 0. 任务介绍 你将编写一个内存管理代码.主要分为两大部分.分别对物理内存和虚拟内存的管理. 对于物理内存,每次分配内存分配器会为你分配4096bytes.也称为一个页(在大部分操作系统中一 ...

- Linux环境下安装配置vsftpd服务(三种认证模式)

一.FTP简介 文件传输协议(英文:File Transfer Protocol,缩写:FTP)是用于在网络上进行文件传输的一套标准协议.它工作于网络传输协议的应用层,使用客户/服务器模式,主要是用来 ...

- 安装nodejs版本模块报错notsup Unsupported platform for n

使用npm install -g n报错 如果出现npm ERR! notsup Unsupported platform for n@6.7.0: wanted {"os":&q ...

- Go语言获取Ubuntu所有网卡名

Go语言获取Ubuntu所有网卡名 需求 获取当前机器下所有网卡名,以字符串数组的形式返回 实现demo package main import ( "fmt" "os/ ...

- 整合Spring Cloud Stream Binder与RabbitMQ进行消息发送与接收

我最新最全的文章都在南瓜慢说 www.pkslow.com,欢迎大家来喝茶! 1 前言 Spring Cloud Stream专门用于事件驱动的微服务系统,使用消息中间件来收发信息.使用Spring ...

- 『心善渊』Selenium3.0基础 — 13、Selenium操作下拉菜单

目录 1.使用Selenium中的Select类来处理下拉菜单(推荐) 2.下拉菜单对象的其他操作(了解) 3.通过元素二次定位方式操作下拉菜单(重点) (1)了解元素二次定位 (2)示例: 页面中的 ...

- 通过Cloudflare API进行CDN刷新

1.Cloudflare CDN刷新说明 1.Cloudfalre同Akamai一样,只有刷新,没有预热的概念. 2.通过Cloudflare API进行刷新,需要用到登录用户的[邮箱][api密钥] ...