[转帖]kubernetes(k8s):容器资源限制(内存限制、cpu限制、namespace限制)

文章目录

1. k8s容器资源限制

k8s采用request和limit两种限制类型来对资源进行分配

- request(资源需求):即运行pod的节点必须满足运行pod的最基本需求才能运行pod。

- limit(资源限制):即运行pod期间,可能内存使用量会增加,那最多能使用多少内存,这就是资源限额。

资源类型:

- CPU的单位是核心数,内存的单位是字节。

- 一个容器申请0.5各CPU,就相当于申请1个CPU的一半,可以加个后缀m表示千分之一的概念。比如说100m的CPU,100豪的CPU和0.1个CPU都是一样的。

内存单位:

- K,M,G,T,P,E #通常是以1000为换算标准的。

- Ki,Mi,Gi,Ti,Pi,Ei #通常是以1024为换算标准的。

2. 内存资源限制实例

[kubeadm@server2 limit]$ cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: memory-demo

spec:

containers:

- name: memory-demo

image: stress

args:

- --vm

- "1"

- --vm-bytes

- 200M // 容器使用200M

resources:

requests: //资源需求,下限

memory: 50Mi

limits: //资源限制,上限

memory: 100Mi

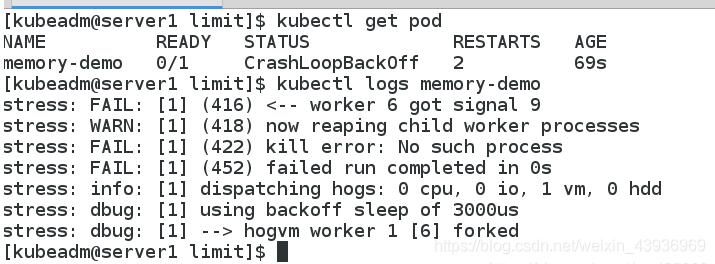

[kubeadm@server1 limit]$ kubectl get pod

NAME READY STATUS RESTARTS AGE

memory-demo 0/1 CrashLoopBackOff 3 106s

因为容器需要200M,超出了最大限制100Mi,所以容器无法运行。

- 如果容器超过其内存限制,则会被终止。如果可重新启动,则与其他所有类型的运行故障一样,kubelet将重新启动它。

- 如果一个容器超过其内存要求,那么当节点内存不足时,它的pod可能被逐出。

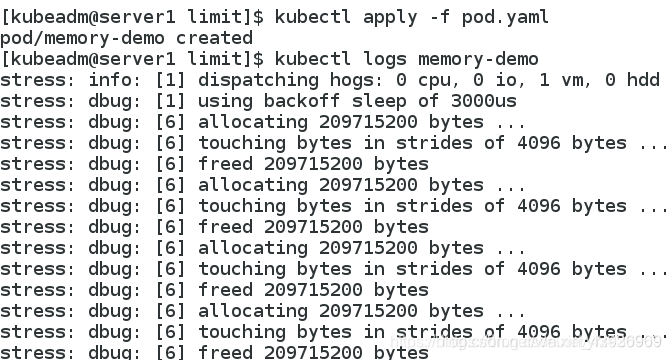

- 当资源限制没冲突的时候正常启动

[kubeadm@server1 limit]$ vim pod.yaml

[kubeadm@server1 limit]$ cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: memory-demo

spec:

containers:

- name: memory-demo

image: k8s/stress

args:

- --vm

- "1"

- --vm-bytes

- 200M

resources:

requests:

memory: 50Mi

limits:

memory: 300Mi //将最大限制改为300mi,容器可以正常运行

[kubeadm@server1 limit]$

资源限制内部机制使用的是cgroup类型

目录: /sys/fs/cgroup/systemd

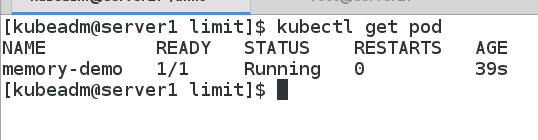

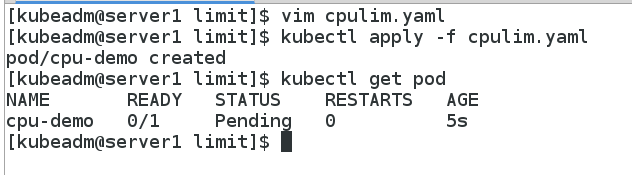

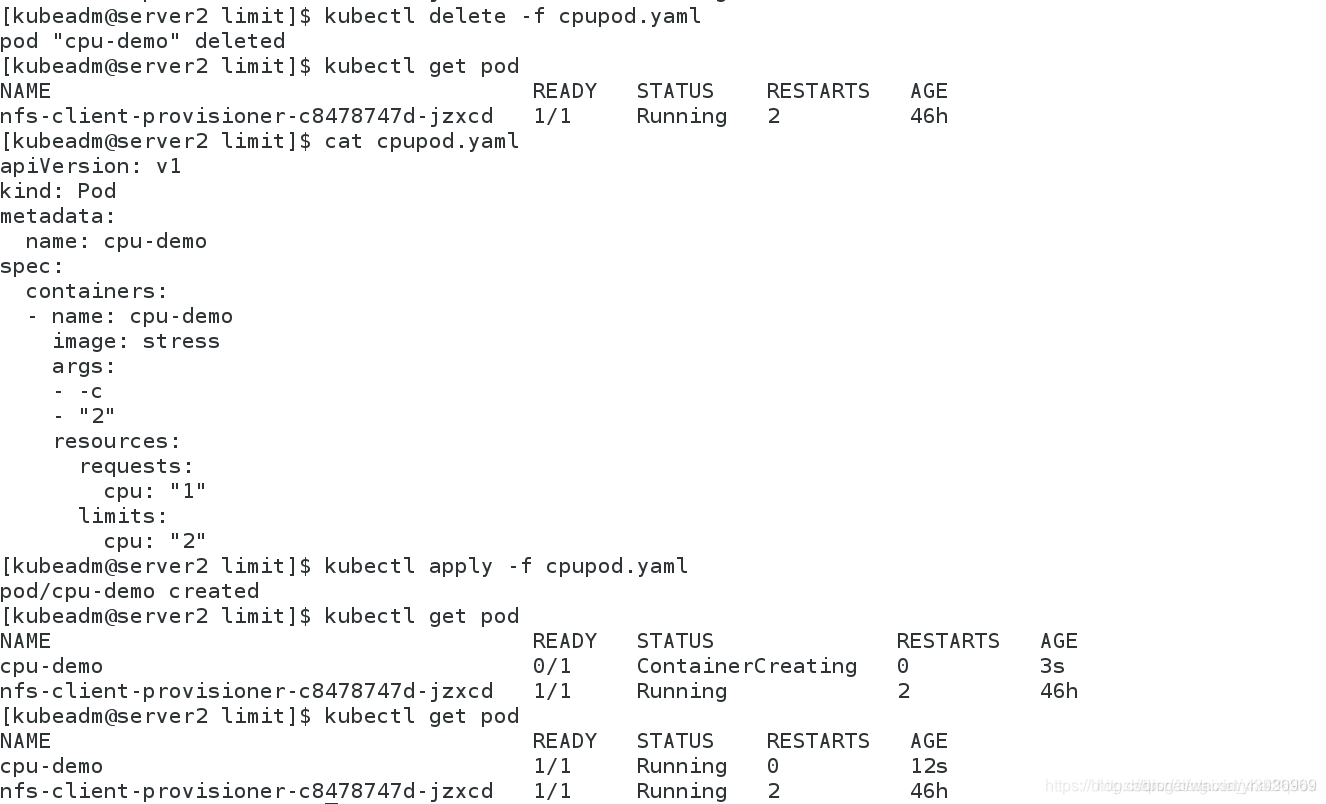

3. cpu资源限制

[kubeadm@server1 limit]$ cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: cpu-demo

spec:

containers:

- name: cpu-demo

image: stress

args:

- -c

- "2" //容器需要2个cpu

resources:

requests: //至少需要5个cpu

cpu: "5"

limits:

cpu: "10" //最大限制10个cpu

[kubeadm@server1 limit]$ kubectl apply -f pod.yaml

pod/cpu-demo created [kubeadm@server1 limit]$ kubectl get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

cpu-demo 1/1 Running 0 4m58s 10.244.2.124 server4 <none> <none>

[root@server4 ~]# top // server4上的两个cpu跑满了,CPU 使用率过高,不会被杀死

(top--->1) top - 16:41:55 up 6:37, 1 user, load average: 3.77, 2.69, 1.54

Tasks: 172 total, 4 running, 168 sleeping, 0 stopped, 0 zombie

%Cpu0 : 98.7 us, 0.3 sy, 0.0 ni, 0.0 id, 0.0 wa, 0.7 hi, 0.3 si, 0.0 st

%Cpu1 : 98.3 us, 0.7 sy, 0.0 ni, 0.0 id, 0.0 wa, 0.7 hi, 0.3 si, 0.0 st

KiB Mem : 2045672 total, 784128 free, 293728 used, 967816 buff/cache

KiB Swap: 0 total, 0 free, 0 used. 1520056 avail Mem PID USER PR NI VIRT RES SHR S %CPU %MEM TIME+ COMMAND

21204 root 20 0 7312 100 0 R 98.3 0.0 5:29.21 stress

21203 root 20 0 7312 100 0 R 97.0 0.0 5:29.84 stress

调度失败是因为申请的CPU资源超出集群节点所能提供的资源

但CPU 使用率过高,不会被杀死

满足要求

满足要求

[kubeadm@server1 limit]$ vim pod.yaml

[kubeadm@server1 limit]$ cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: cpu-demo

spec:

containers:

- name: cpu-demo

image: k8s/stress

args:

- -c

- "2"

resources:

requests:

cpu: "1"

limits:

cpu: "2"

[kubeadm@server1 limit]$

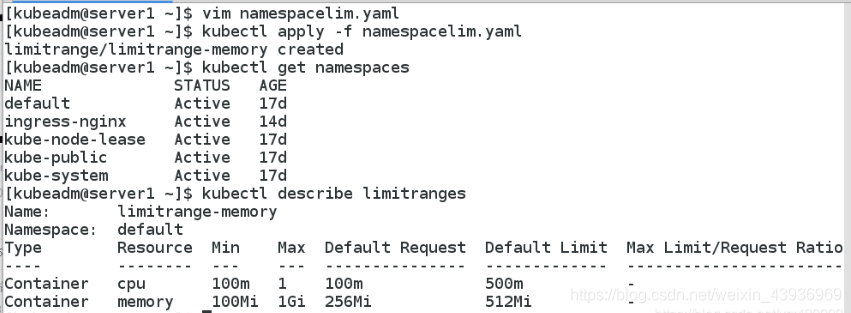

4. namespace设置资源限制

LimitRange资源限制:

apiVersion: v1

kind: LimitRange

metadata:

name: limitrange-memory

spec:

limits:

- default: //默认使用0.5个cpu,512mi内存

cpu: 0.5

memory: 512Mi

defaultRequest: //默认要求0.1个cpu和256mi内存

cpu: 0.1

memory: 256Mi

max: //最大2个cpu和1gi内存

cpu: 1

memory: 1Gi

min: //最小0.1个cpu和100mi内存

cpu: 0.1

memory: 100Mi

type: Container

[kubeadm@server1 limit]$ kubectl apply -f limitrange.yaml

limitrange/limitrange-memory created

[kubeadm@server1 limit]$ kubectl get limitranges

NAME CREATED AT

limitrange-memory 2020-05-08T08:52:10Z

[kubeadm@server1 limit]$ kubectl describe limitranges

Name: limitrange-memory

Namespace: default

Type Resource Min Max Default Request Default Limit Max Limit/Request Ratio

---- -------- --- --- --------------- ------------- -----------------------

Container cpu 100m 2 100m 500m -

Container memory 100Mi 1Gi 256Mi 512Mi -

注意:LimitRange 在 namespace 中施加的最小和最大内存限制只有在创建和更新 Pod 时才会被应用。改变 LimitRange 不会对之前创建的 Pod 造成影响。

LimitRange - default xx会自动对没有设置资源限制的pod自动添加限制

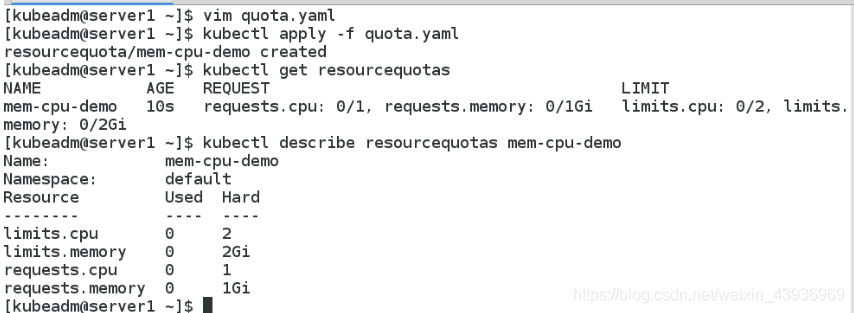

ResourceQuota设置配额限制

ResourceQuota设置配额限制

[kubeadm@server1 limit]$ cat quota.yaml

apiVersion: v1

kind: ResourceQuota

metadata:

name: mem-cpu-demo

spec:

hard:

requests.cpu: "1" // 要求cpu1个 即cpu要求不得超过1个cpu

requests.memory: 1Gi // 要求内存1gi 即内存要求不得超过1Gi

limits.cpu: "2" // cpu限制2个 即cpu限制不得超过2个cpu

limits.memory: 2Gi // 内存限制2gi 即内存限制不得超过2Gi

[kubeadm@server1 limit]$ kubectl apply -f quota.yaml

resourcequota/mem-cpu-demo created [kubeadm@server1 limit]$ kubectl get resourcequotas

NAME AGE REQUEST LIMIT

mem-cpu-demo 13s requests.cpu: 0/1, requests.memory: 0/1Gi limits.cpu: 0/2, limits.memory: 0/2Gi [kubeadm@server1 limit]$ kubectl describe resourcequotas

Name: mem-cpu-demo

Namespace: default

Resource Used Hard

-------- ---- ----

limits.cpu 0 2

limits.memory 0 2Gi

requests.cpu 0 1

requests.memory 0 1Gi

一旦设置配额后,后续的容器必须设置请求(4种请求都设置),当然,这只是在rq设置的defult的namespace中

一旦设置配额后,后续的容器必须设置请求(4种请求都设置),当然,这只是在rq设置的defult的namespace中

4种请求:每个容器必须设置内存请求(memory request),内存限额(memory limit),cpu请求(cpu request)和cpu限额(cpu limit)

资源会统计总的namespace中的资源加以限定,不管是之前创建还是准备创建

创建的ResourceQuota对象将在default名字空间中添加以下限制:

- 每个容器必须设置内存请求(memory request),内存限额(memory limit),cpu请求(cpu

request)和cpu限额(cpu limit)。 - 所有容器的内存请求总额不得超过1 GiB。

- 所有容器的内存限额总额不得超过2 GiB。

- 所有容器的CPU请求总额不得超过1 CPU。

- 所有容器的CPU限额总额不得超过2 CPU。

5. namespace中pod的配额

[kubeadm@server1 limit]$ cat podquata.yaml

apiVersion: v1

kind: ResourceQuota

metadata:

name: pod-demo

spec:

hard:

pods: "2" //2个pod

设置Pod配额以限制可以在namespace中运行的Pod数量。

[kubeadm@server1 limit]$ kubectl apply -f podquata.yaml

resourcequota/pod-demo created

[kubeadm@server1 limit]$ kubectl describe resourcequotas pod-demo // 当前只有一个pod

Name: pod-demo

Namespace: default

Resource Used Hard

-------- ---- ----

pods 1 2

[kubeadm@server1 limit]$ cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: test

spec:

containers:

- name: test

image: nginx

//创建一个pod

[kubeadm@server1 limit]$ kubectl apply -f pod.yaml

pod/test created [kubeadm@server1 limit]$ cat pod.yaml

apiVersion: v1

kind: Pod

metadata:

name: test1

spec:

containers:

- name: test1

image: nginx //再创建一个pod时,会发生错误,因为在当前的namespace中限制两个pod

[kubeadm@server1 limit]$ kubectl apply -f pod.yaml

Error from server (Forbidden): error when creating "pod.yaml": pods "test1" is forbidden: exceeded quota: pod-demo, requested: pods=1, used: pods=2, limited: pods=2

当然,以上设定对应相对的namespace,其它的namespace没有影响

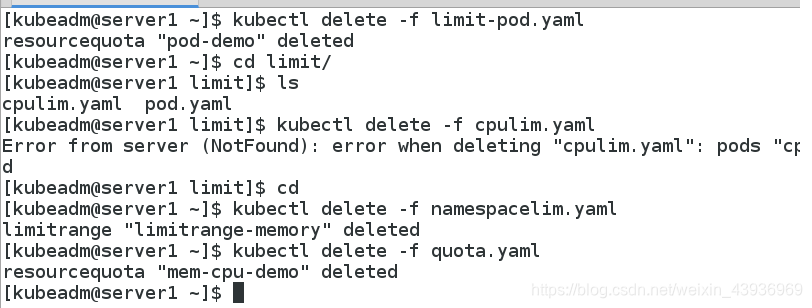

为了后续不受影响,删除相应的设定

6. namespace的创建、使用和删除

创建namespace

kubectl create namespace test // 创建test的namespace

运行yaml文件时指定namespace

kubectl apply -f pod.yaml -n test // 在test的namespace中运行pod.yaml为文件

删除namespace

kubectl delete namespaces test // 删除名为test的namespace

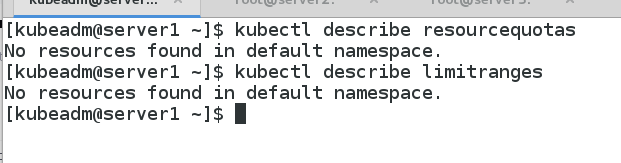

7. 清除资源限制和配额

[kubeadm@server1 limit]$ kubectl delete -f limitrange.yaml

limitrange "limitrange-memory" deleted

[kubeadm@server1 limit]$ kubectl delete -f podquata.yaml

resourcequota "pod-demo" deleted

[kubeadm@server1 limit]$ kubectl delete -f quota.yaml

resourcequota "mem-cpu-demo" deleted

[转帖]kubernetes(k8s):容器资源限制(内存限制、cpu限制、namespace限制)的更多相关文章

- Kubernetes K8S之资源控制器StatefulSets详解

Kubernetes的资源控制器StatefulSet详解与示例 主机配置规划 服务器名称(hostname) 系统版本 配置 内网IP 外网IP(模拟) k8s-master CentOS7.7 2 ...

- Kubernetes K8S之资源控制器Daemonset详解

Kubernetes的资源控制器Daemonset详解与示例 主机配置规划 服务器名称(hostname) 系统版本 配置 内网IP 外网IP(模拟) k8s-master CentOS7.7 2C/ ...

- Kubernetes K8S之资源控制器Job和CronJob详解

Kubernetes的资源控制器Job和CronJob详解与示例 主机配置规划 服务器名称(hostname) 系统版本 配置 内网IP 外网IP(模拟) k8s-master CentOS7.7 2 ...

- zabbix的安装(一)监控os资源:内存,cpu,io,负载,带宽

一.Linux下开源监控系统简单介绍1)cacti:存储数据能力强,报警性能差2)nagios:报警性能差,存储数据仅有简单的一段可以判断是否在合理范围内的数据长度,储存在内存中.比如,连续采样数据存 ...

- K8s容器资源限制

在K8s中定义Pod中运行容器有两个维度的限制: 1. 资源需求:即运行Pod的节点必须满足运行Pod的最基本需求才能运行Pod. 如: Pod运行至少需要2G内存,1核CPU 2. 资源限额: ...

- Kubernetes:容器资源需求与限制(约束)

Blog:博客园 个人 A Container is guaranteed to have as much memory as it requests, but is not allowed to u ...

- [转帖]Kubernetes及容器编排的总体介绍【译】

Kubernetes及容器编排的总体介绍[译] 翻译自The New Stack<Kubernetes 生态环境>作者:JANAKIRAM MSV和 KRISHNAN SUBRAMANIA ...

- kubernetes(k8s)容器编排工具基础概念

Kubernetes (K8s): 中文社区:https://www.kubernetes.org.cn/replication-controller-kubernetes 官网:https://ku ...

- Kubernetes K8S之资源控制器RC、RS、Deployment详解

Kubernetes的资源控制器ReplicationController(RC).ReplicaSet(RS).Deployment(Deploy)详解与示例 主机配置规划 服务器名称(hostna ...

- Kubernetes 集群分析查看内存,CPU

Kubernetes方式 top命令查看所有pod,nodes中内存,CPU使用情况 查看pod root @ master ➜ ~ kubectl top pod -n irm-server NAM ...

随机推荐

- ubuntu frame 个人开发心得

引言 有一次我在树莓派上安装 Ubuntu Core 我给创新创业项目开发一个可视化 gui 看板,用于展示数据. 然后我就找到了我需要的工具 Ubuntu Frame 初次尝试使用 Ubuntu F ...

- QNX 性能分析工具

QNX 性能分析工具 小结 hogs:列出最占用 CPU/RAM 的进程,可以统计内存占用详细情况[可单个进程] pidin:显示进程信息.系统信息.库信息...[可单个进程] ps:显示进程信息[可 ...

- Spring源码学习笔记3——根据BeanDefinition实例化Bean的前置准备

一丶前言 笔记1和笔记2中我们分析了如何根据xml和注解加载生成BeanDefinition,并注册到BeanFactory,接下载便是Bean的加载,在加载之前会进行一些前置准备 二丶前置准备 和B ...

- 为AR&VR黑科技:以“自由视角”360度尽展舞台唯美

摘要:看华为的黑科技,如何用"自由视角"让观众感受舞台"风暴"的魅力所在. "风暴"降临 2021年1月9日晚上,我坐在电视机前,等待湖南卫 ...

- 云图说丨应用宕机怎么办?MAS帮您实现业务无缝切换

摘要: 多云高可用服务(Multi-cloud high Availability Service,简称MAS)源自华为消费者多云应用高可用方案,提供从流量入口.数据到应用层的端到端的业务故障切换及容 ...

- 业务并发度不够,数仓的CN可以来帮忙

摘要: CN全称协调节点(Coordinator Node),是和用户关系最密切也是DWS内部非常重要的一个组件,它负责提供外部应用接口.优化全局执行计划.向Datanode分发执行计划,以及汇总.处 ...

- Log4Shell 漏洞披露已近一年,它对我们还有影响吗?

在 Log4Shell 高危漏洞事件披露几乎整整一年之后,新的数据显示,对全球大多数组织来说,补救工作是一个漫长.缓慢.痛苦的过程. 根据漏洞扫描领先者 Tenable 公司的遥测数据来看,截至今年1 ...

- 火山引擎DataLeap一站式数据治理解决方案及平台架构

更多技术交流.求职机会,欢迎关注字节跳动数据平台微信公众号,回复[1]进入官方交流群 在字节跳动内部,DataLeap数据平台数据治理团队致力于建立一站式.全链路的数据治理解决方案平台. 数据治理的概 ...

- 火山引擎DataLeap基于Apache Atlas自研异步消息处理框架

更多技术交流.求职机会,欢迎关注字节跳动数据平台微信公众号,回复[1]进入官方交流群 字节数据中台DataLeap的Data Catalog系统通过接收MQ中的近实时消息来同步部分元数据.Apache ...

- HanLP — HMM隐马尔可夫模型 -- 训练&预测

BMES => B-begin:词语开始.M-middle:词语中间.E-end:词语结束.S-single:单独成词 训练的过程,就是求三个矩阵的过程 初始概率矩阵 转移概率矩阵 发射矩阵 每 ...