Spark Dataframe 转 Json

import org.apache.spark.sql.DataFrame

import org.apache.spark.sql.functions._

import org.apache.spark.sql.types._ // Convenience function for turning JSON strings into DataFrames.

def jsonToDataFrame(json: String, schema: StructType = null): DataFrame = {

// SparkSessions are available with Spark 2.0+

val reader = spark.read Option(schema).foreach(reader.schema)

reader.json(sc.parallelize(Array(json)))

}

// Using a struct

val schema = new StructType().add("a", new StructType().add("b", IntegerType)) val events = jsonToDataFrame("""

{

"a": {

"b": 1

}

}

""", schema) events.select("a.b").show()

val events = jsonToDataFrame("""

{

"a": 1,

"b": 2,

"c": 3

}

""")

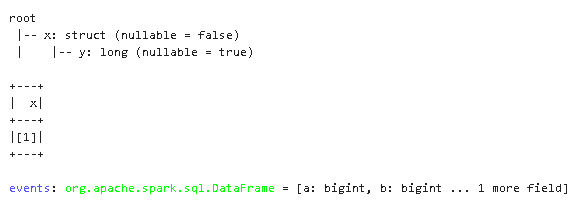

events.select(struct('a as 'y) as 'x).printSchema()

events.select(struct('a as 'y) as 'x).show()

val events = jsonToDataFrame("""

{

"a": 1,

"b": 2

}

""")

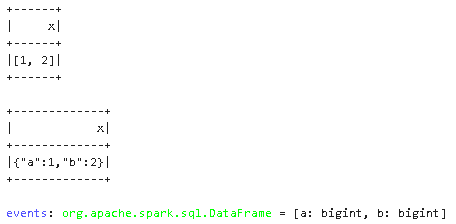

events.select((struct("*") as 'x)).show()

events.select(to_json(struct("*")) as 'x).show()

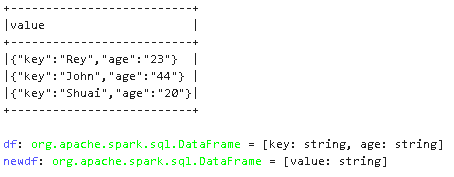

val df = Seq(("Rey", "23"), ("John", "44"),("Shuai", "20") ).toDF("key", "age")

df.columns.map(column)

val newdf = df.select(to_json(struct(df.columns.map(column):_*)).alias("value"))

newdf.show(false)

Ref:

https://docs.databricks.com/_static/notebooks/transform-complex-data-types-scala.html

Spark Dataframe 转 Json的更多相关文章

- Spark SQL,如何将 DataFrame 转为 json 格式

今天主要介绍一下如何将 Spark dataframe 的数据转成 json 数据.用到的是 scala 提供的 json 处理的 api. 用过 Spark SQL 应该知道,Spark dataf ...

- spark DataFrame的创建几种方式和存储

一. 从Spark2.0以上版本开始,Spark使用全新的SparkSession接口替代Spark1.6中的SQLContext及HiveContext接口来实现其对数据加载.转换.处理等功能.Sp ...

- spark dataframe unionall

今天本来想写一个spark dataframe unionall的demo,由于粗心报下面错误: Exception in thread "main" org.apache.spa ...

- spark dataframe操作集锦(提取前几行,合并,入库等)

https://blog.csdn.net/sparkexpert/article/details/51042970 spark dataframe派生于RDD类,但是提供了非常强大的数据操作功能.当 ...

- spark DataFrame 常见操作

spark dataframe派生于RDD类,但是提供了非常强大的数据操作功能.当然主要对类SQL的支持. 在实际工作中会遇到这样的情况,主要是会进行两个数据集的筛选.合并,重新入库. 首先加载数据集 ...

- Spark DataFrame中的join使用说明

spark sql 中join的类型 Spark DataFrame中join与SQL很像,都有inner join, left join, right join, full join; 类型 说明 ...

- 转】Spark DataFrame小试牛刀

原博文出自于: https://segmentfault.com/a/1190000002614456 感谢! 三月中旬,Spark发布了最新的1.3.0版本,其中最重要的变化,便是DataFrame ...

- spark DataFrame 读写和保存数据

一.读写Parquet(DataFrame) Spark SQL可以支持Parquet.JSON.Hive等数据源,并且可以通过JDBC连接外部数据源.前面的介绍中,我们已经涉及到了JSON.文本格式 ...

- spark dataFrame withColumn

说明:withColumn用于在原有DF新增一列 1. 初始化sqlContext val sqlContext = new org.apache.spark.sql.SQLContext(sc) 2 ...

- spark&dataframe

1.今天,我们来介绍spark以及dataframe的相关的知识点,但是在此之前先说一下对以前的hadoop的一些理解 当我启动hadoop的时候,上面有hdfs的存储结构,由于这个是分布式存储,所以 ...

随机推荐

- 谈谈你对MVVM开发模式和MVT的理解?

MVVM分为Model.View.ViewModel三者. Model 代表数据模型,数据和业务逻辑都在Model层中定义: View 代表UI视图,负责数据的展示: ViewModel 负责监听 M ...

- nuxt3正确使用keepalive页面缓存组件缓存

最近使用nuxt@3.x版本做SEO优化项目比较多,之前也踩坑过,所以记录一下在 nuxt3 中路由缓存的正确使用方法,本人也之前在GitHub社区中提交过反馈问题,最后是在 3.8.2 版本解决了路 ...

- Netcode for Entities如何添加自定义序列化,让GhostField支持任意类型?以int3为例(1.2.3版本)

一句话省流:很麻烦也很抽象,能用内置支持的类型就尽量用. 首先看文档.官方文档里一开头就列出了所有内置的支持的类型:Ghost Type Templates 其中Entity类型需要特别注意一下:在同 ...

- char字符_C

字符的表示 字符类型由单引号' '包围,字符串由双引号" "包围. //正确的写法 char a = '1'; char b = '$'; char c = 'X'; char ...

- Odoo 基于Win10搭建基于Win10搭建odoo14开发环境搭建

实践环境 win10 Python 3.6.2 odoo_14.0.latest.tar.gz 下载地址: https://download.odoocdn.com/download/14/src?p ...

- 如何免费提取PDF里的图片-pdfimages使用教程

写在前面 本随笔是非常菜的菜鸡写的.如有问题请及时提出. 可以联系:1160712160@qq.com GitHhub:https://github.com/WindDevil (目前啥也没有 动机 ...

- 使用AWS存储数据并下载遥感影像Landsat为例

使用AWS存储数据并下载遥感影像Landsat为例 一.步骤: 创建s3存储桶(具体创建账号方式请问"度娘",当时忘记录了) 创建用户--配置策略 用该用户创建访问密钥--记录 访 ...

- 【Java】项目采用的设计模式案例

先说一下业务需要: 做电竞酒店后台系统,第一期功能有一个服务申请的消息通知功能 就是酒店用户在小程序点击服务功能,可以在后台这边查到用户的服务需要 原本设计是只需要一张表存储这些消息,但是考虑设计是S ...

- 【JSON】JavaScript Object Notation JS对象表示规则

什么是 JSON? JSON (JavaScript Object Notation) 是一种轻量级的数据交换格式. 易于人阅读和编写.同时也易于机器解析和生成. JSON采用完全独立于语言的文本格式 ...

- 小米(xiaomi)自动驾驶技术的原始技术积累 —— CyberDog 仿生四足机器狗

相关: https://www.youtube.com/watch?v=f0q8tfZ89Qo 小米公司一直没有加入到制造电动车的行列中,直到几年前才感觉造车是必须要走的路了,但是造车就一定是要造电动 ...